-

之所以说监督学习和无监督学习之间并不存在一条严格的界限,是因为很难客观地区分监督者给定的一个值是特征(feature)还是目标(target)。(正确)

解答: -

当深度学习网络的最后一层是一个softmax分类器时,我们可以把网络的前面部分看成是一种表示学习(Representation Learning)的计算单元。(正确)

解答:

表示学习指学习对观测样本 X X X有效的表示。比如CNN参数的有监督训练是一种有监督的表示学习形式;对自动编码器和限制玻尔兹曼机参数的无监督预训练是一种无监督的表示学习形式;对DBN参数-先进行无监督预训练,再进行有监督fine-tuning-是一种半监督的共享表示学习形式。它避免了手动提取特征的麻烦,允许计算机学习使用特征的同时,也学习如何提取特征:学习如何学习。 -

一个聚类算法将样本分成k个不同的聚类(cluster),从另一个角度说,这个聚类算法其实是为样本中的每一个实例提供了一种k维的one-hot编码方式。(正确)

解答: -

随机梯度下降(Stochastic Gradient Descent)算法是用小规模的样本近似估计梯度的方法,适合在大规模数据上训练深度神经网络,但在逻辑回归、SVM等算法中的作用很有限。(错误)

解答:

梯度下降法 用于是用于求解机器学习算法参数的优化算法。优点是效率高,只需要求一阶导数,计算代价小,可以在大规模数据上应用。缺点是求解的是局部最优解。

批量梯度下降法BGD 针对的是整个数据集,通过对所有样本的计算来求解梯度方向。优点是全局最优解,易于并行实现。缺点是当数据集很大时,计算开销大。

小批量梯度下降法MBGD 是把数据分成若干个批,按批来求解本批的梯度。优点降低了计算开销,减小了随机性。

随机梯度下降法 是每个数据都计算一下梯度,然后求梯度的更新。优点计算速度快。缺点收敛性不好。

逻辑回归、SVM等算法都可以使用随机梯度下降 -

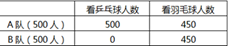

Apriori算法在机器学习和数据挖掘中被广泛使用,已知有1000名球迷看奥运会,分为AB两队,每队各500人,其中A队有500人看了乒乓球比赛,同时又有450人看了羽毛球比赛;B队有450人看了羽毛球比赛,如下表所示:

那么 乒乓球→羽毛球的支持度、置信度和提升度分别是( 0.45,0.9,1)

解答:

支持度: 表示项集 { X , Y } \{X,Y\} {X,Y}在总项集里出现的概率 S u p o r t ( X → Y ) = P ( X , Y ) P ( A L L ) = n u m ( X ∪ Y ) n u m ( A L L ) = 450 1000 = 0.45 Suport(X \to Y)=\frac{P(X,Y)}{P(ALL)}=\frac{num(X\cup Y)}{num(ALL)}=\frac{450}{1000}=0.45 Suport(X→Y)=P(ALL)P(X,Y)=num(ALL)num(X∪Y)=1000450=0.45

置信度: 表示在先决条件 X X X发生的条件下,由关联规则“ X → Y X\to Y X→Y”推出 Y Y Y的概率。即在含有 X X X的项集中含有 Y Y Y的概率。 C o n f i d e n c e ( X → Y ) = P ( Y ∣ X ) = P ( X , Y ) P ( X ) = n u m ( X , Y ) n u m ( X ) = 450 500 = 0.9 Confidence(X\to Y)=P(Y|X)=\frac{P(X,Y)}{P(X)}=\frac{num(X,Y)}{num(X)}=\frac{450}{500}=0.9 Confidence(X→Y)=P(Y∣X)=P(X)P(X,Y)=num(X)num(X,Y)=500450=0.9

提升度: 表示含有 X X X的条件下同时含有 Y Y Y的概率,与不含 X X X的条件下含有 Y Y Y的概率的比值。 L i f t ( X → Y ) = P ( X , Y ) P ( X ~ , Y ) = 450 450 = 1 Lift(X\to Y)=\frac{P(X,Y)}{P(\tilde{X},Y)}=\frac{450}{450}=1 Lift(X→Y)=P(X~,Y)P(X,Y)=450450=1 -

偏差-方差分解:

泛化性能是由学习算法的能力、数据的充分性以及学习任务本身的难度所共同决定的。

偏差: 刻画了学习算法的期望预测与真实结果的偏离程度,即刻画了算法本身的拟合能力,模型的预测准确度。

方差: 度量了同样大小的训练集的变动所导致的学习性能的变化,即刻画了数据扰动所造成的影响,即模型性能的稳定性。 -

有效解决过拟合的方法:

Early stopping

数据增强: 1)增加样本数量;2)增加噪声 输入噪声,等同于L2正则化。权值噪声,指在权值初始化的时候,用高斯分布。网络噪声,让训练向前传播的输出为随机,这使得在测试集上表现会更好。3)重采样;4)根据当前数据集估计数据分布参数,使用该分布产生更多数据等

通过特征选择减少特征数量

采用正则化方法(L1正则化/L2正则化) ,L1正则化能得到稀疏解,L2正则化约束了解空间。

Dropout

Batch Normalization

结合多种模型: 1)bagging,采用多次对样本的采样,并行进行多个模型的训练,最终对分类结果进行投票获得最终结果。2)boosting,串行地进行采样的模型训练,即比如每次取上个模型的错分样本。

交叉验证

决策树剪枝

选择合适的网络结构 -

有效解决欠拟合的方法:

添加其他特征项 增加特征的维度,通过特征组合、泛化、相关性等得到新特征并进行训练。

减少正则化参数

增加模型复杂度

添加多项式特征 将线性模型通过添加二次项或者三次项使线性模型泛化能力增强。 -

随机森林(RF)与梯度提升树(GBDT)区别:

GBDT和RF的相同点:

1.都是由多棵树组成

2.最终的结果都是由多棵树一起决定

GBDT和RF的不同点:

1.组成随机森林的树可以是分类树,也可以是回归树;而GBDT只由回归树组成

2.组成随机森林的树可以并行生成;而GBDT只能是串行生成

3.对于最终的输出结果而言,随机森林采用多数投票等;而GBDT则是将所有结果累加起来,或者加权累加起来

4.随机森林对异常值不敏感,GBDT对异常值非常敏感;

5.随机森林对训练数据一视同仁,GBDT是基于权值的弱分类器的集成;

6.随机森林是通过减少模型方差提高性能,GBDT是通过减少模型偏差提高性能;

理论上树模型全部不需要归一化。因为树模型不是靠梯度下降法来训练的,只跟特征值的大小有关。理论上不改变特征值的顺序不影响结果。 -

随机森林和Adaboost的区别:

和adaboost相比,随机森林对错误和离群点更鲁棒

随机森林对每次划分所考虑的属性数很偏感

Adaboost初始时每个训练元组被赋予相等的权重

随机森林准确率依赖于个体分类器的实例和他们之间的依赖性 -

基于二次准则函数的H-K算法较之于感知器算法的优点是(BD)?

A. 计算量小

B. 可以判别问题是否线性可分

C. 其解完全适用于非线性可分的情况

D. 其解的适应性更好

解答:

感知机可以理解为最简单的神经网络,对权重的更新仅依靠阈值。

HK算法(delta法则又叫增量法则, LMS法则,Adaline法则,Windrow-Hoff法则,或者这里的H-K(LSME法则))。思想很朴实,就是在最小均方误差准则下求得权矢量。他适用于线性可分和非线性可分的情况,对于线性可分的情况,给出最优权矢量,对于非线性可分的情况,能够判别出来,以退出迭代过程。 -

DBSCAN是一个比较有代表性的基于密度的聚类算法。与划分和层次聚类方法不同,它将簇定义为密度相连的点的最大集合,能够把具有足够高密度的区域划分为簇,并可在噪声的空间数据库中发现任意形状的聚类。具体算法描述如下: (1)检测数据库中尚未检查过的对象p,如果p未被处理(归为某个簇或者标记为噪声),则检查其邻域,若包含的对象数不小于minPts,建立新簇C,将其中的所有点加入候选集N; (2)对候选集N 中所有尚未被处理的对象q,检查其邻域,若至少包含minPts个对象,则将这些对象加入N;如果q 未归入任何一个簇,则将q 加入C; (3)重复步骤2),继续检查N 中未处理的对象,当前候选集N为空; (4)重复步骤1)~3),直到所有对象都归入了某个簇或标记为噪声。

-

Apriori算法是经典的挖掘频繁项集和关联规则的数据挖掘算法。该算法的基本思想是:首先找出所有的频集,这些项集出现的频繁性至少和预定义的最小支持度一样。然后由频集产生强关联规则,这些规则必须满足最小支持度和最小可信度。然后使用第1步找到的频集产生期望的规则,产生只包含集合的项的所有规则,其中每一条规则的右部只有一项,这里采用的是中规则的定义。一旦这些规则被生成,那么只有那些大于用户给定的最小可信度的规则才被留下来。为了生成所有频集,使用了递归的方法。

-

EM(Expectation-Maximum)算法也称期望最大化算法,是一种迭代优化策略,由于它的计算方法中每一次迭代都分两步,其中一个为期望步(E步),另一个为极大步(M步)。其基本思想是:首先根据己经给出的观测数据,估计出模型参数的值;然后再依据上一步估计出的参数值估计缺失数据的值,再根据估计出的缺失数据加上之前己经观测到的数据重新再对参数值进行估计,然后反复迭代,直至最后收敛,迭代结束。

-

假设我们想估计A和B这两个参数,在开始状态下二者都是未知的,但如果知道了A的信息就可以得到B的信息,反过来知道了B也就得到了A。可以考虑首先赋予A某种初值,以此得到B的估计值,然后从B的当前值出发,重新估计A的取值,这个过程一直持续到收敛为止,该算法是( C )的算法思想。

A.极大似然法

B.朴素贝叶斯分类器

C.EM算法

D.贝叶斯决策论

解答:

极大似然估计:就是利用已知的样本结果信息,反推最具有可能(最大概率)导致这些样本结果出现的模型参数值!提供了一种给定观察数据来评估模型参数的方法,即:“模型已定,参数未知”。 -

下列关于线性回归说法错误的是(D)

A.在现有模型上,加入新的变量,所得到的R^2的值总会增加

B.线性回归的前提假设之一是残差必须服从独立正态分布

C.残差的方差无偏估计是SSE/(n-p)

D.自变量和残差不一定保持相互独立

解答:

简单线性回归的古典假设:

1)样本是在总体之中随机抽取出来的。

2)因变量在实直线上是连续的

3)残差项是独立同分布的,也就是说,残差是独立的且服从高斯分布。

4)残差项不依赖自变量的值,所以和自变量(预测变量)之间是相互独立的。 -

目标变量在训练集上的7个实际值为[1,1,1,1,0,0,0],目标变量的熵近似值是(log3/7=-0.847,log4/7=-0.560)(0.683)

解答:

P ( X = x i ) = p i = n i N , i ∈ { 0 , 1 } P(X=x_i)=p_i=\frac{n_i}{N}, i \in \{0,1\} P(X=xi)=pi=Nni,i∈{0,1}

熵 H ( X ) = − ∑ i C p i l o g p i H(X)=-\sum_i^Cp_ilogp_i H(X)=−∑iCpilogpi

对于该题 H = − ( 3 7 l o g 3 / 7 + 4 7 l o g 4 / 7 ) = − ( − 0.847 − 0.560 ) = 0.683 H=-(\frac{3}{7}log3/7+\frac{4}{7}log4/7)=-(-0.847-0.560)=0.683 H=−(73log3/7+74log4/7)=−(−0.847−0.560)=0.683 -

现在假设负样本量:正样本量=20:1,下列哪些方法可以处理这种不平衡的情况?(ABC)

A.直接训练模型,预测的时候调节阈值

B.复制正样本,以增加正样本数量

C.随机降采样负样本

D.训练过程中,增加负样本的权重 -

在某神经网络的隐层输出中,包含-1.5,那么该神经网络采用的激活函数不可能是(ABC)

A.sigmoid B.tanh C.relu -

以下几种模型方法属于判别式模型的有(2,3)

1)混合高斯模型

2)条件随机场模型

3)区分度训练

4)隐马尔科夫模型

解答:

高斯混合模型(变量分布模型) 就是用高斯概率密度函数(正态分布曲线)精确地量化事物,它是一个将事物分解为若干的基于高斯概率密度函数(正态分布曲线)形成的模型。

线性链条件随机场CRF(判别式模型),是一种鉴别式机率模型,是随机场的一种,常用于标注或分析序列资料,如自然语言文字或是生物序列。

CRF 的优点:特征灵活,可以容纳较多的上下文信息,能够做到全局最优

CRF 的缺点:速度慢

隐马尔可夫模型(生成式模型)是统计模型,它用来描述一个含有隐含未知参数的马尔可夫过程。每个观测向量都是通过某些概率密度分布表现为各种状态,每一个观测向量是由一个具有相应概率密度分布的状态序列产生。

常见生成式模型:隐马尔可夫模型HMM、朴素贝叶斯模型、高斯混合模型GMM、LDA等 -

以下方法属于集成方法的是(ABCD)

A.bagging B.stacking C.blending D.boosting

-

在()情况下,用分支定界法做特征选择计算量相对较少? (BD)

A.选用的可分性判据J具有可加性

B.选用的可分性判据J对特征数目单调不减

C.样本较多

D. C n d > > n C_n^d >>n Cnd>>n,(n为原始特征个数,d为要选出的特征个数)

分支界定法围绕着一颗搜索树进行的,分支的过程就是不断给树增加子节点的过程。而定界就是在分支的过程中检查子问题的上下界,如果子问题不能产生一比当前最优解还要优的解,那么砍掉这一支。直到所有子问题都不能产生一个更优的解时,算法结束。 -

以下哪些算法不能用于路径规划 (D)

A.A* B.Dijkstra C.动态规划 D.K-Mean

解答:

A[1](A-Star)算法*是一种静态路网中求解最短路最有效的方法。 公式表示为: f(n)=g(n)+h(n), 其中 f(n) 是从初始点经由节点n到目标点的估价函数, g(n) 是在状态空间中从初始节点到n节点的实际代价, h(n) 是从n到目标节点最佳路径的估计代价。 保证找到最短路径(最优解的)条件,关键在于估价函数h(n)的选取: 估价值h(n)<= n到目标节点的距离实际值,这种情况下,搜索的点数多,搜索范围大,效率低。但能得到最优解。 如果 估价值>实际值,搜索的点数少,搜索范围小,效率高,但不能保证得到最优解。

Dijkstra算法 戴克斯特拉算法(英语:Dijkstra’s algorithm,又译迪杰斯特拉算法)由荷兰计算机科学家艾兹赫尔·戴克斯特拉在1956年提出。戴克斯特拉算法使用了广度优先搜索解决赋权有向图的单源最短路径问题。该算法存在很多变体;戴克斯特拉的原始版本找到两个顶点之间的最短路径,但是更常见的变体固定了一个顶点作为源节点然后找到该顶点到图中所有其它节点的最短路径,产生一个最短路径树。 -

bootstrap数据是什么意思?

有放回地从总共N个样本中抽样n个样本 -

一般情况下,KNN最近邻方法在( )情况下效果最好?

样本较少但典型性好 -

下面哪些算法模型可以用来完成命名实体的任务(CDEF)

A.GBDT B.LDA C.HMM D.CRF E.LSTM F.seq2seq

包括:

(1) 基于规则的方法。根据语言学上预定义的规则。但是由于语言结构本身的不确定性,规则的制定上难度较大。

(2) 基于统计学的方法。利用统计学找出文本中存在的规律。

主要有隐马尔可夫(HMM)、条件随机场(CRF)模型和Viterbi算法、支持向量机(Support Vector Machine, SVM)。

(3) 神经网络。

LSTM+CRF模型,基于RNN的seq2seq模型 -

下面哪些是基于核的机器学习算法?(BCD)

A.Expectation Maximization B.Radial Basis Function C.Linear Discrimimate Analysis D.Support Vector Machine

解答:

最大期望算法(Expectation Maximization,EM),EM算法是一种迭代优化策略,用于含有隐变量的概率参数模型的最大似然估计或极大后验概率估计。由于它的计算方法中每一次迭代都分两步,其中一个为期望步(E步),另一个为极大步(M步),所以算法被称为EM算法。

径向基(Radial Basis Function),径向基函数核(Radial basis function kernel),或称为RBF核,是一种常用的核函数。它是支持向量机分类中最为常用的核函数。 -

JC

机器学习专项练习题

最新推荐文章于 2024-05-20 12:33:24 发布

970

970

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?