转载于:http://blog.csdn.net/eviljoseph/article/details/52351403

前两天学习回归算法时看到LeftNotEasy的文章,该文写得很好,部分是对Andrew Ng在CS229上第二节课中讲解的回归算法进行总结,但是其中的公式存在一些表述方面的小问题,在此我提一下我的拙见。

部分假设与原文中一样,方便理解。

假设估计函数为:

式 1

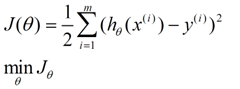

损失函数为:

式 2

对基本的梯度下降思想就不进行讲解了,如果有兴趣,可以去查看LeftNotEasy的文章。原文中对θ求偏导的结果如下:

式 3

看评论发现许多人和我一样对中间式子的求和符号的消失以及下标问题表示有点迷惑,因此我想在此用更为通俗易懂的式子描述一下,仅供参考。

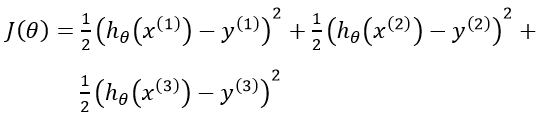

首先,我们从错误函数开始,明确原式中m的含义,m代表的是训练数据的条数;而其中有一个没有展示出的n,表示数据特征数,也就是维度(x0,x1,...,xn)。

这里简单地推导下:

根据我们的估计函数,n=2(x0=1),再假设有3条训练数据(有点少=_=),则m=3,所以:

式 4

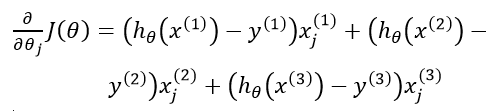

先不去理解式3中对θ求偏导中θ的意义,我们来对θj求偏导,反正最后需要的也是这个。

下面这个过程就相当简单了,求导后均可提出xj:

式 5

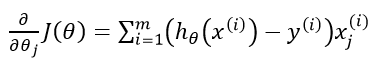

所以:

式 6

j为0到n之间的整数,当j=0时,x0=1。

2167

2167

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?