Hadoop(二)Hadoop运行模式

Hadoop运行模式包括:本地模式、伪分布式模式以及完全分布式模式

- 本地模式:单机运行,只是用来演示一下官方案例。生产环境不用

- 伪分布式模式:也是单机运行,但是具备Hadoop集群的所有功能,一台服务器模拟一个分布式的环境。生产环境一般也不用

完全分布式模式:多台服务器组成分布式环境。生产环境使用

1.完全分布式模式环境搭建

1.1 常用命令

scp(secure copy)安全拷贝:scp可以实现服务器与服务器之间的数据拷贝(from server1 to server2)

基本语法:scp -r $pdir/$fname $user@$host:$pdir/$fname

命令 递归 要拷贝的文件路径/名称 目的地用户@主机:目的地路径/名称

示例1:将102服务器当前目录下的jdk拷贝到103服务器上的module文件下

scp -r jdk1.8.0_212/ root@hadoop103:/opt/module

示例2:从103服务器上拉取102服务器上的hadoop文件

scp -r root@hadoop102:/opt/module/hadoop-3.1.3 ./

示例3:从103上把102的文件拷贝到104

scp -r root@hadoop102:/opt/module/* root@hadoop104:/opt/module

rsync主要用于备份和镜像。具有速度快、避免复制相同内容和支持符号链接的优点

rsync和scp区别:用rsync做文件的复制要比scp的速度快,rsync只对差异文件做更新。scp是把所有文件都复制过去

基本语法:rsync -av $pdir/$fname $user@$host:$pdir/$fname

命令 选项参数 要拷贝的文件路径/名称 目的地用户@主机:目的地路径/名称

xsync集群分发脚本

作用:循环复制文件到所有节点的相同目录下

1.在/home/atguigu/bin目录下创建xsync文件

[gzhu@hadoop102 opt]$ cd /home/atguigu

[gzhu@hadoop102 ~]$ mkdir bin

[gzhu@hadoop102 ~]$ cd bin

[gzhu@hadoop102 bin]$ vim xsync

2.在该文件中编写如下代码

#!/bin/bash

#1. 判断参数个数

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop102 hadoop103 hadoop104

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4. 判断文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件的名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done

3.修改脚本 xsync 具有执行权限

[gzhu@hadoop102 bin]$ chmod +x xsync

4.测试脚本(将/home/gzhu/目录下的bin复制到102和103)

[gzhu@hadoop102 ~]$ xsync /home/gzhu/bin

5.同步环境变量配置

注意:如果用了sudo,那么xsync一定要给它的路径补全

[gzhu@hadoop102 ~]$ sudo ./bin/xsync /etc/profile.d/my_env.sh

6.让环境变量生效

[gzhu@hadoop103 ~]$ source /etc/profile

[gzhu@hadoop104 ~]$ source /etc/profile

1.2 SSH免密登录

进入家目录下.ssh的隐藏文件

在该目录下执行ssh-keygen -t rsa指令并按三次回车,就会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

将公钥拷贝到要免密登录的目标机器上

[gzhu@hadoop102 .ssh]$ ssh-copy-id hadoop102

[gzhu@hadoop102 .ssh]$ ssh-copy-id hadoop103

[gzhu@hadoop102 .ssh]$ ssh-copy-id hadoop104

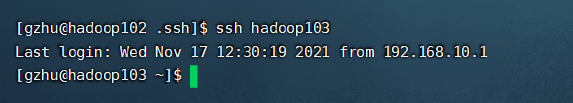

这样就可以在102服务器上登录103了

同样的,在102和103生成密钥后配置到另外两台服务器

.ssh文件夹下(~/.ssh)的文件功能解释

- known_hosts:记录ssh访问过计算机的公钥(public key)

- id_rsa:生成的私钥

- id_rsa.pub:生成的公钥

- authorized_keys:存放授权过的无密登录服务器公钥

1.3 集群配置

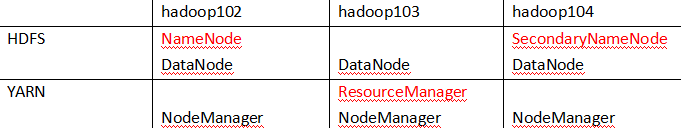

集群部署规划

- NameNode和SecondaryNameNode不要安装在同一台服务器

- ResourceManager也很消耗内存,不要和NameNode、SecondaryNameNode配置在同一台机器上

配置文件说明

Hadoop配置文件分两类:默认配置文件和自定义配置文件,只有用户想修改某一默认配置值时,才需要修改自定义配置文件,更改相应属性值

默认配置文件及其位置:

- [core-default.xml] hadoop-common-3.1.3.jar/core-default.xml

- [hdfs-default.xml] hadoop-hdfs-3.1.3.jar/hdfs-default.xml

- [yarn-default.xml] hadoop-yarn-common-3.1.3.jar/yarn-default.xml

- [mapred-default.xml] hadoop-mapreduce-client-core-3.1.3.jar/mapred-default.xml

自定义配置文件:

core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml四个配置文件存放在$HADOOP_HOME/etc/hadoop这个路径上,用户可以根据项目需求重新进行修改配置

核心配置文件

配置core-site.xml

[gzhu@hadoop102 ~]$ cd $HADOOP_HOME/etc/hadoop

[gzhu@hadoop102 hadoop]$ vim core-site.xml

文件内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- 指定NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop102:8020</value>

</property>

<!-- 指定hadoop数据的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-3.1.3/data</value>

</property>

<!-- 配置HDFS网页登录使用的静态用户为atguigu -->

<property>

<name>hadoop.http.staticuser.user</name>

<value>gzhu</value>

</property>

</configuration>

HDFS配置文件

[gzhu@hadoop102 hadoop]$ vim hdfs-site.xml

文件内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- nn web端访问地址-->

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop102:9870</value>

</property>

<!-- 2nn web端访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop104:9868</value>

</property>

</configuration>

YARN配置文件

[gzhu@hadoop102 hadoop]$ vim yarn-site.xml

文件内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- 指定MR走shuffle -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定ResourceManager的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop103</value>

</property>

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

</configuration>

MapReduce配置文件

[gzhu@hadoop102 hadoop]$ vim mapred-site.xml

文件内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- 指定MapReduce程序运行在Yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

在集群上分发配置好的Hadoop配置文件(如果权限不够用sudo,见上文)

[gzhu@hadoop102 hadoop]$ xsync /opt/module/hadoop-3.1.3/etc/hadoop/

去103和104上查看文件分发情况

[gzhu@hadoop103 ~]$ cat /opt/module/hadoop-3.1.3/etc/hadoop/core-site.xml

[gzhu@hadoop104 ~]$ cat /opt/module/hadoop-3.1.3/etc/hadoop/core-site.xml

1.4 群起集群

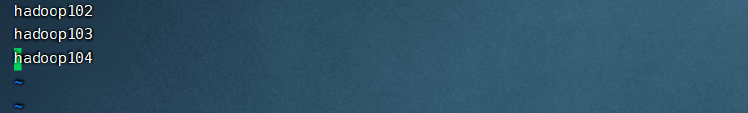

配置workers

cd /opt/module/hadoop-3.1.3

cd etc/hadoop/

vim workers

配置三台主机名称

注意:该文件中添加的内容结尾不允许有空格,文件中不允许有空行

分发:xsync workers

启动集群

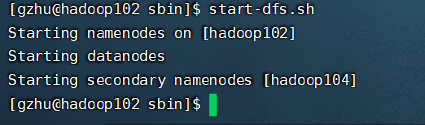

启动HDFS

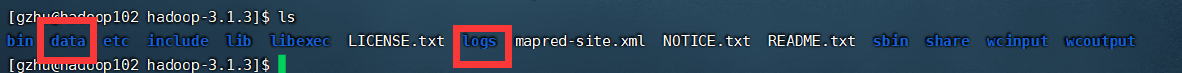

①如果集群是第一次启动,需要在hadoop102节点格式化NameNode(注意:格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到已往数据。如果集群在运行过程中报错,需要重新格式化NameNode的话,一定要先停止namenode和datanode进程,并且要删除所有机器的data和logs目录,然后再进行格式化)

[gzhu@hadoop102 hadoop-3.1.3]$ hdfs namenode -format

初始化完成后hadoop目录下会多一个data和logs文件

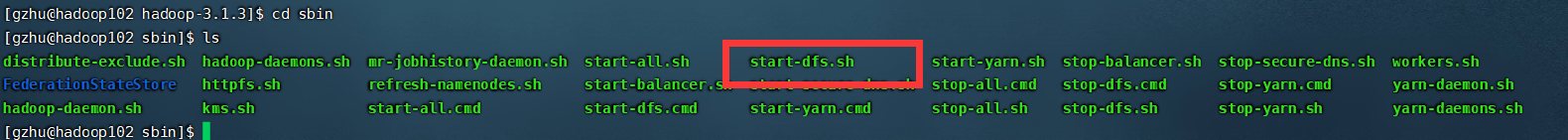

在sbin目录下有个start-dfs.sh命令

jps查看当前进程

浏览器输入http://hadoop102:9870/可以登录到hdfs页面

启动RM

要在hadoop103启动,RM因为安装在hadoop103服务器上

浏览器输入http://192.168.10.103:8088/登录yarn管理界面

集群基本测试

①在HDFS目录下创建一个test目录

[gzhu@hadoop102 hadoop-3.1.3]$ hadoop fs -mkdir /test

②上传文件到该目录下

[gzhu@hadoop102 hadoop-3.1.3]$ hadoop fs -put wcinput/word.txt /test

文件实际存储在data目录下

测试

[gzhu@hadoop102 hadoop-3.1.3]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /test /result

/result为输出目录,可以看到执行成功

1.5 集群故障处理

①杀死相关组件,比如stop-dfs.sh

②删除各个服务器上的data和logs文件

[gzhu@hadoop102 hadoop-3.1.3]$ rm -rf data/ logs/

[gzhu@hadoop103 hadoop-3.1.3]$ rm -rf data/ logs/

[gzhu@hadoop104 hadoop-3.1.3]$ rm -rf data/ logs/

③格式化

[gzhu@hadoop102 hadoop-3.1.3]$ hdfs namenode -format

④启动相关组件,成功

2.配置历史服务器

在hadoop102的etc/hadoop下的mapred-site.xml配置历史服务器

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop102:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop102:19888</value>

</property>

然后分发到其他服务器

在hadoop102启动历史服务器

mapred --daemon start historyserver

浏览器输入http://192.168.10.102:19888/jobhistory进入历史界面

3.配置日志聚集

日志聚集概念:应用运行完成以后,将程序运行日志信息上传到HDFS系统上

日志聚集功能好处:可以方便的查看到程序运行详情,方便开发调试

注意:开启日志聚集功能,需要重新启动NodeManager 、ResourceManager和HistoryServer

开启日志聚集功能具体步骤如下:

①在hadoop目录下的yarn-site.xml配置

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志聚集服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://hadoop102:19888/jobhistory/logs</value>

</property>

<!-- 设置日志保留时间为7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

②分发配置

xsync $HADOOP_HOME/etc/hadoop/yarn-site.xml

③关闭NodeManager 、ResourceManager和HistoryServer

[gzhu@hadoop103 sbin]$ stop-yarn.sh

[gzhu@hadoop102 hadoop]$ mapred --daemon stop historyserver

④重启NodeManager 、ResourceManage和HistoryServer

[gzhu@hadoop103 sbin]$ start-yarn.sh

[gzhu@hadoop102 hadoop]$ mapred --daemon start historyserver

⑤重新执行任务

[gzhu@hadoop102 hadoop-3.1.3]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /test /result

⑥查看日志

4.一键启动集群

①各个模块分开启动/停止(配置ssh是前提)常用

(1)整体启动/停止HDFS

start-dfs.sh/stop-dfs.sh

(2)整体启动/停止YARN

start-yarn.sh/stop-yarn.sh

②各个服务组件逐一启动/停止

(1)分别启动/停止HDFS组件

hdfs --daemon start/stop namenode/datanode/secondarynamenode

(2)启动/停止YARN

yarn --daemon start/stop resourcemanager/nodemanager

一键启动脚本

[gzhu@hadoop102 bin]$ vim myhadoop.sh

输入如下内容

#!/bin/bash

if [ $# -lt 1 ]

then

echo "No Args Input..."

exit ;

fi

case $1 in

"start")

echo " =================== 启动 hadoop集群 ==================="

echo " --------------- 启动 hdfs ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/sbin/start-dfs.sh"

echo " --------------- 启动 yarn ---------------"

ssh hadoop103 "/opt/module/hadoop-3.1.3/sbin/start-yarn.sh"

echo " --------------- 启动 historyserver ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/bin/mapred --daemon start historyserver"

;;

"stop")

echo " =================== 关闭 hadoop集群 ==================="

echo " --------------- 关闭 historyserver ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/bin/mapred --daemon stop historyserver"

echo " --------------- 关闭 yarn ---------------"

ssh hadoop103 "/opt/module/hadoop-3.1.3/sbin/stop-yarn.sh"

echo " --------------- 关闭 hdfs ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/sbin/stop-dfs.sh"

;;

*)

echo "Input Args Error..."

;;

esac

保存退出

加权限

chmod +x myhadoop.sh

测试

[gzhu@hadoop102 bin]$ myhadoop.sh stop

[gzhu@hadoop102 bin]$ myhadoop.sh start

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?