简单来说:

爬虫,即网络蜘蛛,是伪装成客户端与服务器进行数据交互的程序。

代码

from bs4 import BeautifulSoup #网页解析

import urllib.request,urllib.error #制定URL,获取网页数据

import re #正则表达式 进行文字匹配

import xlwt #进行excel操作

from tqdm import trange #进度条库

def main():

baseurl = "https://movie.douban.com/top250?start="

# 1.爬取网页

# 2.逐一解析数据

datalist =getDate(baseurl)

# 3.保存数据

savepath = "豆瓣top250.xls"

savedata(datalist,savepath)

#影片详情链接

findLink = re.compile(r'<a href="(.*?)">') #创建正则表达式,表示规则(字符串的模式)

#影片图片的链接

findImagesrc = re.compile( r'<img[^>]+src=["\']([^"\']+)["\']') #ai写的正则

#影片中文片名

findName = re.compile(r'<span class="title">(.*)</span>')

#影片评分

findRating = re.compile(r'<span class="rating_num" property="v:average">(.*)</span>')

#影片热评

findComment = re.compile(r'<span class="inq">(.*?)</span>')

def getDate(baseurl):

datalist = []

# 1.爬取网页

for i in trange(0,10):

url = baseurl + str(i*25)

html = askURL(url) #保存获取到的网络源码

soup = BeautifulSoup(html,"html.parser")

for item in soup.find_all('div',class_="item"):

# 2.逐一解析数据

item =str(item)

data=[]

name = re.findall(findName,item)[0]

data.append(name)

link = re.findall(findLink,item)[0]

data.append(link)

img = re.findall(findImagesrc,item)[0]

data.append(img)

rating = re.findall(findRating,item)

data.append(rating)

comment = re.findall(findComment,item)

if len(comment)!=0:

comment=comment[0].replace("。","")

data.append(comment)

else:

data.append(" ")

datalist.append(data)

return datalist

def askURL(url):

head={

"User-Agent":"Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/121.0.0.0 Mobile Safari/537.36 Edg/121.0.0.0"

}

request = urllib.request.Request(url,headers=head)

html= ""

try:

response=urllib.request.urlopen(request)

html=response.read().decode("utf-8")

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html

def savedata(datalist,savepath):

book = xlwt.Workbook(encoding="utf-8",style_compression=0) #压缩样式效果,设为0

sheet = book.add_sheet('top250',cell_overwrite_ok=True) #每个单元在写入时覆盖以前的内容

col = ('电影中文名','电影详情链接','图片链接','电影评分','电影热评')

for i in range(0,len(col)):

sheet.write(0,i,col[i]) #列名

for i in range (0,250):

data = datalist[i]

for j in range (0,len(col)):

sheet.write(i+1,j,data[j])

book.save(savepath)

if __name__ == "__main__":

main()

print("爬取完成")需要用到的库: from bs4 import BeautifulSoup #网页解析 import urllib.request,urllib.error #制定URL,获取网页数据 import re #正则表达式 进行文字匹配 import xlwt #进行excel操作 from tqdm import trange

进度条库,当然你也可以不用,这个库只需要把for循环里的range改为trange,你就可以得到一个进度条

思路

1.获取网页的源码

def askURL(url):

head={

"User-Agent":"Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/121.0.0.0 Mobile Safari/537.36 Edg/121.0.0.0"

}

request = urllib.request.Request(url,headers=head)

html= ""

try:

response=urllib.request.urlopen(request)

html=response.read().decode("utf-8")

#print(html)

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html用个循环,根据网页制定一下url

找到用于伪装客户端User-Agent

在network里刷新一下网页,找到发送的标头header

这个是user-agent:Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/121.0.0.0 Mobile Safari/537.36 Edg/121.0.0.0

用urllib获取你制定的url的源码

在 try 块中:

调用 urllib.request.urlopen(request) 发送HTTP请求,并获取响应对象 response。

通过 response.read() 获取服务器返回的原始二进制数据。

使用 decode("utf-8") 方法将二进制数据解码成UTF-8编码的字符串,并将其赋值给变量 html。

如果在执行 urlopen 函数过程中出现 urllib.error.URLError 异常,则进入 except 块:

判断异常对象是否包含 .code 属性,如果有则打印出HTTP状态码。

再判断异常对象是否包含 .reason 属性,如果有则打印出错误原因。

最后,无论是否发生异常,都返回抓取到的网页HTML内容(即变量 html)

2.解析数据

def getDate(baseurl):

datalist = []

# 1.爬取网页

for i in trange(0,10):

url = baseurl + str(i*25)

html = askURL(url) #保存获取到的网络源码

soup = BeautifulSoup(html,"html.parser")

for item in soup.find_all('div',class_="item"):

# 2.逐一解析数据

item =str(item)

data=[]

name = re.findall(findName,item)[0]

data.append(name)

link = re.findall(findLink,item)[0]

data.append(link)

img = re.findall(findImagesrc,item)[0]

data.append(img)

rating = re.findall(findRating,item)

data.append(rating)

comment = re.findall(findComment,item)

if len(comment)!=0:

comment=comment[0].replace("。","")

data.append(comment)

else:

data.append(" ")

datalist.append(data)

return datalistBeautifulSoup

bs4是一个强大的库,用于从HTML和XML文件中提取数据,它能够将复杂的HTML结构转换成树形结构(即元素树),使得开发者可以方便地搜索、遍历以及修改网页内容。

"html.parser": 这是BeautifulSoup用来解析HTML文档的解析器。在这个案例中,它是指Python自带的标准HTML解析器。除了标准的解析器外,BeautifulSoup还可以配合其他第三方解析器如 lxml 来使用。

用bs4和re筛选信息

3.保存数据 写入excel表中

需要用到xwlt库

def savedata(datalist,savepath):

book = xlwt.Workbook(encoding="utf-8",style_compression=0) #压缩样式效果,设为0

sheet = book.add_sheet('top250',cell_overwrite_ok=True) #每个单元在写入时覆盖以前的内容

col = ('电影中文名','电影详情链接','图片链接','电影评分','电影热评')

for i in range(0,len(col)):

sheet.write(0,i,col[i]) #列名

for i in range (0,250):

data = datalist[i]

for j in range (0,len(col)):

sheet.write(i+1,j,data[j])

book.save(savepath)零基础怎么学Python爬虫?

这里分享给大家一套免费的学习资料,包含视频、源码/电子书,希望能帮到那些不满现状,想提升自己却又没有方向的朋友,也可以加我微信一起来学习交流。

① Python所有方向的学习路线图,清楚各个方向要学什么东西

②Python、PyCharm学习工具包全家桶,环境配置教程视频

③Python全套电子书籍PDF,全部都是干货知识

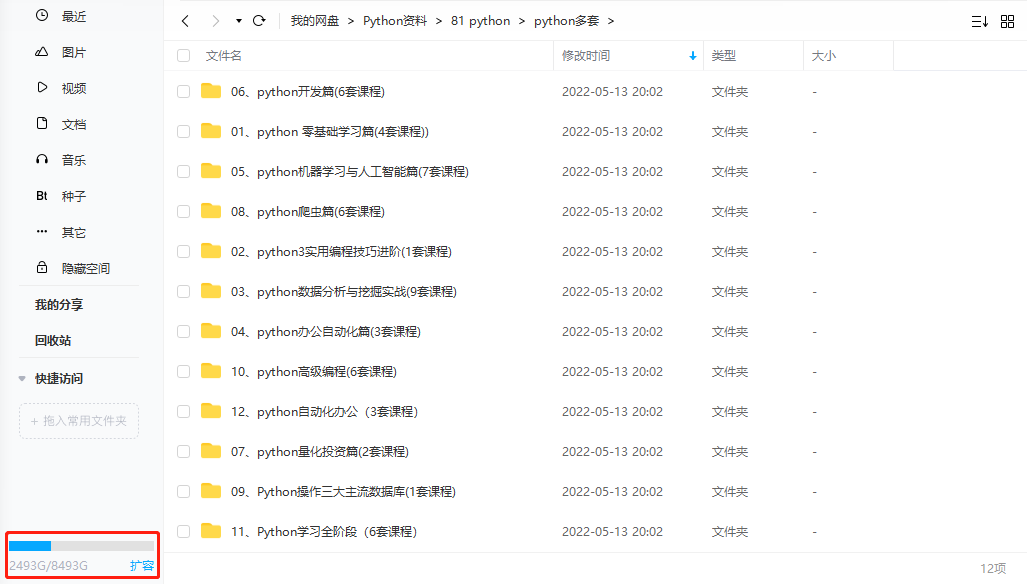

④ 100多节Python课程视频,涵盖必备基础、爬虫和数据分析

⑤ 100多个Python实战案例,学习不再是只会理论

全套Python学习资料分享:

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,还有环境配置的教程,给大家节省了很多时间。

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

四、入门学习视频全套

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

希望这些内容对你有帮助,也希望能帮到大家,因为你我都是热爱python的编程语言爱好者。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?