版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

传送门:大数据系列文章目录

官方网址:http://spark.apache.org/、 http://spark.apache.org/sql/

SparkSQL的介绍

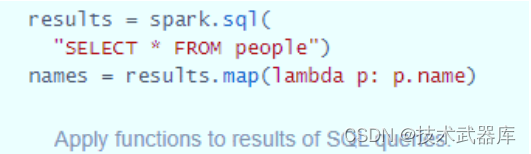

Spark SQL允许开发人员直接处理RDD,同时可以查询在Hive上存储的外部数据。 Spark SQL的一个重要特点就是能够统一处理关系表和RDD,使得开发人员可以轻松的使用SQL命令进行外部查询,同时进行更加复杂的数据分析。

前世今生

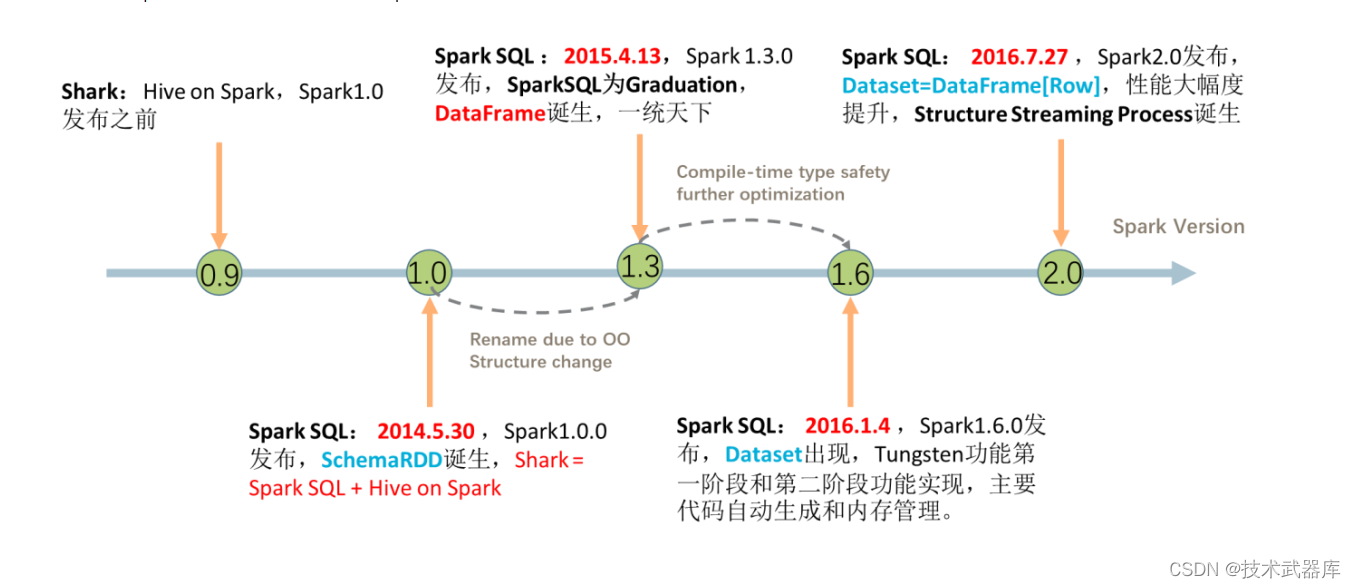

SparkSQL模块一直到Spark 2.0版本才算真正稳定,发挥其巨大功能,发展经历如下几个阶段。

Shark 框架

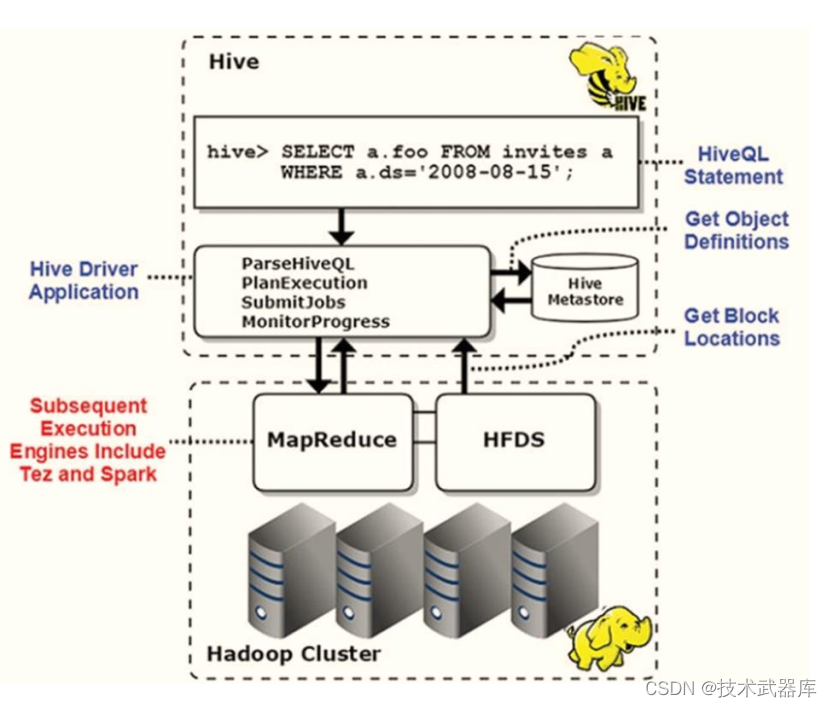

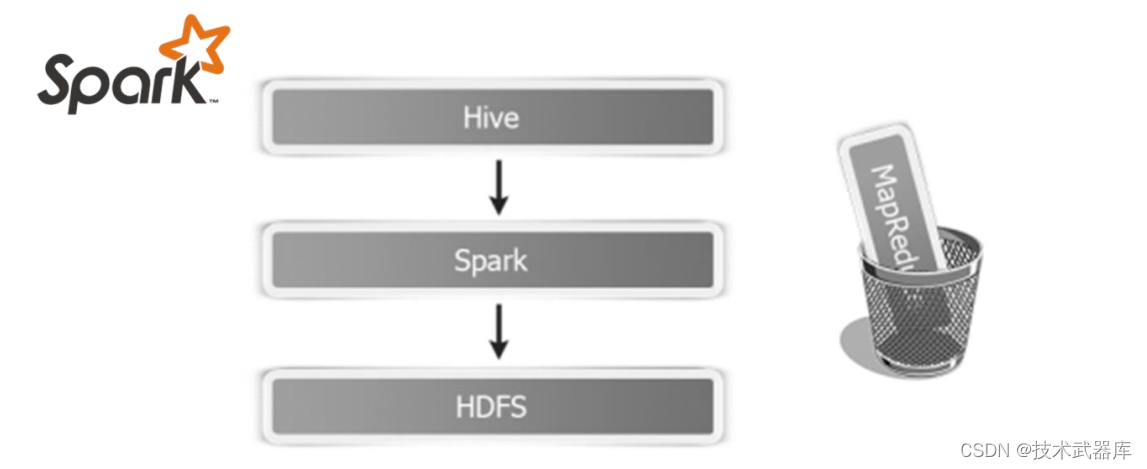

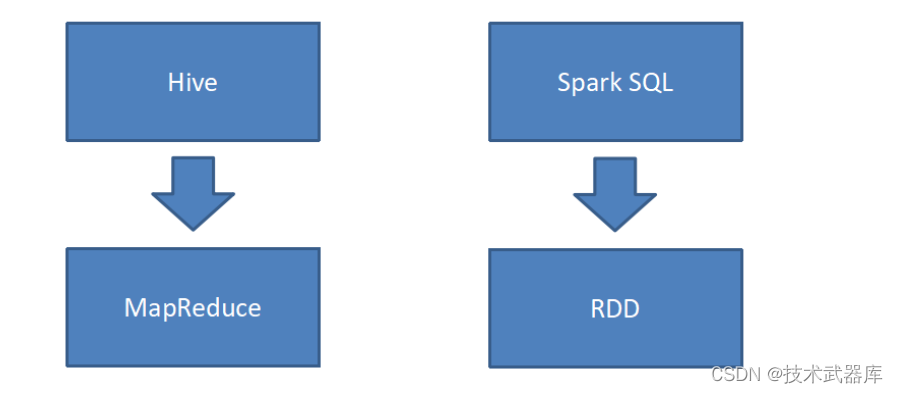

首先回顾SQL On Hadoop框架: Hive(可以说Hive是大数据生态系统中第一个SQL框架),架构如下所示:

可以发现Hive框架底层就是MapReduce,所以在Hive中执行SQL时,往往很慢很慢。

Spark出现以后, 将HiveSQL语句翻译成基于RDD操作,此时Shark框架诞生了。

Spark SQL的前身是Shark,它发布时Hive可以说是SQL on Hadoop的唯一选择(Hive负责将SQL编译成可扩展的MapReduce作业),鉴于Hive的性能以及与Spark的兼容, Shark由此而生。

Shark即Hive on Spark,本质上是通过Hive的HQL进行解析,把HQL翻译成Spark上对应的RDD操作,然后通过Hive的Metadata获取数据库里表的信息,实际为HDFS上的数据和文件,最后有Shark获取并放到Spark上计算。

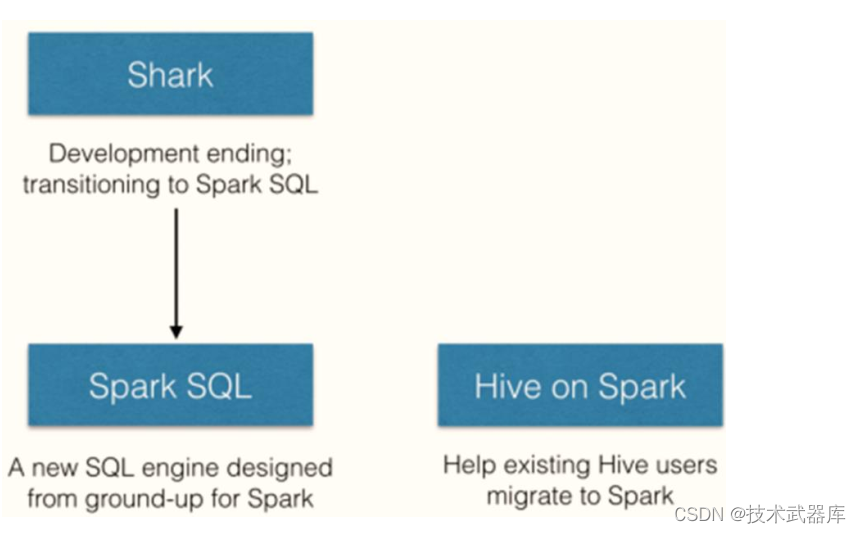

但是Shark框架更多是对Hive的改造,替换了Hive的物理执行引擎,使之有一个较快的处理速度。然而不容忽视的是Shark继承了大量的Hive代码,因此给优化和维护带来大量的麻烦。 为了更好的发展, Databricks在2014年7月1日Spark Summit上宣布终止对Shark的开发,将重点放到SparkSQL模块上。

文档: https://databricks.com/blog/2014/07/01/shark-spark-sql-hive-on-spark-and-the-future-of-sql-on-spark.html

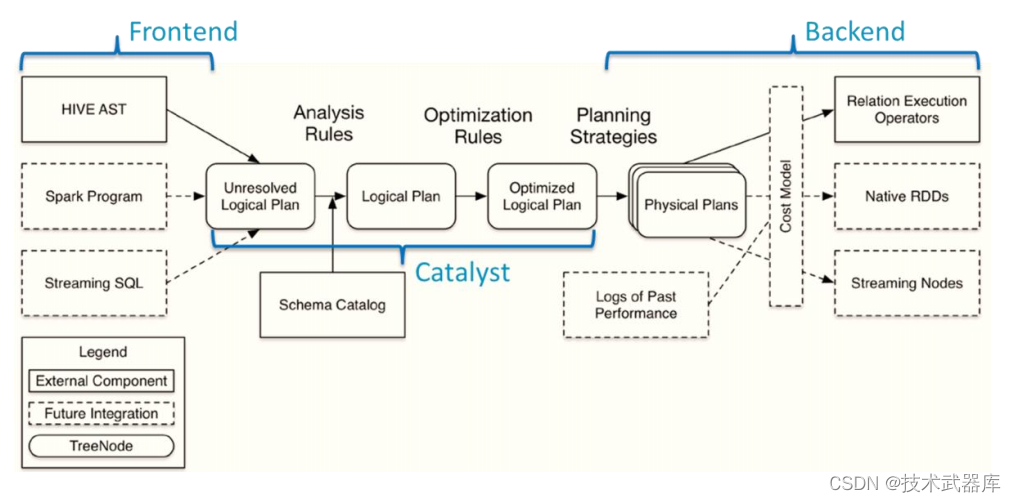

SparkSQL模块主要将以前依赖Hive框架代码实现的功能自己实现,称为Catalyst引擎。

SparkSQL 模块

从Spark框架1.0开始发布SparkSQL模块开发,直到1.3版本发布SparkSQL Release版本可以在生产环境使用,此时数据结构为: DataFrame = RDD + Schame。

1)、解决的问题

- Spark SQL 执行计划和优化交给优化器 Catalyst;

- 内建了一套简单的SQL解析器,可以不使用HQL;

- 还引入和 DataFrame 这样的DSL API,完全可以不依赖任何 Hive 的组件;

2)、新的问题

- 对于初期版本的SparkSQL,依然有挺多问题,例如只能支持SQL的使用,不能很好的兼容命令式,入口不够统一等;

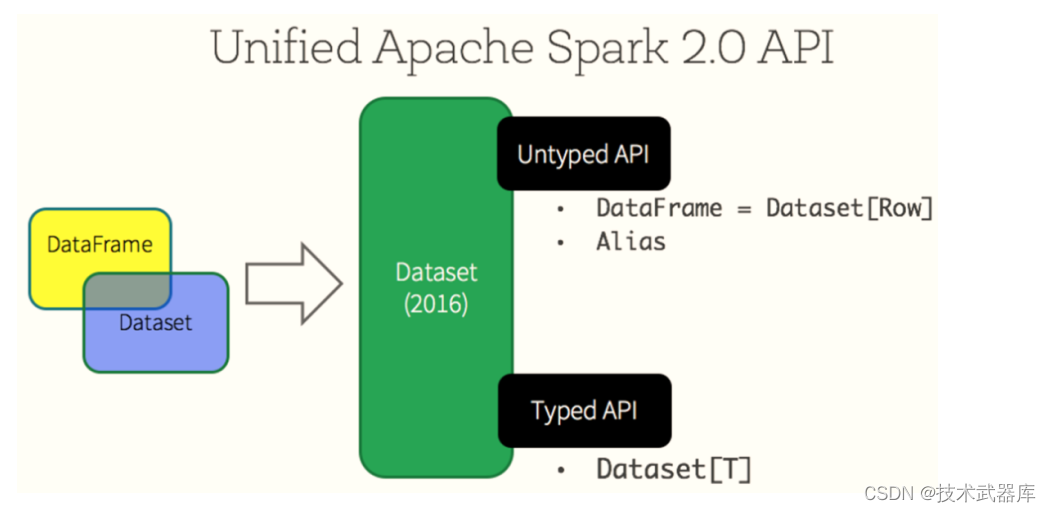

SparkSQL 在 1.6 时代,增加了一个新的API叫做 Dataset, Dataset 统一和结合了 SQL 的访问和命令式 API 的使用,这是一个划时代的进步。在 Dataset 中可以轻易的做到使用 SQL 查询并且筛选数据,然后使用命令式 API 进行探索式分析。

Spark 2.x发布时,将Dataset和DataFrame统一为一套API,以Dataset数据结构为主(Dataset= RDD + Schema),其中DataFrame = Dataset[Row]。

Hive 与 SparkSQL

从SparkSQL模块前世今生可以发现,从Hive框架衍生逐渐发展而来, Hive框架提供功能SparkSQL几乎全部都有,并且SparkSQL完全兼容Hive,从其加载数据进行处理。

Hive是将SQL转为MapReduce, SparkSQL可以理解成是将SQL解析成RDD + 优化再执行。

官方定义

SparkSQL模块官方定义:针对结构化数据处理Spark Module模块。

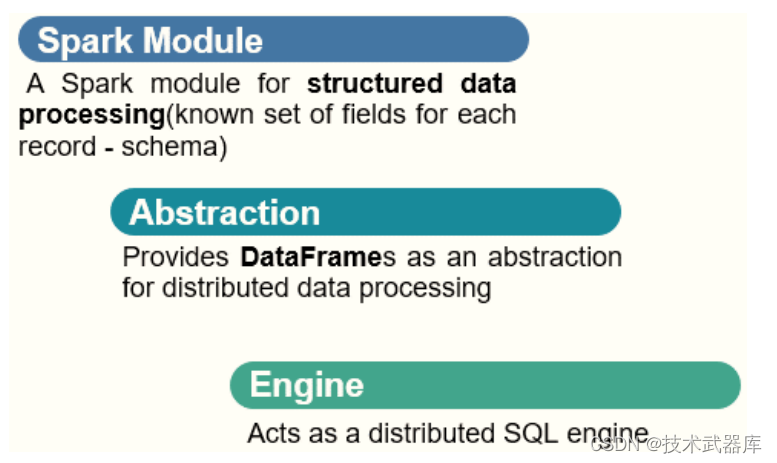

主要包含三层含义:

第一、针对结构化数据处理,属于Spark框架一个部分

- 结构化数据:一般指数据有固定的 Schema(约束),例如在用户表中, name 字段是 String型,那么每一条数据的 name 字段值都可以当作 String 来使用;

- schema信息,包含字段的名称和字段的类型,比如: JSON、 XML、 CSV、 TSV、 MySQLTable、 ORC、 Parquet, ES、 MongoDB等都是结构化数据;

第二、抽象数据结构: DataFrame

-

将要处理的结构化数据封装在DataFrame中,来源Python数据分析库Pandas和R语言dataframe;

-

DataFrame = RDD[Row] + Schema信息;

第三、分布式SQL引擎,类似Hive框架

- 从Hive框架继承而来, Hive中提供bin/hive交互式SQL命令行及HiveServer2服务,SparkSQL都可以;

Spark SQL模块架构示意图如下:

SparkSQL 特性

Spark SQL是Spark用来处理结构化数据的一个模块,主要四个特性:

第一、易整合

可以使用Java、 Scala、 Python、 R等语言的API操作。

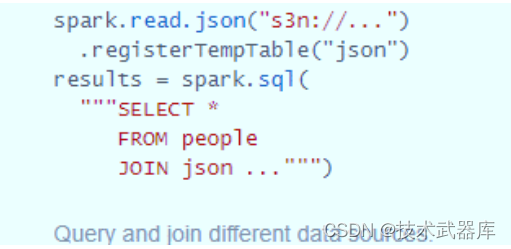

第二、 统一的数据访问

连接到任何数据源的方式相同。

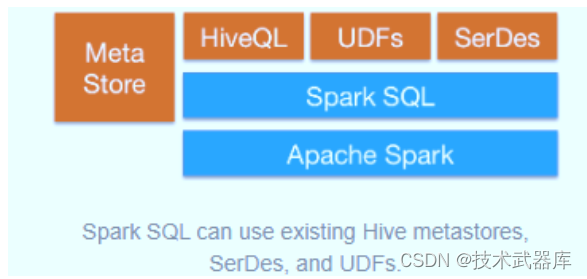

第三、 兼容Hive

支持Hive HQL的语法,兼容hive(元数据库、 SQL语法、 UDF、序列化、反序列化机制)。

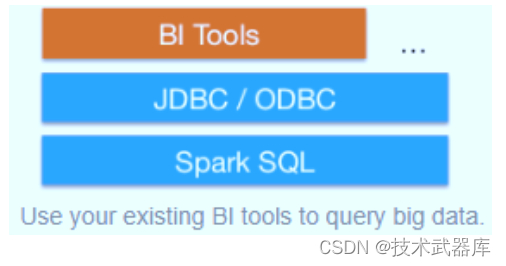

第四、 标准的数据连接

可以使用行业标准的JDBC或ODBC连接。

SparkSQL模块官方文档: http://spark.apache.org/docs/2.4.5/sql-programming-guide.html

1073

1073

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?