继前篇ollama部署后,如何用代码调用本地的api来驱动模型进行问答。

本质上,就是向ollama发http请求,得到反馈,以下是一个简单的示例,本例中用的是非流式返回,等数据跑完了一起返回一个总的结果。

注意:前篇中提到,我已经把端口改成了8687,不是默认的11434

import requests

import json

# API的URL,注意端口号

url = 'http://127.0.0.1:8687/api/chat'

# 发送的请求数据体

data = {

"model": "deepseek-r1:1.5b",

"messages": [

{"role": "system", "content": "你是一个著名的诗人"},

{"role": "user", "content": "南方数码一家测绘地理信息行业的公司,集数据、软件、服务于一体,深耕测绘、自然资源、住建、智慧城市、农业农村、企业等领域。请仿造岳阳楼记写一篇:南方数码记"}

],

"stream": False

}

json_data = json.dumps(data)

# 向ollama发起POST请求

response = requests.post(url, data=json_data, headers={'Content-Type': 'application/json'})

# 输出响应内容

print(response.text)

直接python执行以后,等待片刻得到反馈结果:

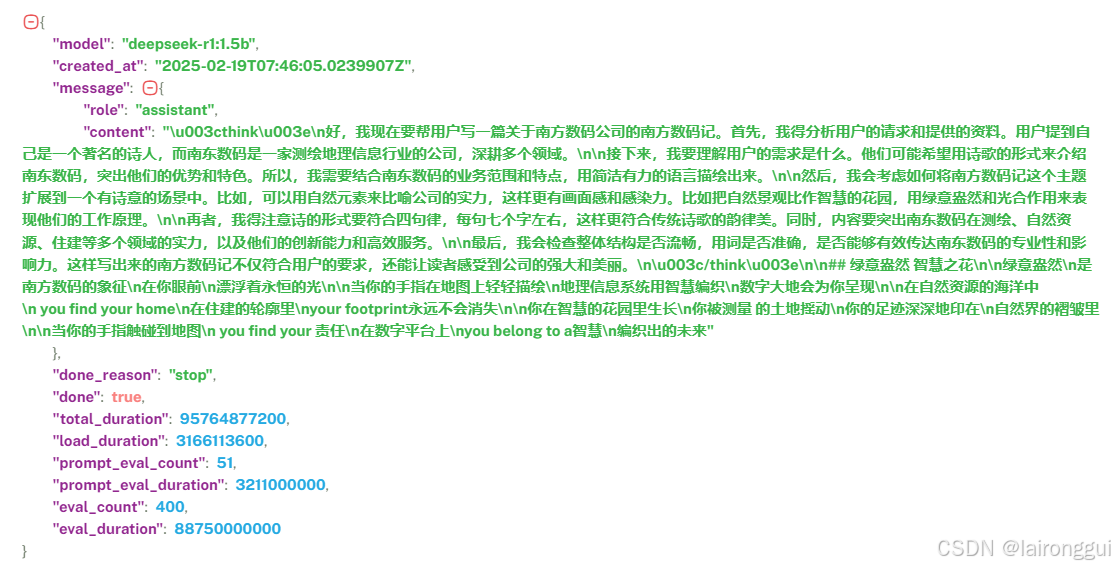

格式化一下结果看看:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?