引言:并发编程的挑战

在多线程编程中,资源竞争是开发者面临的核心挑战。当多个线程同时访问共享资源(如变量、文件、数据库连接等)时,可能导致数据不一致、程序崩溃或不可预测的行为。Python的全局解释器锁(GIL)虽然在一定程度上简化了线程安全,但并不能解决所有并发问题。互斥锁(Mutex) 作为并发编程的基石,提供了确保线程安全的可靠机制。

本文将深入探讨Python中互斥锁的实现原理、使用模式、性能优化和实战应用,通过原创代码示例和深度分析,帮助您掌握构建健壮并发系统的核心技术。

第一部分:互斥锁基础理论

1.1 互斥锁的核心概念

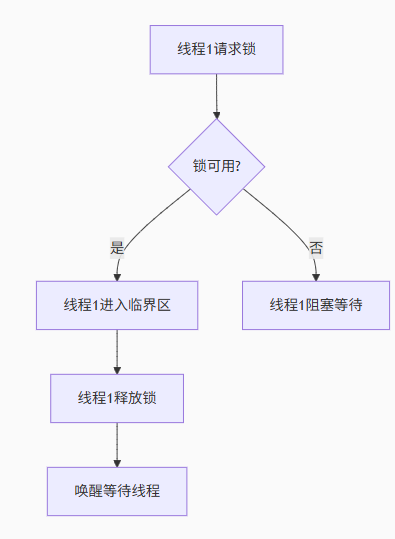

互斥锁(Mutual Exclusion Lock)是一种同步原语,用于保护共享资源,确保在任何时刻只有一个线程可以访问临界区。其基本操作包括:

-

获取锁(acquire):线程请求对资源的独占访问权

-

释放锁(release):线程释放资源控制权

-

阻塞等待:当锁被占用时,其他请求线程进入等待状态

1.2 竞争条件与数据损坏

考虑以下未使用锁的银行账户操作:

class UnsafeAccount:

def __init__(self, balance):

self.balance = balance

def withdraw(self, amount):

if amount <= self.balance:

# 模拟处理延迟

time.sleep(0.001)

self.balance -= amount

return True

return False

# 测试代码

account = UnsafeAccount(1000)

def concurrent_withdraw():

for _ in range(100):

account.withdraw(1)

# 创建10个线程同时取款

threads = []

for _ in range(10):

t = threading.Thread(target=concurrent_withdraw)

threads.append(t)

t.start()

for t in threads:

t.join()

print(f"最终余额: {account.balance}") # 预期为0,实际通常大于0

这种数据不一致就是典型的竞争条件导致的结果。

1.3 Python的threading.Lock

Python标准库提供了简单易用的锁实现:

import threading

class SafeAccount:

def __init__(self, balance):

self.balance = balance

self.lock = threading.Lock()

def withdraw(self, amount):

with self.lock: # 自动获取和释放锁

if amount <= self.balance:

time.sleep(0.001)

self.balance -= amount

return True

return False

使用with语句可以确保锁的正确释放,即使在临界区代码抛出异常的情况下。

第二部分:高级锁机制

2.1 可重入锁(RLock)

普通锁在同一个线程中不可重入,会导致死锁:

lock = threading.Lock()

def recursive_func(count):

with lock:

if count > 0:

recursive_func(count-1) # 再次尝试获取锁,导致死锁

# 使用RLock解决

rlock = threading.RLock()

def safe_recursive(count):

with rlock: # 同一线程可多次获取

if count > 0:

safe_recursive(count-1)

2.2 条件变量(Condition)

条件变量用于线程间的复杂协调:

class TaskQueue:

def __init__(self, max_size):

self.tasks = []

self.max_size = max_size

self.cond = threading.Condition()

def add_task(self, task):

with self.cond:

# 等待队列有空位

while len(self.tasks) >= self.max_size:

self.cond.wait()

self.tasks.append(task)

self.cond.notify() # 通知消费者

def get_task(self):

with self.cond:

# 等待任务可用

while len(self.tasks) == 0:

self.cond.wait()

task = self.tasks.pop(0)

self.cond.notify() # 通知生产者

return task

2.3 信号量(Semaphore)

信号量用于控制对有限资源的访问:

class ConnectionPool:

def __init__(self, max_connections):

self.pool = []

self.sem = threading.Semaphore(max_connections)

def get_connection(self):

self.sem.acquire() # 减少可用资源计数

# 实际实现中会返回或创建连接

return "connection"

def release_connection(self, conn):

# 返回连接池

self.sem.release() # 增加可用资源计数

第三部分:锁的内部实现原理

3.1 Python锁的源码解析

Python的锁实现基于底层操作系统的同步原语。在Unix系统上,主要使用pthread mutex;在Windows上使用CRITICAL_SECTION。以下是简化版的Lock实现原理:

class PyLock:

def __init__(self):

self._lock = 0 # 0表示未锁定,1表示已锁定

self.waiters = [] # 等待队列

def acquire(self, blocking=True):

"""获取锁的核心逻辑"""

if not blocking and self._lock:

return False

while True:

# 原子操作检查并设置锁状态

if self._compare_and_swap(0, 1):

return True

if not blocking:

return False

# 将当前线程加入等待队列

self._add_waiter()

# 挂起线程,等待唤醒

def release(self):

"""释放锁的核心逻辑"""

self._lock = 0

# 唤醒一个等待线程

if self.waiters:

waiter = self.waiters.pop(0)

self._wake_waiter(waiter)

def _compare_and_swap(self, expected, new):

"""原子操作:比较并交换"""

# 实际使用底层原子指令实现

if self._lock == expected:

self._lock = new

return True

return False

3.2 全局解释器锁(GIL)的影响

GIL是CPython解释器中的全局锁,它确保任何时候只有一个线程执行Python字节码。这影响了多线程程序的性能特性:

| 场景 | GIL影响 | 建议方案 |

|---|---|---|

| CPU密集型任务 | 多线程无法利用多核 | 使用多进程 |

| I/O密集型任务 | 阻塞I/O操作会释放GIL | 多线程有效 |

| C扩展操作 | 可显式释放GIL | 使用NumPy等优化库 |

# 演示GIL释放场景

import time

def cpu_bound():

# 计算密集型任务,受GIL限制

sum = 0

for i in range(10**7):

sum += i

def io_bound():

# I/O操作会释放GIL

time.sleep(1)

第四部分:死锁分析与预防

4.1 死锁的四个必要条件

-

互斥:资源不能共享

-

持有并等待:线程持有资源同时请求新资源

-

不可剥夺:资源只能由持有者释放

-

循环等待:线程间形成等待环路

4.2 常见死锁场景与解决方案

场景1:嵌套锁顺序不一致

lockA = threading.Lock()

lockB = threading.Lock()

# 线程1

with lockA:

with lockB:

# 操作资源

# 线程2

with lockB: # 与线程1顺序相反

with lockA:

# 操作资源

解决方案:固定锁的获取顺序

场景2:未释放锁的异常

lock = threading.Lock()

def risky_operation():

lock.acquire()

try:

# 可能抛出异常的操作

raise ValueError("意外错误")

finally:

lock.release() # 必须确保释放

解决方案:使用with语句或try-finally

4.3 死锁检测与恢复

实现简单的死锁检测器:

class DeadlockDetector:

def __init__(self):

self.lock_graph = defaultdict(set)

self.detection_lock = threading.Lock()

def register_acquire(self, thread, lock):

with self.detection_lock:

# 添加边:线程 -> 锁

self.lock_graph[thread].add(lock)

# 检查是否有循环

if self._has_cycle(thread):

self._handle_deadlock(thread)

def register_release(self, thread, lock):

with self.detection_lock:

if lock in self.lock_graph[thread]:

self.lock_graph[thread].remove(lock)

def _has_cycle(self, start):

"""使用DFS检测循环"""

visited = set()

stack = [start]

while stack:

node = stack.pop()

if node in visited:

return True

visited.add(node)

stack.extend(self.lock_graph[node])

return False

def _handle_deadlock(self, thread):

# 实际应用中可能记录日志、中断线程等

print(f"检测到死锁! 线程: {thread.name}")

# 中断当前线程(谨慎使用)

# threading.current_thread().interrupt()

第五部分:锁的性能优化

5.1 锁性能分析工具

使用cProfile分析锁竞争:

import cProfile

import threading

lock = threading.Lock()

shared_data = 0

def worker():

global shared_data

for _ in range(100000):

with lock:

shared_data += 1

# 性能分析

profiler = cProfile.Profile()

profiler.enable()

threads = [threading.Thread(target=worker) for _ in range(4)]

for t in threads:

t.start()

for t in threads:

t.join()

profiler.disable()

profiler.print_stats(sort='cumtime')

5.2 降低锁竞争策略

策略1:减小临界区范围

# 不推荐:整个函数在锁内

def process_data(data):

with lock:

result = complex_computation(data)

store_to_database(result)

# 推荐:仅保护共享资源

def optimized_process(data):

result = complex_computation(data) # 在锁外执行耗时计算

with lock:

store_to_database(result) # 仅保护数据库访问

策略2:使用读写锁

import threading

class ReadWriteLock:

"""读写锁实现"""

def __init__(self):

self._read_ready = threading.Condition(threading.Lock())

self._readers = 0

def acquire_read(self):

with self._read_ready:

self._readers += 1

def release_read(self):

with self._read_ready:

self._readers -= 1

if self._readers == 0:

self._read_ready.notify_all()

def acquire_write(self):

self._read_ready.acquire()

while self._readers > 0:

self._read_ready.wait()

def release_write(self):

self._read_ready.release()

策略3:无锁数据结构

import threading

class LockFreeCounter:

"""基于原子操作的无锁计数器"""

def __init__(self):

self._value = threading._allocate_lock()

self.value = 0

def increment(self):

while True:

# 使用CAS(比较并交换)原子操作

current = self.value

new = current + 1

if self._compare_and_swap(current, new):

return new

def _compare_and_swap(self, expected, new):

# 模拟原子操作(实际使用CPU指令)

if self.value == expected:

self.value = new

return True

return False

结语:锁的艺术与哲学

互斥锁作为并发编程的基础工具,其使用既是一门技术,也是一门艺术。在Python并发编程中,我们需要:

-

理解场景:区分CPU密集型和I/O密集型任务

-

合理选择:根据需求选择锁、队列、Actor等并发模型

-

最小化竞争:减小临界区、使用读写锁、避免不必要的同步

-

预防死锁:固定锁顺序、使用超时、避免嵌套锁

-

优先高级抽象:使用Queue、线程池等高级工具减少直接锁操作

"并发不是并行,但并行需要并发。锁不是目的,安全才是根本。" —— 并发编程箴言

随着Python生态的发展,asyncio、multiprocessing等模块提供了更多并发选择。但无论技术如何演进,理解互斥锁的原理和应用,始终是构建可靠并发系统的基石。

328

328

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?