前言

本文主要CNN系列论文解读——VGG的简介、模型结构、参数计算、网络结构的代码实现等。

1.简介

VGGNet 是牛津大学计算机视觉组(Visual Geometry Group)和谷歌 DeepMind 一起研究出来的深度卷积神经网络,因而冠名为 VGG。VGG是一种被广泛使用的卷积神经网络结构,其在在2014年的 ImageNet 大规模视觉识别挑战(ILSVRC -2014)中获得了亚军,不是VGG不够强,而是对手太强,因为当年获得冠军的是GoogLeNet。

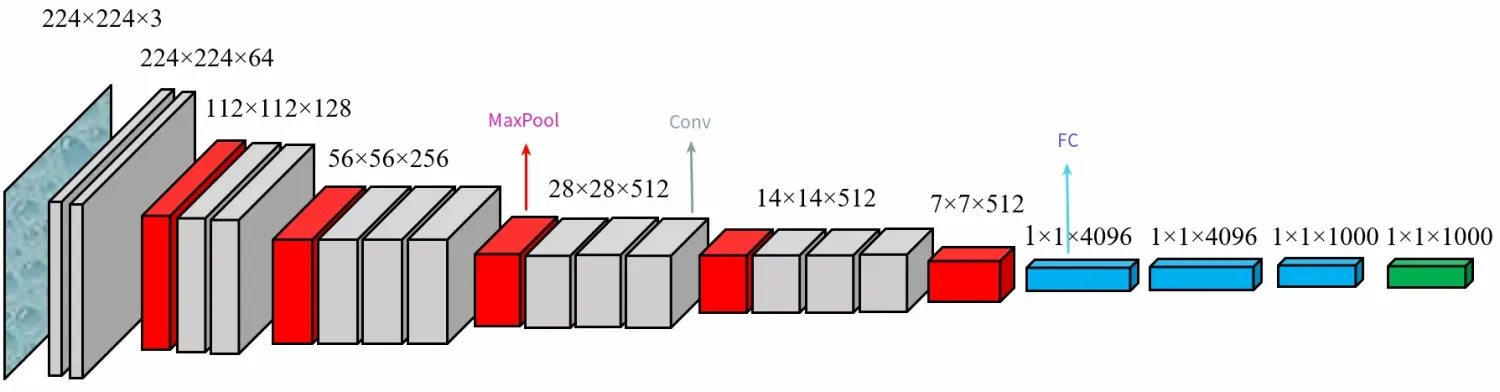

通常人们说的VGG是指VGG-16(13层卷积层+ 3层全连接层)。虽然其屈居亚军,但是由于其规律的设计、简洁可堆叠的卷积块,且在其他数据集上都有着很好的表现,从而被人们广泛使用,从这点上还是超过了GoogLenet。VGG和之前的AlexNet相比,深度更深,参数更多(1.38亿),效果和可移植性更好。

2.Abstract

Abstract

In this work we investigate the effect of the convolutional network depth on itsa

订阅专栏 解锁全文

订阅专栏 解锁全文

1632

1632

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?