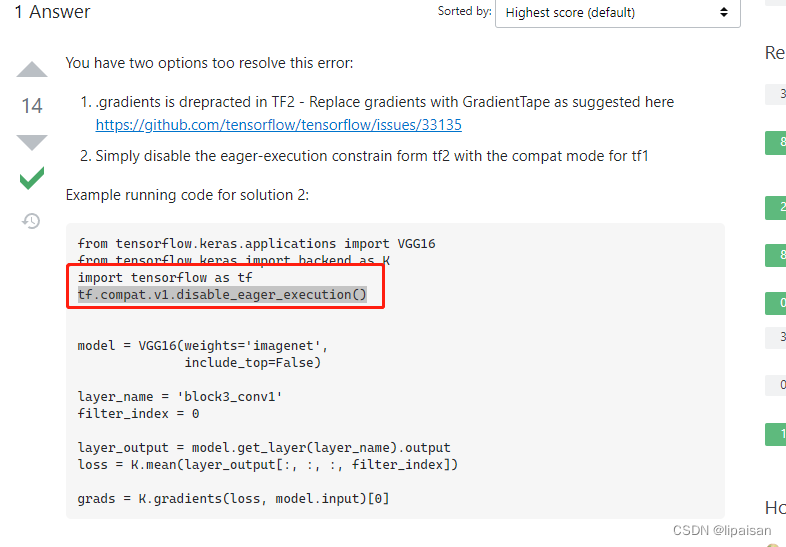

经过搜索,实践,最优解:

主要是加这两行代码:

import tensorflow as tf

tf.compat.v1.disable_eager_execution()

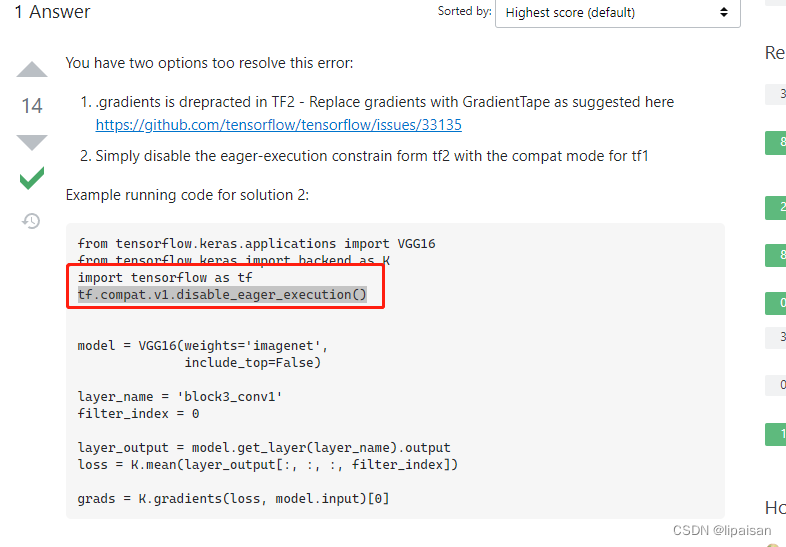

经过搜索,实践,最优解:

主要是加这两行代码:

import tensorflow as tf

tf.compat.v1.disable_eager_execution()

3700

3700

477

477

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?