DeepSeek热度还在继续,在大家还在等待R2的发布时,DeepSeek官方依然在服务器繁忙和蹦了之间左右徘徊。

就当各互联网大厂还为DeepSeek API 在推理速度是30还是40Tokens/s秒争的面红耳赤之时,一个低调的平台SophNet,直接甩出王炸速度,推出DeepSeek V3极速版,推理速度直接怼到150Tokens/s,甩到各互联网大厂尾灯都看不见。

SophNet平台DeepSeek推理速度超100TPS

我去体验了一下,确实速度快到惊人,基本日常的问答回复,看不到吐字速度,瞬间窜出回答。

现在教大家如何接入天花板级别的DeepSeek API

1、首先打开SophNet网址,这里注意下,要点击这个链接,是CSDN和SophNet合作的邀请链接,注册了就能送20元,并且后续如果充值还能享受CSDN的88折专属优惠。

2、点击控制台,创建新项目。

3、点击刚刚创建的项目详情。

4、点击添加新服务。

5、在服务详情页里,还需要创建个API key 把他复制下来

6、选择ChatCompletion,在使用模型这里,注意选择DeepSeek-V3-Fast。点击确认

6、进入刚刚创建的项目详情后,就可以看到API调用示例了,注意画框的接口地址和模型参数,模型参数这里是:DeepSeek-V3-Fast

以上,我们就得到了一个极速版的API调用示例和APIkey

- 模型名称:DeepSeek-V3-Fast

- API key:就是刚刚创建的那个一长串key

现在我们以Dify为例,把他配置进去

1、在Dify中右上角点击用户名 -> 设置

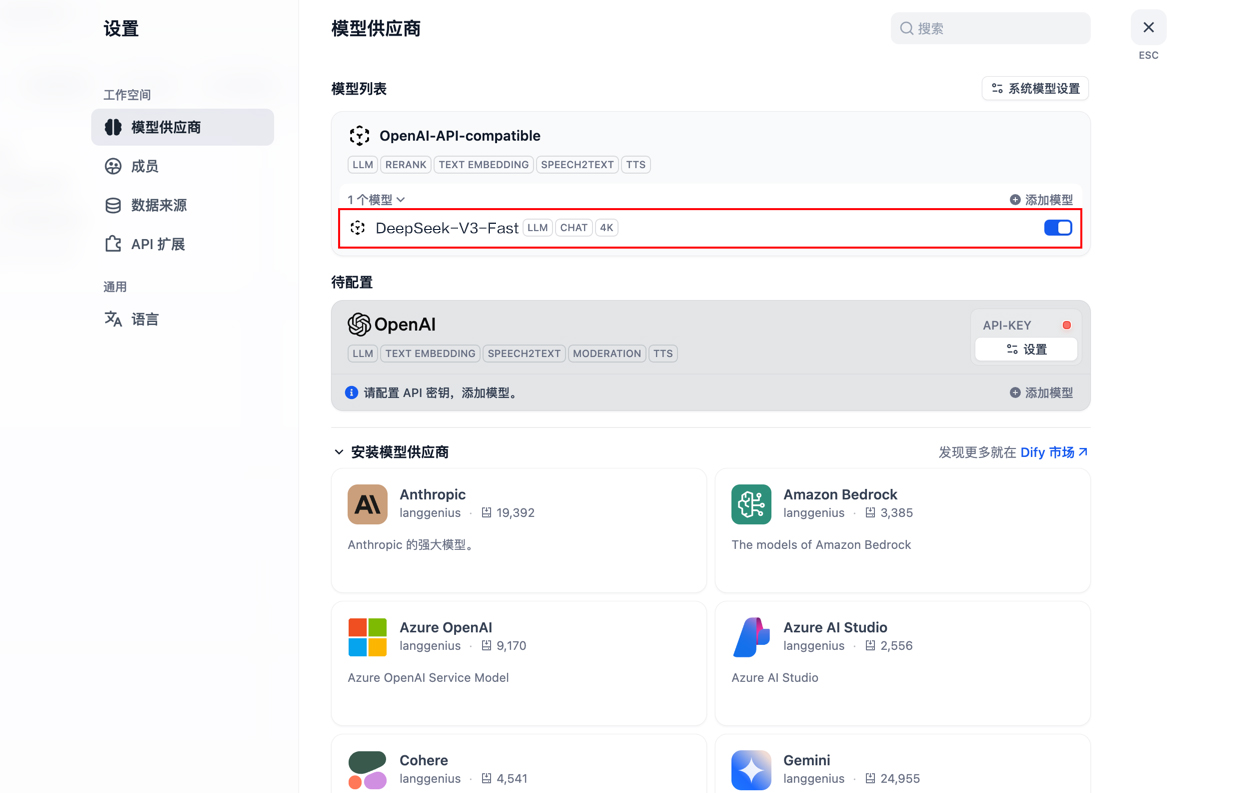

2、在模型供应商中安装支持OpenAI API的模型供应商 以安装 OpenAI-API-compatible 为例

3、点击添加模型

模型类型选择 LLM

模型名称与模型显示名称填入 DeepSeek-V3-Fast

在API KEY文本框中输入你的API Key

API endpoint URL文本框中填入https://www.sophnet.com/api/open-apis

点击保存

然后点击显示n个模型,查看已添加的模型状态

至此,就可以畅快的使用极速版DeepSeek了。

最后提醒下哈,一定要通过CSDN和SophNet合作的邀请链接注册,不仅能送20元,后续如果充值还能享受CSDN的88折专属优惠。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?