目录

2. 图神经网络当前的落地场景?图神经网络在实际落地中还需要考虑哪些因素?

3. 图神经网络可能应用于哪些交叉学科(如生物医学工程、材料基因组等)?

4. 当下,图神经网络有哪些问题亟待解决,哪些研究方向值得关注?

1. 图神经网络的发展当前面临哪些问题?哪些方面有望在近几年取得突破?

2. 如何基于图神经网络做认知推理?如何看待图神经网络与知识图谱的结合?

3. 如何看待无监督/自监督图神经网络?未来的发展方向及面临的主要困难是?

4. 图神经网络在可解释性方面有什么优势与不足,还能如何增强?

6. 怎么有效的处理大规模图,怎么有效的处理动态图(time-varying graphs)?

黄增峰 理论算法研究 Embedding Methods From Graph Partition Algorithms and Their Connection to GNNs

陈思衡 Bridging graph signal processing and graph neural networks

1、简介

2、嘉宾

问题讨论1

Panel嘉宾:

黄增峰 (复旦大学)、王啸 (北京邮电大学)、何向南 (中国科学技术大学)、崔鹏 (清华大学)、Jian Tang (Mila (Quebec AI institute) and HEC Montreal)

Panel议题:

1. 如何看待当前图上的自监督学习进展?未来前景如何?

2. 图神经网络当前的落地场景?图神经网络在实际落地中还需要考虑哪些因素?

3. 图神经网络可能应用于哪些交叉学科(如生物医学工程、材料基因组等)?

4. 当下,图神经网络有哪些问题亟待解决,哪些研究方向值得关注?

5. 对想研究图神经网络的新入门同学有何建议?

6. 能否展望一下图神经网络在未来几年的发展趋势?

1. 如何看待当前图上的自监督学习进展?未来前景如何?

何老师

自监督有意义,属于一种数据增强问题。可以针对数据和任务的特点,设计自监督

崔老师

属于无监督的一种,之前是找cluster,NE本身就属于自监督,借鉴NE在学习节点表示上如何使用图本身拓扑结构上出发

唐老师

对比学习引入,不能直接使用,比如生物图,修改一个原子或者边,不改变图结构不适应

王老师

很看好,在性能上有优势,半监督上发展到现在有一个很高的门槛。目前沿用对比学习范式解决-正负样本选择/对比,正负样本在选的时候通常扰动结构和特征,通过对比学习来获得最好的embedding,但是这种embedding到底刻画了什么样的结构信息,现在还是不清晰明确的。另外,图自监督在分类上效果较好,但是在图分类上貌似不是很好,是不是某种程度上暗含着现有图上的对比学习只刻画了适合节点分类的某种信息,而某些信息缺失被我们忽略掉了。比如做异常节点检测,现有图自监督是不是做的不是很好。因此,有很多需要值得思考的地方。

黄老师

使用图同构这个性质来解决

2. 图神经网络当前的落地场景?图神经网络在实际落地中还需要考虑哪些因素?

何老师

推荐,金融,搜索,蛋白质分子

图要怎么构建,尤其结构

先验知识怎么和图结合是个很值得研究的

计算效率不是瓶颈

崔老师

只要能表示成图形式的数据,都能用GNN

探索GCN解决问题的边界:GCN到底能解决什么样的问题,不能解决什么样的问题。

比较强调拓扑结构的问题上,GCN表示能力有限!

3. 图神经网络可能应用于哪些交叉学科(如生物医学工程、材料基因组等)?

唐老师

生物:有机分子结构,label少,聚焦于自监督学习

材料:无机分子结构

王老师

落地需要考虑异质性

大规模数据采样!:实际落地上一般用的一层

图可以叠加很多层吗?

- 图叠加很多层会出现过平滑,在思考这个问题的时候的时候,应该和具体任务结合来考虑。(王)

- CV上是为了提取更高层语义;GNN上这里是聚合更多邻居信息(王)

- GNN本身就是聚合local邻居信息,本质上属于流型学习,因此不需要聚合更多层(崔)

样本间关系怎么学习?

- 参考图结构学习:在比较noisy下学习一个比较好的图表示

图上的高频和低频

- 高频:边缘地区---变化剧烈的信息(差异性信息),如邻居结构不同

- 低频:非边缘地区,如面部变化平缓---变化平缓的信息(共性信息)

图的构建这个特征工程

黄老师

药分子生成

4. 当下,图神经网络有哪些问题亟待解决,哪些研究方向值得关注?

崔老师

理论上+表征能力上

归纳偏置能力学习:目前特征为主,拓扑为辅。要想这个归纳偏置一致起正向作用的话,该如何设计?(图上噪音学习)

唐老师

理论上的突破:逻辑推理

黄老师

图生成

分布式学习(分割图)

5. 对想研究图神经网络的新入门同学有何建议?

何老师

执行力

基础

- 书籍有个大局观

- 线性代数

- 追最新论文

崔老师

培养研究taste,一定要选择一个难的问题,因为这样的问题好解决,点子也多。否则简单的问题大家都可以容易发现,自己的研究就容易中途断...

唐老师

基础:经典论文-推公式

找到自己喜欢的点:聚焦某个应用领域+其他机器学习上的技术

王老师

执行力很重要,目前呈爆发状态,有不错的想法,赶紧和老师讨论并实现

刷arxiv上图相关论文

机器学习和图信号基础学习:很多都是从这里受到启发

黄老师

书籍通读,再看具体论文动手(现有很多框架)

问题讨论2

Panel嘉宾:

唐杰 (清华大学)、石川 (北京邮电大学)、廖仁杰 (University of Toronto)、陈思衡 (Mitsubishi Electric Research Laboratories)、胡玮 (北京大学)

Panel议题:

1. 图神经网络的发展当前面临哪些问题?哪些方面有望在近几年取得突破?

2. 如何基于图神经网络做认知推理?如何看待图神经网络与知识图谱的结合?

3. 如何看待无监督/自监督图神经网络?未来的发展方向及面临的主要困难是?

4. 图神经网络在可解释性方面有什么优势与不足,还能如何增强?

5. 如何在图表征学习中更好的构建与运用图结构?

6. 怎么有效的处理大规模图,怎么有效的处理动态图(time-varying graphs)?

1. 图神经网络的发展当前面临哪些问题?哪些方面有望在近几年取得突破?

唐杰

半监督(标注不准确且标签少)-超大规模自监督和预训练

深层解决过平滑问题-random

对抗鲁棒性,有扰动性能变差-random

石川

学习机理理解不足,目前基于启发式的学习

可解释性不足-因果推断

同质化-异构图

idea+速度,现在爆发式。及早发paper

廖仁杰

图生成模型,既与监督相关,也与无监督相关

陈思衡

网络性质相差很大,无法建立一个统一的卷积框架,可能是定制型的模型

2. 如何基于图神经网络做认知推理?如何看待图神经网络与知识图谱的结合?

唐杰

认知推理是个博弈的学习过程,双系统结合的学习可能好些

石川

KG和GNN是两个方向,采样技术方法也是不一样的,分析手段不一样的,方法可以相互借鉴

廖仁杰

memory

3. 如何看待无监督/自监督图神经网络?未来的发展方向及面临的主要困难是?

石川

怎么找到有效的自监督信息?

如何设计有效的学习方法?

采样大量的正负样例vs效率

廖仁杰

子图学习,对生物学很重要

陈思衡

从task出发设计比较合理

4. 图神经网络在可解释性方面有什么优势与不足,还能如何增强?

唐杰

有一定的能力

基因图数据,是个黑盒子且深层浅

未来抗攻击性是个突破口

石川

注意力值具有一定的可解释性

消息传递机制,也具有一定可解释性

但是不足

与知识图谱结合,语义信息/逻辑规则

5. 如何在图表征学习中更好的构建与运用图结构?

唐杰

浅层:如一层就是矩阵分解

深层:可能本质也是矩阵分解

可能大家都没用好,本质在矩阵上做了一些变换操作

之后可以将卷积和权重拆开学习,不同网络使用不同操作

想清楚本质是什么,然后再优化

石川

研究角度:本质-再设计网络

从不同角度建立统一优化框架,指导设计新的网络结构

应用角度:图是抽象出来的一种知识,图如果构建的更好的话,可能效果会更好

廖仁杰

图去噪

图池化

陈思衡

性能和效率在大图上的平衡问题

6. 怎么有效的处理大规模图,怎么有效的处理动态图(time-varying graphs)?

唐杰

simple case-图数据-动态-大规模

动态图是一个很重要的问题,做一些smoothing操作,但是也有问题。

未来走向预训练和自监督,但是超大规模数据计算效率问题急需解决(也不需要将整个图数据利用,使用local graph图比较合适)

石川

在工业界很现实的问题,同时数据难以获取

聚合局部图信息/图压缩/增量式学习

廖仁杰

local子图,另外还需要做好balance(有的子图大,有的小),全局信息存到全局memory中方便子图访问

崔鹏6问《图神经网络年度进展概述》

小结

正文

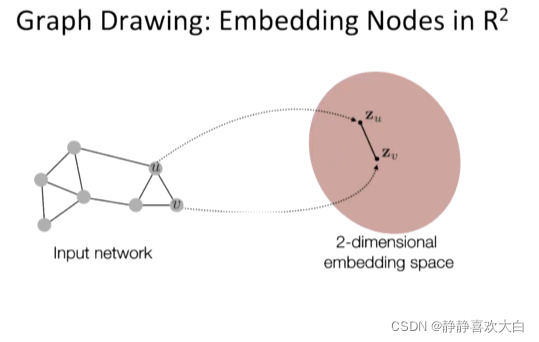

图用来描述节点和节点间关系的一种很general的一种表达方式。如果节点和节点间有关系的话,我们倾向于使用图来表示

因为平时只关注实体,忽略了实体间的关系。下面两个例子均需要图这种形式的数据来辅助解决问题

可学习性差

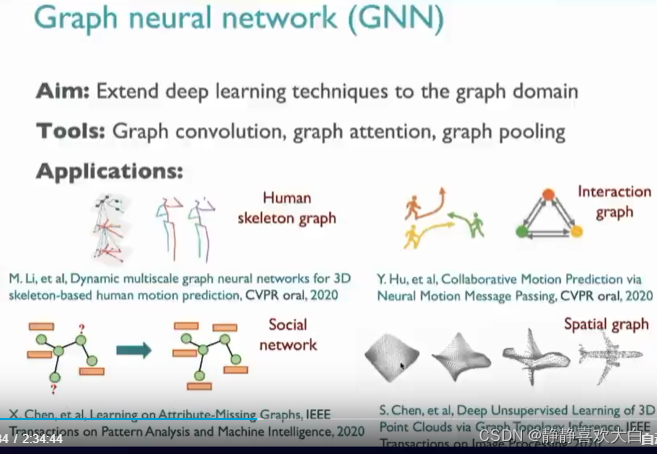

GNN学习机制出现 ,当前节点状态依赖于自身特征+邻居特征+连接强度

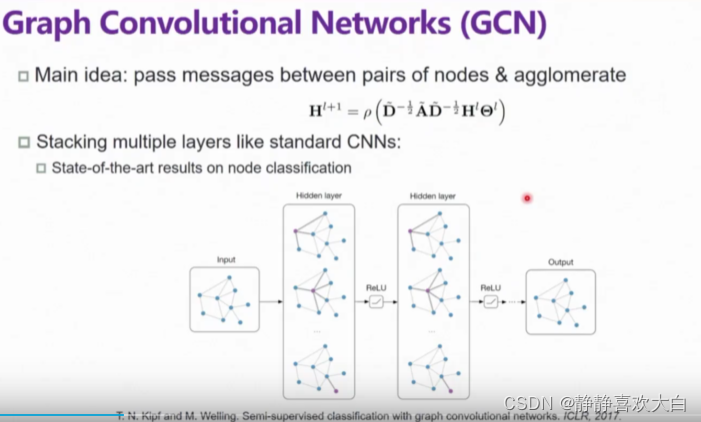

GCN出现 :可以理解为将DAD结构数据映射到H特征上,产生另一个特征空间

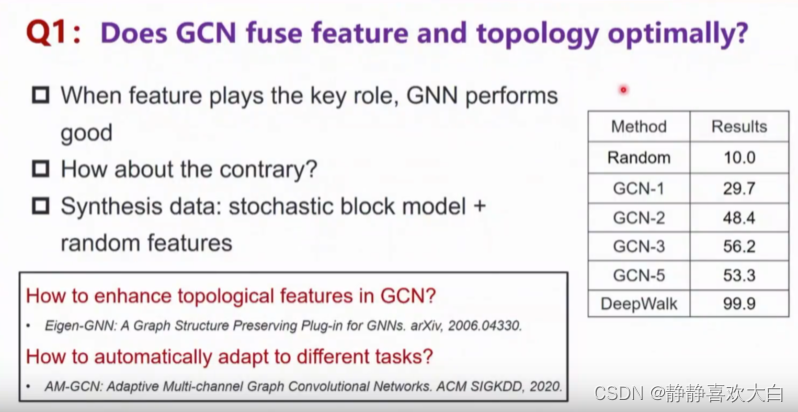

GCN可以将特征和拓扑很好的使用吗?

feature起关键作用,结构辅助时,效果很好;反之效果差,说明了GCN在拓扑导向的任务上表现不是很好

GCN为什么不能很好的保留结构信息?

满足置换不变性(有优缺点)

优点:同构;泛化

缺点:结构同,但是label不同,GCN学不了;2跳信息的结构也不能很好的学习到

GCN真的是deep model吗

GCN真的需要deep吗?

GCN能力需要使用大数据集来验证

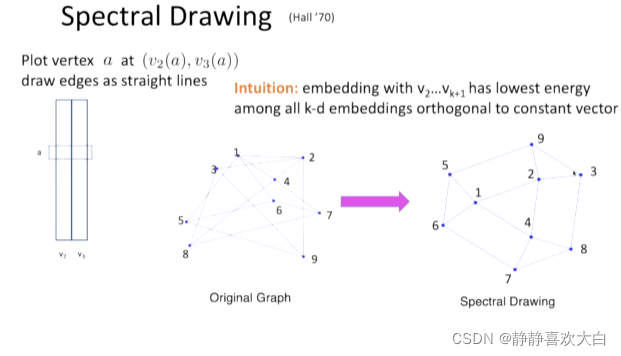

黄增峰 理论算法研究 Embedding Methods From Graph Partition Algorithms and Their Connection to GNNs

正文

非对角线上的值都是-1,同时也会发现每行值的和为0

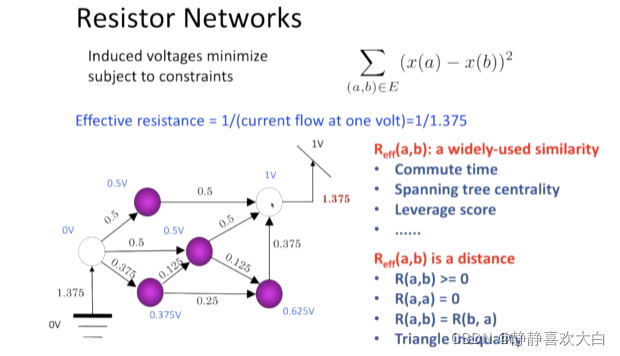

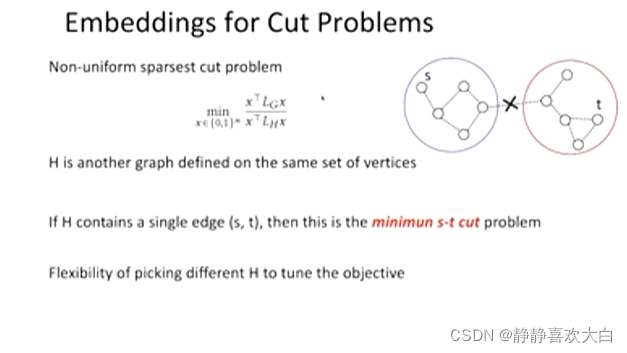

工作1 -偏数学理论上

划分成2块

工作2-物理电压问题上的半监督学习

工作三-图分割:使用对比损失学习整图表示,只使用负样本

多层线性模型

因为模型简单,收敛很快

大图结果也不错

廖仁杰 Deep Learning on Graphs

小结

正文

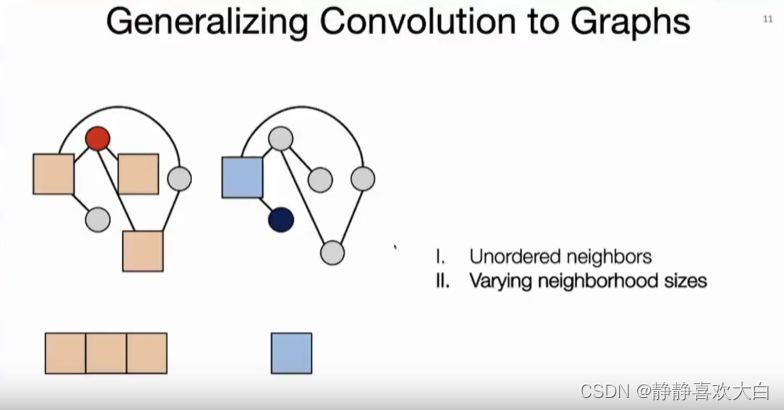

CNN中卷积

CNN中的池化

CNN架构:卷积模块+池化模块+其他非线性模块

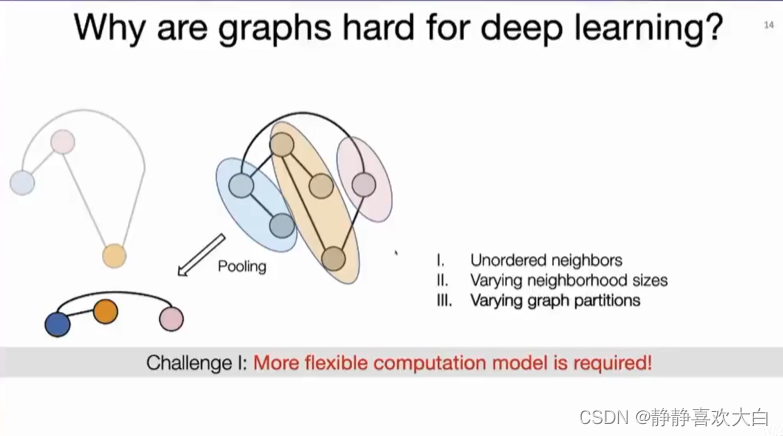

图上需要考虑的点

假设3*3卷积核大小,由于邻域无序,导致有多种可能,但是在图像上很容易确定(有上下左右概念)

邻域大小不同:红色点有三个邻居,蓝色有1个邻居,如果使用3*3卷积核,在红色节点上可以做,但是蓝色不可以

多种切分:将2个节点变成1个节点的话,有2种划分,发现这2种结构相差很大。导致无法使用池化

反向传播计算怎么解决?

经典的CNN最重要的一点就是可以进行反向传播来对模型进行训练,但是GNN里面是离散的点,不可微

GNN消息传递(动画做的及其简洁,可以直接看B站视频)

陈思衡 Bridging graph signal processing and graph neural networks

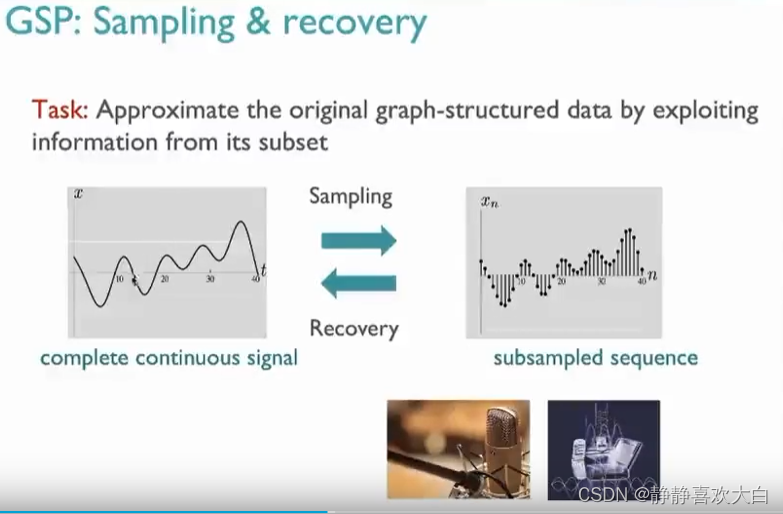

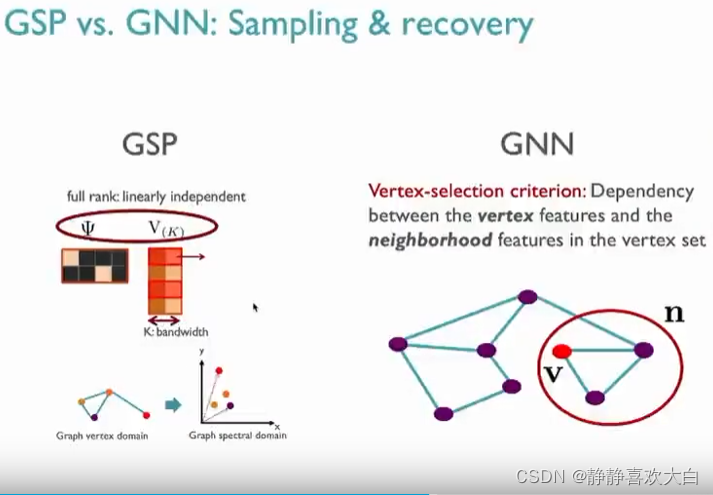

小结

从图信号角度解决问题

正文

3、参考

20210317-06 总第231期 深度学习中的拓扑美学:图神经网络

20200805-VALSE 2020 APR-崔鹏《图神经网络年度进展概述》

20210317【深度学习中的拓扑美学:图神经网络】黄增峰 Embedding Methods From Graph Partition Algorith...

本文综述了图神经网络的最新进展,包括自监督学习、落地场景、交叉学科应用、问题与解决方案,以及对新手的建议。专家们讨论了图神经网络面临的挑战、发展方向和可解释性增强的方法,还提及了处理大规模图和动态图的策略。

本文综述了图神经网络的最新进展,包括自监督学习、落地场景、交叉学科应用、问题与解决方案,以及对新手的建议。专家们讨论了图神经网络面临的挑战、发展方向和可解释性增强的方法,还提及了处理大规模图和动态图的策略。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?