第一步安装Scrapy

- pip install pywin32

- pip install Twisted 安装在scrapy前面,否则报错

- pip install scrapy

建立项目

-

第一步,在pycharm中选择一个文件夹,右击,出现一个 open in Terminal,控制台位置就出现了所在文件夹,类似的还有一个方法,在cmd中进入所在文件夹

-

第二步,在cmd输入

scrapy startproject 工程项目会自动生成一个框架会有一系列文件生成 -

-

第三步,先简单做个例子,

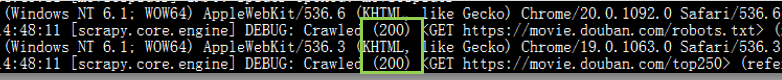

scrapy genspider 爬虫脚本名称 访问网站的域名可以使用scrapy shell 网站Url地址测试网址是否可以爬虫,出现200即可;

- 第四步,修改settings文件,有四个地方;①

ROBOTSTXT_OBEY = False (大概在20行左右)用于去掉限制②DOWNLOAD_DELAY = 3(28行左右,注释需打开)采集延迟③SPIDER_MIDDLEWARES = { 'dataspider.middlewares.DataspiderSpiderMiddleware': 543 }(47行)④DOWNLOADER_MIDDLEWARES = { 'dataspider.middlewares.DataspiderDownloaderMiddleware': 543, }(53行)⑤ITEM_PIPELINES = { 'dataspider.pipelines.DataspiderPipeline': 300, }(65行)

从网页获取数据,一种是HTML页面,一种是json形式

爬取百度(HTML页面)

爬取百度之前,添加一个探测头文件(搞定反爬虫),并进行配置

比较重要的是,那些该怎么选择,详情见文件(选择标签的使用);

爬一个json

爬完第一页,继续爬第二页

爬完第一页,顺便爬了页面内链接页面

完事了再拿管道输出,别自己print了

没有下一页的时候就停止采集

正则化处理掉HTML标签或者工资等字眼需要统一单位等

(没来得及完善有机会重写)

2405

2405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?