一、hive安装前提

1. 安装好一台纯净linux虚拟机

2. 安装好hadoop,用于练习一台就够,不需要集群

3. 安装好mysql

二、linux虚拟机配置

1.配置静态地址

vi /etc/sysconfig/network-scripts/ifcfg-ens33

2. 修改主机名

vi /etc/hostname

3.修改hosts

vi /etc/hosts

三、使用rpm安装mysql

1. 查看系统中是否有数据库

1.rpm -qa | grep mysql --查看是否存在mysql

2.rpm -qa | grep mariadb --查看存在mariadb

2.如果存在进行卸载

rpm -e --nodeps 软件名

3.下载wget,铜鼓wget下载mysql的repo源

yum install -y wget --下载wget

wget http://repo.mysql.com/mysql-community-release-el7-5.noarch.rpm --下载mysql的repo数据源,选择好目录下载。

4.安装mysql-community-release-el7-5.noarch.rpm包

rpm -ivh mysql-community-release-el7-5.noarch.rpm

5.安装mysql

yum install mysql-server -y

6.对root用户进行授权,才能正常登录mysql

chown -R root:root /var/lib/mysql

7.重新启动MySQL服务

service mysqld restart

8.登录mysql,设置密码

mysql > use mysql;

mysql > update user set password=password('ok') where user='root';

9.可以为root添加远程连接的能力

GRANT ALL PRIVILEGES ON *.* TO root@"%" IDENTIFIED BY "ok";

10.推出mysql,重新用用户密码登录

mysql -uroot -pok

11.查询编码格式,并修改成utf8

show variables like "%char%";

- mysql默认编码格式为:latin1

- 修改编码格式:

vi /etc/my.cnf

[client]

default-character-set = utf8

[mysqld]

skip-grant-tables

character_set_server = utf8

collation_server = utf8_general_ci

修改完再查询结果为

四、mysql连接sqlyg

点击连接之后

五、安装hive

1.hive安装包

链接:hive安装

提取码:r093

2. 将安装包放入linux系统相应位置

3. 解压安装包,并改名。

tar -zxvf hive-1.1.0-cdh5.14.2.tar.gz --解压hive

mv hive-1.1.0-cdh5.14.2 hive110 --改名

4.进入配置文件,创建hive-site.xml文件

cd hive110/conf ---进入配置文件目录

vi hive-site.xml ---创建hive-site.xml文件

文件内容:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>hdfs://mycluster/hive/warehouse</value>

<description>管理表存储的位置,可以是linux中的目录,也可以是相对于fs.default.name有关的目录</description>

</property>

<property>

<name>hive.metastore.local</name>

<value>true</value>

</property>

<!-- 指定hive元数据存储的MySQL地址 -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://dag01:3306/hive?createDatabaseIfNotExist=true&useSSL=false</value>

</property>

<!-- 元数据存储数据库的驱动 -->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- 元数据存储数据库的用户名 -->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- 元数据存储数据库的密码,(注:这里是mysql自己root用户的密码) -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>ok</value>

</property>

<property>

<name>hive.server2.authentication</name>

<value>NONE</value>

</property>

<property>

<name>hive.server2.thrift.client.user</name>

<value>root</value>

</property>

<property>

<name>hive.server2.thrift.client.password</name>

<value>ok</value>

</property>

</configuration>

5.配置环境变量

vi /etc/profile

代码内容:

export JAVA_HOME=/opt/jdk1.8.0_221

export JRE_HOME=/opt/jdk1.8.0_221/jre

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/root/bin

export HADOOP_HOME=/opt/hadoop

export HIVE_HOME=/opt/soft/hive110

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:$HIVE_HOME/bin

里面有hadoop和Java的环境变量,自己可以根据自己情况做改变。

6.新建hive-env.sh文件: vi hive-env.sh,添加如下内容

export HADOOP_HOME=/opt/hadoop

export HIVE_HOME=/opt/hive110

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HIVE_AUX_JARS_PATH=/opt/hive110/lib

export JAVA_HOME=/opt/jdk1.8.0_221

export HIVE_CONF_DIR=/opt/soft/hive110/conf

7.修改hive-log4j.properties,配置hive的日志

1. 先改名:mv hive-log4j.properties.template hive-log4j.properties

2. 进入:vi hive-log4j.properties

3. 在20添加内容`hive.log.dir=/opt/soft/hive110/logs`

8.新建两个配置文件中指定的目录

mkdir /opt/soft/hive110/warehouse

mkdir /opt/soft/hive110/logs

9.将mysql-connector-java-5.1.48-bin.jar包拖到$HIVE_HOME/lib目录下

10.给hive文件赋权

chmod 777 /opt/hive

五、启动hive(需要先启动hdfs)

1.初始化mysql数据库

schematool -initSchema -dbType mysql

效果

连接mysql的sqlyg中会出现hive数据库

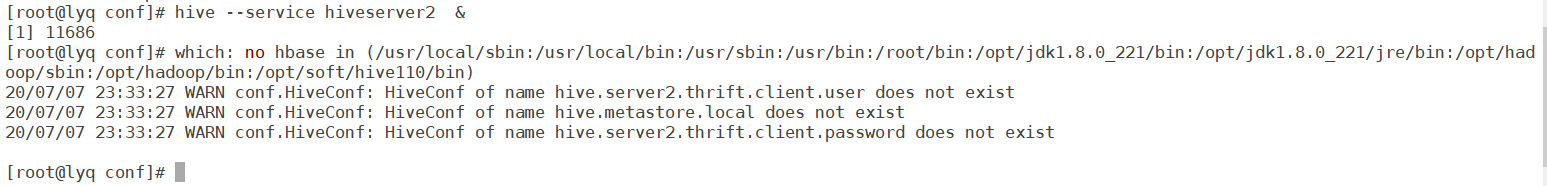

2.启动hive服务

hive --service hiveserver2 &

执行完不动,直接按回车就行。

3.启动hive

hive

4.启动beeline

beeline -u jdbc:hive2://192.168.222.160:10000

794

794

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?