Window Kafka 简单使用

文章目录

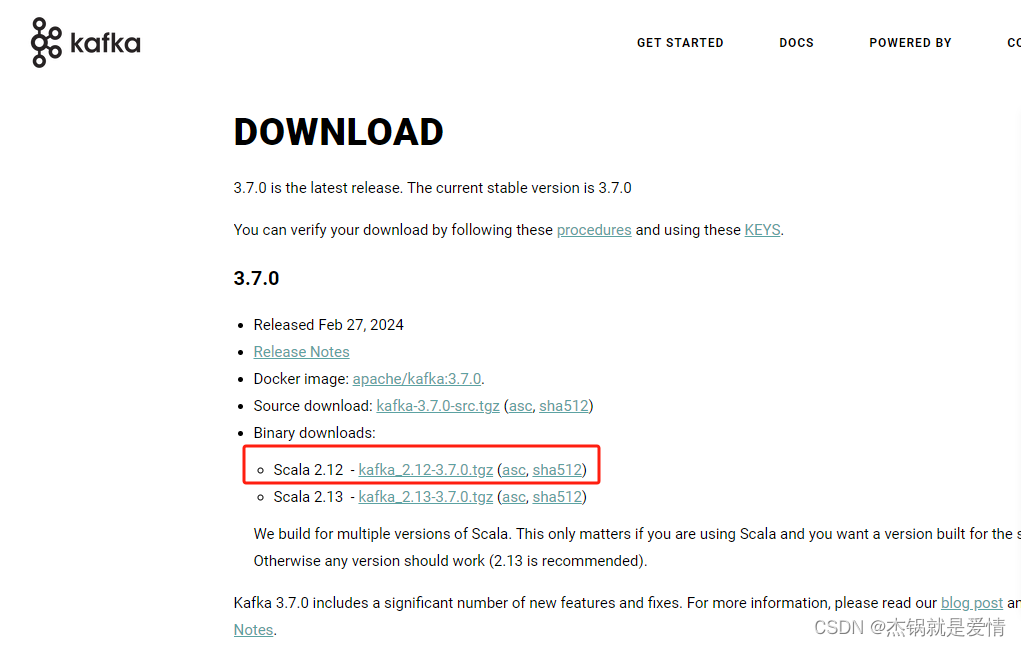

1.kafka下载

下载地址

下载二进制的,如图:

2、官网下载kafka【解压之后如图所示】

3、修改zookeeper、Kafka的配置文件

config文件夹下zookeeper.properties文件

dataDir=D:/zookeeper/data

config文件夹下server.properties文件

log.dirs=D:/kafka-logs

4、启动zookeeper

cd D:\kafka_2.12-3.7.0\bin\windows

在此目录下打开cmd,执行命令

zookeeper-server-start.bat ..\..\config\zookeeper.properties

5、启动kafka

cd D:\kafka_2.12-3.7.0\bin\windows

在此目录下打开cmd,执行命令

kafka-server-start.bat ..\..\config\server.properties

6、Confluent.Kafka在.Net中使用

生产者:

/// <summary>

/// 消息生产者

/// </summary>

public static void Producer()

{

var conf = new ProducerConfig {

BootstrapServers = "localhost:9092",

//CompressionType=CompressionType.Gzip//压缩方式

};

Action<DeliveryReport<string, string>> handler = r =>

{

if (!r.Error.IsError)

{

Console.WriteLine($"Delivered message to {r.TopicPartitionOffset}");

}

else

{

//发送邮件,记录错误消息

Console.WriteLine($"Delivery Error: {r.Error.Reason}");

}

};

using (var p = new ProducerBuilder<string, string>(conf).Build())

{

for (int i = 0; i < 5; ++i)

{

//批消息:消息集合

//虽然是单条数据发送 ,但是是批量发送的

//先放在内存中缓存起来,一起发送的

//磁盘IO:顺序读写(固态硬盘,机械硬盘寻址时间比较长)

var vin = $"LDP95E966NE02292{i}";

p.Produce("test", new Message<string , string> {Key= vin, Value = i.ToString() }, handler);

}

// wait for up to 10 seconds for any inflight messages to be delivered.

p.Flush(TimeSpan.FromSeconds(10));

}

}

消费者:

/// <summary>

/// 消费者

/// 从文件找到数据,读到内存,通过网络发给客户端

/// </summary>

public static void Consumer()

{

var conf = new ConsumerConfig

{

GroupId = "test-consumer-group",

BootstrapServers = "localhost:9092",

// Note: The AutoOffsetReset property determines the start offset in the event

// there are not yet any committed offsets for the consumer group for the

// topic/partitions of interest. By default, offsets are committed

// automatically, so in this example, consumption will only start from the

// earliest message in the topic 'my-topic' the first time you run the program.

AutoOffsetReset = AutoOffsetReset.Earliest,

EnableAutoCommit=true,//关闭自动提交位移

PartitionAssignmentStrategy=PartitionAssignmentStrategy.Range,//分区分配策略 轮询 、粘滞

};

using (var c = new ConsumerBuilder<Ignore, string>(conf).Build())

{

c.Subscribe("test");

CancellationTokenSource cts = new CancellationTokenSource();

Console.CancelKeyPress += (_, e) =>

{

e.Cancel = true; // prevent the process from terminating.

cts.Cancel();

};

try

{

while (true)

{

try

{

var cr = c.Consume(cts.Token);

Console.WriteLine($"Consumed message '{cr.Value}' at: '{cr.TopicPartitionOffset}'.");

}

catch (ConsumeException e)

{

Console.WriteLine($"Error occured: {e.Error.Reason}");

}

}

}

catch (OperationCanceledException)

{

// Ensure the consumer leaves the group cleanly and final offsets are committed.

c.Close();

}

}

}

7、基本命令

7.1 查看主题列表

kafka-topics.bat --list --bootstrap-server localhost:9092

7.2 创建主题

kafka-topics.bat --create --topic test0 --bootstrap-server localhost:9092

7.3 查看主题详细信息

kafka-topics.bat --describe --bootstrap-server localhost:9092 --topic test0

7.4 修改主题分区

kafka-topics.bat --bootstrap-server localhost:9092 --alter --topic test0 --partitions 2

7.5 插入数据到主题

kafka_2.12-3.7.0\bin\windows>kafka-console-producer.bat --broker-list localhost:9092 --topic test0

7.6 查看主题消费偏移量

kafka-consumer-groups.bat --bootstrap-server localhost:9092 --group test0Consumer --describe

7.6 重设主题消费偏移量

kafka-consumer-groups.bat --bootstrap-server localhost:9092 --group test0Consumer --topic test0 --execute --reset-offsets --to-offset 1

4515

4515

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?