本文为SIGAI 2018/8/22最优化算法总结的直播笔记。

目录

总结图片:

1、精确求解(公式求解)

一共分为三种:费马定理→拉格朗日乘数法→KKT条件

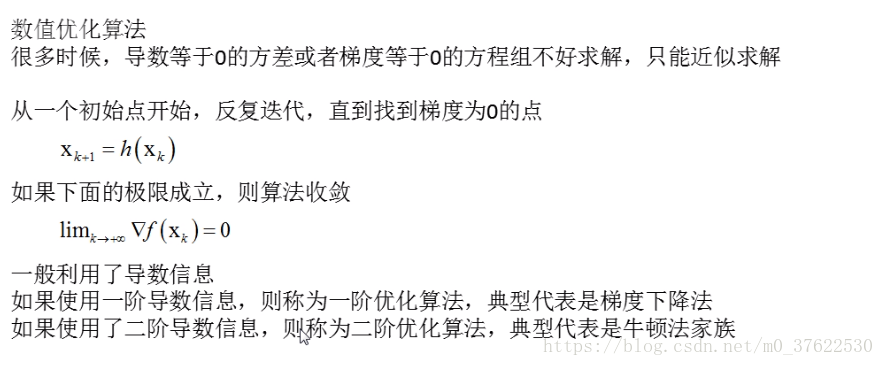

2 数值优化算法

2.1 梯度下降法

有两种调整方法——加入动量项和自适应学习率法

2.1.1 动量项

动量项展开后(累计了之前所有的梯度):

2.1.2 自适应学习率法

AdaGrad

RMSProp

AdaDelta

前两种方法还都用了人工的学习率α,替换掉了人工学习率α后:

Adam

随机梯度下降

2.2 牛顿法

3 分治法

将一个大问题分解成子问题求解,最后将子问题拼接起来

3.1 坐标下降法

3.2 SMO算法

(下图中C是惩罚因子)

3.3 分阶段优化法

上图中:先固定β,优化f;再固定f,优化β

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?