首先 hadoop集群是要先搭建的没的说。

可以先在hadoop上运行自带的mapreduce jar包,跑一下,不成功说明配置文件没有配置好,这里就不说配置哪些了,网上很多。

1.在windows下下载hadoop-2.8.0.tar.gz 并且解压

2.下载 hadoop-eclipse-plugin-2.7.0.jar插件 ,然后放到myeclipse的dropins文件夹下,然后重启myeclipse。

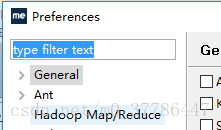

3 windows -preferences 然后发现有出现下面这个hadoop Map/Reduce

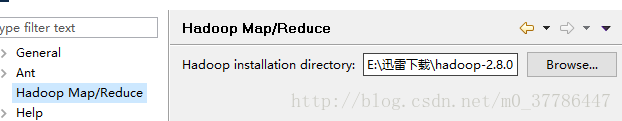

4. 把前面解压hadoop-2.8.0.tar.gz 的路径输入然后点击OK。

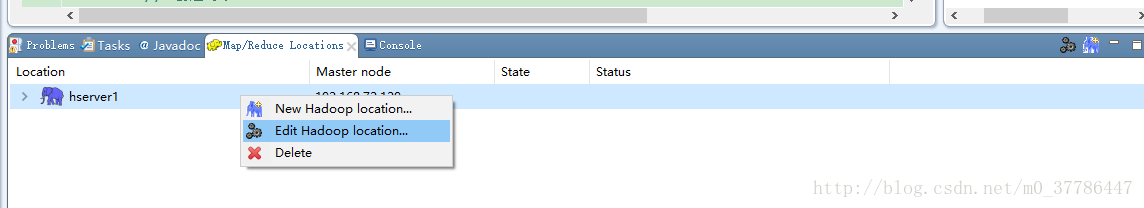

5.重选择window-->OpenPerspective-->Others;选择Map/Reduce 点击OK;

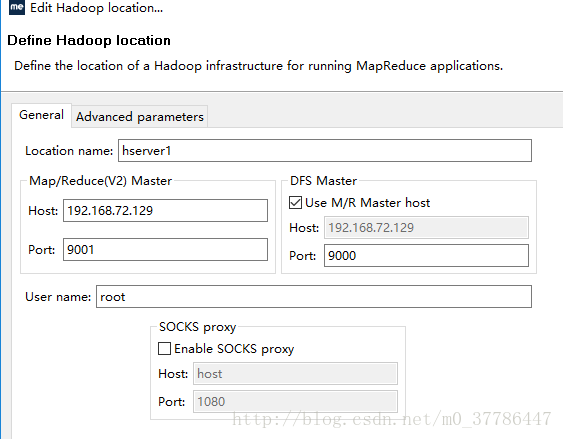

6.根据你的hadoop 进行配置

这时候就可以看左边有显示自己的hdfs文件夹了

6.windows的环境变量中要配置上上面解压的hadoop的环境变量,配置方法和配置jdk一样。

7.下载 winutils.exe 和hadoop.dll 放到上面解压的hadoop下的bin目录里面,并且把hadoop.dll放到C:\Windows\System32目录。 下载地址:https://github.com/steveloughran/winutils

如果报错是权限不允许的话:在hdfs-site.xml 里面加上:

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

问题解决,尽情的写你的mapreduce吧,伙计。

9231

9231

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?