Video Question Answering: a Survey of Models and Datasets

长文预警!!!

p.s.此篇文章于2021年1月25日新鲜出炉,在Springer需要付费观看,博主免费分享给大家,希望与大家共同学习!

Abstract

视频问答(VideoQA)根据视频内容自动回答自然语言问题。它促进了在线教育、情景分析、视频内容检索等方面的发展。VideoQA是一项具有挑战性的任务,因为它需要一个模型来理解视频的语义信息和生成答案的问题。首先,我们提出了一个视频特征提取模块、文本特征提取模块、集成模块和答案生成模块组成的视频质量保证系统的总体框架。集成模块是核心模块,包括核心处理模型、递归神经网络(RNNs)编码器和特征融合。这三个子模块协作生成上下文表示,答案生成模块在此基础上生成答案。 然后,总结了核心处理模型的方法,并详细介绍了编码器解码器、注意模型、记忆网络等方法的思想和应用。此外,我们还介绍了广泛使用的数据集和评价标准,以及在基准数据集上的实验结果分析。最后,我们讨论了视频qa领域所面临的挑战,并为未来的工作提供了一些可能的方向。

Keywords

Video question answering

Feature extraction

Encoder-decoder

Attention model

Memory network

Recurrent neural networks

Feature fusion

1 Introduction

近年来,视觉和语言理解任务因其包含了真实世界的动态场景信息而受到越来越多的关注。它有助于有效聚合海量数据,为在线学习提供教育资源。VideoQA在深度视觉和语言理解方面起着至关重要的作用。VideoQA的主要目标是学习一个模型,这需要理解视频和问题中的语义信息,以及它们的语义关联,以预测给定问题的正确答案。在视频质量检测中应用了多种人工智能技术,包括对象检测[1]和分割[2]、特征提取[3]、内容理解[4]、分类[5]等。综合表现的评估指标是答对问题的百分比。VideoQA可以应用于许多实际应用中,如用户自由提问的视频内容检索,视障人士的视频内容理解等。VideoQA打破了视觉和语言的语义鸿沟,从而促进了视觉理解和人机交互。

即使VideoQA是ImageQA[6]的自然扩展,它们之间仍然有许多不同之处。因此,简单地将ImageQA方法扩展到视频是不够的,也是最优的。主要区别在于两个方面:

(1)VideoQA处理具有丰富外观和运动信息的长序列图像,而不是单一的静态图像。

(2)由于视频中存在大量的时间线索,VideoQA需要更多的时间推理来回答问题,如动作过渡和计数。

在此基础上,本研究对视频质量控制的研究框架、核心处理模型的方法、数据集以及未来的发展方向进行了全面的综述。

在VideoQA框架中,

(1)视频特征提取模块分别使用Faster-RCNN[7]提取区域级特征,使用CNN[8-10]提取帧级特征,使用C3D[11]提取图像级别特征。

(2)文本特征提取模块分别使用预先训练的词嵌入模型[12,13]和句子嵌入模型[14-16]提取词级特征。

(3)集成模块以视觉和文本信息为重要线索,生成具有多模态语义的上下文表示。

(4)答案生成模块根据语境表征,通过判别模型生成答案。

集成模块包括核心处理模型、rns编码器和特征融合。这三个子模块协作获得上下文表示。核心处理模型是进行推理和生成答案的核心部分。它由多种模型组成,如编码器-解码器[17]、注意模型[18]、记忆网络[19]和其他方法[20]。编码器-解码器模型有两个组件:一个编码器和一个解码器。编码器从变长输入序列中提取定长表示,然后解码器从该表示中生成答案。注意模型有选择地将注意力集中在源中相关度最高的部分,并收集加权表示生成答案。具体来说,它根据问题选择重要的视频,获得问题引导的视频表示。内存网络模型包含一个内存数组。它存储整个视频内容以保存其长期记忆,并结合注意模型根据问题阅读相关信息,得到问题引导的视频表示用于回答问题。其余的方法大致可以归类为其他方法,例如,使用生成对抗网络(GAN)的思想来解决VideoQA任务。此外,RNNs编码器对视频和问题的时间结构进行建模,特征融合融合了多模态特征(视觉和语言),提高了回答性能。

根据不同的视频源,我们引入了一些基准数据集,如MovieQA[19]、TGIFQA[21]、TVQA[22]、PororoQA[23]和Activity-QA[24]。针对数据集设计了不同类型的问题,如多项选择题、填空题和开放式问题。与图像相比,视频具有更丰富和高质量的时间维度的视觉信息,这决定了VideoQA需要对视频进行更深层次的语义分析。此外,有两种常用的评价标准来评价生成答案的质量,即准确性和waps[25]。

值得注意的是,视频qa研究工作已经引起了极大的关注。然而,调查[26-29]只关注VisualQA任务。一些VideoQA作品在[30]中被回顾,这还不够。因此,我们的调查对VideoQA任务进行了全面和集中的描述。并对近年来的工作进行了回顾,总结了尚未解决的问题,为今后的工作提供了很有前景的方向。

这项调查的结构如下。第2节给出了VideoQA的形式化定义和总体架构,并以图表的形式说明了不同模块的处理。第三节总结了近期的视频qa论文中关于预测答案的核心处理模型,并对核心处理模型进行了全面的文献综述,以及如何利用这些思想解决视频qa任务。第4节介绍了应用于视频qa的典型数据集和评估指标。第五部分总结并讨论了未来可能的发展。最后,第六章进行了总结,提出了一些思考,并为今后的工作提供了研究方向。

2 Framework of video QA

2.1 Video QA task and terminology

以往的研究使用无监督[20]、半监督[31]或监督学习模型[18]来解决VideoQA任务。在大多数情况下,监督学习仍然是最常见的。因此,解决VideoQA任务的监督学习的正式定义如下。在描述模型之前,我们首先解释表1中列出的一些基本概念和术语。模型f(v,q, a;θ)的输入:模型输出的视频v∈v,问题q∈q,答案a∈a。因此,我们学习过程中的目标函数为:

其中θ为模型系数,l θ为损失函数,λ为训练损失与正则化之间的权衡参数。显然,如何训练模型参数θ来回答问题是解决视频qa任务的关键。

为便于描述,图1给出了VideoQA任务的总体框架,该任务由以下四个部分组成:视频特征提取模块、文本特征提取模块、集成模块和答案生成模块。视频特征包括区域级特征、帧级特征和剪辑级特征。详细的分析将在2.2节中描述。

文本特征包括词层特征和句子层特征。这两层特征既表示粗粒度的问题特征,也表示细粒度的词特征。详细分析将在2.3节中讨论。

提取的视频特征和文本特征输入到集成模块中。然后输出上下文表示,这是问题回答的关键线索。集成模块的定义和分析将在2.4节中讨论。答案生成模块使用上下文表示来生成答案。模块的详细分析将在2.4.1节中介绍。

2.2 Video feature extraction

与图像相比,视频不仅包含静态的区域(对象)级和帧级特征,还包含动态的片段(段)级特征。区域级视频特征是对局部视觉信息的细粒度表示。提取的局部特征可以表示为区域级的视频特征和预测的检测标签,两者都可以作为集成模块的输入。由于现有的基于region proposal network (RPN)的工作在许多测试中都取得了很高的精度,大多数工作都使用Faster-RCNN检测感兴趣的局部部分,以识别视频的局部属性。

帧级视频特征是对全局视觉信息的粗粒度表示,它比区域级视频特征捕获更多类型的信息。(例如:人物和场景)。随着深度神经网络的发展,人们提出了更深入、性能更高的神经网络,如VGGNet、GoogLeNet和ResNet。VGGNet被广泛用于提取每一帧的帧级特征。每帧大小为224 × 224。然后提取第一个全连通层的4096维特征向量作为帧级视频特征。类似地,GoogLeNet被用于提取帧级特征,这些特征来自于Concat层的最后一个初始5b。特征尺寸为2 × 7 × 1024。利用ResNet,从pool5层提取2048维的特征向量。

剪辑级视频特征是顺序的和动态的特征表示(例如,行为)。C3D网络在动作识别任务和捕捉视频动态信息的能力方面显示了很有前途的结果。在Sport-1 M数据集[11]t o e x tra c t the c l i p水平特征上预先训练C3D。C3D的fc7层和C3D的conv5b层的输出特征作为连续16帧的剪辑特征。特性大小分别为4096和1024。我们将基于上述模型的工作总结在表2中。

2.3 Text feature extraction

在自然语言处理任务中,预先训练好的语言模型是提取文本特征的有效方法[66,67]。句子级模型通过分析句子的顺序数据来预测句子之间的关系,单词级模型在单词级[16]上实现细粒度表示。VideoQA中有大量的文本数据,即字幕、故事、对话和问题,这些文本数据被认为是一个单词序列。因此,文本特征提取可分为单词级和句子级。

采用Word2Vec[12]和GloVe[13]的词嵌入提取词级特征。词向量是词汇表中所有词的向量表示的特征矩阵。该算法将所有的词转化为低维嵌入空间,计算词间的语义相似度。采用预先训练的word2vec模型[68]提取题、答案的语义信息,其维数为256。预训练的300维手套模型也在许多研究工作中得到应用。该手套是根据维基百科2014和Gigaword 5(包括400k的词汇量)训练的。对于不出现在手套中的词,使用现有词的嵌入值的平均值。

通常使用Skip-Thought[14]、Bag-of-word[15]和BERT[16]来提取句子级文本特征。受词向量学习的启发,Skip-Thought是一种学习高质量句子向量的模型,它将skip-gram模型抽象到句子级别。在VideoQA中,使用SkipThought学习RNN模型中的句子语义和句法属性,以捕获问题语义信息之间的相似性。word袋模型使用一个固定长度的单词计数向量来表示文本。虽然该模型不考虑词级信息,但它已被证明能够成功地捕捉到长距离词汇相关信息和主题信息。BERT是一种经过微调的基于transformer的语言模型,它捕捉双向上下文信息,以在不同的句子级别任务中预测句子。我们在表3中总结了常用的预先训练过的语言模型。

2.4 Integration

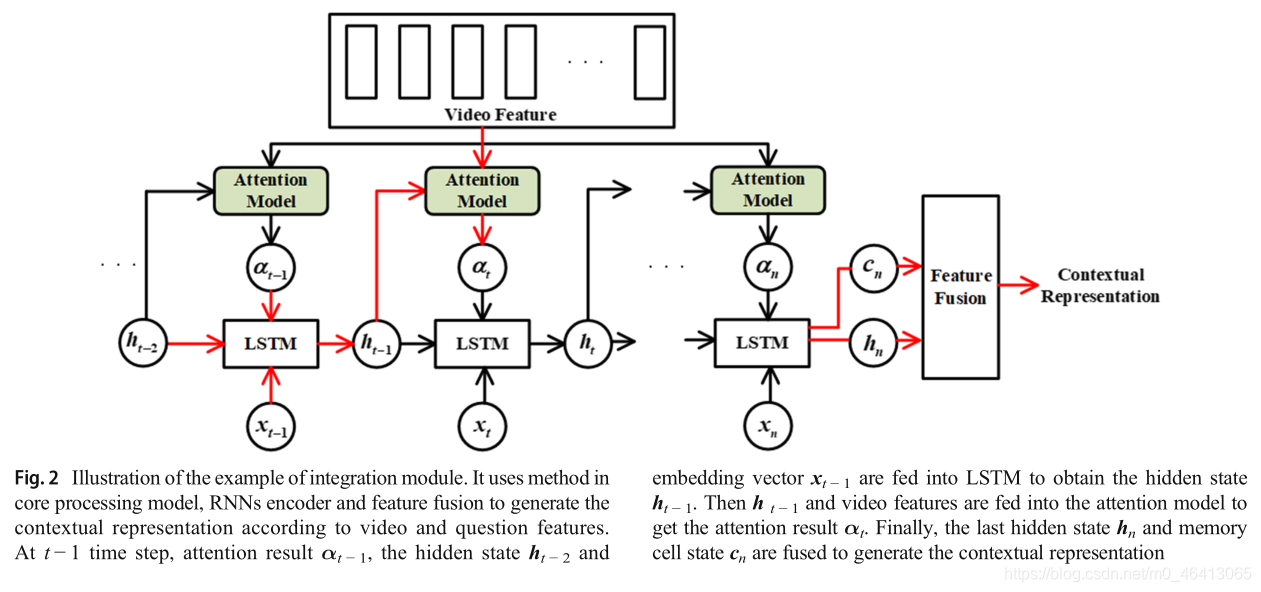

集成模块的目的是建立多模态语义信息之间的相关表示,作为问答的关键线索。为了学习上下文表示,集成模块中需要核心处理模型、rns编码器和特征融合三个模块进行协作。核心处理模型作为集成模块的重要组成部分,是解决VideoQA任务的核心。主要分为四类方法:编译码法、注意模型法、记忆网络法等。由于视频和文本都是不同长度的连续数据,所以选择RNNs编码器是很自然的。现有的方法表明,结合不同层次的特征也可以提高性能[70]。特征融合也分为三类:线性池化、模型融合、双线性池化[30]。

为了更清楚地说明,图2给出了集成模块的示例。集成模块将注意模型集成到解码器的语言模型中,实现利用语言模型解码视频信息的方法。它在问题和视频之间建立了紧密的联系。具体来说,词嵌入向量{x1,…,xt−1,xt,…,xn}被输入语言模型[71],该语言模型在t−1时间步长输出隐藏状态ht−1。注意模型基于隐藏状态ht−1对视频特征进行注意,得到注意结果为。由此可见,注意力模型被整合到LSTM的过程中,整合模块不仅使用了核心处理模型中的方法,还使用了RNNs编码器对问题序列进行编码。通过连接的方法将最后一个隐藏状态hn和记忆单元状态cnn融合,生成带有问题视频语义信息的上下文表示,是回答问题的重要线索。

2.4.1 Core processing model

本研究将核心处理模型的方法分为四类:编码器-解码器、注意模型、记忆网络等。编码器-解码器框架由编码器和解码器组成。编码器对来自变长输入句子的定长表示进行编码,解码器生成与问题相关的变长序列。注意力模型的思想是计算视频上的权重分布,并赋予与问题相关的元素更高的值。记忆网络是一种具有递归注意力模型的神经网络,与递归神经网络相比具有较大的外存储器。它包含一个存储阵列,为多个周期编码输入源,以及一个注意力模型,允许阅读过程在每个周期关注不同的内容。其余的方法大致归类为其他方法。表4总结了现有的工作。第三章将详细介绍在核心处理模型中的方法分析。

2.4.2 RNNs encoder

视频和问题都是顺序数据,所以选择rns网络进行编码是很自然的。在rns模型的帮助下,通过编码帧级特征获得视频级表示,通过对词级特征进行编码,得到问题级表征。RNN族(简称RNN)包括LSTM[71]、双向LSTM (Bi-LSTM)[72]、双LSTM[73]、门控循环单元网络(GRU)[74]、双向GRU(简称Bi-GRU)[75]。

LSTM是rnn的一种变体,它结合了短期记忆和长期记忆,能够更好地解决序列相对较长的任务。在基本的LSTM单元结构中,有一个称为存储单元的单元,它存储状态变化并对顺序数据进行编码。它由输入门、遗忘门和输出门三种门机制来调节。对于帧级和词级特征,输入门对当前输入数据和之前隐藏的状态进行编码。遗忘门控制是否忘记先前的信息,以及修改多少信息的记忆单元状态。输出门输出当前隐藏状态和存储单元状态,这是下一步的输入。LSTM通常用于编码这两个特征,其中最后的隐藏状态和存储单元状态连接作为特征表示。

Bi-LSTM由正向LSTM和反向LSTM组成,它们具有相同的拓扑结构,只是反向输入序列不同。对于帧级和词级特征,通常将前向LSTM和后向LSTM的隐藏状态连接起来作为特征表示。Double-LSTM由一个两层的LSTM组成。针对上述两个特征,将第一层的编码结果传输到第二层。最后的隐藏状态和第二层的存储单元状态连接起来作为特征表示。

GRU在概念上比较简单,但不比LSTM差。GRU只有更新门和重置门。对于框架级和词级特征,输出GRU网络的最后隐藏状态作为特征表示。Bi-GRU由正向GRU和反向GRU组成,它们类似于Bi-LSTM,对上述两个特征进行编码。我们在表5中总结了用于编码视频特征和问题特征的RNNs方法。

2.4.3 Feature fusion

多模态特征融合是视频质量保证任务的基础和意义。特征融合被广泛应用于多种模态特征的融合。与未融合的特征相比,融合的特征具有更好的性能[76]。特征融合方法包括线性池化、模型融合和双线性池化。

线性池化是多模态特征融合的常用方法。视频和问题的联合表示是通过拼接、元素和元素相乘等方法得到的。实验表明,两个特征集在不同模态下的分布可能有很大差异,融合特征的表示能力可能不够,导致预测性能不理想[70]。

模型融合采用神经网络学习联合表示。例如,IFAN [17] u s es LSTM对视频特征进行编码,并利用最后的隐藏状态初始化语言模型。将注意力模型整合到语言模型中,将问题与视频建立起密切的关系。

与线性池化方法相比,双线性池化方法[70,76,77]被用来融合不同的模态特征来解决VideoQA任务。多模态紧致双线性池(MCB)[70]的性能优于线性池方法。然而,MCB通常需要高维特征来保证其鲁棒性能,这可能会严重限制其能力,因为GPU内存的限制。为了解决这一问题,提出了基于两个特征向量的Hadamard积的多模态低秩双线性池(MLB)[77]。MLB取得了与MCB相同的性能,但其特征维数和模型参数较少。此外,多模态分解双线性池(MFB)[76]方法是MLB和MCB之间的一种折衷方法,它具有MLB紧凑的输出特性和MCB健壮的表达能力的双重优势。我们将特征融合方法总结在表6中。

2.5 Answer generation

视频问答题的答案通常分为三种类型:开放式问题、多项选择题和填空题。 基于监督学习和判别模型解决了答案生成问题。判别模型定义如下:给定一个输入变量x,该模型直接求解目标变量的类后验概率P(y|x)。定义了一个线性回归,它将集成模块中的视频和问题的上下文表示作为输入,并输出每个候选答案的实值分数,

其中,W⊤和b为模型参数。通常,训练模型的方法是最小化成对比较∑p≠nmax(0,1−sp+sn)的hinge loss,其中sn sp 为分别来自错误答案和正确答案的分数。

softmax回归是线性回归的多类版本,表示为样本向量x属于这k个类之一的概率值。因此,我们定义了一个softmax分类器,它以上下文表示形式O作为输入,通过计算置信向量s从词汇表中选择答案。

其中,W⊤和b为模型参数。该模型通过最小化softmax损失函数进行训练。

通过

得到预测答案。我们在表格7总结了在表中生成答案的方法。

3 The methods in Core processing model

集成模块的核心部分是核心处理模型,从视频和问题特征中提取相关信息,进行上下文表示并生成答案。根据思想和方法的不同,core processing model中的方法大致可以分为以下四类: encoder-decoder [17], attention model [18], memory network[19]和其他方法[20] 。详细介绍了该方法的核心思想,以及如何利用这些思想解决视频qa任务。

3.1 Encoder-decoder

由编码器和解码器组成的编译码器[78-80]模型在机器翻译中非常流行。编码器将变长序列(输入序列)编码为中间码,解码器使用中间码生成变长序列(输出序列)[81]。编译码器模型的基本框架如图3所示。首先,输入序列{x1,…,xT}被送入编码器,生成t时间步长的隐藏状态,其中ht=R N N s (xT,ht−1)。然后将所有隐藏状态输入到一个非线性函数中,生成结果c=q ({h1,…,hT})作为整个输入序列的输出,其中是上下文向量。然后解码器根据概率函数输出答案预测yt at t时间步长,如下:

其中g为非线性函数,为隐态st−1产生的解码器的隐态,输出yt−1,公式如下:

初始隐藏状态s1由最后一个隐藏状态ht和特殊的句子结束标记eos计算。解码器生成隐藏状态序列s={s1,…,sM}和输出序列y=(y1,…,yM)。在下面的小节中,我们将讨论三种类型的编码器-解码器模型:

基本编译码、部分改进的编译码、完全改进的编译码,按编译码模型改进程度进行划分。基本编码器-解码器是一个简单的应用编码器-解码器结构的VideoQA。原始的RNN模型,如LSTM和GRU,只是简单地用于编码器和解码器部分。部分改进的编译码器只改进了编译码器结构的一部分,主要是通过在rns模型中加入注意模型。在上述方法的基础上,完全改进的编解码器的编解码器部分,自然可以与其他模型进行多种组合。在下面的章节中,我们将通过三个类别全面回顾VQA方法。

3.1.1 Basic encoder-decoder

基本编码器-解码器是一个简单的应用编码器-解码器结构的VideoQA。本文提出了一种多层GRU编译码框架,并提出了一种双通道排序损耗法来分析过去、描述现在和预测未来。GRU模型编码帧级特征,以生成隐藏状态

在编码器的每个时间步。然后这些隐藏状态的串联

作为中间代码。对于解码器,其架构与编码器相同。解码器的初始隐藏状态h0用编码器最后一步T的隐藏状态进行初始化。分别学习的三个GRU解码器分别用于推理过去、描述现在和预测未来。为了产生不同的目标序列,译码器在时域中关注不同的信息。最后,为了评估学习到的视频对过去、现在和未来的表征,我们采用了双通道排名损失,以产生比其他干扰因素对正确答案的视觉上下文和表征向量更高的相似性。本文以时域为研究对象,采用无监督方法对编码器进行训练。该方法能够在较长的时间范围内对视频时间结构进行建模。但该方法将时间模型和问答对模型分别训练,弱化了视频内容与文本之间的关系。

在论文[53]中解决的问题类型是带有填空的VideoQA任务。编码器使用双向BN-LSTM (LSTM的批处理规范化变体)对问题进行编码。前半段LSTM网络对问题进行编码,输出表示为ashf。反向LSTM网络在后半部分对问题进行编码,而输出表示则记录为ashb。其中hq ={hf,hb}是整个问题的编码表示。利用LSTM网络对帧级特征进行编码得到hV。然后,将hq和hv输入解码器,输出不同候选答案的概率分布。该译码器由单层MLP和softmax分类网络组成。采用最大对数似然法对网络参数进行估计。

论文[22]针对多模态VQA任务提出了一种可训练的多流端到端神经网络。多流包括区域级和概念级特征,以及帧级特征。对于这三个特征,使用基于视觉基因组训练的Faster R-CNN来检测每一帧中的目标和属性区域。区域特征作为区域级特征,预测的检测标签作为概念特征。在ImageNet上训练ResNet101,提取帧级特征。在编码器中,使用双lstm对问题序列和视频序列进行编码。以所有时刻步骤的隐藏状态分别表示问题、答案和视频。然后,上下文匹配模块[82]将上下文向量和查询向量作为输入,产生一组上下文感知的查询表示,即每个上下文查询对之间的相似度。这些上下文感知的查询表示通过连接进行融合。最后,将融合后的表示输入到另一个双lstm中进行解码。它的隐藏状态被暂时最大池提供给softmax分类器用于答案预测。表8总结了VideoQA中基于基本编码器解码器方法的模型。

3.1.2 Partly improved encoder or decoder

部分改进的编译码器主要通过增加注意模型来改进编译码器的部分结构。IFAN网络在论文[17]中提出,将注意力模型集成到解码器中,建立了文本和视频之间的密切关系。首先,利用VGGNet提取帧级特征。然后,在编码器中,通过LSTM对帧级特征进行编码,生成以时间结构作为视频表示的隐藏状态序列。最后的隐藏状态和存储单元状态用于初始化解码器的语言模型。然后,为了对视频信息进行解码,在语言模型中引入注意模型来建立问题与视频之间的关系。特别地,问题被嵌入到生成词向量xi:i=1,…,n。词向量xi被用来参加视频表示,得到γt−1,在下一步中被传递到注意状态γt。可以看出,采用注意模型的LSTM网络传输到下一步的状态包含三个部分:记忆细胞ct−1、隐藏状态ht−1和注意状态γt。最后,将最后的隐藏状态hM和最后的存储单元状态cM融合到softmax分类器中,得到最终的答案。

论文[21]提出了ST-VQA网络,将时空注意力模型集成到编码器中,并根据问题选择每一帧中的关键区域和视频中的重要帧。首先利用ResNet算法提取帧级视频特征,然后利用C3D算法提取剪辑级视频特征;它们被连接成整个视频功能。采用预先训练的方法提取问题和答案的文本特征。其次,在编码器中使用双lstm对帧级视频特征进行编码。它的最终隐藏状态用于初始化第二个double-LSTM,第二个double-LSTM用于对问题进行编码,并使问题的最终隐藏状态初始化第三个double-LSTM以生成答案。最后,在解码器阶段,针对多项选择题、开放式(数)题和开放式(字)题设计三个解码器生成答案。本文的贡献在于将问题中的每个单词分别用于参加视频中的每一帧,以及每一帧中对应的区域。时空信息在与问答对相关联的同时被保留。

论文[38]提出了序列视频注意力模型和时间问题注意力模型,并将其集成到编码器中。首先,使用双lstm分别对问题和视频进行编码。编码器生成的问题表示记作hq={hf q;hb q}。同样,编码器生成的视频表示记作hv={ hf v;hb v}。其次,提出了两种注意模型。一种是顺序视频注意模型,它不仅关注视频的相关帧,而且沿着问题的顺序结构反复积累信息,以获得问题引导的视频表示。另一种是时间问题注意模型,它不仅关注每一帧的问题,而且在时间维度上不断累积以获得视频引导的问题表示。第三,将这些模型集成起来,为解码器生成上下文表示。该译码器由两个堆叠的单层LSTM组成,其中顶层LSTM用零向量激活。顶层LSTM的输出直接作为底层LSTM的输入,直到生成句尾标记eos。最后,底层LSTM对向量进行解码,通过一个全连通层和一个softmax层生成答案。

论文[39]提出了将多层次时空注意力网络集成到编码器中。首先,由于帧级视频特征不足以捕获细粒度信息,自然可以选择空间注意模型,根据问题自动定位每帧中的目标区域,得到空间参与的帧表示vf。用Bi-GRU对表示vf进行编码,得到隐藏状态表示hf。然后,为了减少冗余的视频帧,颞注意力模型提出了估计视频帧的相关性问题,并输出标准化的时间关注分数β∈(0,1)。此外,一个与注意力门格勒乌网络是用来学习时空的顺序敏感表示出席。与基本GRU模型不同,GRU模型的输入是hf和βi。当前的估计状态是基于输入高频产生的。然后,GRU网络根据估计状态和之前的隐藏状态ht−1更新其隐藏状态,并将更新门向量设置为标准化得分βi。然后,得到了时空出席的顺序敏感表示,记为hT,这是GRU模型的最后一个隐藏状态。最后,通过引入多步推理过程进一步提高了VideoQA模型的性能,并在第r次更新后获得时空视频的联合表示,以提高泛化性能。在解码器中,答案由时空视频的联合表示生成。仅对VideoQA的编码器和解码器部分进行扩展的工作如表9所示。

3.1.3 Fully improved encoder and decoder

充分改进的编码器-解码器模型优化了编码器和解码器部分。本文研究了多回合视频质量保证任务。与单回合的VideoQA任务相比,VideoQA数据集包含多回合的问题-答案对。首先,利用I3D网络提取帧级视频特征;其次,在问题引导的视频表示模型中,使用双lstm网络对问题进行编码,并将前向隐藏状态和后向隐藏状态连接起来,得到最终的问题表示。第三,通过测量多模态特征之间的相似度,提出三线性函数来识别与问题最相关的视频帧。注意模型可以在时间域内剔除不相关的帧。因此,提出了一种选门机制来从每一帧中选择与问题相关的区域。最后,将问题编码过程中获得的隐藏状态初始化译码网络。在t时间步,使用t−1时间步的隐藏状态对问题中的单词进行关注,使用最后一个隐藏状态生成答案。

充分改进的编码器-解码器模型优化了编码器和解码器部分。本文研究了多回合视频质量保证任务。与单回合的VideoQA任务相比,VideoQA数据集包含多回合的问题-答案对。首先,利用I3D网络提取帧级视频特征;其次,在问题引导的视频表示模型中,使用双lstm网络对问题进行编码,并将前向隐藏状态和后向隐藏状态连接起来,得到最终的问题表示。第三,通过测量多模态特征之间的相似度,提出三线性函数来识别与问题最相关的视频帧。注意模型可以在时间域内剔除不相关的帧。因此,提出了一种选门机制来从每一帧中选择与问题相关的区域。最后,将问题编码过程中获得的隐藏状态初始化译码网络。在t时间步,使用t−1时间步的隐藏状态对问题中的单词进行关注,使用最后一个隐藏状态生成答案。

提出了JSFusion[42]来度量视频质量检测中任意一对多模态之间的语义相似度。JSFusion由联合语义张量(joint semantic tensor, JST)和卷积层次译码器(convolutional hierarchical decoder, CHD)两部分组成。JST是一种编码器网络,它将两个模的序列压缩成稠密张量表示。CHD是一个解码器网络,通过发现隐藏的层次匹配来计算两种序列模式之间的相似性。这两个模块都利用了层次注意模型来提升匹配良好的表示模式,同时以自底向上的方式剔除不匹配的表示。首先,在编码阶段,使用双lstm对问题进行编码,融合前向/后向隐藏状态得到问题表示。使用CNN获取视频表示。其次,将问题表示和视频表示嵌入到同一个特征空间中,将问题用于观看视频,获得问题引导的视频表示;在解码时,CHD计算一对多模态序列的兼容性得分,并将JST张量通过一系列卷积层和卷积门控块进行前一层的匹配嵌入。最后,通过平均池化得到视频-问题表示,并将其输入到稠密层中进行预测。

文献[64]提出了一种分层卷积自注意编译码网络(HCSA)来解决长格式的视频qa任务。首先,利用预先训练好的3D-ConvNet提取帧级视频特征,然后输入线性投影进行降维。利用预先训练好的word2vec提取问题特征,然后输入Bi-GRU模型学习问题语义表示。其次,针对表9部分改进的VideoQA编译码器,提出了HCSA编码器。表中的“关注”意味着编码器和译码器使用注意模型除了RNNs论文编码器(Q)编码器(V)译码器如果[17]LSTM LSTM LSTM注意ST-VQA [21] Double-LSTM Double-LSTM注意LSTM统一[38]B i - L S T M注意Bi-LSTM注意Double-LSTM r-STAN[39]格勒乌Bi-GRU关注神经网络移动Netw:编码。它由L个卷积的自我注意层组成,每一层由两个卷积单元、一个注意分割单元和一个问题感知的自我注意单元组成。卷积单元可以有效地建模长格式的视频内容。注意分割单元将长形式的视频内容分割成不同的片段,利用问题信息学习注意的片段级表征。具有问题意识的自我注意单元以问题为引导,捕捉长形式视频的信息。HCSA编码器输出多层视频语义表示作为多尺度关注解码器网络输入。最后,基于多尺度视觉线索的多尺度细心解码器对自然语言问题进行了回答。本文的贡献在于解决了传统RNN编译码框架中由于长期依赖而导致的建模能力不足和计算复杂度高的问题。本文[32]提出了跨模态自我注意(cross-modal self-attention, CMSA)编码器和LSTM解码器模型,以解决基于LSTM方法的长期依赖性和局限性问题。首先,提取帧级视频特征和区域级视频特征,利用语义丰富嵌入(SRE)模块将区域级视频特征和帧级视频特征嵌入到同一个特征空间中。利用自我注意模型捕获长视频之间的时间关系,得到自我注意的SRE表征。其次,将SRE表示作为查询矩阵,通过不同权重矩阵对字幕特征进行初始化,得到关键矩阵和值矩阵;在变压器编码器上输入查询、键和值,通过CMSA得到不同型号vcmsaa的联合表示。最后,在解码器中,将平均vcmsaa输入一个双层MLP网络,其输出用于初始化解码器的隐藏状态和存储单元状态。这个问题被用来参加自我注意的SRE表征,以产生最终的答案。本文的贡献在于利用不同模态的自我注意模型捕获模态之间的高级语义信息。改进VideoQA编码器和解码器模型的工作如表10所示。

3.2 Attention model

从自然语言处理领域的著作[83,84]到计算机视觉领域的著作[85,86],注意模型受到了极大的关注。在自然语言处理、统计学习、语音识别和计算机视觉等领域,注意力模型已经成为神经结构的重要组成部分。注意力是由人体生理系统直接驱动的典型例子。人们在观看狗狗照片时,会选择性地将注意力集中在照片中的狗身上,而忽略不相关的信息。如上所述,我们可以把狗当作一个查询,把照片当作一个来源。注意力模型的主要目标是定位图片中包含狗的区域。注意模型可以被描述为一个函数,它将一个查询和一组键值对映射到一个输出[87],其中查询、键、值和输出都是向量。

图4显示了注意力模型的框架。将查询和来源输入注意模型,并输出注意值。具体来说,在计算注意分布时,查询作为参考或指南,由键-值对组成的源表示为关注对象,其中键和值是由不同权重矩阵初始化的源表示。注意力价值是注意力的结果。注意力模型的思想是计算源上的权重分布,将更高的值分配给与查询相关的元素。因此,查询引导的源表示由以下方式生成:

分数函数输出一组标量分数,表示匹配或组合的质量,并实现对查询和键之间的语义信息的解释。对齐函数将评分转换为关注权重αi。α是查询与源相关的概率。常见的对齐函数是softmax函数,它将所有的分数归一化为概率值。生成上下文函数是这些值及其对应的注意权值的加权和,它生成一个查询引导的源表示。查询引导的源表示是一种最终表示,它关注与查询相关联的源的位置。

由于注意模型给出的结果具有通用性、直观性和可解释性,因此在以问题为查询对象、以视频为数据源的视频qa中得到了广泛的应用。根据注意在视频问答任务中的应用,我们将注意模型分为:单跳问题引导的注意模型、多跳问题引导的注意模型、视频问题共同注意模型和自我注意模型。单跳表示源只参与一次,多跳表示不止一次。随着注意数量的增加,多跳问题引导注意所达到的准确性超过了单跳问题引导注意。在共同注意模型中,问题引导的注意和视频引导的注意被执行并合并。在自我注意模型中,根据序列的不同位置计算一个表示。

相应的调查[88-90]对注意事项给出了更详细的说明。为了避免混淆,在进一步讨论之前,我们先解释一些缩写。Q Guided S是question-guided source的缩写。根据问题参加视频的方式为Q→V,根据问题参加上下文的方式为Q→C

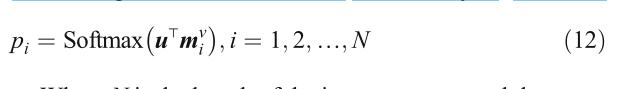

3.2.1 Single-hop question-guided attention model

图5显示了单跳问题引导注意模型的架构。源是一个包含区域级、帧级和剪辑级特性的视频特性。Key和value被作为源表示的同等权重的矩阵初始化。利用问题特征q参加帧级视频特征{v1,v2,…,vn},其中为视频中采样的帧级特征个数。问题引导的视频呈现是注意力的结果。问题引导的注意模型可以表示为:

这里我们选择一般得分函数来计算si, Wa是一个权重矩阵。

表11给出了常用的评分函数

论文[18]提出了一种端到端的视频qa模型。首先,将VGGNet提取的帧级视频特征定义为外观特征;针对运动特征,定义了C3D提取的剪辑级视频特征。将问题转换成词向量,然后输入到LSTM中。隐藏状态记住了处理过的单词的信息。其次,逐字分析问题,并利用注意记忆单元(AMU)在每个时间步上细化对外观和运动特征的注意;AMU包括四个步骤:注意、通道融合、记忆和提炼。注意根据问题对外观和动作特征进行注意,得到问题引导的视频表示,表示为Q→V。注意过程分两次进行。信道融合融合特征生成中间视频表示。记忆是一个LSTM网络,它控制二次注意操作的输入并记忆注意历史。在Refine中,在第一和第二注意力权重被细化后,生成视频表示,将在下一步中使用。第三,在对问题的所有单词进行处理后,模型生成了一个精炼的问题引导视频表示,这是回答问题最相关、最重要的信息。最后,利用问题信息、注意历史信息和优化后的注意表征生成答案。

人们不仅考虑用视觉内容来回答问题,还会在脑海中回顾知识。除了视频内容外,参考外部知识是必不可少的。论文[33]提出了一种基于知识的渐进时空注意网络(K-PSTANet),该网络不仅考虑了视频的时空特征,而且利用外部知识来提高问题的回答能力。首先,使用Faster-RCNN模型提取区域级特征,使用VGGNet提取帧级特征。将这两种特征融合为视频表示。来自DBpedia[92]的外部知识由Doc2Vec模型编码[93]。将问题转化为单词嵌入,逐字输入LSTM。其次,在每个时间步骤中,分别使用问题感知的知识注意(ATTKnowledge)和时空注意(STA)单元生成问题引导的知识表示和问题引导的视频表示。atti - knowledge利用问题的隐藏状态对知识特征进行注意,记为Q→K。然后,将问题引导的知识表示为外部先验知识来回答问题。第三,在STA单元中,将外部先验知识和问题隐藏状态连接为一个查询来参加视频表示,记为asQ→V。然后,得到帧级视频表示,并将其输入双lstm得到阶敏感表示。最后,在对问题中的所有单词进行处理后,融合视频表示、问题和知识生成答案。

许多现有的作品将整个问题作为一个查询来执行对视频的注意,这在视频qa中可能是无效的。论文[43]提出了分层双层注意网络(DLAN)。DLAN模型包含细粒度的词级注意模型和粗粒度的问题级注意模型,学习问题引导的框架表示和问题引导的片段表示,并将其连接起来回答问题。首先,利用VGGNet网络提取帧级特征,利用C3D网络提取段级特征;其次,为了获得细粒度的词引导视频表示,首先,将问题单词分别处理帧级和分段级视频特征,生成词引导的帧表示和词引导的段表示;第三,为了获得粗粒度的问题引导视频表示,在第二级,对帧级视频特征和分段级视频特征对问题进行关注,分别获得问题引导的帧表示和问题引导的段表示。最后,问题对第二级特征进行注意,以获得与问题最相关的视频表示,这些视频表示用于生成最终答案。

DLAN虽然获得了一个细粒度的词级视频表示,但它忽略了需要不同出席的不同词和不需要本质出席的无意义词。论文[44]提出了异构树形结构记忆网络(HTreeMN),利用问题中的单词构造语义树。HTreeMN模型根据单词类型对树中的单词进行处理。与其他类型不同的是,视觉词在视频中是与特定区域相关的,所以只有当这些词属于视觉词时,它们才会被关注。HTreeMN的过程如下。首先,将节点分为叶节点、中间节点和根节点三类。叶节点对应于问题中的单词。由当前节点的单词参与的视频输出一个单词引导的视频表示。其次,中间节点对应着NP、VP、NN等句子中间表示。其注意结果是所有子节点注意的累积。根节点的计算方法与此相同。HTreeMN模型利用语法树结构属性,将单词组合成短语,再组合成句子。最后,使用softmax函数根据根节点的注意力生成最终答案。本文的贡献是通过注意融合的方法将单词以叶到根的方式传播,从而理解问题和视频之间的语义信息。

论文[34]提出了一种通过多任务学习获取多模态视频质量额外监督的方法。该方法由三个主要部分组成:

(1)基于视频特征、字幕特征、问题和候选答案的多模态视频qa网络预测答案;

(2)时间定位网络,根据问题定位视频的开始时间和结束时间;

(3)模态比对网络正确关联视频特征和字幕特征。

该多模态视频问答网络提出了一种上下文-查询关注层,将问题和候选答案表示为参与视频特征的查询,得到问题引导的视频表示和答案引导的视频表示。同时,上下文-查询层将问题和候选答案表示为参加字幕的查询,得到问题引导的字幕表示和答案引导的字幕表示。将问题引导的表示和答案引导的表示融合起来预测最终答案。本文的贡献是与VideoQA网络的高层共享参数,并提供额外的协作学习信号,以提高回答问题的性能。单跳问题引导注意模型如表12所示。

3.2.2 Multi-hop question-guided attention model

图6展示了多跳问题引导注意模型的体系结构,该模型以问题q为查询对象,在视频v上迭代执行注意。在上述注意过程中,模型使用多跳查询逐步细化视频上的注意。多跳模型使答案比单跳模型更准确。随着跳数的增加,准确性也会提高。已知第k - 1次注意的结果yzk−1(Q;V),一个多跳模型可以表示为:

其中u0用问题q初始化,uk通过汇总uk−1和yzk−1(Q;V)进行更新,更新后的uk用于检索相关视频。在处理复杂的时间推理任务时,多跳问题引导注意模型能够在多次跳后成功定位答案。VideoQA中的多跳问题引导注意模型总结在表13中,我们将在下文中详细讨论每篇论文。

文献[65]提出了一种解决视频qa任务的注意框架。该框架由时间注意模型、时空注意模型和全局上下文嵌入模型三部分组成。时间注意模型将问题视为查询,在帧级视频特征上进行单跳注意,得到问题引导的视频表示。为了更好地定位视频区域,采用了多跳时间注意模型。时空注意模型将问题作为查询对视频区域级特征进行注意,并在每一帧中获得标记的区域级特征。与通过注意力模型获得的视频特征相比,全局上下文嵌入模型捕获全局视频特征,然后将视频特征输入到由两层MLP组成的网络中。论文[56]提出了一种属性增强注意网络(r-ANL),通过多步推理生成答案。类似于paper[65],不同的是,提取视频中的属性标签来迭代关注视频。

论文[45]提出了**具有多步推理的多回合层次注意上下文网络(MHACN)**来解决多回合视频问答任务。MHACN模型根据视频生成答案,与给定的问题和对话语境相关联。会话上下文包含多组问答对。首先,利用问题对对话语境进行注意,得到问句引导的对话表征。MHACN将问题和问题引导的对话表征进行了归纳,得到了情境感知的问题表征。其次,利用上下文感知的问题表征对框架中的区域级特征进行空间注意,获得其问题引导的框架级视频表征;第三,利用情境感知的问题表征分别对问题引导的帧级视频特征和分段级视频特征进行时间注意,以学习上述两种问题引导的问题表征。最后,为了更好地定位视频中的目标区域,使用多跳推理过程生成最终的视频表示来预测答案。论文[46]的思路与[45]相同,不同的是它使用了基于增强解码器网络的问题引导视频表示来生成答案。

与以往的多跳推理不同,论文在[57]中提出了ta-GRU网络,它可以随着时间戳扩展推理。taGRU网络是一种改进的GRU网络,其隐藏状态转移过程与时间注意相关。首先,利用问题对区域级视频特征进行注意,以获得问题引导的视频表示。然后,将区域和问题引导的视频表示连接到ta-GRU网络中。第三,利用问题生成当前状态和之前所有升级后的隐藏状态的注意权重,得到最终的隐藏状态。最后,用ta-GRU的最终隐藏状态来预测最终答案。

论文[58]提出了一个端到端层次结构的视频qa模型,该模型由一个基于剪辑的关系网络(CRN)和一个记忆-注意组合网络(MAC)组成,用于预测答案。首先,对于视频表示,CRN将问题作为查询,对剪辑级特征进行注意,获得问题引导的视频表示。同时,它也适用于对象、动作和时空信息中的关系。然后,将问题引导的视频表示作为知识库输入MAC。MAC协同控制单元、读单元和写单元对知识库进行迭代操作推理,从而计算出中间推理结果。最后,利用MAC的最终输出表示来生成答案。

论文[59]提出了一种新的高级概念词检测器,该检测器以视频和相关问题作为输入,为每个视频生成高级概念词列表。采用软注意模型的LSTM网络检测跨帧区域一致出现的概念词。概念追踪语义注意网络(CT-SAN)是一个具有多步推理能力的语义注意模型,由两种语义注意功能组成。将t - 1时间步的预测标签作为输入语义注意功能的输入,对概念词进行注意,得到了t时间步的标签引导的概念词表征。将隐藏状态的atttime步长和视频作为输出语义注意函数的输入,对概念词进行注意,得到视频引导的概念词表征。输入和输出语义注意函数协同工作,通过多跳迭代推理得到最终预测词。

3.2.3 Video-question co-attention model

视频-问题共同注意模型同时处理视频和问题,通过共同学习两者的注意权重来捕获视频和问题之间的交互。视频-问题共同注意模型是一个对称模型,其结构如图7所示。问题引导的视频注意模型将问题作为查询表示,对视频特征{v1,v2,…,vn}进行注意,其中n为帧数。与此同时,视频引导的问题注意模型使用视频作为查询的表示来对问题特征{q1,q2,…,qm}(其中m为单词数)进行注意。问题引导的视频注意可以减少视频中与问题无关的冗余信息。获得的视频显示了“往哪里看”。视频引导的问题注意还可以减少问题中与视频无关的冗余信息:

所以它揭示了“该听哪些词”。然后融合问题引导的视频表示c和视频引导的问题表示u作为回答问题的重要表示。视频-问题共同注意模型表示为:

其中Wa和Wb是权矩阵。VideoQA中的视频-问题共同注意模型如表14所示,下面我们将对每篇论文进行详细讨论。

[47]论文提出了re-watcher模型和re-reader模型,并将其结合到遗忘-watcher模型中,以更好地利用视频的时间信息和答案的短语信息。首先,该模型将问题与其对应的候选答案连接成一个QA句子。使用两种独立的双lstm将QA语句和视频编码到联合特征空间中。然后,将QA语句和视频信息输入到再观看模型中,输出问题引导的视频表示。重看模式模仿了一个人,这个人需要反复阅读问题来记住视频内容。再次,将QA语句和视频信息输入到再读模型中,输出视频引导的问题表征。重复阅读模式模仿了一个需要反复观看视频来记住问题的人。最后,将rewatcher模型和rereader模型结合到遗忘-观察者模型中,得到当前候选答案的得分。

论文[35]提出了一种多粒度时间注意网络(MGTA-Net),该网络通过共同注意模型学习多粒度视频和问题特征,获得与答案相关的全局和部分视频信息。基于对象级视频特征、帧级视频特征和问题特征,构建了细粒度对象协同注意模型和粗粒度视频协同注意模型。细粒度对象共同注意模型同时处理对象级视频特征和问题,并共同学习它们的注意权值,以捕获它们之间的交互。粗粒度视频协同注意模型同时处理帧级视频特征和问题,并共同学习它们的注意权值来捕获它们之间的交互。最后,将细粒度和粗粒度的对象表示融合在一起来预测答案。

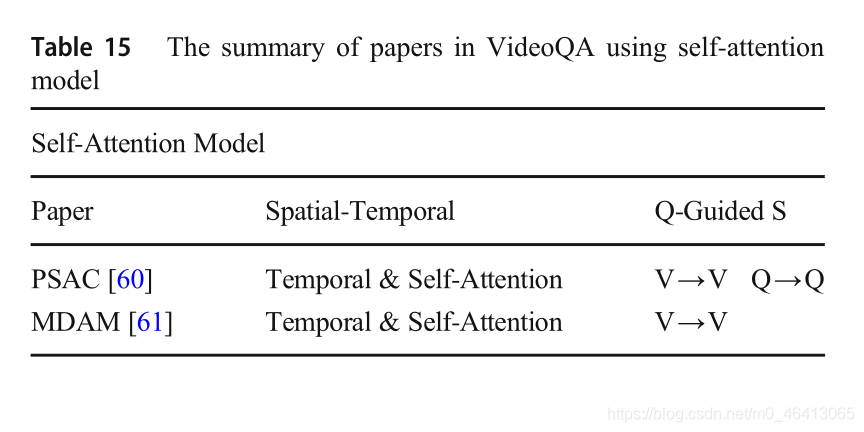

3.2.4 Self-attention model

自我注意模型已经成功地应用于机器翻译、语言理解、图像生成和问题回答等多种任务中[94-99]。自我注意模型不同于前面提到的其他注意模型,它通过以相同的顺序参与所有位置来计算每个位置的权重分布。在自我注意模型中,键、值和查询来自相同的序列,即query = key = value。图8显示了自我注意模型的体系结构。视频特征vi .参加视频特征v.自我注意的表征为:

其中1/√dk 为比例因子,Q、K、V分别表示查询、键、值。自我注意应用规模化的点积注意,多头自我注意应用规模化的点积注意并行运行。多头自我注意的表示形式为:

其中投影为参数矩阵WO;WQ i;WK i;WV i.多头自我注意模型将查询、键和值投影h次,以捕捉远距离依赖关系和位置信息。因此,它提高了理解相同序列中位置相关性的能力。VideoQA中的自我注意模型总结在表15中,我们将在下文中详细讨论每一篇论文。

论文[60]提出了一个带有注意的位置自我注意模型。位置自我注意模型计算同一序列内所有位置的注意力在每个位置上的权重分布,然后加入绝对位置的表示。共同注意模型同时对视频和问题进行注意。首先,PSAC对视频进行位置自我注意,得到位置自我注意的视觉特征;其次,PSAC对问题进行了位置自我注意,获得了位置自我出席问题的特征。为了共同注意来自不同位置不同子空间的信息,位置自我注意采用了l尺度的点积注意。然后,基于视频特征和问题特征构建相似矩阵,生成问题引导和视频引导的问题表示。最后,将位置自出席视觉特征与两种表征相结合,预测最终答案。

文献[61]提出了一种多模态双注意记忆(MDAM)模型,该模型利用自我注意学习框架和字幕中的潜在概念。首先,自我注意模型利用一个多头自我注意来获取潜在变量,使每个帧和字幕关注包括自己在内的所有帧和字幕。其次,将这些潜在变量组合起来生成输出张量。将输出张量输入到多点问题引导的注意模型中,得到视频表示和标题表示。然后,利用该问题对视频和字幕表示进行融合,得到一种多模态融合表示。最后,利用多模态融合表示和候选答案计算得分,得到最终预测答案。

3.3 Memory network

在长序列学习中,模型通常需要记住视频的内容,并在很长一段时间内准确地找到与给定问题相关的内容,从而推断出答案。因此,建立一个能够描述视频内容长期依赖性的模型是非常重要的,但也是具有挑战性的。现有的大多数机器学习模型都缺乏能够容易读写的长期记忆组件,并且可以与推理无缝结合。虽然rnn可以根据输入序列进行预测,但其内存(由隐藏状态和权值编码)通常太小,无法准确记住视频内容。

为了解决上述问题,论文[100]提出了一种新的学习模型,称为记忆网络(memory networks, MemNN),其核心思想是构建一个可以读写的记忆组件。然后,将MemNN与成功的机器学习推理模型相结合。在那之后,这个模型被训练来学习如何有效地利用记忆组件。MemNN在每次迭代时都需要由相应的支持事实进行监督,而大多数数据集仅由问答对的形式组成。

因此,论文[101]提出了端到端记忆网络(MemN2N),该网络可以从输入-输出对进行端到端的训练。因此,该模型需要较少的监督培训,更适合实际环境。此外,MemN2N也被扩展来处理多跳操作。随着跳数的增加,模型的泛化性能有所提高。

文献[102]提出了动态记忆网络(DMN)。DMN包括情景记忆模块,情景记忆模块由注意模型和循环网络组成。它可以通过多次迭代进行更新。该模块将问题、之前的记忆和客观事实作为当前迭代的输入,然后在每次迭代中更新情景记忆单元,获得当前的记忆。存储网络在VideoQA中的应用总结在表16中,我们将在下文中详细讨论每一篇论文。

3.3.1 Memory networks

MemNN由一个记忆数组M和四个可学习的成分组成:输入特征映射、泛化、输出特征映射和响应。记忆数组M是用来存储整个视频内容的数组,它可以保留视频序列的长期记忆作为知识库。然后,记忆可以用来推断一个给定问题的答案。输入特征映射组件提取视频特征和问题特征,这在前面2.2节和2.3节中提到过。泛化组件接受将存储在内存数组中的内容作为输入,并根据它更新内存数组。在这个过程中,存储阵列可以按顺序更新,也可以通过复杂的操作进行广义化,如通过非线性映射更新。输出特征映射组件根据查询结果和当前内存数组状态进行推理,得到特征空间中的上下文表示。响应组件将上下文表示转换为预期的答案。具体过程见2.4.1节。存储网络的总体结构如图9所示。然后,介绍了在视频qa研究中起着重要作用的记忆网络。

论文[23]提出了一种深度嵌入式存储网络(DEMN)模型,该模型对存储网络的泛化成分进行了改进。它使该组件能够根据视频特征和与视频相对应的字幕特征生成故事描述。然后,泛化组件将故事描述按顺序存储到内存数组M中。内存数组被定义为一个故事集,它代表整个视频内容。之后,输出特征映射组件使用问题引导的注意模型来寻找与问题最相关的故事的∗。最后,将s∗与问题连接起来,得到sa作为响应组件的输入。反应成分使用注意模型对sa与每个候选答案句子ai的匹配进行评分,然后选择得分最高的候选答案作为最终预测答案。

论文[54]提出了遗忘记忆网络(FMN)模型。FMN修改内存网络的输出特征映射组件。根据输入的问题,修改后的组件可以专注于视频中与问题相关的部分,而忽略其他不相关的部分。FMN在内存数组中按顺序存储区域级特性。输出特征映射组件首先计算存储数组的内积和获取区域级特征权重的问题。然后,该分量通过计算top-k区域特征的加权和得到问题引导的视频表示。最后,融合视频特征和问题特征作为响应分量的输入来预测答案。之后,[54]又提出了一种基于FMN的扩展遗忘记忆网络(e -FMN)模型。E-FMN利用GRU模型对视频帧进行编码,而不是简单地求和,从而有效地捕捉视频中的时间信息。论文[48]pro对FMN模型和E-FMN模型提出了两个改进。一方面,与仅使用视频剪辑来解决VideoQA任务相比,将视频剪辑和文本特征融合在一起可以获得更好的性能。另一方面,选择权重的中位数来忽略无用或不相关的信息。

不同于以往将视频特征按顺序存储在存储阵列中的模型,论文[49]利用注意模型将每个输入特征分配给所有的存储单元,这些输入特征被视为上下文感知的视频特征和问题特征。由于简单的异构数据组合不能有效地表示视频内容,提出异构视频记忆学习运动和外观的共同注意,从而获得视频表示,增强推理能力。异构视频存储器的存储器结构包括用于存储视频内容的存储器阵列,以及用于确定如何将视频内容写入存储器的三种隐藏状态。此外,还设计了写操作、读操作和隐藏状态更新操作来有效地读写内存数组的内容。写操作分别输入外观和运动,根据隐藏状态分别计算外观、运动和记忆数组的权值,然后根据权值更新记忆数组的内容。读取操作根据所述隐藏状态和所述外观和动作内容,确定每个存储单元的权重。然后,它根据权重从内存数组中读取并融合内容,以获得上下文表示。隐藏状态更新操作根据当前隐藏状态和上下文表示更新隐藏状态。在此基础上,外部问题记忆采用与问题相似的处理方法来获得其表征。然后通过时间注意和LSTM的多步推理实现上下文和问题的多模态融合。最后,根据问题生成答案。

文献[62]提出了一种读写内存网络(RWMN)模型。RWMN将内存网络的泛化部分修改为写网络和读网络。首先,RWMN将视频特性按顺序存储到存储器阵列中。然后,RWMN设计了一个由多个卷积层组成的写网络,使每个存储单元与相邻的视频特征相关联。然后RWMN设计了一个读入问题的网络,提高了存储阵列和问题之间的相关性,使后续的推理更加准确。读网络首先通过微型断路器将问题的特性集成到存储器阵列中。然后,read网络通过多个卷积层对一系列场景进行连接和关联,以改善对问题的理解,提高预测精度。最后,读取网络得到一个重构的存储阵列,用来推断正确的答案。RWMN的输入与[23]相似,推理和回答预测部分与MemNN相似。RWMN与其他内存网络模型的不同之处在于,RWMN的内存阵列的维数在更新过程中会变小,而其他模型的内存阵列的维数是静态的。

3.3.2 End-to-end memory networks

MemN2N的架构与MemNN相似。而MemN2N改变了存储阵列的结构和推理过程,增强了模型的连续性。因此,MemN2N可以从输入-输出对端到端的训练,并显著减少了训练过程中必要的监督,以适用于现实应用。

MemN2N的特点是它使用两个内存数组来转换输入序列。一个是用于记忆内容信息的存储器阵列mv,另一个是用于推理生成输出的输出存储器。具体来说,MemN2N可分为输入内存表示、输出内存表示和最终预测生成三个模块。输入存储表示模块首先使用嵌入矩阵A将输入序列转换为存储阵列mvat。该模块还使用嵌入矩阵B将问题嵌入得到内部状态u,然后计算问题内部状态与内存mv之间的匹配权值p,如下所示:

其中N是输入序列和存储数组的长度。输出存储表示模块首先利用嵌入矩阵c将输入序列转换成输出存储阵列mo,然后将输出存储阵列mo与匹配权值p加权求和得到响应向量c,如下所示:

论文[19]将原有的MemN2N模型应用于VideoQA任务的MovieQA数据集,并根据MovieQA的特点,提出了MemN2N的两个关键修改。第一个关键修改是增加了额外的嵌入层F来映射多个选项,使MemN2N模型能够从多个选项中预测出正确的选项。然后,该模型计算候选答案、问题u和输出结果之间的相似度来预测答案。由于VideoQA中的数据非常大,像原来的MemN2N那样直接学习不同的嵌入矩阵会导致整个网络中有大量的参数。虽然共享所有不同嵌入矩阵的参数是可行的,但参数的数量仍然很大。因此,提出了第二种关键修改方法,即使用Word2Vec预先训练的嵌入矩阵Z替换原始网络中的所有嵌入矩阵,使用共享的线性投影T将视频和问题映射到同一个低维空间。这种改进有效地减少了需要训练的参数数量,提高了学习效率。

论文[50]采用了多跳MemN2N模型,并对模型的输入进行了修改,得到了扩展端到端存储网络(E-MN)模型,该模型能够捕捉连续帧中动作之间的时间关系。利用一组帧序列作为输入,采用双lstm对序列进行编码。然后将编码后的序列输入到模型中,提高了模型对时间信息的分析能力,以适应视频质量保证的要求。

3.3.3 Dynamic memory networks

与MemNN和MemN2N不同,DMN在情景记忆模块中修改泛化、输出特征映射和记忆数组,使记忆数组可以由问题动态更新。DMN由四个模块组成,输入模块、问题模块、情景记忆模块输入特征图输入特征图综合输出特征图反应记忆阵列···视频问题图9记忆网络框架该模型首先使用输入特征映射组件生成视频特征v和问题特征q,然后使用泛化方法将视频特征存储到存储阵列mv中。然后,将mv和q输入到输出特征映射组件中,得到上下文表示O。最后,响应组件输入O,得到预测答案b。像MemNN的输入特性映射组件,输入模块使用格勒乌编码输入序列{x1, x2,…,xn}到事实表示{c1, c2,…,cn},问问题模块编码问题表示。迭代更新记忆过程是由q在情景记忆模块。将事实表征{c1,c2,…,cn}和问题表征q输入情景记忆模块,情景记忆模块使用q初始化情景记忆m0=q。在第i次迭代中,情景记忆模块使用GRU来更新情景记忆:

其中⊙是元素的乘积,“;”是连接操作。使用情景记忆来预测答案的答案模块与MemNN的反应模块相似。答案模块在情景记忆模块的末尾或每次更新操作之后被触发。综上所述,DMN的内存数组在推理过程中是动态的,而MemNN和MemN2N的内存数组是静态的。论文[35]相信动态记忆可以检索一些信息,被认为是不相关的在以前的迭代,以实现更好的推理。视频QA DMN框架如图12所示。接下来,我们将通过论文阐述如何将DMN的思想应用到视频qa中。

论文[63]建立了一种适用于视频qa的DMN网络。它对输入模块进行了修改,将情景记忆模块变为动作表象共同记忆模块。改进后的输入模块包含多个时间卷积层,用于建模时间上下文信息,以及多个反卷积层,用于恢复时间分辨率。该模型可以建立多层次的时态表示,每一层表示不同的上下文信息。输入模块分别应用于运动和外观,以获得运动的上下文事实和外观的co textual facts。运动-外观共同记忆模块包含两个单独的记忆阵列,一个用于运动,另一个用于外观。运动-外观共同记忆模块的每次迭代包括三个步骤,共同记忆注意力、动态事实集成和记忆更新。共同记忆注意分别利用先前的运动记忆、先前的外表记忆和疑问对运动事实和外表事实进行注意,得到运动注意门和外表注意门。动态事实集成根据相应的关注门获取事实的权重,然后对事实进行加权求和,得到整体事实。记忆更新使用基于注意的GRU将集成事实和相应的注意门编码为当前的上下文事实,通过这些事实来更新记忆数组。最后,运动-表象共记忆模块将运动记忆和表象记忆连接起来,得到共同记忆。然后,回答模块使用内存来预测答案。通过上述修改,模型不仅可以关注问题所涉及的不同时间特征,还可以根据需要关注外观或运动信息。

论文[51]提出了一种分层记忆网络(LMN)模型,该模型结合了视频内容和字幕,提高了答案预测的性能。LMN的存储模块由静态字存储和动态字幕存储两部分组成,可以学习分层视频表示。LMN有两个版本,单跳和多跳。在单跳算法中,静态词存储器的词存储数组存储了整个数据集中的所有词,用于学习区域的语义表示。该方法利用一帧内的所有区域,计算每个区域特征与单词存储数组中每个单词的相似度,得到每个单词的权重。然后,LMN对所有词进行加权求和,更新区域特征。然后,将每一帧的区域特征相加得到帧的表示。动态字幕存储器中的字幕存储数组以句子的形式存储字幕,用于表示剪辑。动态字幕存储器以帧的表示作为输入,计算存储数组中每一帧与每句话的相似度,得到每个字幕的权重。然后,该模块对字幕进行加权求和来更新帧表示,对帧表示进行加权求和得到剪辑表示。最后,单跳LMN使用片段表示、问题和候选答案来预测正确答案。在多跳中,静态词存储模块只计算前一跳的区域表示与当前词的相似度来得到当前的区域表示,而词存储数组没有更新。在完成最后一跳后,通过区域特征的加权和得到帧的表示。与单跳不同的是,多跳动态字幕存储模块利用当前的字幕存储和视频表示生成下一跳的字幕存储。通过这样做,模块消除了不相关的字幕信息,提高了推理能力。一般来说,单跳LMN的单词记忆和字幕记忆对于视频来说都是静态的,所以我们认为单跳LMN模型是MemNN的一种变体。虽然多跳LMN的词存储是静态的,但字幕存储是通过视频的帧表示动态更新的,因此多跳LMN模型被认为是DMN的变体。

论文[52]在[51]的LMN模型的基础上,增加了一个plot graph representation network (PGRN),并引入了一个新的数据集PlotGraphs作为外部知识。PGRN用图形表示视频内容(如人物、情节等)之间的语义信息和关系。认为结合LMN和PGRN可以更充分地表达视频内容,并用于推理。PGRN包含多个节点,表示情节、角色、属性、位置、时间、运动和原因。由于属性节点只与人物相关,位置、时间、运动、原因等节点与情节相关,因此PGRN将它们分别进行融合,得到人物表示和情节表示。此外,角色往往与许多其他情节节点有关系,所以PGRN将情节作为图的中心。然后,PGRN得到了包含节点语义信息和节点之间关系的整个图的表示。由于图的描述可能包含与问题无关的冗余信息,PGRN需要根据问题计算图的权重,并根据权重更新图的表示。最后,将LMN得到的视频内容与PGRN得到的图形表示进行融合,并用于预测答案。

论文[55]提出了渐进注意记忆网络(PAMN)模型。该系统包含四个模块:双记忆嵌入、渐进注意、动态模态融合和信念修正回答方案。双存储嵌入模块利用前馈神经网络(FFN)将视频和字幕分别嵌入到相应的存储阵列中。渐进注意模块以视频记忆、字幕记忆、问题表征和答案为输入,通过基于问题和答案的注意模型对视频记忆和字幕记忆进行迭代更新。这个模块通过积累线索来定位回答问题的相关时间点,并从记忆中过滤出对问题不必要的信息。在注意模型对每个存储阵列进行每个更新周期后,动态模态融合模块根据两个存储阵列与问题之间的相关性,对两个存储阵列进行权重赋值。然后通过权重对视频和字幕进行融合,得到视频的融合内存。信念修正答疑方案利用信念来衡量每个考生答案的信度。对信念进行等概率初始化,并根据问题与候选答案之间的相关性进行第一次修正。然后,在迭代过程中利用融合记忆对信念进行动态修正。信念修正回答方案可以通过每次迭代连续预测答案,而不是在其他模型中只预测一次答案。使推理结果更加准确可靠。

3.4 Other methods

在以上三节中,根据核心处理模型的特点,详细介绍了核心处理模型的三种类型。但也有一些模型有自己独特的想法,一般不能将其划分为以上几类。这些论文的摘要见表17。

受生成式对抗网络[103]的启发,论文[20]提出了一种对抗式多模态网络(AMN)模型,并将自我注意模型引入其中。AMN为视频特征和相应的文本特征找到一个一致的子空间来获得多模态特征表示,并保持多模态表示与原始视频之间的自相关性。AMN由三部分组成:对抗性多模态表征学习、基于自我注意的一致性约束和答案推理。对抗多模态表示学习是基于生成式对抗网络的思想设计的,生成式对抗网络由一个生成器和一个鉴别器组成。该算法用于寻找视频特征与相应文本特征之间具有高相关性的子空间。该生成器由两个不同的注意模型组成,用于学习视频的多模态表示。第一个注意模型将视频的区域特征映射到一个单词空间中,并将所有区域特征相加得到帧特征。第二种注意模型将帧特征映射到字幕空间,得到视频特征。训练识别器将视频的文本特征与生成器学习到的多模态表示区分开来。针对多模态表示产生时可能丢失信息的问题,提出了基于自我注意的一致性约束。由于原始视频和多模态表示的维数不同,AMN引入了自我注意模型将两个表示映射到一个固定的空间中。答案推理采用多模态表示、问题和候选答案来预测答案,并更新字幕来删除字幕中的不相关信息。

论文[37]提出了一种基于基础证据的时空回答者(STAGE)模型,该模型利用时空域来回答问题。STAGE的核心思想是生成一个与问题和答案最相关的跨度提案,并用它来预测答案。这可以过滤掉无关的信息输入模块问题模块注意力模型记忆力Array1㼿㼿㼿注意力模型记忆力Array2㼿㼿㼿回答模块㼿㼿㼿视频问题图12的框架动态内存网络视频质量。该模型采用注意模型对记忆进行迭代更新。在第i个迭代,视频功能v,问问题特性和之前的内存数组mi−1作为输入的注意模型,并使用结果来更新内存数组并获取当前内存数组mi。最后,它使用最后一个内存数组mnand问移动Netw预测答案:问题,并改善预测性能。首先,STAGE通过RCNN获得视频特征,通过BERT获得文本特征,并使用卷积编码器对视频特征和文本特征进行编码。其次,STAGE利用qa引导的注意生成视频和字幕的qa引导表示,并将其融合得到融合后的视频文本表示。第三,STAGE利用线性层、卷积编码器和最大池化层得到输出特征矩阵。然后,STAGE根据输出的特征矩阵,实现一个跨度预测器,预测每个时间位置的开始和结束概率,然后应用动态规划,根据开始和结束概率生成跨度建议。最后,STAGE用输出特征矩阵生成一个全局假设表示,用span建议生成一个局部假设表示,并将它们连接起来预测正确答案。

4 Datasets

在VideoQA的大量研究工作中,已经专门为它收集了大量的数据集。我们根据视频源对现有的典型VideoQA数据集进行了广泛的分类,分为以下几类:电影类型、电视类型、TGIF类型、几何类型、游戏和卡通类型。此外,还有一些非特异性的数据集值得关注,这些数据集没有包括在本次调查中。数据集样本由一个视频剪辑、一个问题和最少正确答案组成的三部分组成。在图13中,数据集中各个类别的视频内容显示如下。以MovieQA数据集属于电影类型为例,如图13中的红框所示。它的问题和答案分别用红色和绿色标记。根据视频剪辑的长度,可以分为短视频和长视频。长视频包含了复杂而深刻的事件、动作和学习对象,其长度比短视频要长。问题通常是自然语言描述句,即文本数据。一些特殊的数据集还提供额外的文本数据,如对话、说明、故事等等。目前的题型分为开放式(OE)、多项选择(MC)和填空(FIB)。OE问题是根据视频剪辑的内容,在完整的句子系统的基础上,自动生成正确的答案。具体的例子见图14a。MC题是在对一题和多个备选答案(一般为1对4错)的情况下,选择一个准确的答案,如图14b所示。F I B问题是根据给定的视频和一个不完整的问题,从整个词汇集中找到适合空白的单词或短语,如图14c所示。为了便于读者比较和查看不同数据集之间的差异,列出了S om e di S t in ci v e数据集,如表18所示。最后,VideoQA的两个主要评估标准Acc和wops在4.7节中介绍。

4.1 Movie Types

来自LSMDC 2016数据集的 MovieFIB[53] 是针对视障人士的基于描述性视频标注修改的FIB数据集。该类型的问题是由自然语言工具包(NLTK)工具针对原始LSMDC 2016数据集提供的标注生成的,其中以名词、动词、形容词和副词词性标注的词作为空题的候选答案。问答数据集包含348998双,其中有296960在训练集,验证集,21689和30349年在测试集。由于问题生成基于注释的原始LSMDC数据集,只有浅一些视频信息,数据集需要高级的语义推理。

MovieQA[19] 是应用最广泛的数据集之一,旨在评估从视频和问题中对长篇故事的理解。该数据集包含408部电影和14944个MC问题-答案对,每个问题-答案对由五个选项组成,只有一个正确答案。此外,每个问答对都是根据模板手工生成的。为了更好地理解视频内容,该数据集还提供了与电影视频、字幕、分布式交换机、脚本和情节梗概相关的五种故事源。基于这些来源的不同组合,该数据集涉及6个子任务:(i)视频+字幕,(ii)仅字幕,(iii)仅分布式,(iv)仅脚本,(v)仅情节概要,和(vi)开放式的。在这些子任务中,第一个任务更值得注意,因为它是唯一一个需要理解视频和文本的VQA任务,而其他任务都是纯文本的。6462个问答对分别被分为4318、886和1258,分别用于训练、验证和测试集。140个电影(共6771个剪辑)被分成4385个、1098个和1288个剪辑,分别用于训练、验证和测试集。每个剪辑的长度非常长,平均长度为202秒。由于电影片段的长度,不断变化的背景和故事情节,MovieQA更注重以抽象和高层次的信息来理解故事。

LSMDC2016[104] 数据集来源于大规模电影描述挑战,基于M-VAD和MPII-MD数据集的融合。提出了电影和字幕理解的三个任务:MC、视频检索和FIB。MC任务中的正确答案来自ground truth标题,其他五个候选答案是从其他标题中随机抽取的。视频检索任务是根据给定的查询活动短语从1000个测试视频中找到相应的视频。FIB任务与上述描述相同。LSMDC数据集的训练集、验证集和组合测试集中的视频数量分别为91,908、6542和19,631。同时,组合测试集由10053个公开测试数据和9778个盲测试数据组成,盲测试集仅用于评价。与其他数据集相比,LSMDC具有更多的视频片段,更关注电影本身。

4.2 TV types

TVQA[22]数据集是一个以电视节目为视频源的大型数据集。同时,这则视频来自三种类型的6部长期播放的电视剧:(1)情景喜剧:《生活大爆炸》,《老爸老妈浪漫史》,《老友记》。医疗类剧集:《实习医生格蕾》、《豪斯医生》;(3)犯罪剧:卡塞尔。共有925集,涵盖461个小时,21793个视频剪辑产生了152545对问题。多模态问答对由Amazon Mechanical Turk工作人员根据视频和字幕,根据模板自然生成。问题模板首先使用开始时间戳和结束时间戳,根据“when / before / after”来定位与问题相关的视频片段中的相关时刻。然后构成与视频和问题理解相关的“what / how / where / why /”问题。这个问题是MC问题,平均长度为13.5个单词。它明显大于其他数据集,总共有461.2 h的视频。视频剪辑的长度平均为60 - 90秒,包含了大量关于人们活动和场景的自然信息。它还具有丰富的动态和现实的社会互动。TVQA的一个关键特性是,每个视频剪辑都有开始和结束的时间戳,以便根据问题准确定位视频剪辑的关键部分。

TVQA+[37]数据集在TVQA的基础上增加了接地边界盒,具有更多的时空关系。该算法从TVQA数据集《生活大爆炸》中选择一个电视节目作为视频源,并根据问题和正确答案逐帧添加边框。边界框是在Amazon Mechanical Turk平台上手动添加的。数据集包含4198个视频剪辑,29383个问答对,148468张图像,有310826个包围框。平均每幅图标注2.09条,每道题标注10.58条,标注种类2527种。它的独特之处在于它的问答对不仅包含时间定位,而且包含空间定位。其中最重要的是空间定位,因为它对每个视频帧中的目标区域进行了标注。VideoQA任务可以使用目标区域和属性标签特性进行训练,这样他们可以更准确地回答问题。

4.3 Open types

ActivityNet-qa[105]数据集来源于ActivityNet视频数据集,基于人们的日常生活视频。它从ActivityNet数据集的20000个视频中采样5800个视频,考虑到班级的多样性和视频数量的平衡。它包括14,429个视频剪辑,71,961个自然语言描述和130,161个问答对。主要有五种类型的问题:什么,谁,如何,在哪里,和其他。数据集的问答对是根据给定的问题模板使用现成的算法手工生成的。问题涉及三种类型:运动型问题主要要求对粗时间动作的理解;空间关系问题主要基于静态框架进行空间推理;时间关系问题验证了从一系列帧中推理对象时间关系的能力。数据集限制问题和答案的长度,以确保质量。题目最多20个字,答案最多5个字。ActivityNet-QA数据集的视频源于人们的日常生活,更加真实,因此对VideoQA有重要的影响。

4.4 TGIF types

TGIF-qa[106]数据集是一个公开的短格式TGIF数据集,它使用gif作为视频源。该数据集基于TGIF数据集提出了四种类型的任务:重复计数、重复动作、状态转换和帧QA。重复计数任务是一个关于计算一个动作的重复次数的OE问题,其答案主要在2到10之间。重复动作任务定义为识别视频中重复的动作的MC问题。状态转换任务是一个MC问题,是关于识别另一种状态之前(或之后)的状态,包括面部表情(如从悲伤到快乐)、动作(如从站立到坐)、位置(如从卧室到客厅)、物体属性(如从空到满)。这三个任务都是由模板生成的。Frame QA task是一个OE问题,主要是基于视频中的某一帧,比如ImageQA。该任务由原始TGIF数据集的描述信息自动生成。问题的类型包括类型、数量、颜色和位置。TGIF-QA数据集基于71,741个gif生成了共165,165个问题回答对。与其他数据集相比,TGIF-QA数据集是唯一的,因为它包含了更多的动词形式。理解视频片段的内容需要丰富的时空推理。

Tumblr的GIF[38]数据集与TGIFQA具有相同的来源,但问答对生成的方式不同。该数据集包括101983个视频剪辑(gif)和287,763个问答对。它分为三个部分:训练、验证和测试集。训练集包含79325个视频中的230,689个问题-答案对。验证和测试集分别有来自10,038和12,620个视频的24,696和32,378个问答对。QA对是自动生成的。问题的类型主要分为what、when、where、who、whose、how many六类。该数据集最重要的特征是在生成问答对时保证不偏倚。生成的答案的相似性非常低。此外,Tumblr GIF数据集包含单个事件,比MovieQA数据集简单,因此不需要高级别的推理。

4.5 Geometry types

SVQA[57]数据集使用关于几何变化的合成视频作为视频源,由Unity 3D生成。每个视频剪辑有3 - 8个不同形状、大小和颜色的静态或动态几何对象,其中动态几何对象有额外的动作类型和动作方向属性。基于这些属性,它可以根据对象之间特定的时空关系、相对位置和动作顺序来构造推理问题。构造的SVQA拥有12000个合成视频,并自动生成约120k个带有固定模板的问答对。为了保证生成的问题的质量,首先将少量的几何属性整合到所有候选描述中。其次,每个描述都会被检查和更正。最后,利用均衡机制使答案分布具有一定的均匀性。设计原则是解决逻辑结构的组合问题,这需要多步的推理过程。虽然SVQA数据集的视频内容与其他数据集相比还不够充分,但回答这个问题需要对时空关系有更强的推断。

MarioQA[65]数据集使用名为《无限马里奥兄弟》(Infinite Mario Bros)的游戏视频作为其视频源,《无限马里奥兄弟》是《超级马里奥兄弟》的变体。它收集了13小时的超级马里奥游戏,生成带有事件日志的视频片段,并根据手工构建的模板,从抽取的事件中自动生成187,757个问答对。每个视频剪辑平均包含11.3个事件。问答组合是基于不同的事件生成的,包括E = {kill, die, jump, hit, break, appear, shoot, throw, kick, hold, eat}。生成的问题仍然分为三种类型——以事件为中心的问题、计数问题和状态问题。根据时间关系将MarioQA数据集构造为三个子集。没有时间关系(NT):在整个视频中有78297个NT的例子,它们更关心没有任何时间关系短语的独特事件。简单时间关系(ET):有64,619个ET例子包含关于全球独特事件的问题。以上两种类型很容易回答。硬时间关系(HT):有44,841个HT的例子涉及干扰事件,使VQA系统根据时间推理从多个相同的事件中找到正确答案。为了保证问题的推理性和答案的清晰度,删除了一些需要额外信息推理的问题,以保证数据集的质量。MarioQA数据集的特征是具有多个事件和时间依赖性的大量视频。游戏视频中事件的发生是清晰的,不会让人感到暧昧,所以很容易在游戏视频中学习完整的语义信息。

**PororoQA[23]**视频来源于广受欢迎的儿童卡通系列视频。该数据集包含20.5 h视频的16066对场景-对话,27328个细粒度场景描述句子和8913个故事相关的问答对。描述句和问答对是在Amazon Mechanical Turk (AMT)平台上手工收集的。在场景描述中,移动网络应用的平均句数和单词数分别为1.7和13.6。它拥有大量的支持事实标签,表明在每个视频剪辑中链接框架和标题,以更正答案信息和描述文本。由于PororoQA使用卡通视频作为视频素材,所以视频内容简单明了,故事结构连贯。与戏剧或电影相比,环境也很小。此外,由于高质量的场景描述,也涉及到高水平的视频分析。

4.7 Evaluation criterion

根据题型不同,不同的题型对应不同的评价方法。有两种流行的方法,精度(Acc)和Wu-Palmer相似度(waps)。Acc是答对题数占答对题总数的比例。它是最广泛的用于衡量分类任务的性能。公式如下:

其中qt为问题的数量,N为答案的大小。其中ti代表ground truth答案,ai代表VideoQA模型预测的答案。1[·]是一个指示函数,只有当tiai完全相同时,样本的精度为1,0 o the r w is e。但是对于OE问题,Acc不能直接用来评价两个短语之间的相似度。waps用于评估OE问题,它衡量基于语义差异的预测答案与ground truth的差异程度。根据分类树中两个词的最长公共子序列计算相似度。如果预测词与ground truth答案词的相似度低于阈值,则候选答案的得分为0。当阈值设置为0.0时,表示为WUPS@0.0。当阈值设置为0.9时,也可以表示为WUPS@0.9。公式如下:

其中WUPγ(任意性)[107]通过WordNet[108]计算单词相似度。其中N为题数,A= {a1,a2,…,aN}为模型预测的答案,T={t1,t2,…,tN}为ground truth答案。符号ak表示预测句的第k个单词,tk表示地真句的第k个单词。

5 Discussions

5.1 Experimental results and analysis

在MovieQA、TGIF-QA和SVQA三个基准数据集上进行了实验,并对实验结果进行了分析和描述。MovieQA是一个MC问题数据集。“Video + Subtitle”任务在验证和测试集上的实验结果如表19所示。对实验结果进行了精度排序。作为竞争基线网络,DEMN在验证集(44.7%)和测试集(29.97%)上取得了结果。RWMN明显优于DEMN的29.97%。RWMN不仅在提高电影理解方面起着至关重要的作用,而且体现了RWMN在处理高级推理问题方面的优越性。LMN采用了更新机制和问题引导注意模型,使字幕记忆与问题更加相关。此外,LMN具有良好的可扩展性。MDAM通过后期融合避免了早期融合的过拟合现象,并利用自我注意模型提高了%5的准确率。A2A模型探索了理解电影的高水平、多模态注意模型,并采用了一种新的词嵌入方法对词汇外的词进行跟踪。与LMN模型相比,基于动态推理的PAMN模型得到了更准确、更可靠的答案。目前,AMN的测试准确率达到了45.31%,表明基于GAN和一致性约束的多模态表示学习提高了有效性和泛化能力。我们在表20中显示了在TGIFQA数据集上的结果比较。TGIF-QA包括以下四项任务。重复动作(action)和状态转换(Trans)是多项选择题,重复计数(count)和框架问答(FrameQA)是开放式问题。实验采用准确性评价重复动作、状态转换和框架QA问题,采用损失值评价重复计数任务。正如所预料的那样,随机机会法比其他方法表现最差,因为它是模仿一个人随机猜答案。在重复计数和重复动作任务方面,论文[49]分别比其他方法获得了最低的L2平均损耗和最高的准确率。在状态转换和帧质量保证任务中,CRN + MAC®移动网络应用的准确率分别为0.787和0.592,显著优于其他方法。结果表明,多步推理有助于提高视频质量评价的准确性。

我们总结了SVQA数据集的实验结果,该数据集具有很强的时空关系推理能力。开放性问题的比较结果见表21。ST-VQA-Tp的性能不如其他算法,因为它只使用单跳时间注意模型。大量的时间视觉线索丢失了。r-STAN被过度拟合所困扰。统一att的问题是传统的GRU不能很好地捕捉长期的时间依赖性。此外,E-SA相对于E-VQA的改进证明了注意模型在视频qa中起着至关重要的作用。SA + TA-GRU的空间注意机制优于E-VQA和Unified-Att。这表明TA-GRU能够捕获更完整、更长期的时间视觉线索。CRN + MAC实现了最先进的结果,从44.9%大幅提高到75.8%。由于SVQA数据集中的问题是为多步推理而设计的,因此具有双处理系统的CRN + MAC在推理过程中是有效的。

5.2 Directions for future work and challenges

VideoQA的研究是推动计算机视觉和自然语言处理研究领域发展的一项重要而具有挑战性的任务。然而,仍有大量的空间进行进一步的研究和性能改进。因此,本文从视频qa发展的角度,总结了视频qa领域尚未解决的问题,并指出了未来工作的方向。

- 实现多模态间的交互 。VideoQA任务是一个跨模态任务,它支持在不同模式之间进行解释、对齐和融合。但在以往的研究中,大多只使用视频和问题来回答问题,很少考虑音频。因此,利用音频、视频和问题的多模态交互,有助于学习鲁棒的多模态表示。

- 细粒度和粗粒度特征的分析。为了捕获视频的局部属性(例如,行人的布料类型),细粒度特征在理解视频内容方面比粗粒度特征表现得更好。相比之下,粗粒度的特征更擅长捕捉视频的全局属性(例如,环境)。此外,细粒度和粗粒度的特征都需要解决视频QA任务与合理的融合。

- 转移学习。由于VideoQA太复杂,无法在有限的数据集中描述,所以学习一个VideoQA数据集中的通用模式非常重要,这些模式可以很好地用于另一个VideoQA数据集。如何将迁移学习应用到VideoQA中是训练鲁棒模型的关键问题。

- 建立标准基准数据集。尽管许多论文报告了相对较好的结果,但很难做到比较不同的模型,因为它们在数据资源和问答对生成方面存在差异。因此,可以对标准基准数据集进行进一步的研究,以促进VideoQA的发展。

- VideoQA模型的可视可解释性。由于缺乏可解释性,VideoQA模型的结果一直不被信任。因此,利用可视化工具来检查VideoQA模型的内部工作就显得尤为重要。

- 用几个训练示例训练一个模型。对于VideoQA来说,一个常见的挑战是用很少的训练例子来训练一个表现良好的深度学习模型。在今后的工作中,建议采用元学习和少镜头学习来解决这一问题。

- 优化的培训。常用的基于最大似然估计训练的视频qa网络使网络处于次优状态。为了提高训练效率,在今后的工作中可以考虑强化学习框架的研究。

6 Conclusion

VideoQA在计算机视觉和自然语言处理中扮演着重要的角色。它可以根据视频内容自动回答自然语言问题。视频质量检测中运用了许多人工智能技术,如目标检测与分割、特征提取、内容理解、分类等。VideoQA的研究界在很大程度上促进了人工智能的发展。在这项调查中,对VideoQA进行了系统和全面的回顾。我们提出了一个理解VideoQA的总体框架,并回顾了构建视频和问题之间的交互表示以回答问题的最流行的方法。我们描述了core processing model中同类型方法的其他改进,并强调了它们在思想和应用上的差异。此外,我们回顾了基准数据集和评价标准,并分析了在这些数据集上的实验结果。未来的研究工作将需要视频qa。迁移学习、元学习和视觉工具等有希望的发展方向有望提高视频qa的性能。 我们相信,未来在这些问题上的工作将有助于VideoQA的更多改进。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?