题主本科课程作业涉及西瓜书课后题,本篇主要包括第5-8章除编程题以外的课后题,订正后整理如下:(如有不完善处,欢迎评论讨论)

5.1、5.2、5.3、5.4;

6.1、6.4、6.5、6.6;

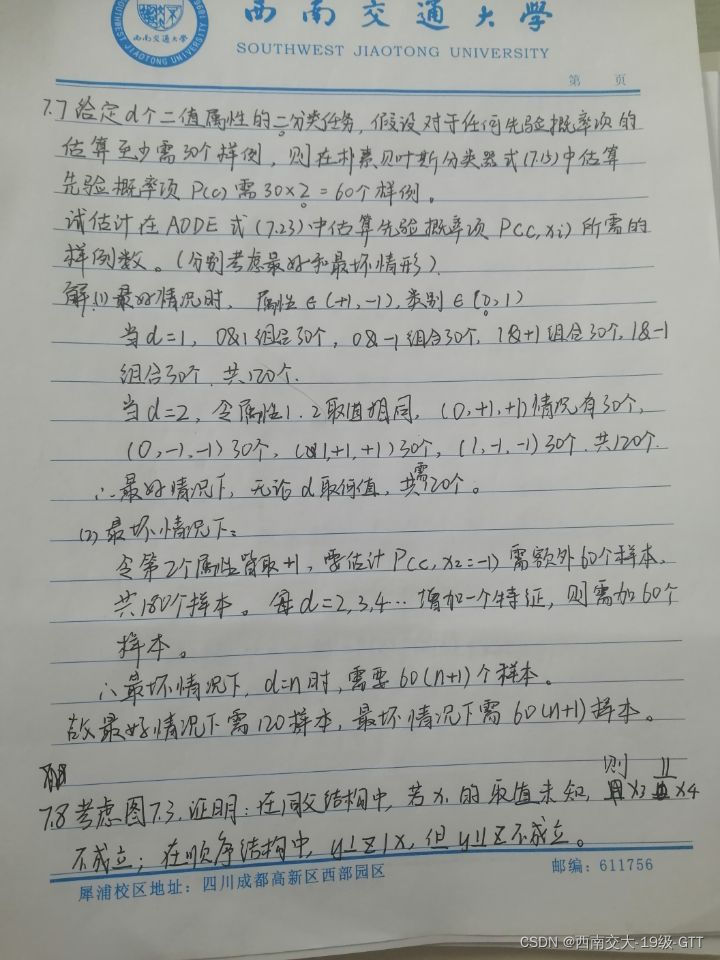

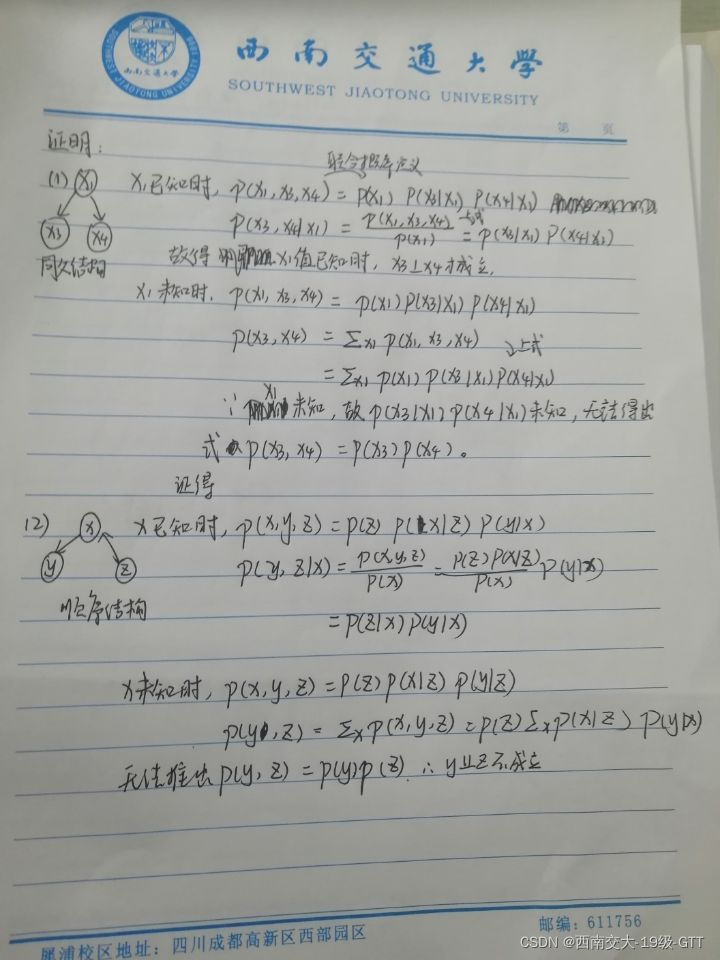

7.4、7.5、7.7、7.8;

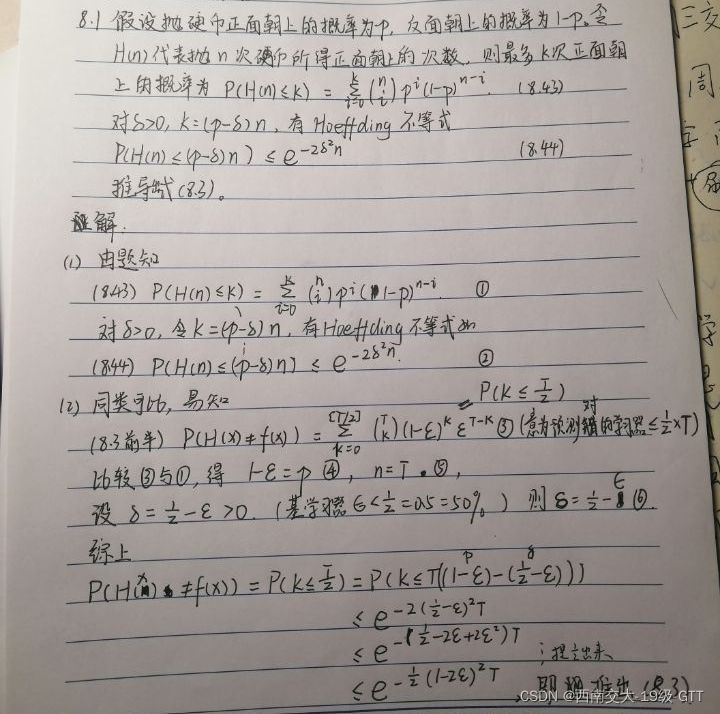

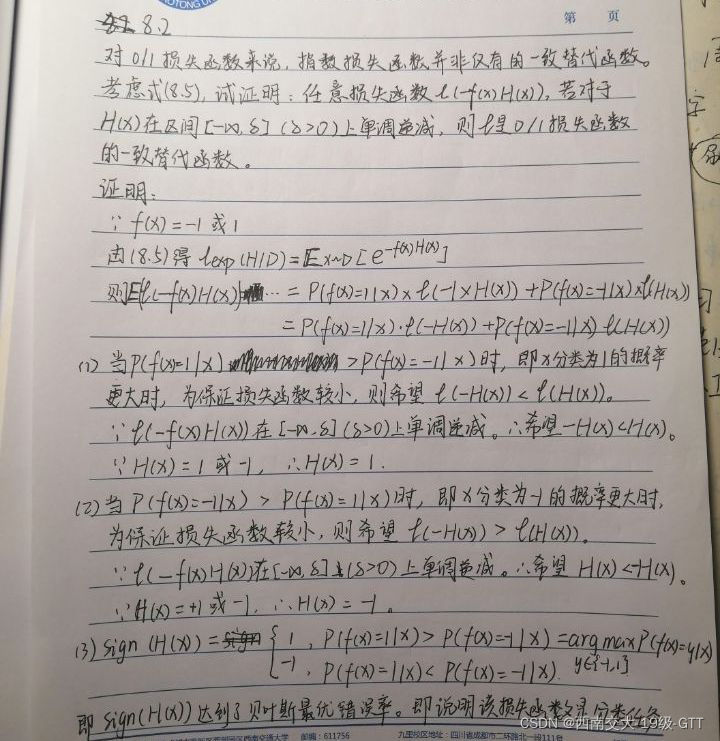

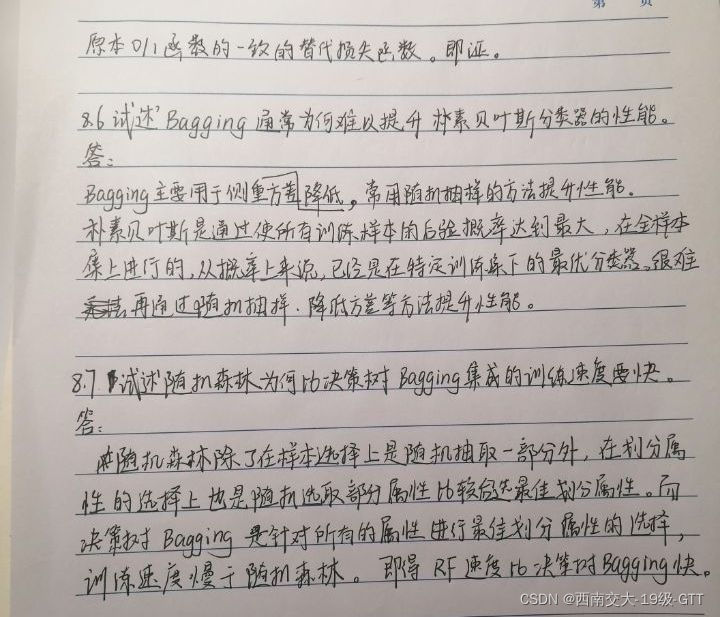

8.1、8.2、8.6、8.7;

第5章:

要点:

5.1:试述将线性函数XXXXX用作神经元激活函数的缺陷。

#“退化”

(1)当使用线性函数作为激活函数时,无论是在隐藏层还是在输出层,其单元值都还是输入的线性

组合。

(2)若隐层用线性函数作为激活函数,输出层用线性函数,等价于线性回归 。

(3)若隐层用线性函数作为激活函数,输出层用 Sigmoid函数,等价于逻辑回归Logistics。

5.2:试述使用图 5.2(b) 激活函数的神经元与对率回归的联系。

(1)使用Sigmoid

激活函数,每个神经元几乎和对率回归相同。

(2)但是输出不同。对率回归在Sigmoid

(

x

)>0.5

时输出为1

,而神经元直接输出

Sigmoid

(

x

)。

(3)特别地,使用sigmoid激活函数的单层神经网络在做二分类时等价于对率回归。

5.3:对于图

5.7

中的

v

ih

,试推导出

BP

算法中的更新公式

(5.13)。

"""图5.7的符号表示及涉及的公式需要自己多画两遍弄清楚,还有sigmoid函数求导性质;仿照课本

另一个公式的推导进行,涉及链式求导法则。"""

5.4:

试述式

(5.6)

中学习率的取值对神经网络训练的影响。

(1)学习率

控制着每一轮迭代的更新步长。

控制着每一轮迭代的更新步长。

(2)学习率太高,会导致误差函数来回震荡,无法收敛;

(3)学习率太低,会导致收敛太慢,影响训练效率。

第6章:

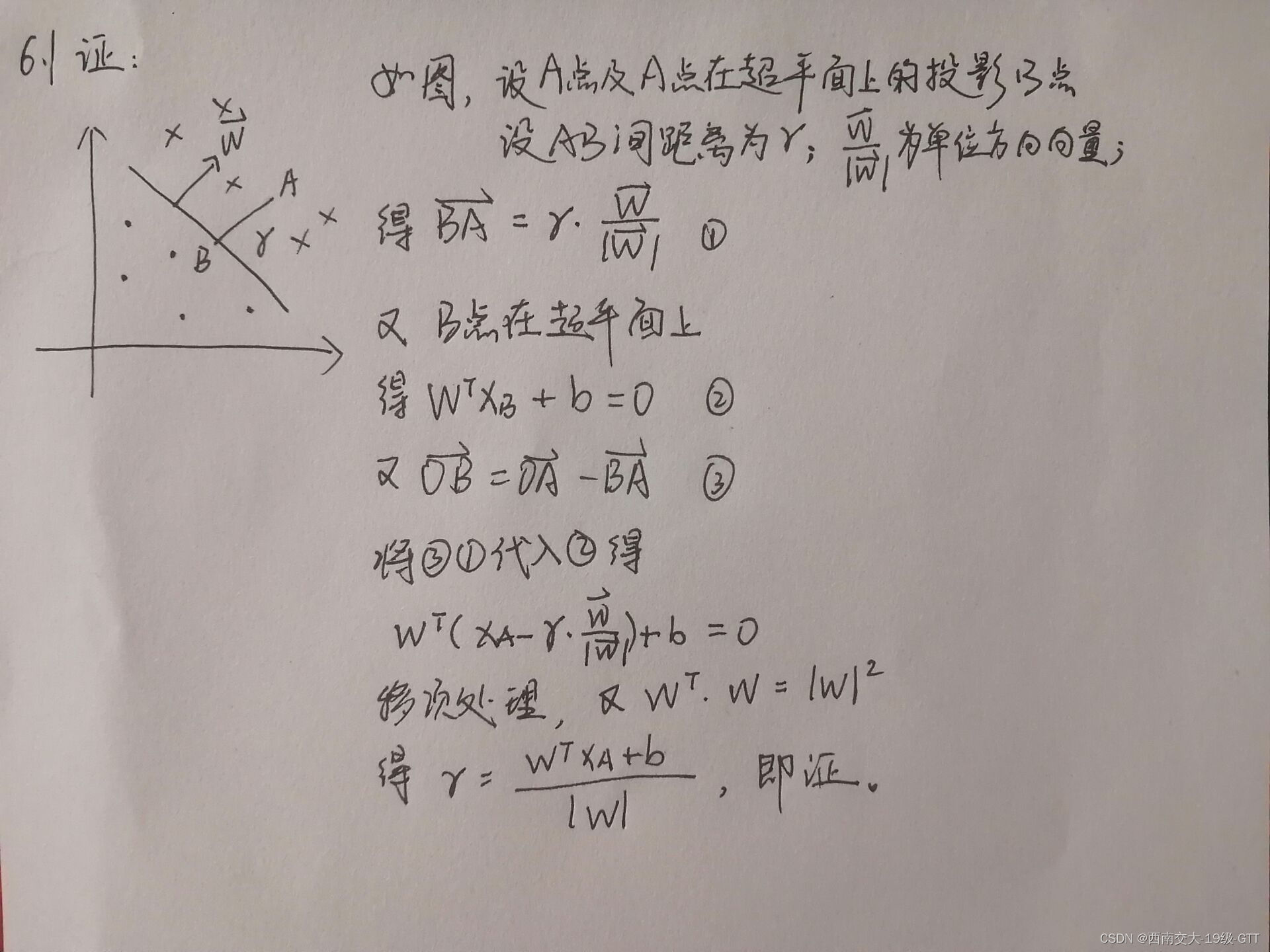

6.1:试证明样本空间中任意点

x

到超平面(

w

,

b

)的的距离为式

(6.2)

。

6.4:试讨论线性判别分析LDA与线性核支持向量机在何种条件下等价

答:当线性核支持向量机超平面

与LDA投影方向

与LDA投影方向

垂直时二者等价

垂直时二者等价

6.5:试述高斯核SVM与RBF神经网络之间的联系。

答:

(1)在联系上:RBF

网络的径向基函数与

SVM

都采用高斯核,就分别得到了高斯核

RBF

网络与高

斯核SVM。

(2)在误差和惩罚项区别方面,神经网络是最小化累计误差,将参数

w

作为惩罚项;而

SVM

相

反,主要是最小化参数,将误差作为惩罚项。

(3)在高斯核的应用区别方面,高斯核

SVM

将高斯函数仅作为计算高维空间内积的假想函数

,

即实

际上数据并非是被映射到函数的输出;

而

RBF

神经网络则是真的用

RBF

函数将输入映射一个已知的

空间。

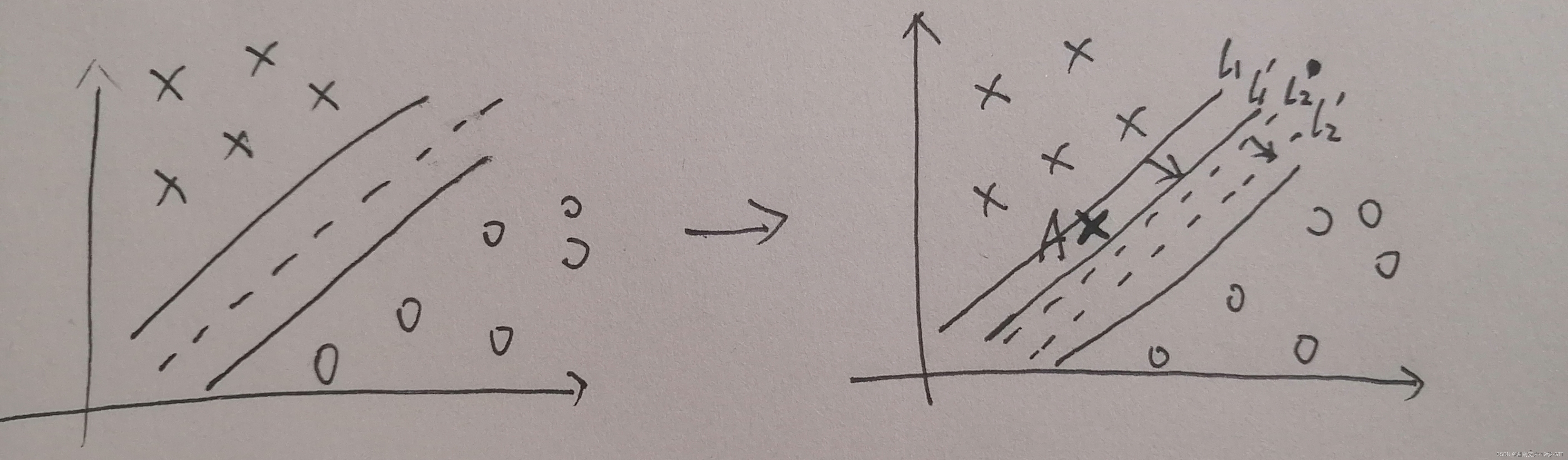

6.6:试析SVM对噪声敏感的原因。

(1)前提:SVM

的基本形态是硬间隔分类器,它要求所有样本都满足硬间隔约束。

(2)第一种情况:当数据集中存在噪声点但是仍然满足线性可分的条件时,SVM

为了把噪声点也划分正确,超平面就会向另外一个类的样本靠拢,这就使得划分超平面的几何间距变小,从而降低了模型的泛化性能。

参考图:

(3)第二种情况:当数据集因为存在噪声点而导致已经无法线性可分时,就会使用核技巧,将样本映射到高维特征空间使得样本线性可分,得到一个复杂模型,容易出现过拟合情况,泛化能力差。

(4)结论:

所以SVM对于噪声很敏感,因此后文提出了软间隔

SVM

来防止噪声的存在容易导致的过拟合问题。

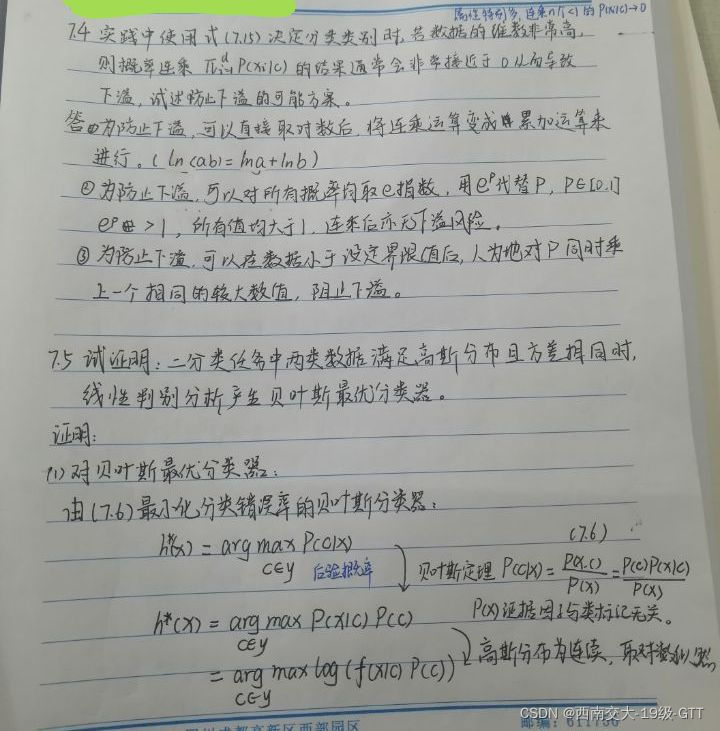

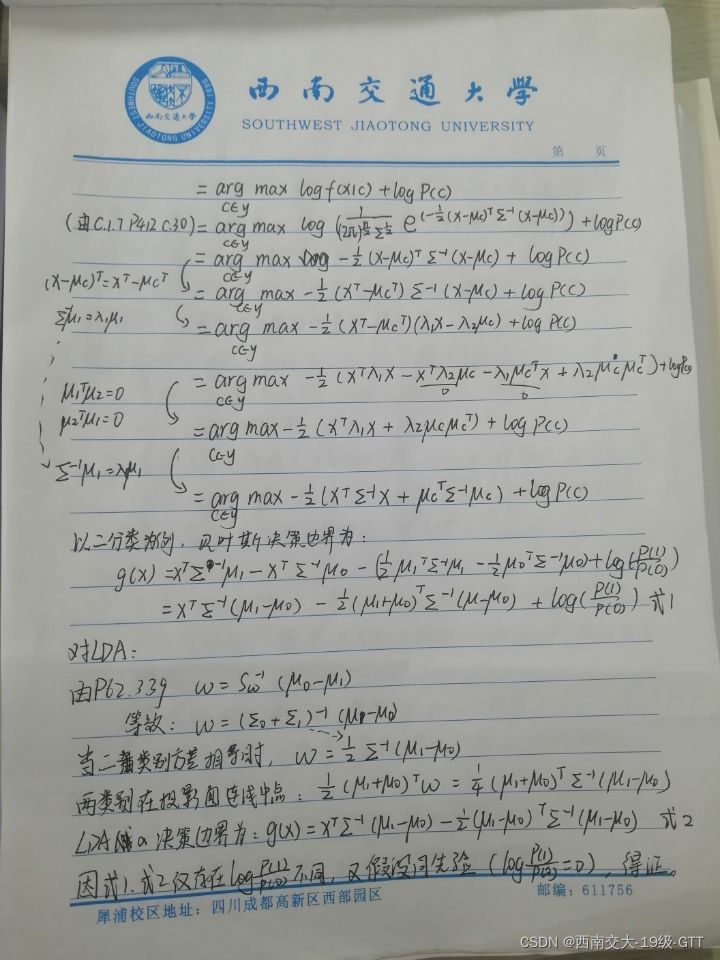

第7章:

第8章:

8.1:#说白了就是类比,得到p和两个关系,后面就好做了。

8.2:#说白了就是把期望函数写出来再分析,得到sign(H(x)),证得一致替代函数。

8.2:#说白了就是把期望函数写出来再分析,得到sign(H(x)),证得一致替代函数。

8327

8327

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?