文章目录

前言

前段时间做一个国防的项目,使用鲲鹏服务器+英伟达GA100显卡,离线环境安装驱动和pytorch。操作系统使用KylinV10SP2。python依赖已经整理好,可以去我的下载资源里去获取。

一、基础环境

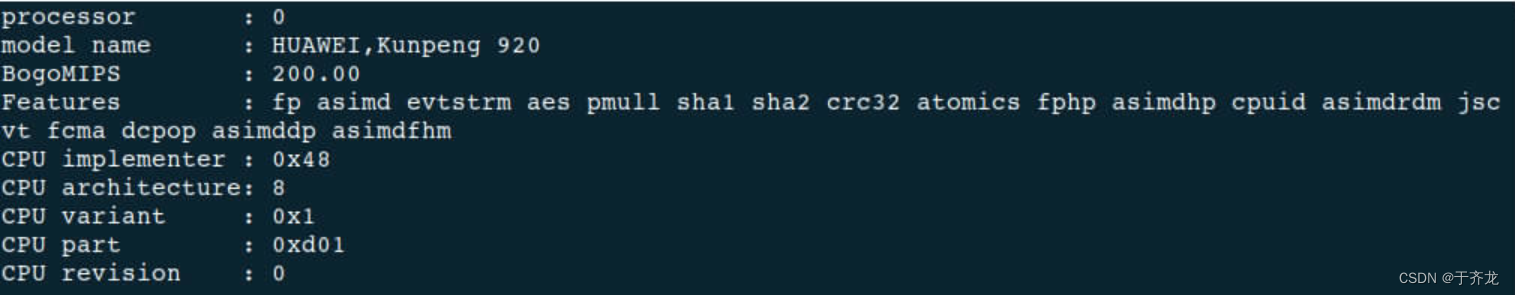

1.1、处理器型号

HUAWEI Kunpeng 920 7261K

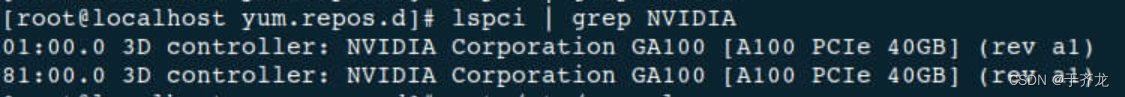

1.2、英伟达显卡型号

Tesla A100

GA100 [A100 PCIe 40GB]

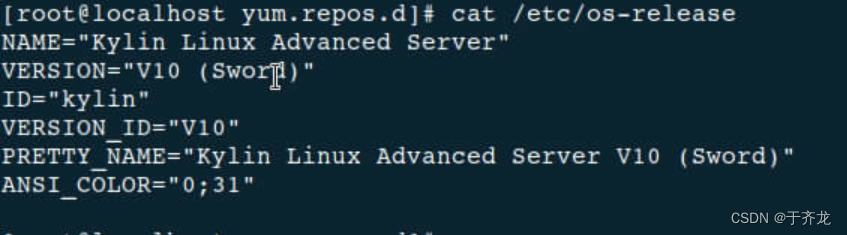

1.3、操作系统

KylinV10SP2

1.4、软件环境

| 软件 | 版本 | 下载地址 |

|---|---|---|

| CUDA Toolkit | 11.8 | https://developer.download.nvidia.com/compute/cuda/11.8.0/local_installers/cuda_11.8.0_520.61.05_linux_sbsa.run |

| cuda-samples | 11.8 | https://github.com/NVIDIA/cuda-samples/archive/refs/tags/v11.8.tar.gz |

| python | 3.9.0 | https://www.python.org/ftp/python/3.9.0/Python-3.9.0.tgz |

| torch | 2.0.0 | https://download.pytorch.org/whl/torch-2.0.0-cp39-cp39-manylinux2014_aarch64.whl#sha256=a83b26bd6ae36fbf5fee3d56973d9816e2002e8a3b7d9205531167c28aaa38a7 |

| torchvision | 0.15.1 | https://download.pytorch.org/whl/torchvision-0.15.1-cp39-cp39-manylinux2014_aarch64.whl#sha256=e9b4bb2a15849391df0415d2f76dd36e6528e4253f7b69322b7a0d682535544b |

| torchaudio | 2.0.1 | https://download.pytorch.org/whl/torchaudio-2.0.1-cp39-cp39-manylinux2014_aarch64.whl#sha256=77b953fd7278773269a9477315b8998ae7e5011cc4b2907e0df18162327482f1 |

二、取消内核自动升级

说明:之前使用昇腾服务器,遇到过内核自动升级后 NPU 驱动无法使用的情况,所以这里取消内核自动升级。

- 修改配置文件

/etc/yum.confvim /etc/yum.conf - 在

[main]的最后添加exclude=kernel*并保存

三、配置本地yum源

-

将下载好的iso镜像文件上传到服务器指定目录:

/mnt -

创建挂载目录

mkdir /mnt/iso -

挂载镜像

mount /mnt/Kylin-Server-10-SP2-aarch64-Release-Build09-20210524.iso /mnt/iso/ -

备份yum源

cd /etc/yum.repos.d mkdir bak mv *.repo bak -

新建本地

yum源vim /etc/yum.repos.d/kylin_aarch64.repo内容如下:

[kylin_aarch64.repo]

name=kylin_aarch64.repo

baseurl=file:///mnt//iso

enabled=1

gpgcheck=0 -

使

yum源生效yum clean all yum makecache -

验证

yum list -

设置开机自动挂载

方式1:配置

/etc/fstabvim /etc/fstab 添加以下内容: /mnt/Kylin-Server-10-SP2-aarch64-Release-Build09-20210524.iso /mnt/iso/ xfs defaults 0 0方式2:配置

/etc/rc.d/rc.localvim /etc/rc.d/rc.local 添加挂载命令: mount /mnt/Kylin-Server-10-SP2-aarch64-Release-Build09-20210524.iso /mnt/iso/

四、安装NVIDIA驱动

本项目使用的驱动版本:NVIDIA-Linux-aarch64-550.54.15.run

-

安装依赖

yum install kernel-devel-$(uname -r) kernel-headers-$(uname -r) -

查看显卡型号

lspci | grep NVIDIA -

根据显卡型号下载驱动,本项目使用的驱动跟图片中一致

下载地址:https://www.nvidia.cn/Download/index.aspx?lang=zh-cn

-

禁用nouveau,重启服务器

安装Nvidia显卡的官方驱动和系统自带的nouveau驱动冲突,所以需要禁用nouveau。lsmod | grep nouveau如果有输出则说明

nouveau正在被加载,执行下面代码,禁用nouveau,如果没有输出,则不执行。1、创建文件 vim /etc/modprobe.d/blacklist-nouveau.conf 添加如下内容: blacklist nouveau options nouveau modset=0 2、更新 dracut --force 3、重启服务器 reboot 4、查看是否禁用成功,若没有输出,则表示禁用成功 lsmod | grep nouveau -

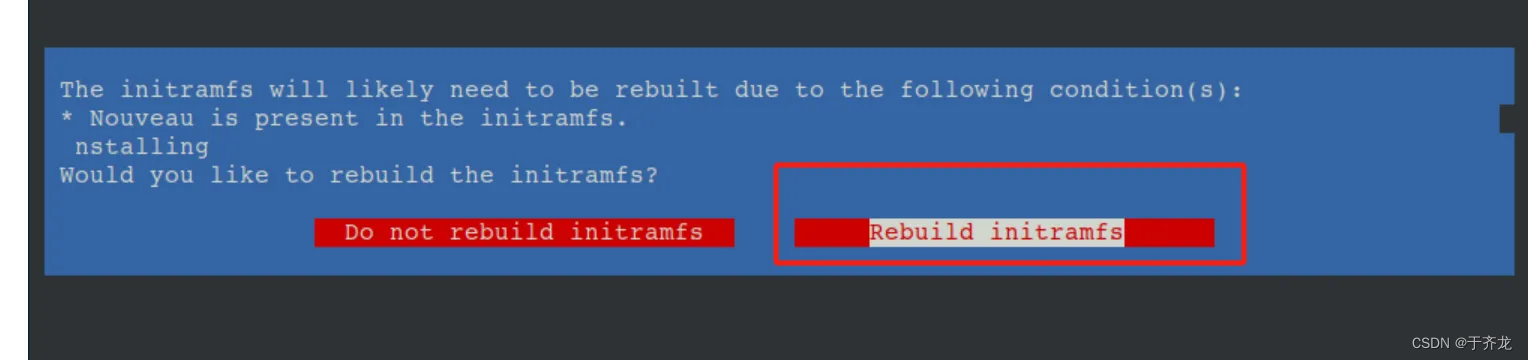

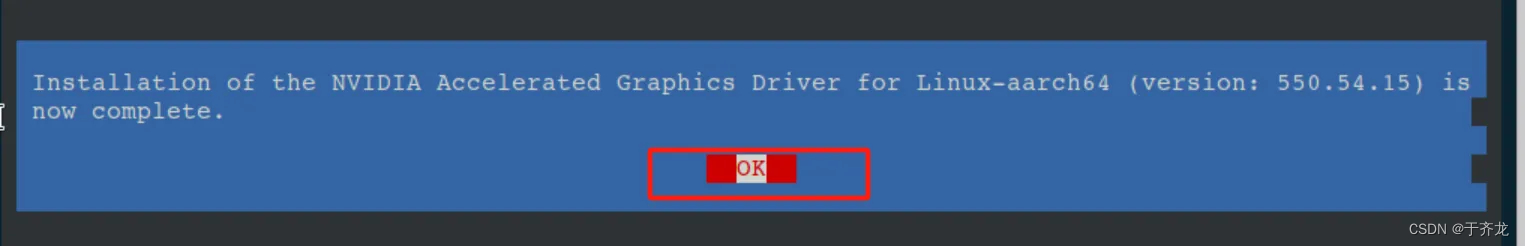

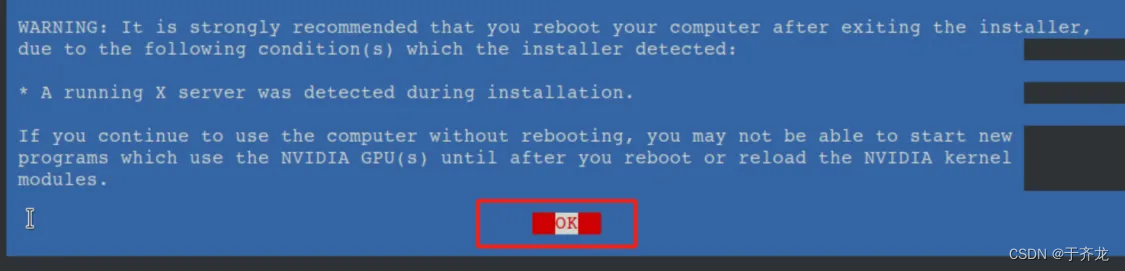

安装NVIDIA驱动

cd /opt sh NVIDIA-Linux-aarch64-550.54.15.run –no-opengl-files第一个页面:选择继续

第二个页面:

第三个页面:

第四个页面:

-

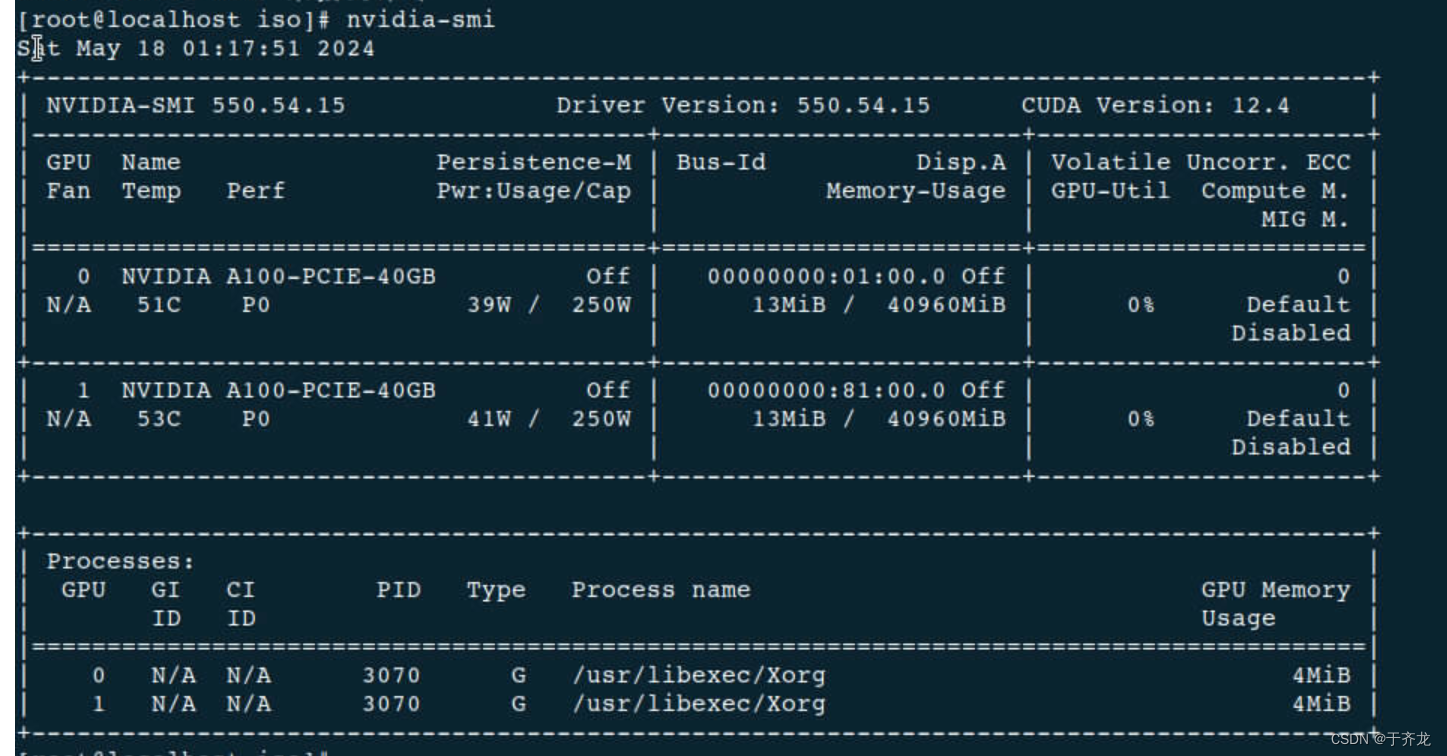

查看是否安装成功,查看驱动版本

nvidia-smi输出驱动版本,CUDA驱动版本,显卡型号。

五、安装CUDA

-

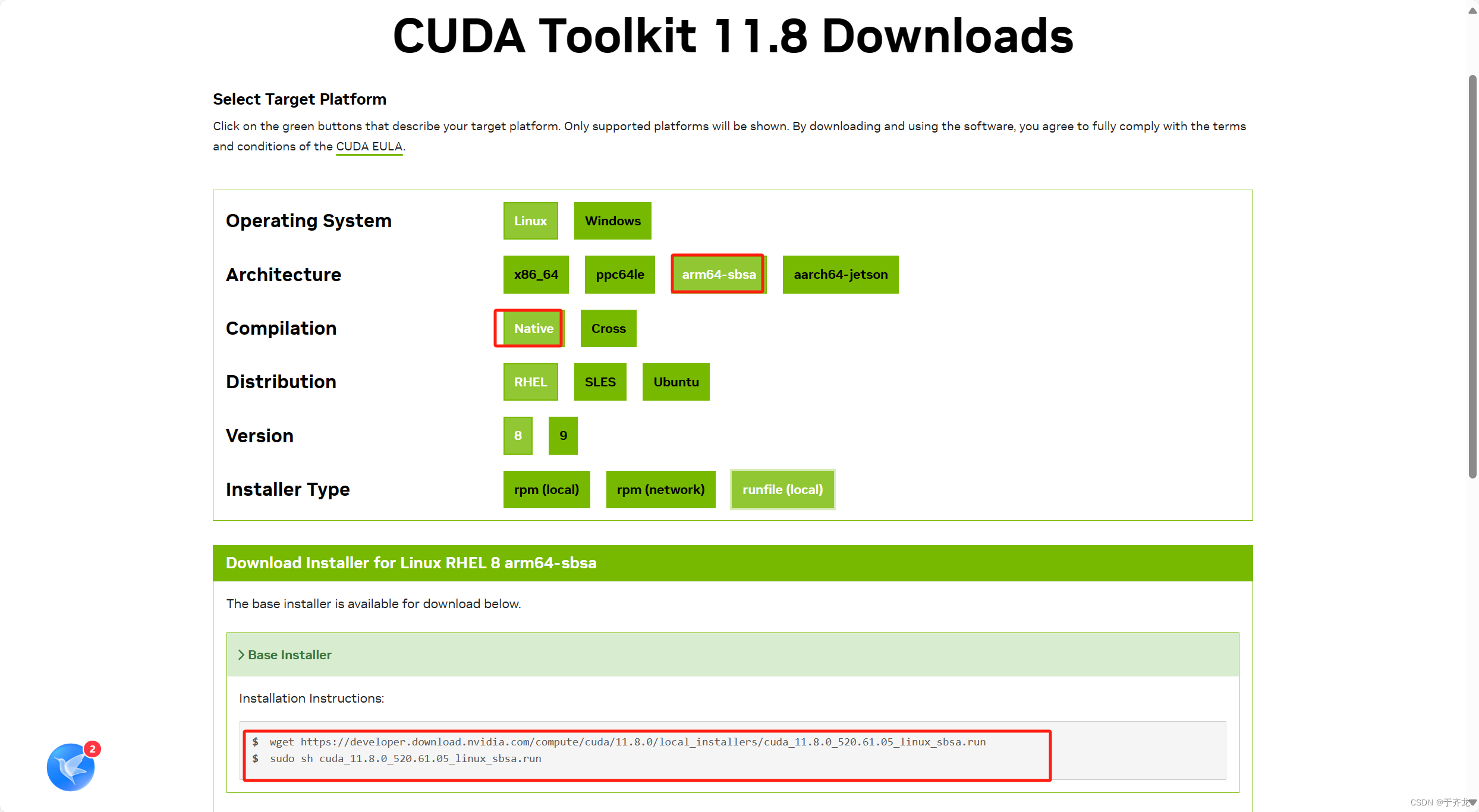

下载CUDA

这里需要注意

CUDA Toolkit的版本要小于上面CUDA驱动的版本。CUDA Toolkit下载地址:https://developer.nvidia.com/cuda-toolkit-archive本文使用的版本是

cuda_11.8.0_520.61.05_linux_sbsa.run这里不用纠结选择那个操作系统,只要选择

arm64-sbsa、Native、runfile(local)即可,其他的不管选什么下载的地址都是一个。

-

安装CUDA

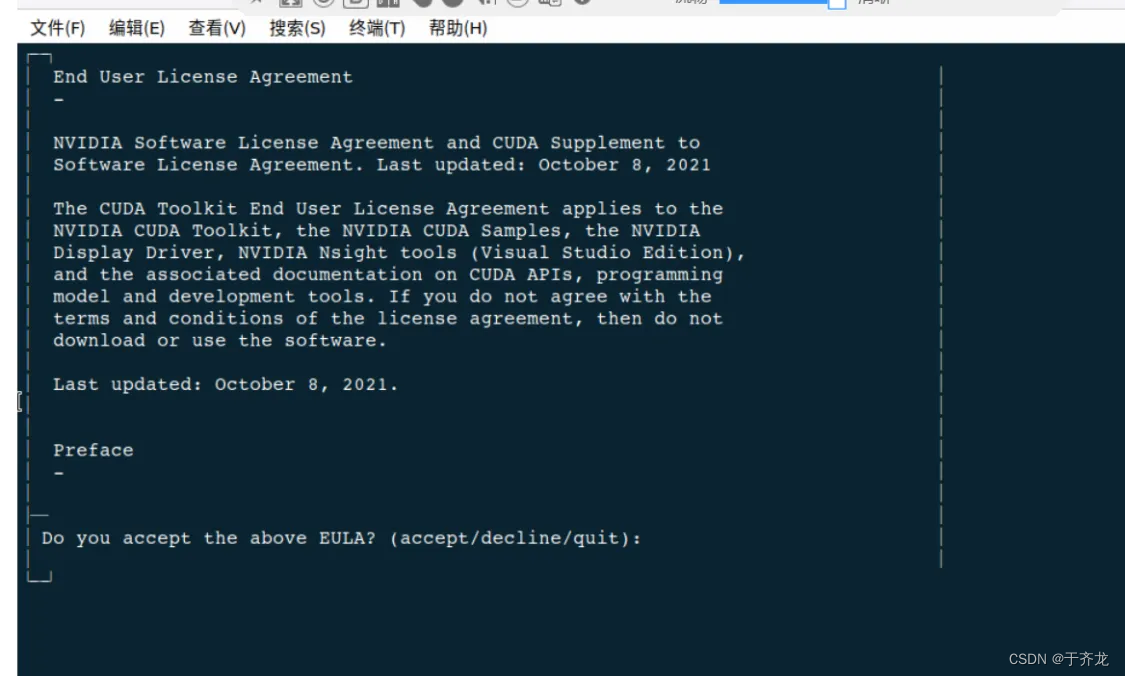

cd /opt sh cuda_11.8.0_520.61.05_linux_sbsa.run第一个页面:输入

accept

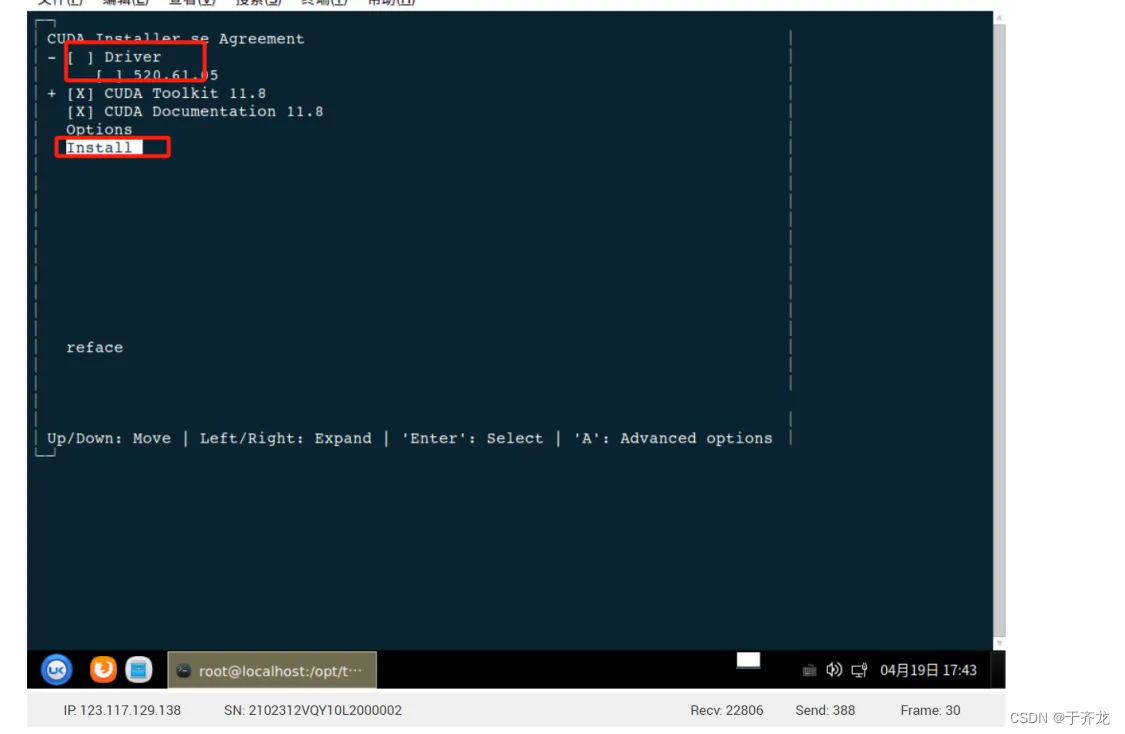

第二个页面:取消Driver的安装,因为前面已经安装了驱动

第三个页面:显示下面的输出,表示安装成功

-

配置环境变量

vim /etc/profile 添加如下内容: export CUDA_HOME=/usr/local/cuda export PATH=$CUDA_HOME/bin:$PATH export LD_LIBRARY_PATH=$CUDA_HOME/lib64:$LD_LIBRARY_PATH #使生效 source /etc/profile -

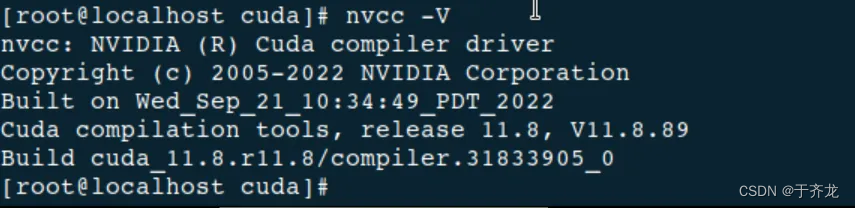

验证是否安装成功

nvcc -V

六、编译安装cuda-samples

说明:安装cuda-samples,是因为从CUDA Toolkit 11.6之后就不再将Samples集成到里面了,我们还需要使用cuda-samples进行测试,所以编译安装cuda-samples。

-

安装依赖

yum install gcc-c++ libstdc++-devel cpp gcc libgomp libstdc++ -

下载cuda-samples,本文使用版本

11.8下载地址:https://github.com/NVIDIA/cuda-samples/

-

编译

deviceQuery案例cd /opt/cuda-samples-11.8/Samples/1_Utilities/deviceQuery make -

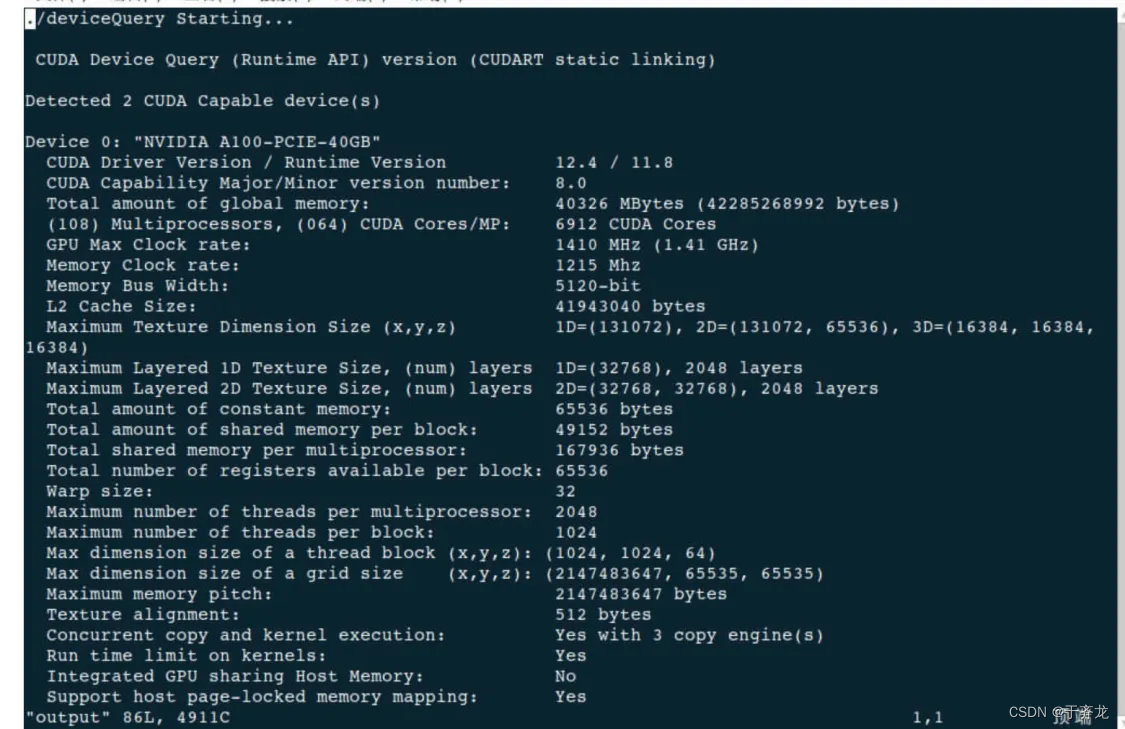

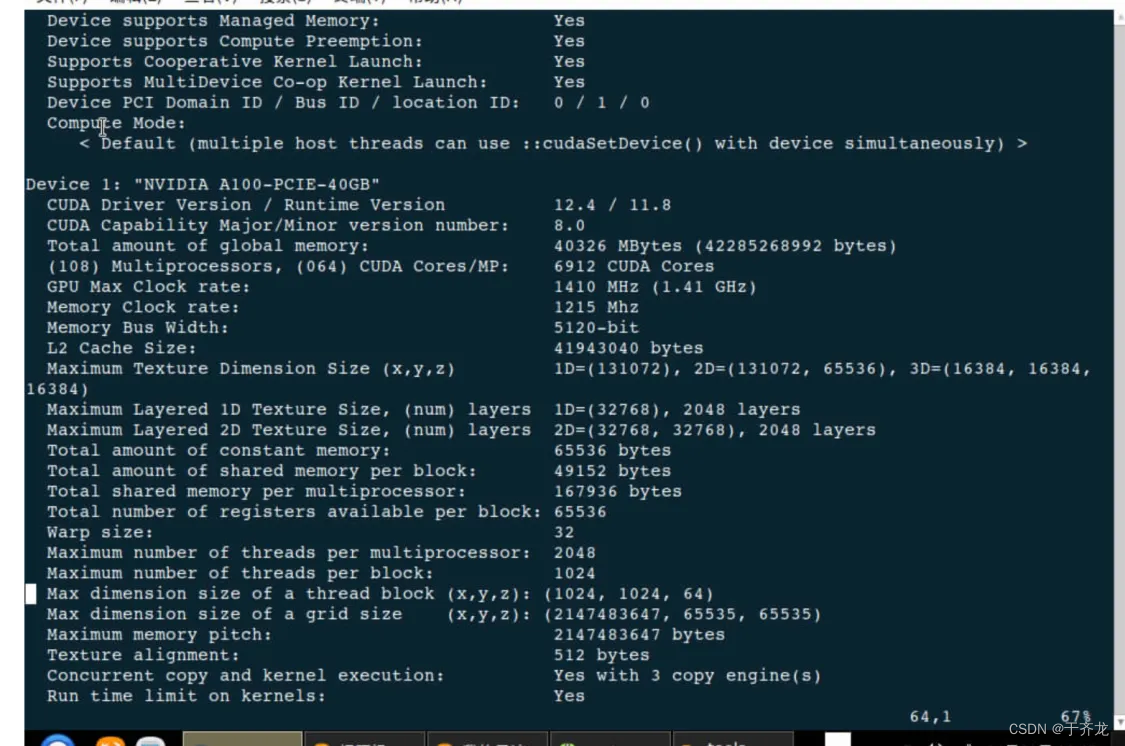

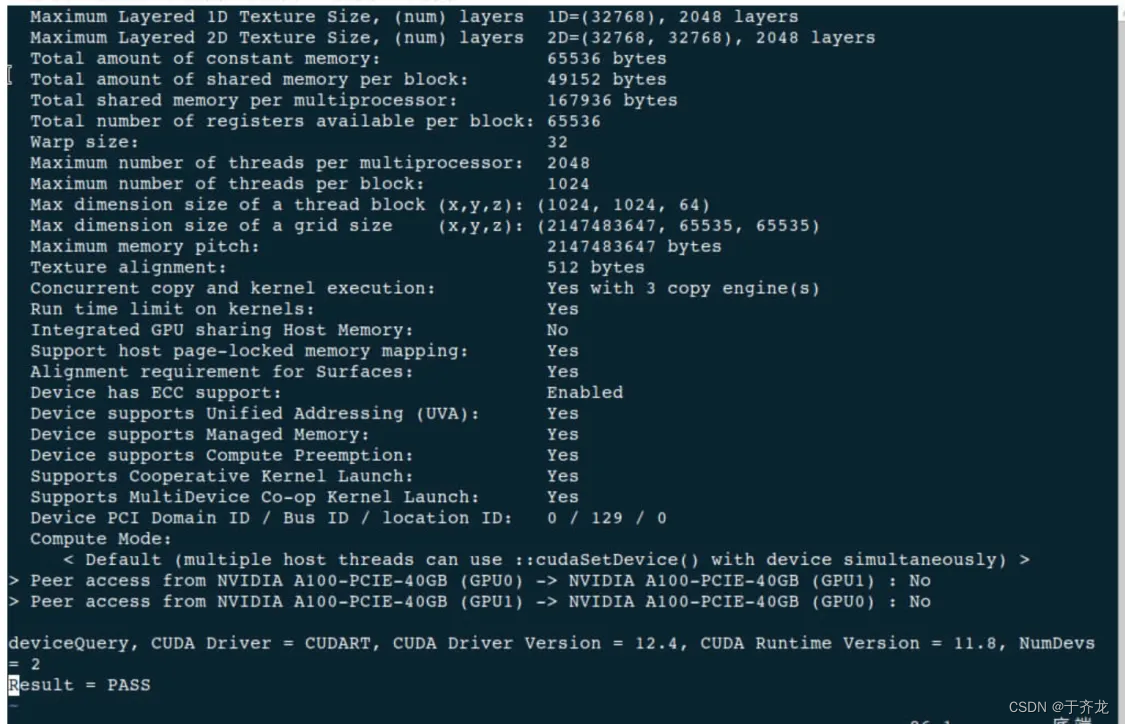

执行

deviceQuery案例./deviceQueryCUDA核心数:6912

七、安装Python

-

安装依赖

yum install openssl-devel openssl openssl-libs e2fsprogs-devel keyutils-libs-devel krb5-devel libverto-devel -

下载Python3.9

下载地址:https://www.python.org/ftp/python/3.9.0/Python-3.9.0.tgz

-

编译、安装

tar -zxvf Python-3.9.0.tgz cd /opt/Python-3.9.0 ./configure --prefix=/usr/local/python39 make -j make install -j -

创建

python和pip的软链接,如果存在旧的软连接,删除即可rm /usr/bin/python rm /usr/bin/pip ln -s /usr/local/python39/bin/python3.9 /usr/bin/python ln -s /usr/local/python39/bin/pip3.9 /usr/bin/pip -

验证是否安装成功

python --version pip --version

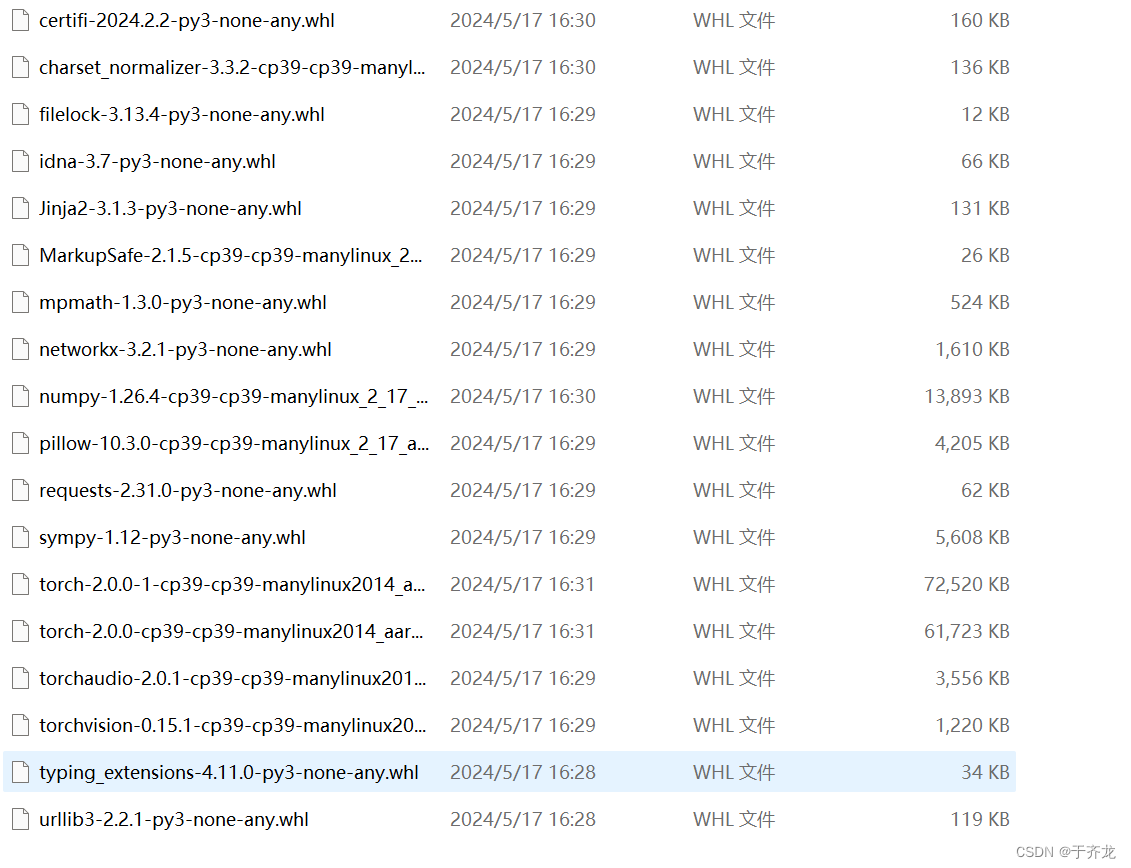

八、安装Pytorch

-

下载Pytorch

本文使用的版本为:

torch==2.0.0 torchvision==0.15.1 torchaudio==2.0.1下载地址:https://pytorch.org/get-started/previous-versions/

-

安装Pytorch

说明:当前目录下已经存在 torch==2.0.0 torchvision==0.15.1 torchaudio==2.0.1及其依赖包。

pip install --no-index --find-links=./ torch-2.0.0 torchvision-0.15.1 torchaudio-2.0.1

总结

本文主要内容包括:在鲲鹏服务器离线环境上安装NVIDIA A100显卡驱动、安装CUDA、安装cuda-samples并进行简单测试、安装Python、安装Pytorch。

7276

7276

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?