导读:这是一篇写得比较全面的基准数据集构建论文,论文附录还开源了人工标注说明、模型评测实验软硬件环境、详细的系统和用户提示词等,希望对大家有帮助。论文和数据集链接见文末

引言

近年来,大语言模型(LLMs)以其强大的语言理解和生成能力席卷全球,从智能助手到学术研究,无处不在。然而,当这些模型被应用于公共卫生领域时,一个关键问题浮现:它们能否准确检索并理解权威的公共卫生信息?

特别是政府发布的公共卫生指导意见,其不仅是居民健康决策的重要依据,也是专业人员和医疗机构的核心参考。错误、过时的解读或信息缺失可能带来严重后果。为此,英国健康安全署(UK Health Security Agency, UKHSA)的研究团队推出了一项开创性工作——PubHealthBench。这是一个专为评估大语言模型在英国公共卫生指导知识上的表现而设计的基准测试,旨在探索AI在这一关键领域的潜力与局限。

本文将带你深入了解PubHealthBench的创新之处、实验方法以及成果,并从中带你了解如何构建LLM行业基准评测数据集。

图1:PubHealthBench多选题和自由回答模式下模型准确率对比 左图展示多选题(包括全集和人工审查的子集)的模型准确率,右图展示自由回答模式的准确率,均包含95% Wilson置信区间。

图1:PubHealthBench多选题和自由回答模式下模型准确率对比 左图展示多选题(包括全集和人工审查的子集)的模型准确率,右图展示自由回答模式的准确率,均包含95% Wilson置信区间。

PubHealthBench的创新与贡献

PubHealthBench的推出是公共卫生领域与人工智能交叉研究的一次重要突破。传统的语言模型评估通常聚焦于通用知识或特定学科(如医学考试或科学问答),但针对某一国家公共卫生指导的系统性评估却鲜有涉足。英国的公共卫生指导内容复杂且更新频繁,涵盖从生物安全到健康不平等的广泛主题,涉及不同人群和场景。这为语言模型的知识准确性提出了独特挑战。

PubHealthBench的创新点在于其全面性和针对性。首先,研究团队收集并整理了超过1000份来自英国政府网站的公共卫生指导文档,涵盖PDF和HTML格式,最终筛选出687份高质量文档,形成了公开数据集。这一数据集以Markdown格式发布,为后续研究提供了宝贵资源。其次,团队开发了一个自动化流水线,生成了超过8000道多选题(MCQA)和自由回答题,覆盖10个公共卫生主题和352个指导领域,确保测试内容的广度和深度。这些问题直接基于原始文档,保证了评估的真实性和权威性。

图2:MCQA评测集的问答对示例

图2:MCQA评测集的问答对示例

此外,PubHealthBench不仅局限于多选题测试,还引入了自由回答(FreeForm)评估,模拟真实世界中用户与聊天机器人交互的场景。这种设置更贴近实际应用,考验模型在没有选项提示的情况下回忆和生成准确信息的能力。为了确保评估的客观性,研究团队利用了基于原始文档的评判机制,通过GPT-4o-Mini模型作为裁判,判断自由回答是否与指导内容一致。这种多维评估方式为理解语言模型在公共卫生领域的表现提供了全新视角。

另一个亮点是PubHealthBench对人类表现的对比。研究团队邀请了5位非公共卫生专家在有限时间内使用搜索引擎完成600道多选题,模拟普通公众获取信息的行为。这一人类基线与模型表现的对比,清晰揭示了AI在信息检索效率和准确性上的潜力。

实验方法:从文档提取到模型评估

PubHealthBench的研究团队首先从英国政府网站收集了1,150份公共卫生指导文档,涵盖生物安全、传染病防控、环境健康等多个领域。由于文档格式多样(HTML和PDF),他们开发了两阶段文本提取流水线:

- 对于HTML文档,直接转换为Markdown格式;

- 对于PDF文档,先使用现有工具提取原始文本,再通过GPT-4o-Mini视觉模型逐页提取内容,确保包括标题和结构信息。

最终,文档被分割成20,488个小节(section chunk),为后续问题生成提供了基础。

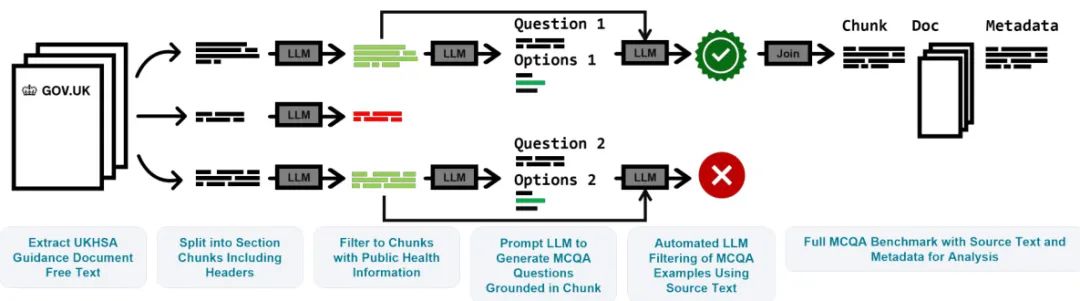

在多项选择问题生成阶段,团队使用Llama-3.3-70B-Instruct模型,通过单样本思维链(one-shot Chain of Thought)生成每个chunk对应的两道多选题,每题包含一个正确答案和六个错误干扰选项。为了确保问题聚焦于公共卫生推荐内容,团队先通过分类模型过滤掉不含推荐内容的文本段,保留7,946个有效chunk。生成的问题经过Llama-3-70B-Instruct的自动化错误检测,进一步筛选出14,440道高质量问题,最终形成包含8,090道多选题的PubHealthBench-Full数据集,以及760道人工审查的PubHealthBench-Reviewed子集。

图3:PubHealthBench多选题(MCQA)生成流水线概览 图示展示了从文档提取、文本分段、问题生成到错误检测的自动化流程,确保问题的高质量和可扩展性。

自由回答测试(PubHealthBench-FreeForm)基于人工审查子集,移除多选选项,要求模型直接生成答案。评估采用“LLM裁判”机制,GPT-4o-Mini根据原始文档、正确答案和相关上下文,判断回答是否准确。这一机制通过结合文本嵌入和TF-IDF的混合检索系统,提供五个相关文本段作为补充上下文,确保裁判的全面性。

实验中,研究团队测试了24个语言模型,包括私有模型(如GPT-4.5、Claude-Sonnet-3.7、o1)和开源模型(如Llama-3.3、Gemma-3)。为模拟真实场景,在对LLM进行能力评估时采用零样本提示(Zero-Shot Prompting),不提供外部工具或信息库,聚焦模型的内在知识;而为了凸显LLM的能力水平,还进行了人类基线测试,并允许使用搜索引擎(比如谷歌),但限定每题2分钟,以模拟快速信息检索的场景,从而帮助研究者们了解人们在使用LLM询问公共健康相关问题时的风险是高了还是低了。

图4:PubHealthBench 基准测试集审查的全流程 左图的步骤一表示在生成 MCQA 数据集后,先由两名人类专家对子集中的 150 道试题进行人工标注和对齐,从而修改和完善标注协议;中间的步骤二表示其中一名人类专家再根据完善后的标注协议对剩下的 650 道 MCQA 试题进行标注;右图的步骤三表示由 5 位非公共卫生专家对 600 道随机选取的 MCQA 试题在可借助搜索引擎的前提下进行作答,从而完成人类基准测试

图4:PubHealthBench 基准测试集审查的全流程 左图的步骤一表示在生成 MCQA 数据集后,先由两名人类专家对子集中的 150 道试题进行人工标注和对齐,从而修改和完善标注协议;中间的步骤二表示其中一名人类专家再根据完善后的标注协议对剩下的 650 道 MCQA 试题进行标注;右图的步骤三表示由 5 位非公共卫生专家对 600 道随机选取的 MCQA 试题在可借助搜索引擎的前提下进行作答,从而完成人类基准测试

实验结果:AI公共卫生知识的潜力与挑战

PubHealthBench的实验结果显示,语言模型在公共卫生领域的应用提供了深刻洞见。在多选题测试中,最新私有模型表现出色,GPT-4.5、GPT-4.1和o1的准确率均超过90%,接近理论上限97%,并显著优于人类基线(88%)。这表明顶级模型在结构化问题上已能高效检索和理解公共卫生指导内容。开源模型中,Llama-3.3-70B和Phi-4-14B等中型模型也表现不俗,准确率在75%-87%之间,显示出较强的知识储备。

图5:按主题划分,模型在PubHealthBench(MCQA)全集上的评估结果

图5:按主题划分,模型在PubHealthBench(MCQA)全集上的评估结果

按主题分析,模型在“气候与健康”和“包容健康环境下的健康保护”主题上表现最佳,而在“化学品与毒理学”领域准确率相对较低。这可能反映了不同主题内容的复杂性或模型训练数据的分布差异。按受众划分,模型对面向公众的指导内容掌握更好(GPT-4.5达96%),而对临床指导的准确率略低,提示模型在专业性较强的领域可能需进一步优化。

图6:按受众划分,模型在PubHealthBench(MCQA)全集上的评估结果

图6:按受众划分,模型在PubHealthBench(MCQA)全集上的评估结果

自由回答测试则揭示了更大的挑战。由于缺乏选项提示,模型需完全依赖自身知识生成答案,准确率普遍下降。最佳模型o1仅达74%,较其多选题表现下降17个百分点,而部分中小型模型(如Phi-4-14B)下降幅度高达47个百分点。这种差距源于自由回答需更高水平的知识召回能力,且模型可能生成与原始指导不一致的“幻觉”内容。值得注意的是,“推理型”模型(如o1和o3-Mini)在自由回答中表现优于非推理模型,表明推理能力在复杂场景中的价值。

图7:按受众划分,模型在PubHealthBench-FreeForm(开放问答)上的评估结果

图7:按受众划分,模型在PubHealthBench-FreeForm(开放问答)上的评估结果

展望:AI在公共卫生领域的未来

PubHealthBench不仅为语言模型的公共卫生知识评估树立了新标杆,也为AI在这一领域的应用指明了方向。其自动化流水线设计确保了测试的可扩展性,能够适应指导内容的频繁更新。实验结果表明,顶级模型已接近人类专家的准确性,尤其在结构化问题上表现突出。然而,自由回答的较低准确率提醒我们,模型在生成复杂答案时仍需改进,以避免信息偏差或错误。

对于公共卫生机构而言,PubHealthBench提供了一个可靠的工具,用于评估和优化语言模型,确保其在信息传播和决策支持中的安全性。未来,结合实时信息检索(如搜索引擎)或专门的微调,模型可能进一步提升在动态公共卫生场景中的表现。同时,公开数据集的发布将激励更多研究者探索AI与公共卫生的结合,助力全球健康事业。

PubHealthBench的诞生标志着AI在公共卫生领域迈出了坚实一步。它不仅揭示了语言模型的潜力,也为构建更安全、更准确的AI应用奠定了基础。无论是普通公众还是专业人士,未来的AI助手有望成为值得信赖的健康信息伙伴。

论文链接:

https://arxiv.org/pdf/2505.06046

数据集地址:

https://huggingface.co/datasets/Joshua-Harris/PubHealthBench

如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 2024行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?