今天跟学长交流了下想法,他说可以试试,但不好说效果好不好

而且还有一个问题是,不知道这个能不能作为创新点,也确实

但是大家在分类头上做的创新感觉并不是很多,基本上都就是local feature过一个分类头得到类别,然后用匹配算法找到对应的gt再做loss,我这其实唯一的区别就是,人家得到local feature是还不知道他对应的gt是哪一个,所以要用匈牙利匹配找到对应gt(有可能找错),我这个就是事先就知道了对应gt是哪个(不会找错),仅此而已

主要是感觉,毕竟预训练过程中的分类头和knet是一样的,要做分类的话肯定不好乱动,不然结构都不一样预训练肯定就没作用

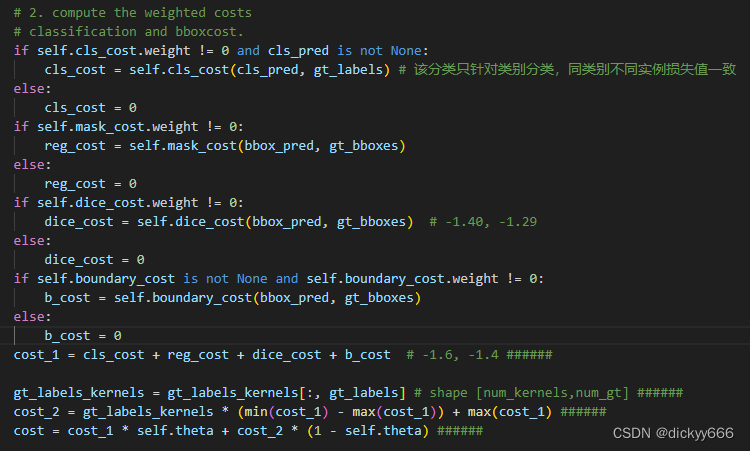

下午主要就是照着这个思路写了一下代码,匈牙利匹配根据cost来匹配pred和gt,然后额外加了一个hard cost,就是直接按照feature对应的类别去匹配,做了一个新的cost。但是pseudo gt的分类本身可能有错,不能完全按照这个去匹配,所以还是保留了之前的cost,两个cost用一个权重来平衡

cost1是正常计算匈牙利匹配的cost,cost2就是暴力匹配的cost

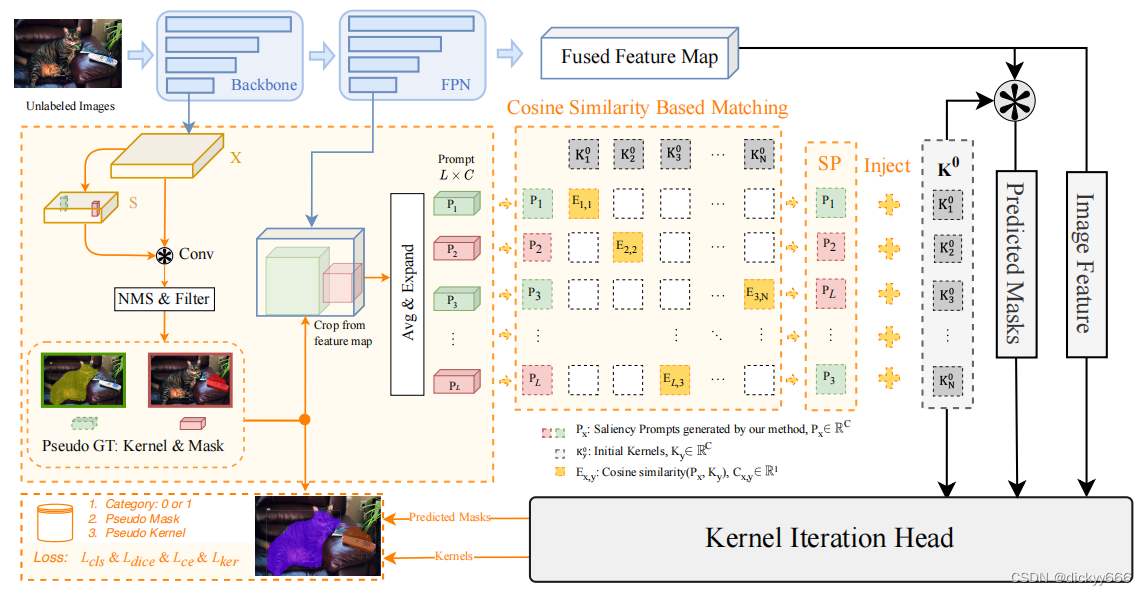

对,还是这个图,今天又对比了一下,发现其实学长这个,嘿嘿嘿,跟有的paper方法还有点像嘞

我看pre-training的文章比较少,想起来其中一篇是《up-detr》,然后对比了一下

大概也是image patch feature加到query上面,思路很像

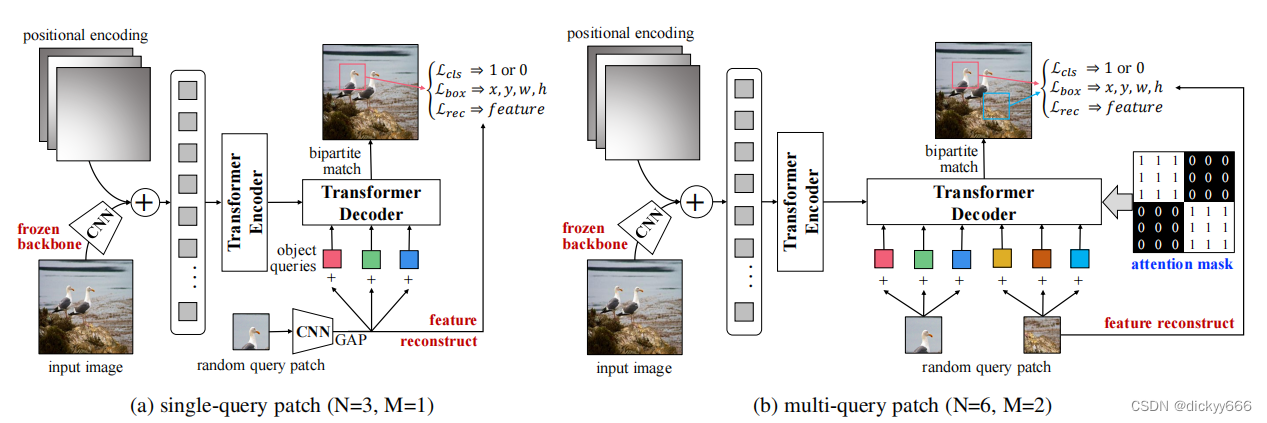

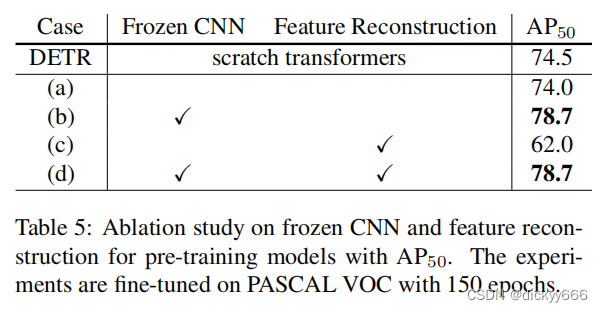

不过这些都不重要,看到这个部分感觉有点意思:feature reconstruction,就是patch feature(p)要和transformer decoder输出的query feature(pi)做相似损失,越像越好,作者解释就是,检测任务和分类任务所倾向的feature是不一致的,而pi的任务是要做检测,分类任务可能就无法完成得很好,那么就让pi保留原始p所具备的特征辨识性(feature discrimination)(但是我也好奇p哪里来的辨识性)

挺有想法的,但可惜最后ablation做出来发现这一part并没有什么效果

所以现在针对我的工作,就有大致几个想法:(1)把crop下来的patch feature直接加到最后的kernel里面,相当于也让最后的kernel保留原有feature,是不是能提高分类能力捏;(2)或者kernel后面再加几个conv layer,让他转换到更适合分类的特征空间?但是这样knet本身估计也要改;(3)或者在patch feature后面加几个conv layer,再加到最后的kernel上?(4)patch feature过一个新的辅助分类头,让这个辅助分类头作用(蒸馏?ema?)到真正的分类头上?

唉好复杂,感觉分类头这个部分很少有人发挥,确实有可能是个空白,但是也有可能是没必要,现在大家差不多都是local feature直接过分类头得到class,还挺难搞的

明天:

早起,明天导来实验室

再想想,或者开始跑实验

666

666

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?