声明

不定期更新自己精度论文,通俗易懂,初级小白也可以理解

涉及范围:深度学习方向,包括 CV、NLP、Data Fusion、Digital Twin

论文标题:

TransUNet: Transformers Make Strong Encoders for Medical Image Segmentation

TransUNet: Transformer 为医学图像分割提供强大的编码器

论文链接:https://arxiv.org/abs/2102.04306

论文代码:https://github.com/Beckschen/TransUNet

发表时间:2021年2月

创新点

1、引入Transformer 和 U-Net 网络相结合,构建 TransUNet 网络

Abstract

医学图像分割是开发医疗保健系统,特别是疾病诊断和治疗计划的必要前提。在各种医学图像分割任务中,U形体系结构(又称U-NET)已经成为事实上的标准,并取得了巨大的成功。然而,由于卷积运算固有的局部性,U-NET通常在显式建模远程依赖方面表现出局限性。为序列到序列预测而设计的变换器已经成为具有先天全局自关注机制的替代架构,但由于缺乏底层细节,它可能导致有限的定位能力。

本文提出 TransUNet 作为医学图像分割的一个有力的替代方案,它兼有 Transformers 和 U-net 的优点。一方面,该转换器将卷积神经网络(CNN)特征图中的标记图像块编码为输入序列,用于提取全局上下文。另一方面,解码器对编码特征进行上采样,然后将编码特征与高分辨率 CNN 特征映射相结合,以实现精确定位。

我们认为,变压器可以作为医学图像分割任务的强编码器,并结合 U-NET 通过恢复局部空间信息来增强更精细的细节。Transunet 在多器官分割和心脏分割等医学应用中取得了优于各种竞争方法的性能。 代码和模型可在 https://github.com/beckschen/transunet 获得。

Method

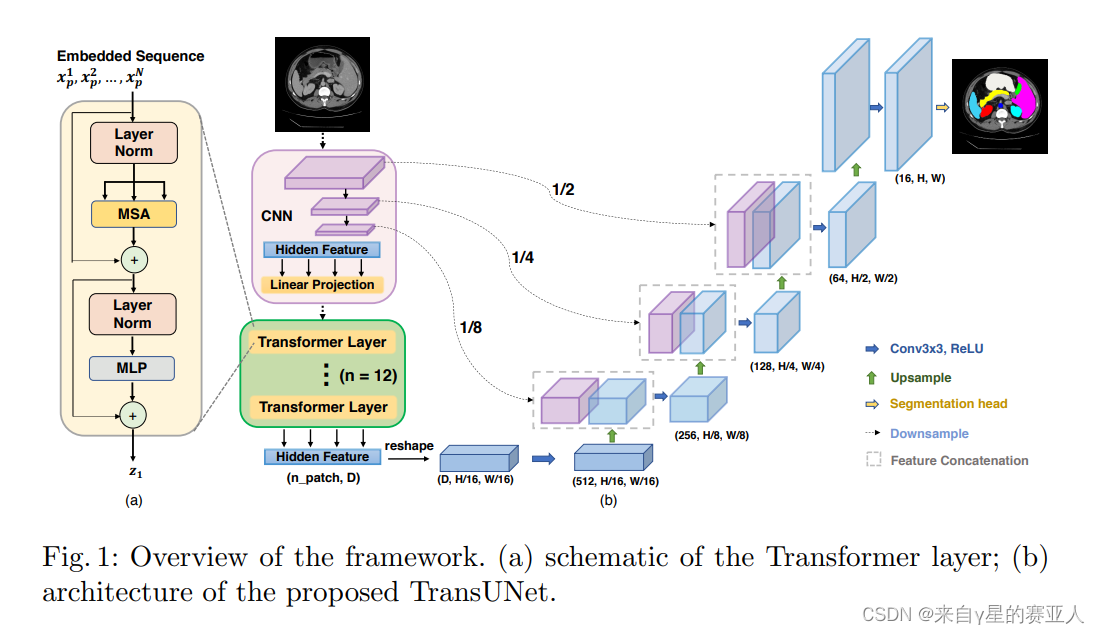

首先,输入图片经过下采样和3层卷积的迭代,生成的特征,进行 Flatten 操作;

然后,Flatten 后的特征进入 12 层 Transformer,这里的 Transformer 结构里面是 MSA (多头注意力机制),MLP (全连接层)然后输出;

这里解释一下,为什么先卷积再 Transformer 。

是因为,Transformer 的缺点就是,计算量大,并且没有空间信息。优点是,具备全局信息。

而卷积的缺点是,无法综合全局信息,而优点是,经过卷积后,参数变少,并且具备局部空间信息,不同的卷积核具备不同的感受野。

因此,作者将卷积放在 Transformer 结构前面,综合他们的优缺点,降低了参数,并具备了空间和全局信息。

最后,解码器部分和 U-Net 相同,reshape 后进行四次上采样,然后与编码器三次下采样的特征进行 Concatenation 操作,最后输出分割图。

Experiments

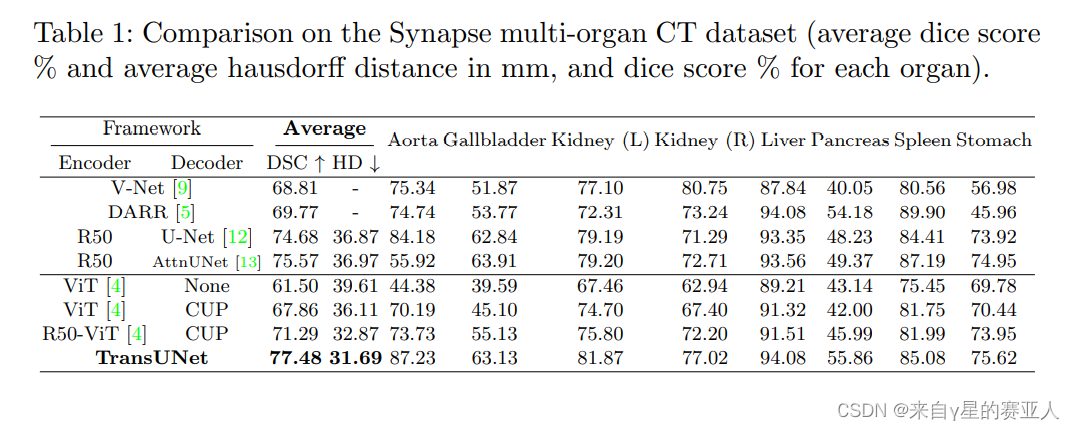

实验目标:不同数据集,不同编解码器结构的对比结果

实验结果:TransUNet 结果最优

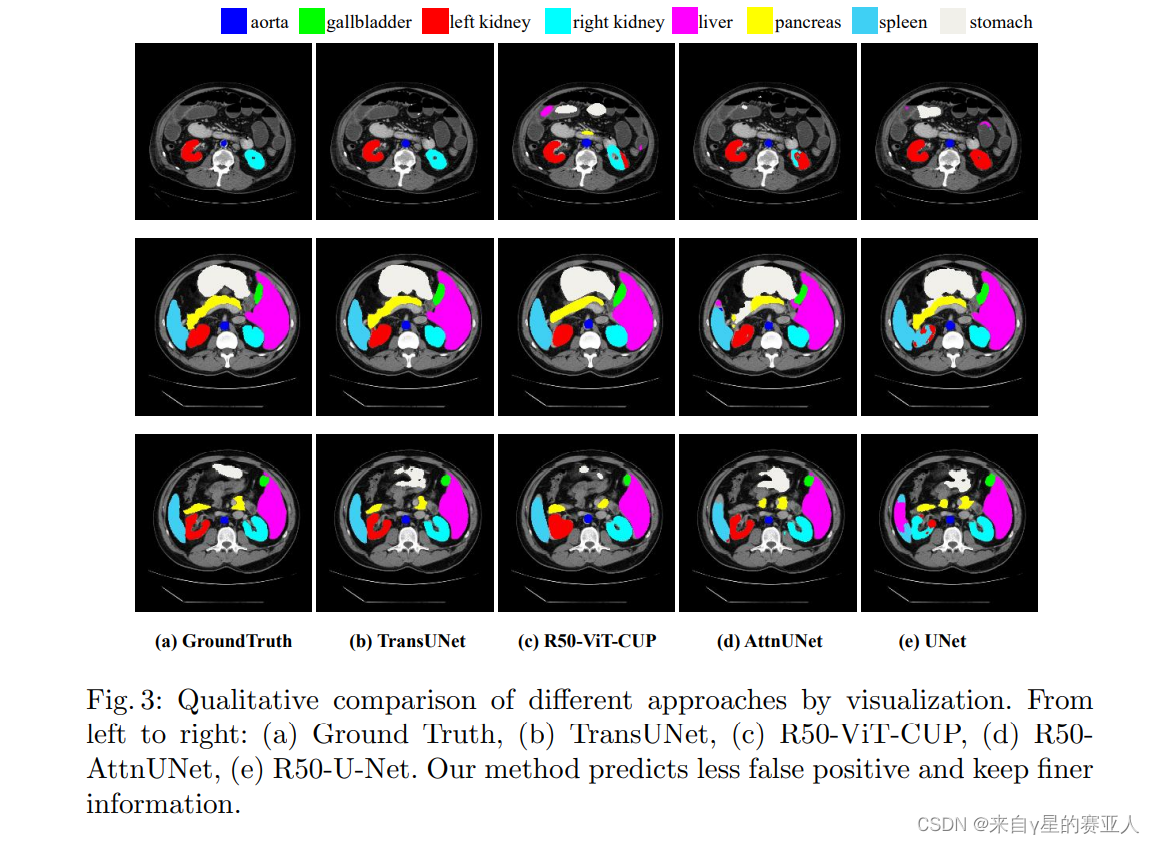

实验目标:分割结果图

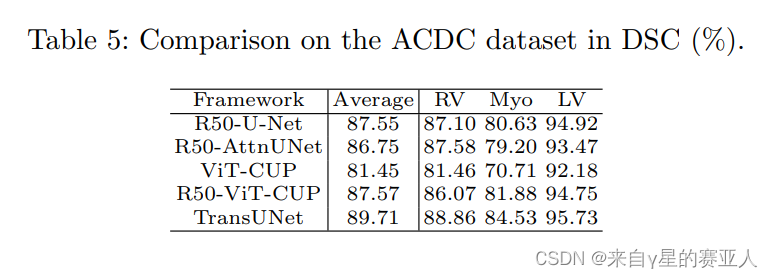

实验目标:不同框架对比

实验结果: TransUNet 有明显优势

写在最后

Transofrmer 要求数据集量大,但是医学数据集不好收集,这可能是限制 Transformer 在医学领域发展的问题之一吧!

3042

3042

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?