互联网上有极其丰富的数据资源可以使用。使用Excel可以自动读取部分网页中的表格数据,使用Python编写爬虫程序可以读取网页的内容。

今天的文章主要分为两个部分,一是用通过Python构建一个数据网站,二是分别使用Excel和Python从编写的Web网站上获取数据。

1、构建测试用网站数据

通过Python Flask Web框架分别构建一个Web网站和一个Web API服务。

1.构建Web网站

新建一个名为“5-5-WebTable.py”的Python脚本,创建一个包含表格的简单网页。如果读者对构建方法不感兴趣,可跳过以下代码,直接执行脚本“5-5-WebTable.py”打开网站。

(1)安装flask包。

pip install flask

(2)构建包含表格的网页。

from flask import Flask

app = Flask(__name__) # 创建Falsk Web应用实例

# 将路由“/”映射到table_info函数,函数返回HTML代码

@app.route('/')

def table_info():

return """<h2>HTML表格实例,用于提供给Excel和Python读取</h2>

<table border="1">

<caption>用户信息表</caption>

<tbody><tr>

<th>姓名</th>

<th>性别</th>

<th>年龄</th>

</tr>

<tr>

<td>小米</td>

<td>女</td>

<td>22</td>

</tr>

……….

</tbody></table>"""

if __name__ == '__main__':

app.debug = True # 启用调试模式

app.run() # 运行,网站端口默认为5000

通过命令“python ./5-5-WebTable.py”启动网站,然后在浏览器中输入http://127.0.0.1:5000/,出现如图1所示的网页内容。

图1 使用Flask构建的测试网站

2.构建Web API服务

新建一个名为“5-5-WebAPI.py”的Python脚本,使用flask_restplus包构建Web API服务。如果读者对构建方法不感兴趣,可跳过以下代码,直接执行脚本“5-5-WebAPI.py”打开Web API服务。

(1)安装flask_restplus包。

pip install flask-restplus

(2)导入必要的库与初始化应用对象。

from flask import Flask

# Api类是Web API应用的入口,需要用Flask应用程序初始化

from flask_restplus import Api

# Resource类是HTTP请求的资源的基类

from flask_restplus import Resource

# fields类用于定义数据的类型和格式

from flask_restplus import fields

app = Flask(__name__) # 创建Falsk Web应用实例

# 在flask应用的基础上构建flask_restplus Api对象

api = Api(app, version='1.0',

title='Excel集成Python数据分析-测试用WebAPI',

description='测试用WebAPI', )

# 使用namespace函数生成命名空间,用于为资源分组

ns = api.namespace('ExcelPythonTest', description='Excel与Python Web API测试')

# 使用api.model函数生成模型对象

todo = api.model('task_model', {

'id': fields.Integer(readonly=True,

description='ETL任务唯一标识'),

'task': fields.String(required=True,

description='ETL任务详情')

})

(3)Web API数据操作类,包含增、删、改、查等方法。

class TodoDAO(object):

def __init__(self):

self.counter = 0

self.todos = []

def get(self, id):

for todo in self.todos:

if todo['id'] == id:

return todo

api.abort(404, "ETL任务 {} 不存在".format(id))

def create(self, data):

todo = data

todo['id'] = self.counter = self.counter + 1

self.todos.append(todo)

return todo

# 实例化数据操作,创建3条测试数据

DAO = TodoDAO()

DAO.create({'task': 'ETL-抽取数据操作'})

DAO.create({'task': 'ETL-数据清洗转换'})

DAO.create({'task': 'ETL-数据加载操作'})

(4)构建Web API的路由映射。

HTTP资源请求类从Resource类继承,然后映射到不同的路由,同时指定可使用HTTP方法。

@ns.route('/') # 路由“/”对应的资源类为TodoList,可使用get方法和post方法进行请求

class TodoList(Resource):

@ns.doc('list_todos') # @doc装饰器对应API文档的信息

@ns.marshal_list_with(todo) # @marshal_xxx装饰器对模型数据进行格式转换与输出

def get(self): # 定义get方法获取所有的任务信息

return DAO.todos

@ns.doc('create_todo')

@ns.expect(todo)

@ns.marshal_with(todo, code=201)

def post(self): # 定义post方法获取所有的任务信息

return DAO.create(api.payload), 201

# 路由/<int:id>对应的资源类为Todo,可使用get、delete、put方法进行请求

@ns.route('/<int:id>')

@ns.response(404, '未发现相关ETL任务')

@ns.param('id', 'ETL任务ID号')

class Todo(Resource):

@ns.doc('get_todo')

@ns.marshal_with(todo)

def get(self, id):

return DAO.get(id)

@ns.doc('delete_todo')

@ns.response(204, 'ETL任务已经删除')

def delete(self, id):

DAO.delete(id)

return '', 204

@ns.expect(todo)

@ns.marshal_with(todo)

def put(self, id):

return DAO.update(id, api.payload)

if __name__ == '__main__':

app.run(debug=True, port=8000) # 启动Web API服务,端口为8000

(4)开启Web API服务。

通过命令“python ./5-5-WebAPI.py”启动Web API服务,在浏览器中输入“http://127.0.0.1:8000/”将出现如图5-23所示的Web API服务请求方法列表。

图2 WebAPI服务请求方法列表

2、抓取用网页数据

Excel可以通过“数据”选项卡下的“自网站”功能抓取网页数据。Python可以使用 requests 库、Beautiful Soup包、Scrapy框架抓取网页数据。

1.通过Excel抓取

单击“数据”→“自其他源”→“自网站”功能。Excel可读取的网页数据有局限:动态网页数据无法自动识别,非表格数据无法自动识别。

(1)单击“数据”→“自其他源”→“自网站”功能。

(2)确保在5.5.1节中编写的Web网站已经开启。

(3)输入网站URL地址“http://127.0.0.1:5000/”

单击“高级”按钮可配置更详细的HTTP请求信息,然后单击“确定”按钮,如图3所示。

图3 配置要读取网站的URL

(4)在“导航器”窗口中选择导入数据。

如图4所示,Excel自动识别网页中的表格数据,选择表名后单击“加载”按钮即可。

图4 Excel自动识别网页中的表格数据

2.使用Python抓取

下面演示使用requests库抓取整个网页中的数据,然后使用Beautiful Soup解析网页。读者可参考本书代码素材文件“5-5-web.ipynb”进行学习。

(1)通过requests读取网页数据。

import requests #导入requests包

url ='http://127.0.0.1:5000/'

strhtml= requests.get(url) #使用get方法请求网页数据

(2)通过Beautiful Soup解析网页。

from bs4 import BeautifulSoup

soup = BeautifulSoup(strhtml.text) # 将网页内容作为参数,创建soup对象

table = soup.find('table') # 查找网页中的table元素

table_body = table.find('tbody') # 查找table元素中的tbody元素

data = []

rows = table_body.find_all('tr') # 查找表中的所有tr元素

for row in rows: # 遍历数据

cols = row.find_all('td')

cols = [ele.text.strip() for ele in cols]

data.append([ele for ele in cols if ele])

# 结果输出:[[],

['小米', '女', '22'],['小明','男','23'],……

3、调用Web API服务

Excel可以通过“数据”选项卡下的“自网站”功能调用Web API服务。Python可以使用 requests 库、Beautiful Soup包、Scrapy框架调用Web API获取数据。

1.使用Excel调用

(1)确保5.5.1节中编写的Web API服务已经开启。

(2)输入Web API方法对应的URL:http://127.0.0.1:8000/ExcelPythonTest/。

(3)处理返回的数据。

调用Web API服务后数据以JSON格式返回,按照5.4.3小节中介绍的方法处理JSON数据。

2.使用Python调用

使用requests库调用Web API方法,然后对返回的JSON数据进行处理,读者可参考本书代码素材文件“5-5-api.ipynb”进行学习。

import requests #导入requests包

url ='http://127.0.0.1:8000/ExcelPythonTest/'

strhtml= requests.get(url) #使用get方法获取网页数据

import pandas as pd

frame= pd.read_json(strhtml.text) #使用Pandas包中的read_json函数

print(frame)

#结果输出:

id task

0 1 ETL-抽取数据操作

1 2 ETL-数据清洗转换

2 3 ETL-数据加载操作

4、两种方法对比

表1所示为Excel和Python抓取互联网数据方法的对比。需要注意Excel从互联网抓取数据的功能并不完善。

表1 Excel和Python抓取互联网数据方法对比

- 声明:本文选自北京大学出版社的《从零开始利用Excel与Python进行数据分析》一书,略有修改,经出版社授权刊登于此。

[](https://blog.csdn.net/Python84310366/article/details/137593575?spm=1001.2014.3001.5502)关于Python学习指南

------------------------------------------------------------------------------------------------------

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

包括:Python激活码+安装包、Python web开发,Python爬虫,Python数据分析,人工智能、自动化办公等学习教程。带你从零基础系统性的学好Python!

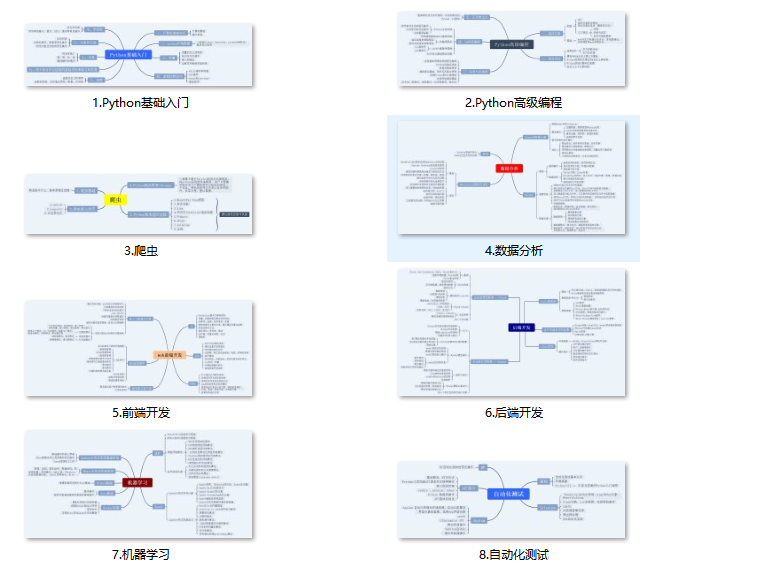

#### [](https://blog.csdn.net/Python84310366/article/details/137593575?spm=1001.2014.3001.5502)👉Python所有方向的学习路线👈

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。**(全套教程文末领取)**

#### [](https://blog.csdn.net/Python84310366/article/details/137593575?spm=1001.2014.3001.5502)👉Python学习视频600合集👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

#### [](https://blog.csdn.net/Python84310366/article/details/137593575?spm=1001.2014.3001.5502)温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

#### [](https://blog.csdn.net/Python84310366/article/details/137593575?spm=1001.2014.3001.5502)👉Python70个实战练手案例&源码👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

#### [](https://blog.csdn.net/Python84310366/article/details/137593575?spm=1001.2014.3001.5502)👉Python大厂面试资料👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自**阿里、腾讯、字节等一线互联网大厂**最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

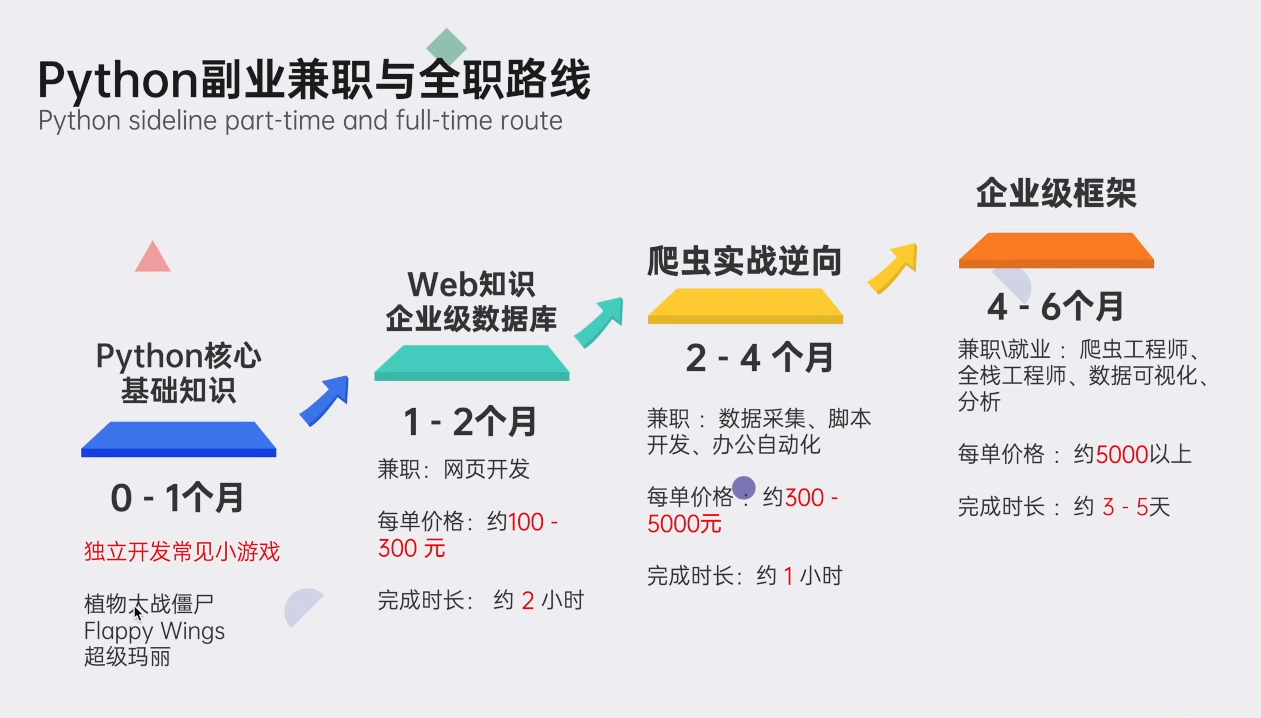

#### [](https://blog.csdn.net/Python84310366/article/details/137593575?spm=1001.2014.3001.5502)👉Python副业兼职路线&方法👈

学好 Python 不论是就业还是做副业赚钱都不错,但要学会兼职接单还是要有一个学习规划。

**👉** **这份完整版的Python全套学习资料已经上传,朋友们如果需要可以扫描下方CSDN官方认证二维码或者点击链接免费领取**【**`保证100%免费`**】

<img src="https://hnxx.oss-cn-shanghai.aliyuncs.com/official/1712471201228.jpg?t=0.9333927604578112" >

本文介绍了如何使用PythonFlask构建一个数据网站,以及如何通过Excel和Python爬虫从该网站及WebAPI获取数据,包括表格抓取和RESTfulAPI操作的详细步骤。

本文介绍了如何使用PythonFlask构建一个数据网站,以及如何通过Excel和Python爬虫从该网站及WebAPI获取数据,包括表格抓取和RESTfulAPI操作的详细步骤。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?