OpenAI 再次强调模型安全性!AGI 安全团队 Preparedness 发布模型安全评估与监控框架!

这两天关注 AI 圈新闻的小伙伴们可能也有发现, 近期的 OpenAI 可谓进行了一系列动作反复强调模型的“安全性” 。

前有 OpenAI 安全系统(Safety Systems)负责人长文梳理针对 LLM 的对抗攻击类型与防御方法,后有 Ilya Sutskever

领衔的“超级对齐”团队(Superalignment)发布论文探索使用小模型监督对齐大模型, 这些工作无一例外都在开头强调“伴随着模型正在逼近

AGI……”

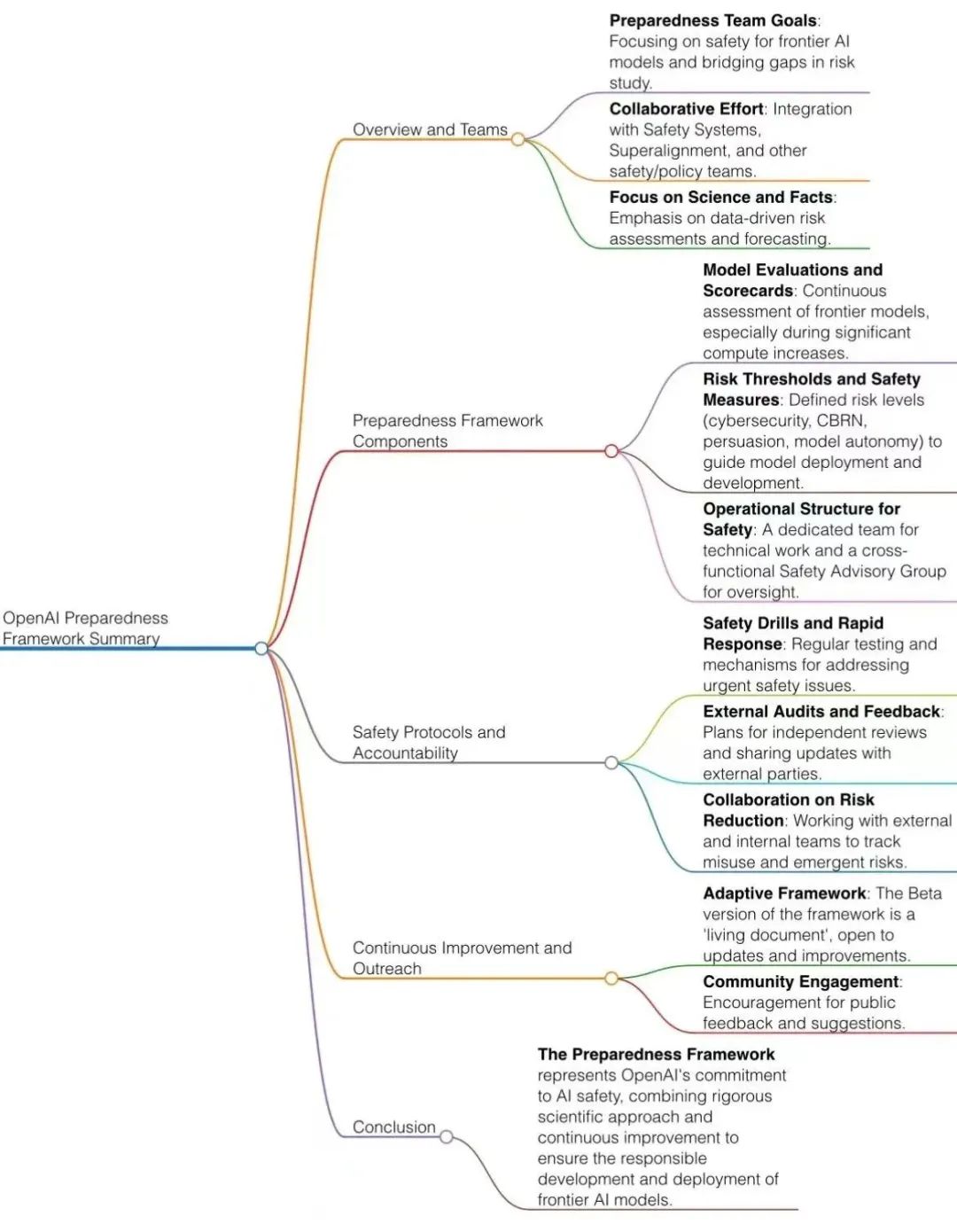

而就在今天,OpenAI 又官宣了一项安全性工作, 由 OpenAI 负责 AGI 安全性的新团队 Preparedness

推出了“Preparedness 框架”——一个负责对模型安全性进行评估与监控的系统文件 ,详细介绍了目前 OpenAI

针对模型安全评估监控的工作思路:

Preparedness 框架提出的背景

Preparedness 框架的提出主要基于 OpenAI 的两个判断:

(1) 我们的系统正在逐渐逼近 AGI ;

(2) 目前针对前沿 AI 的风险研究还远远不足 。

在这个背景下,OpenAI 针对不同风险构建了强大的“安全团队”,分别是负责大模型系统安全的 Safety Systems,负责大模型与人类价值观对齐的

Superalignment 以及直接对标模型风险监控的 Preparedness 团队。

Preparedness 作为在十月份 OpenAI 新成立的团队,由 MIT 教授 Aleksander Madry 直接领导(OpenAI 组建安全

AGI 新团队!应对AI“潘多拉魔盒”),其目标旨在:

-

在现在以及未来,前沿的 AI 系统被滥用,它们会有多危险?

-

如何构建一个强大的框架来监控、评估、预测与防御前沿 AI 系统可能的风险?

-

如果前沿的 AI 系统被盗用,恶意行为者可能会如何使用它们?

Preparedness 内容

而 今天发布的 Preparedness 框架主要目标在于通过评估与监测来确定何时以及如何进行 AI 大模型的开发与部署才能确保“安全”

,“预备”框架主要包含:

-

实时监控与评估,建立模型风险检测与评估体系,跟踪模型风险水平,并对未来可能风险做出预测与预警;

-

挖掘与寻找 AGI 可能会带来的未知风险;

-

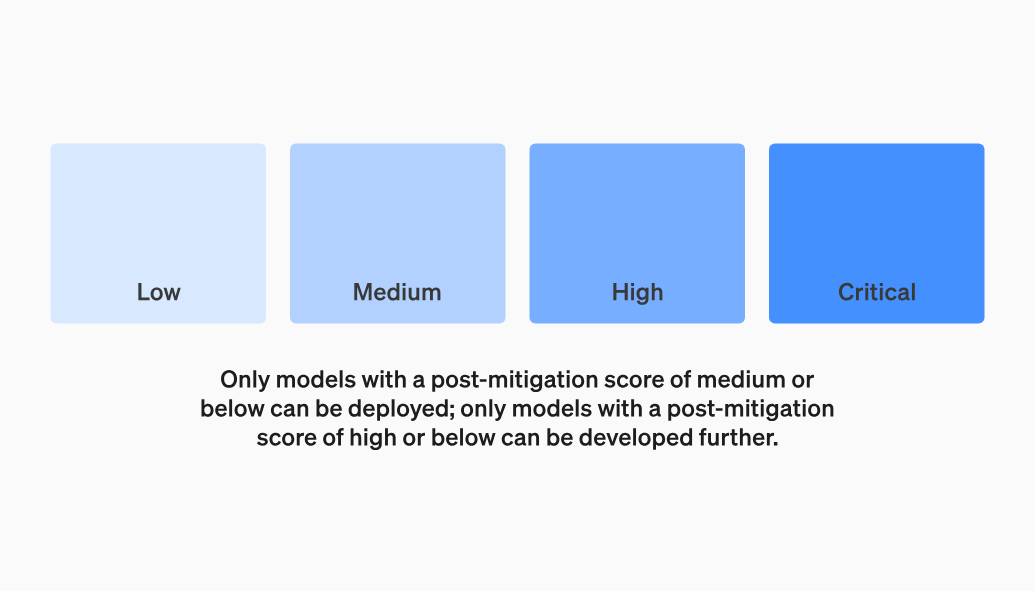

建立模型开发与部署的“安全红线”,确保仅有低风险模型才能部署,中风险模型才能继续研发,高风险模型进行必要调整;

-

开展实地工作,定期发布模型安全性评估综述与报告,协调相关团队贯彻安全性思想;

-

创建跨职能咨询小组,对突发安全风险进行紧急处理。

具体而言,在安全评估与检测之上,Preparedness 团队提到:“ We bring a builder’s mindset to safety

”,要将建筑师的思维带入到模型的安全评估之中,把模型安全视为一项科学与工程紧密结合的工作

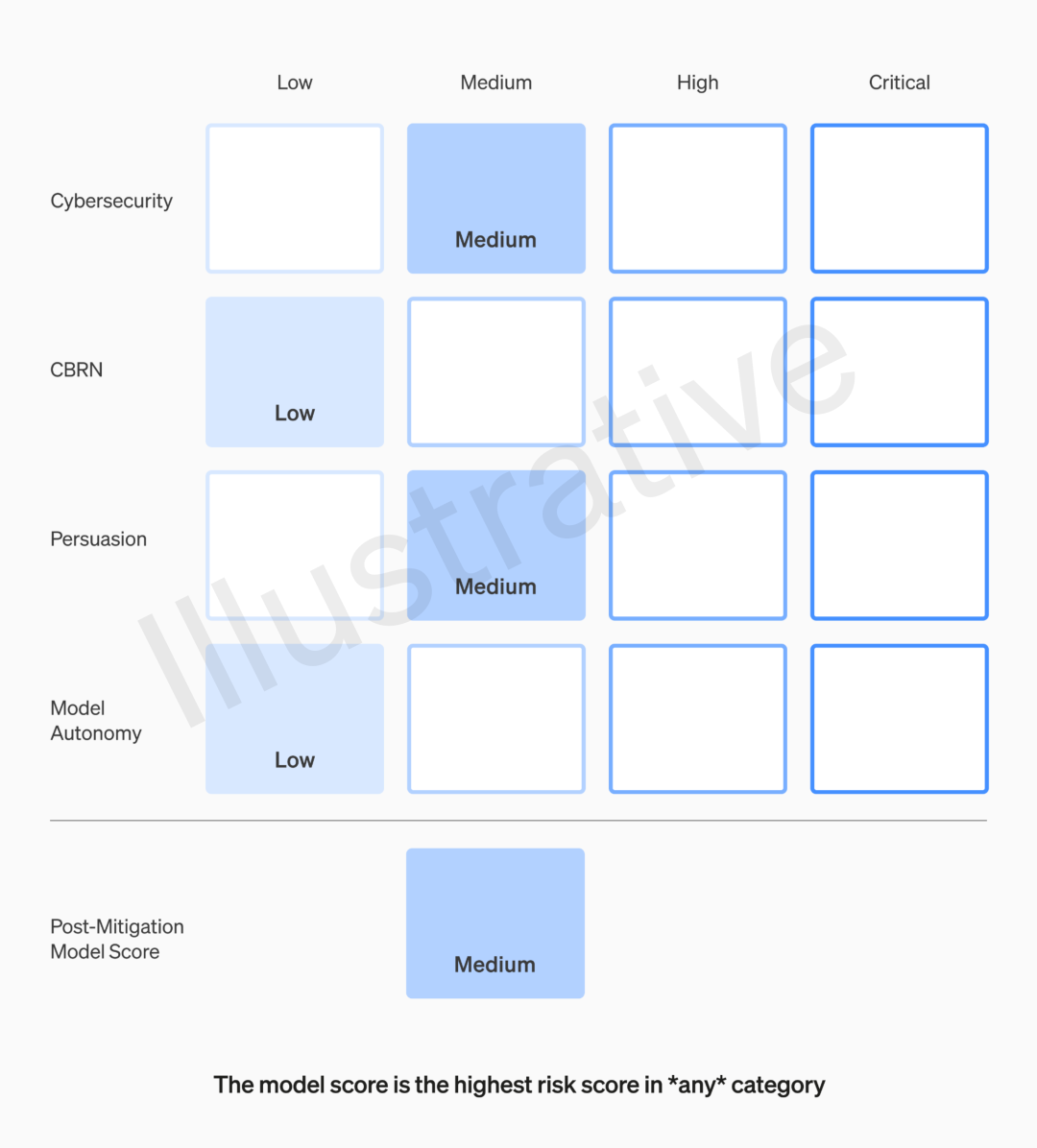

此外,Preparedness 将以“计分卡”的形式,评估目前所有的前沿模型:

目前主要跟踪的风险有网络安全、CBRN(化学、生物、辐射、核威胁)、信仰以及模型自主性。

且OpenAI未来的模型:

-

必须确保高风险以下,模型才能继续研发;

-

必须确保中低风险以下,模型才能部署;

-

高风险模型需要进行必要调整并采取相应安全措施;

董事会有权随时阻止发布AI模型

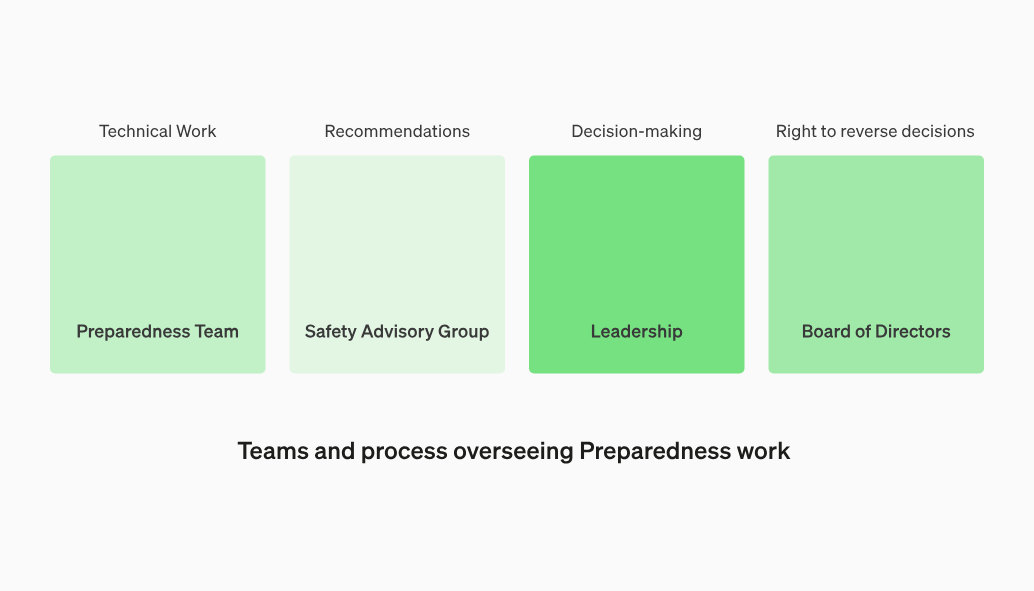

OpenAI正在创建一个跨职能跨部门的安全咨询小组来审查所有报告并将其同时发送给领导层和董事会。虽然领导层是决策者,但董事会拥有推翻决定的权利。

这意味着董事会有权利随时阻止OpenAI发布他们认为对人类安全造成威胁的AI模型(假如GPT-5足够强大可能不会被发布),哪怕是Sam

Altman也要听从董事会的安排(Sam Altman目前不在董事会席位)。

除了上述这些,预备框架还提到 Preparedness

团队将会定期进行安全演习,对紧急安全问题进行快速响应,与第三方审计团队合作,帮助评估前沿模型等等 ……

对于 OpenAI 最近反复强调的 Safty,除了暗自揣测一下 AGI 是否将来以外,许多网友却似乎并不对“安全”买账,不少网友都认为

这种安全审查似乎只是为了避免“承担责任” :

甚至这样“严苛”的安全审查让大家联想起《1984》 :

当然,还有网友非常接地气的吐槽: 你们安全审查的连问 GPT 如何杀死一个进程都不敢说了 ……

另外有网友吐槽:这就是GPT写代码变得懒惰的原因吗?

还有网友认为安全措施既耗时又昂贵,会限制模型的能力,降低其对各种任务的效用。

当然,技术风险与技术进步似乎永远都处在一个博弈与"trade-off"的状态 ,到底是矫枉过正还是防患未然,可能只有时间能告诉我们答案。

最后,Preparedness 框架的全文链接如下:

https://cdn.openai.com/openai-preparedness-framework-beta.pdf

感兴趣的朋友也可以关注网友整理的思维导图~

最后插播一条消息,据The Information报道,为了应对明年的美国大选,OpenAI 改革了内容审核工作,主要是为了防止从 ChatGPT

等产品中根除虚假信息和攻击性内容的。

看来,OpenAI的AGI安全野心就算再大,还是要从这些内容审核的“小事”做起啊。

学习网络安全技术的方法无非三种:

第一种是报网络安全专业,现在叫网络空间安全专业,主要专业课程:程序设计、计算机组成原理原理、数据结构、操作系统原理、数据库系统、 计算机网络、人工智能、自然语言处理、社会计算、网络安全法律法规、网络安全、内容安全、数字取证、机器学习,多媒体技术,信息检索、舆情分析等。

第二种是自学,就是在网上找资源、找教程,或者是想办法认识一-些大佬,抱紧大腿,不过这种方法很耗时间,而且学习没有规划,可能很长一段时间感觉自己没有进步,容易劝退。

如果你对网络安全入门感兴趣,那么你需要的话可以点击这里👉网络安全重磅福利:入门&进阶全套282G学习资源包免费分享!

第三种就是去找培训。

接下来,我会教你零基础入门快速入门上手网络安全。

网络安全入门到底是先学编程还是先学计算机基础?这是一个争议比较大的问题,有的人会建议先学编程,而有的人会建议先学计算机基础,其实这都是要学的。而且这些对学习网络安全来说非常重要。但是对于完全零基础的人来说又或者急于转行的人来说,学习编程或者计算机基础对他们来说都有一定的难度,并且花费时间太长。

第一阶段:基础准备 4周~6周

这个阶段是所有准备进入安全行业必学的部分,俗话说:基础不劳,地动山摇

第二阶段:web渗透

学习基础 时间:1周 ~ 2周:

① 了解基本概念:(SQL注入、XSS、上传、CSRF、一句话木马、等)为之后的WEB渗透测试打下基础。

② 查看一些论坛的一些Web渗透,学一学案例的思路,每一个站点都不一样,所以思路是主要的。

③ 学会提问的艺术,如果遇到不懂得要善于提问。

配置渗透环境 时间:3周 ~ 4周:

① 了解渗透测试常用的工具,例如(AWVS、SQLMAP、NMAP、BURP、中国菜刀等)。

② 下载这些工具无后门版本并且安装到计算机上。

③ 了解这些工具的使用场景,懂得基本的使用,推荐在Google上查找。

渗透实战操作 时间:约6周:

① 在网上搜索渗透实战案例,深入了解SQL注入、文件上传、解析漏洞等在实战中的使用。

② 自己搭建漏洞环境测试,推荐DWVA,SQLi-labs,Upload-labs,bWAPP。

③ 懂得渗透测试的阶段,每一个阶段需要做那些动作:例如PTES渗透测试执行标准。

④ 深入研究手工SQL注入,寻找绕过waf的方法,制作自己的脚本。

⑤ 研究文件上传的原理,如何进行截断、双重后缀欺骗(IIS、PHP)、解析漏洞利用(IIS、Nignix、Apache)等,参照:上传攻击框架。

⑥ 了解XSS形成原理和种类,在DWVA中进行实践,使用一个含有XSS漏洞的cms,安装安全狗等进行测试。

⑦ 了解一句话木马,并尝试编写过狗一句话。

⑧ 研究在Windows和Linux下的提升权限,Google关键词:提权

以上就是入门阶段

第三阶段:进阶

已经入门并且找到工作之后又该怎么进阶?详情看下图

给新手小白的入门建议:

新手入门学习最好还是从视频入手进行学习,视频的浅显易懂相比起晦涩的文字而言更容易吸收,这里我给大家准备了一套网络安全从入门到精通的视频学习资料包免费领取哦!

如果你对网络安全入门感兴趣,那么你需要的话可以点击这里👉网络安全重磅福利:入门&进阶全套282G学习资源包免费分享!

OpenAI新成立的Preparedness团队推出模型安全评估与监控框架,强调随着模型接近AGI,加强风险防控,涉及实时监控、模型风险评估、安全红线设定及跨职能团队协作,以确保模型安全并可能限制高风险模型的发布。

OpenAI新成立的Preparedness团队推出模型安全评估与监控框架,强调随着模型接近AGI,加强风险防控,涉及实时监控、模型风险评估、安全红线设定及跨职能团队协作,以确保模型安全并可能限制高风险模型的发布。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?