文末有福利领取哦~

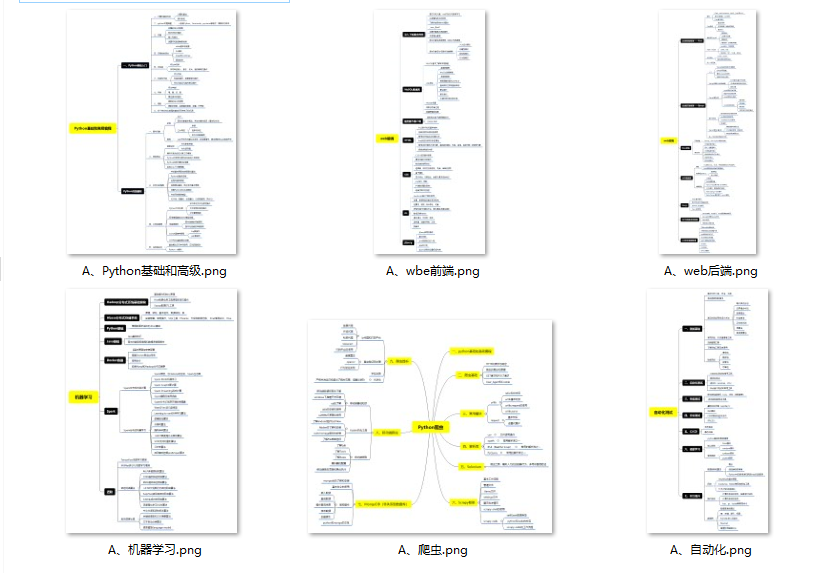

👉一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉二、Python必备开发工具

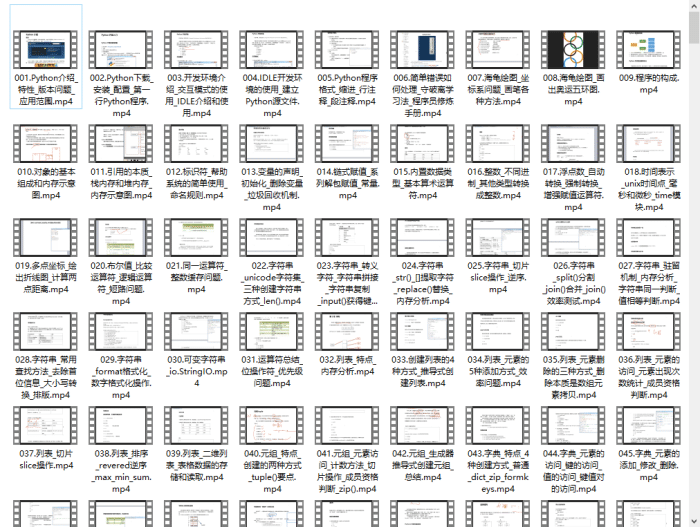

👉三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

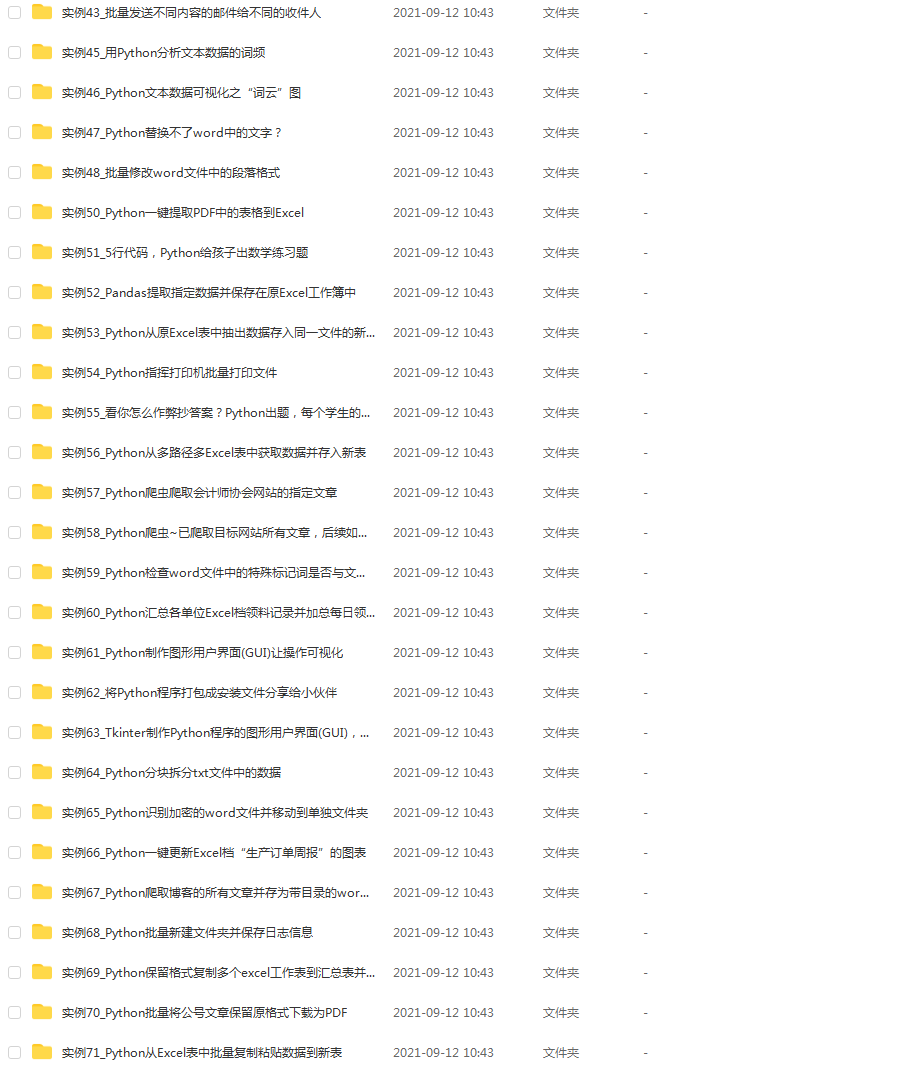

👉 四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(文末领读者福利)

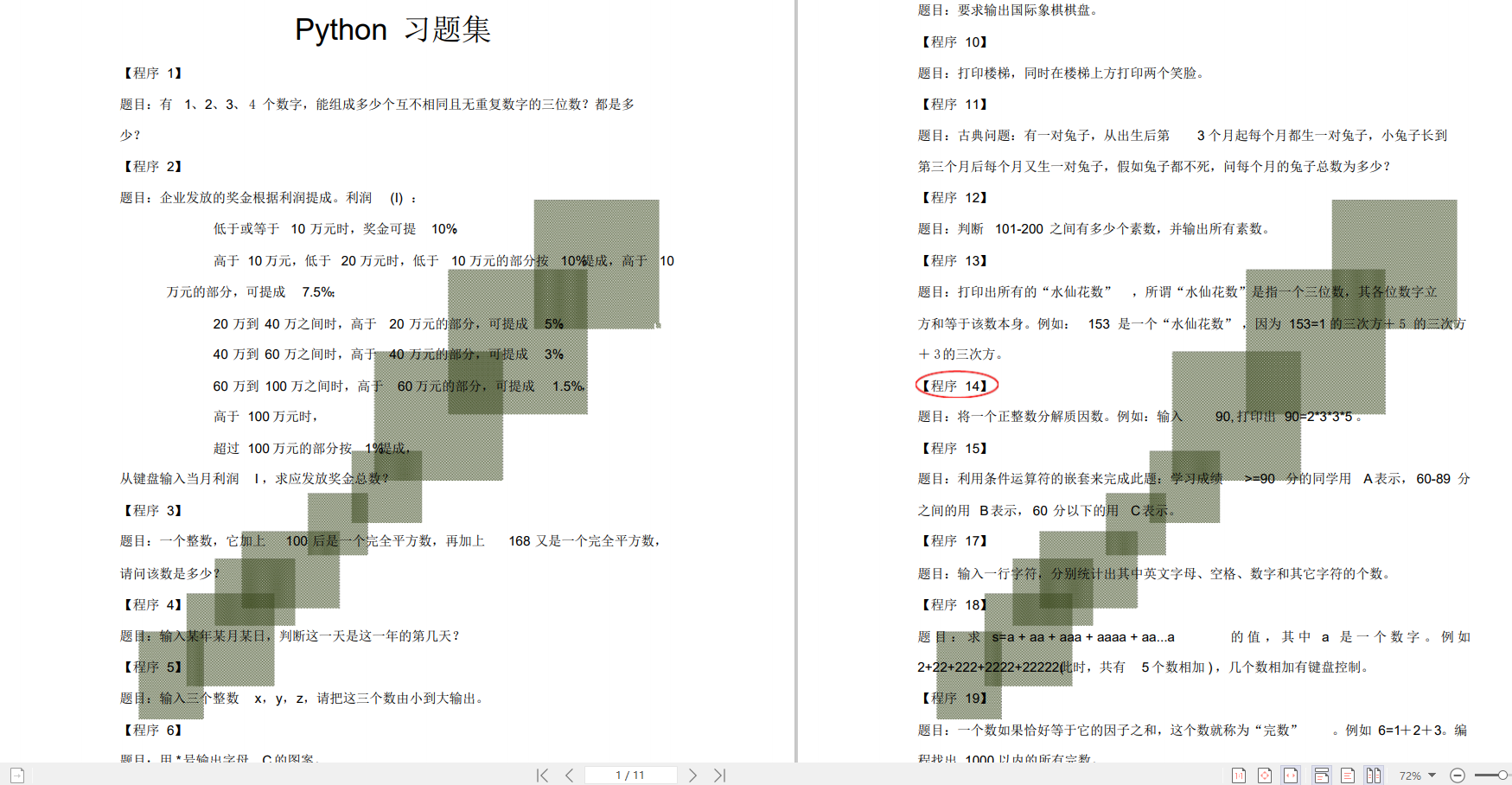

👉五、Python练习题

检查学习结果。

👉六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

👉因篇幅有限,仅展示部分资料,这份完整版的Python全套学习资料已经上传

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

# 查找class属性为"intro"的<div>标签

div_tags = soup.find_all('div', attrs={'class': 'intro'})

for div_tag in div_tags:

print(div_tag.text)

在上面的例子中,我们使用find_all()方法的attrs参数来查找class属性为"intro"的<div>标签,并使用循环遍历打印每个标签的文本内容。

案例

案例1:解析天气预报

假设我们需要获取某个城市的天气预报信息,我们可以使用Python爬虫和BeautifulSoup库来解析相关网页内容。以下是一个简单的例子:

from bs4 import BeautifulSoup

import requests

# 发起请求,获取天气预报网页内容

url = 'https://www.xxxx.com'

response = requests.get(url)

html_content = response.text

# 创建BeautifulSoup对象

soup = BeautifulSoup(html_content, 'html.parser')

# 解析天气预报网页内容

forecast_tag = soup.find('div', attrs={'class': 'forecast'})

print('天气预报:', forecast_tag.text)

在上面的例子中,我们使用requests模块发起请求,获取天气预报网页的HTML内容。然后,我们使用BeautifulSoup()方法创建一个BeautifulSoup对象,传入网页的HTML内容和解析器类型。接下来,我们使用find()方法查找class属性为"forecast"的<div>标签,并使用text属性获取标签内的文本内容,即天气预报信息。

案例2:解析新闻标题和链接

假设我们需要获取某个新闻网站上的新闻标题和链接,我们同样可以使用Python爬虫和BeautifulSoup库来解析相关网页内容。以下是一个简单的例子:

from bs4 import BeautifulSoup

import requests

# 发起请求,获取新闻网页内容

url = 'https://www.xxxx.com'

response = requests.get(url)

html_content = response.text

# 创建BeautifulSoup对象

soup = BeautifulSoup(html_content, 'html.parser')

# 解析新闻网页内容

news_tags = soup.find_all('a', attrs={'class': 'news-link'})

for news_tag in news_tags:

title = news_tag.text

link = news_tag['href']

print('标题:', title)

print('链接:', link)

在上面的例子中,我们使用requests模块发起请求,获取新闻网页的HTML内容。然后,我们使用BeautifulSoup()方法创建一个BeautifulSoup对象,传入网页的HTML内容和解析器类型。接下来,我们使用find_all()方法查找class属性为"news-link"的<a>标签,并使用循环遍历打印每个标签的标题和链接信息。

练习题:

- 编写一个爬虫程序,从某个在线商城的首页提取热门商品的名称和价格信息。

- 编写一个爬虫程序,从某个新闻网站的首页提取新闻标题、发布时间和摘要信息。

- 尝试使用CSS选择器来解析网页内容,将以上案例中的查找标签的代码改写成使用CSS选择器的方式。

- 尝试使用正则表达式来解析网页内容,提取符合特定模式的信息。

- 尝试使用BeautifulSoup库的其他功能,如处理XML文档、修复不完整的HTML等。

以上练习题可以帮助你进一步练习和掌握Python爬虫解析网页内容的技巧和方法。通过不断练习和实践,你可以逐渐提升自己的爬虫能力,并应用到更广泛的领域中。

除了上述的基本用法,BeautifulSoup库还提供了许多其他的方法和功能,用于处理不同的解析场景。例如,我们可以使用CSS选择器来定位标签,使用正则表达式来匹配内容等等。这些功能使得BeautifulSoup库在解析网页内容时非常灵活和强大。

Python爬虫解析网页内容是非常有用的技能。通过使用BeautifulSoup库,我们可以方便地解析HTML和XML文档,提取网页中的信息。无论是进行数据采集、信息抓取还是网页分析,都可以使用Python爬虫和BeautifulSoup库来解析网页内容,帮助我们更好地获取和利用网页中的有价值信息。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

963

963

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?