先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

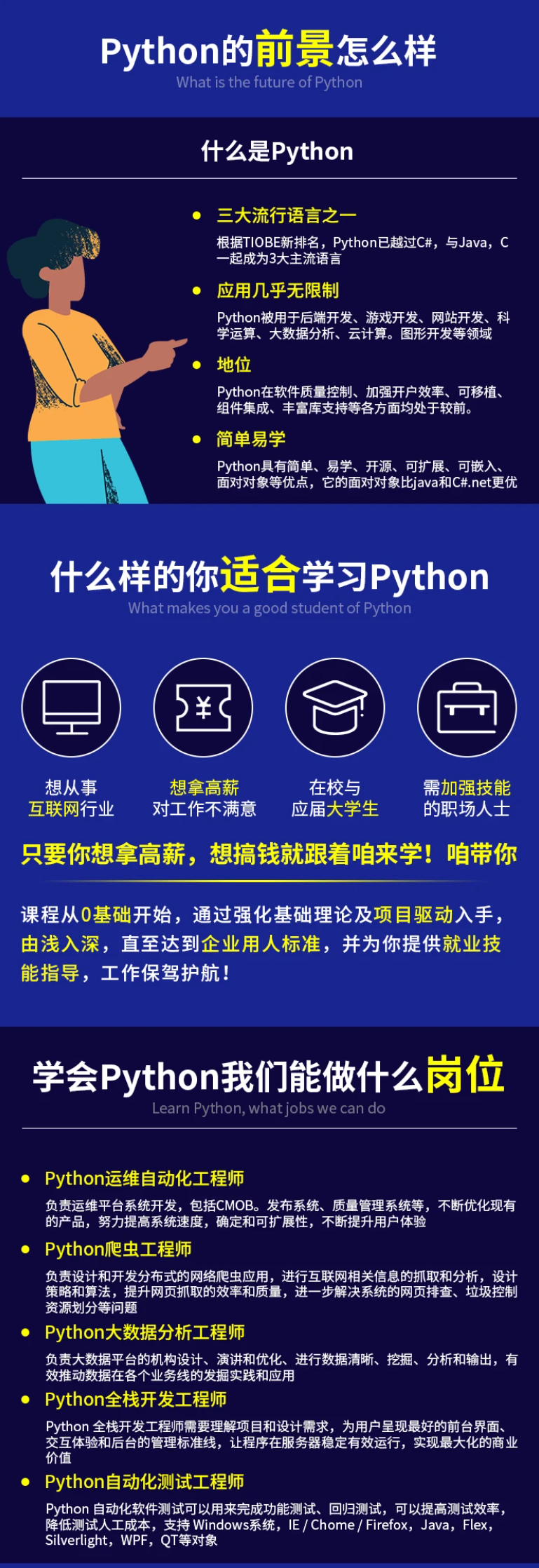

因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Python知识点,真正体系化!

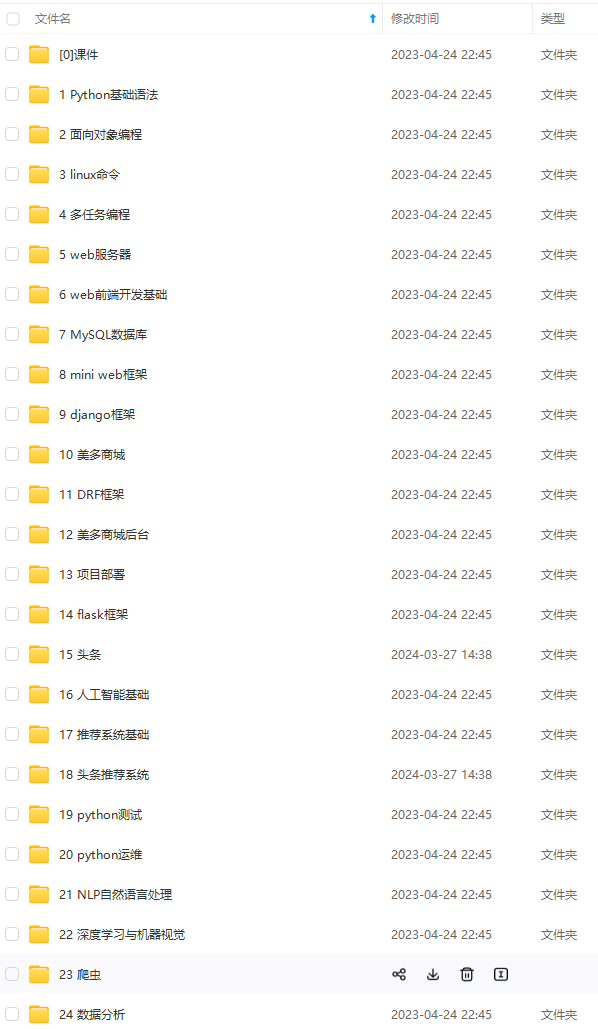

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip1024c (备注Python)

正文

京东网站,一般是动态加载的,也就是说,采用一般方式只能爬取到某个页面的前30个数据(一个页面一共60个数据)。

基于本文,我仅用最基本的方法,爬取了每个页面的前30条数据(如果大家有兴趣,可以 自行下去爬取所有的数据)。

那么,本文究竟爬取了哪些字段呢?我给大家做一个展示,大家有兴趣额,可以爬取更多的字段,做更为详细的分析。

下面为大家展示爬虫代码:

import pandas as pd

import requests

from lxml import etree

import chardet

import time

import re

def get_CI(url):

headers = {‘User-Agent’:‘Mozilla/5.0 (Windows NT 6.1; Win64; X64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.80 Safari/537.36’}

rqg = requests.get(url,headers=headers)

rqg.encoding = chardet.detect(rqg.content)[‘encoding’]

html = etree.HTML(rqg.text)

价格

p_price = html.xpath(‘//div/div[@class=“p-price”]/strong/i/text()’)

名称

p_name = html.xpath(‘//div/div[@class=“p-name p-name-type-2”]/a/em’)

p_name = [str(p_name[i].xpath(‘string(.)’)) for i in range(len(p_name))]

深层url

deep_ur1 = html.xpath(‘//div/div[@class=“p-name p-name-type-2”]/a/@href’)

deep_url = [“http:” + i for i in deep_ur1]

从这里开始,我们获取“二级页面”的信息

brands_list = []

kinds_list = []

for i in deep_url:

rqg = requests.get(i,headers=headers)

rqg.encoding = chardet.detect(rqg.content)[‘encoding’]

html = etree.HTML(rqg.text)

品牌

brands = html.xpath(‘//div/div[@class=“ETab”]//ul[@id=“parameter-brand”]/li/@title’)

brands_list.append(brands)

类别

kinds = re.findall(‘>类别:(.*?)’,rqg.text)

kinds_list.append(kinds)

data = pd.DataFrame({‘名称’:p_name,‘价格’:p_price,‘品牌’:brands_list,‘类别’:kinds_list})

return(data)

x = “https://search.jd.com/Search?keyword=%E7%B2%BD%E5%AD%90&qrst=1&wq=%E7%B2%BD%E5%AD%90&stock=1&page=”

url_list = [x + str(i) for i in range(1,200,2)]

res = pd.DataFrame(columns=[‘名称’,‘价格’,‘品牌’,‘类别’])

这里进行“翻页”操作

for url in url_list:

res0 = get_CI(url)

res = pd.concat([res,res0])

time.sleep(3)

保存数据

res.to_csv(‘aliang.csv’,encoding=‘utf_8_sig’)

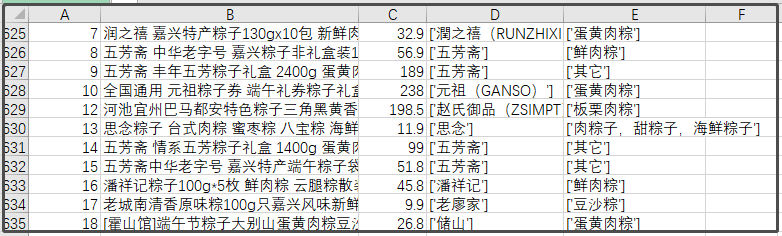

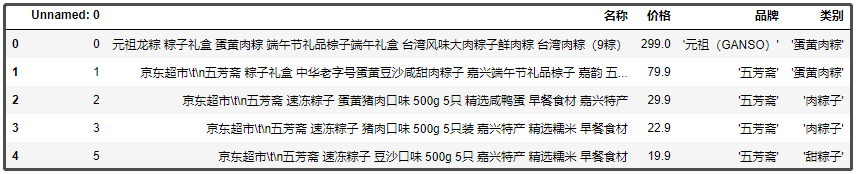

最终爬取到的数据,长这样。

数据清洗

从上图可以看到,整个数据算是很整齐的,不是特别乱,我们只做一些简单的操作即可。

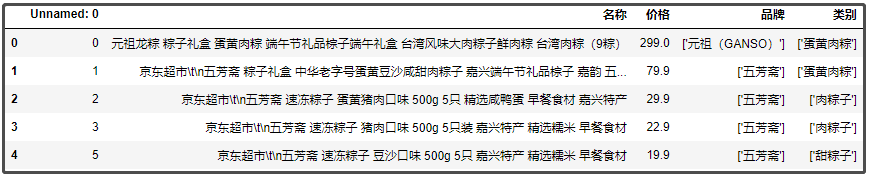

先使用pandas库,来读取数据。

import pandas as pd

df = pd.read_excel(“粽子.xlsx”,index_col=False)

df.head()

结果如下:

我们分别针对 “品牌”、“类别‘两个字段,去掉中括号。

df[“品牌”] = df[“品牌”].apply(lambda x: x[1:-1])

df[“类别”] = df[“类别”].apply(lambda x: x[1:-1])

df.head()

结果如下:

① 粽子品牌排名前10的店铺

df[“品牌”].value_counts()[:10]

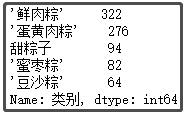

② 粽子口味排名前5的味道

def func1(x):

if x.find(“甜”) > 0:

return “甜粽子”

else:

return x

df[“类别”] = df[“类别”].apply(func1)

df[“类别”].value_counts()[1:6]

结果如下:

③ 粽子售卖价格区间划分

def price_range(x): #按照淘宝推荐划分价格区间

if x <= 50:

return ‘<50元’

elif x <= 100:

return ‘50-100元’

elif x <= 300:

return ‘100-300元’

elif x <= 500:

return ‘300-500元’

elif x <= 1000:

return ‘500-1000元’

else:

现在能在网上找到很多很多的学习资源,有免费的也有收费的,当我拿到1套比较全的学习资源之前,我并没着急去看第1节,我而是去审视这套资源是否值得学习,有时候也会去问一些学长的意见,如果可以之后,我会对这套学习资源做1个学习计划,我的学习计划主要包括规划图和学习进度表。

分享给大家这份我薅到的免费视频资料,质量还不错,大家可以跟着学习

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

mg_convert/21b2604bd33c4b6713f686ddd3fe5aff.png)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

[外链图片转存中…(img-jAE8Wtjc-1713418830245)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

4350

4350

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?