数据准备是构建定制语音搜索引擎的关键步骤之一。以下是一个简化的示例代码,展示了如何准备训练数据并生成相应的文件:

数据准备是构建定制语音搜索引擎的关键步骤之一。以下是一个简化的示例代码,展示了如何准备训练数据并生成相应的文件:

# 假设您已经收集了一些音频文件和对应的文本标注

# 步骤1:创建数据目录和相应的文件

mkdir data/train

touch data/train/wav.scp

touch data/train/text

touch data/train/utt2spk

touch data/train/spk2utt

# 步骤2:将音频文件和对应的文本信息添加到相应的文件中

# 假设您有两个音频文件audio1.wav和audio2.wav,对应的文本标注分别是"transcription1"和"transcription2"

echo "audio1 /path/to/audio1.wav" >> data/train/wav.scp

echo "audio2 /path/to/audio2.wav" >> data/train/wav.scp

echo "audio1 transcription1" >> data/train/text

echo "audio2 transcription2" >> data/train/text

# 步骤3:生成utt2spk和spk2utt文件

# 假设两个音频文件都属于同一个说话人,我们将它们都标记为"speaker1"

echo "audio1 speaker1" >> data/train/utt2spk

echo "audio2 speaker1" >> data/train/utt2spk

echo "speaker1 audio1 audio2" >> data/train/spk2utt

在上述示例中,我们创建了一个名为"data/train"的数据目录,并生成了四个文件:wav.scp、text、utt2spk和spk2utt。其中,wav.scp文件包含音频文件的路径信息,text文件包含音频文件的文本标注,utt2spk文件定义了音频文件和说话人的对应关系,spk2utt文件定义了说话人和音频文件的对应关系。

请注意,这只是一个简化的示例,实际的数据准备过程可能更加复杂,具体取决于您的数据集和需求。您可能需要进行数据清洗、标注处理、说话人划分等操作。此外,如果您的数据集很大,您可能需要将数据分成多个子集,并为每个子集创建相应的数据目录和文件。

根据您的应用场景和目标,确保您的训练数据包含多样化的语音样本和对应的文本标注是非常重要的。这样可以提高模型的泛化能力和识别准确性。

四、特征提取示例代码

在Kaldi中进行特征提取可以使用特征提取工具和相应的配置文件。以下是一个示例代码,展示了如何使用Kaldi提取MFCC特征:

在Kaldi中进行特征提取可以使用特征提取工具和相应的配置文件。以下是一个示例代码,展示了如何使用Kaldi提取MFCC特征:

# 假设您已经准备好了数据目录和文件,如上一个示例中的"data/train"

# 步骤1:创建特征目录和相应的文件

mkdir data/train_mfcc

touch data/train_mfcc/feats.scp

touch data/train_mfcc/cmvn.scp

# 步骤2:使用Kaldi的特征提取工具进行MFCC特征提取

compute-mfcc-feats --config conf/mfcc.conf scp:data/train/wav.scp ark:- | \

apply-cmvn --norm-vars=true scp:data/train/cmvn.scp ark:- ark:- | \

add-deltas ark:- ark:- | \

copy-feats --compress=true ark:- ark,scp:data/train_mfcc/feats.ark,data/train_mfcc/feats.scp

# 步骤3:计算特征的均值和方差并保存到cmvn.scp文件中

compute-cmvn-stats --spk2utt=ark:data/train/spk2utt scp:data/train_mfcc/feats.scp ark,scp:data/train_mfcc/cmvn.ark,data/train_mfcc/cmvn.scp

在上述示例中,我们首先创建了一个名为"data/train_mfcc"的特征目录,并生成了两个文件:feats.scp和cmvn.scp。feats.scp文件包含了MFCC特征的路径信息,cmvn.scp文件包含了特征的均值和方差信息。

接下来,我们使用Kaldi提供的特征提取工具进行MFCC特征提取。具体来说,我们使用compute-mfcc-feats命令计算MFCC特征,然后使用apply-cmvn命令进行归一化,再使用add-deltas命令添加差分特征。最后,我们使用copy-feats命令将特征保存到feats.scp文件中。

在步骤3中,我们使用compute-cmvn-stats命令计算特征的均值和方差,并将结果保存到cmvn.scp文件中。这些均值和方差信息将在训练和解码过程中用于特征归一化。

请注意,上述示例中的配置文件"conf/mfcc.conf"用于指定MFCC特征提取的参数,您可以根据需要进行相应的配置和参数调整。此外,您可能还需要根据实际情况调整特征提取的流程和参数,例如添加VAD(Voice Activity Detection)处理、调整特征维度等。

这只是一个示例,Kaldi提供了丰富的特征提取工具和配置选项,您可以根据自己的需求选择适合的特征,并根据数据进行相应的配置和参数调整。您可以参考Kaldi的官方文档和示例来了解更多关于特征提取的细节和用法。

五、声学模型训练示例代码

在Kaldi中进行声学模型训练可以使用相应的训练脚本和配置文件。以下是一个示例代码,展示了如何使用Kaldi进行GMM-HMM声学模型训练:

在Kaldi中进行声学模型训练可以使用相应的训练脚本和配置文件。以下是一个示例代码,展示了如何使用Kaldi进行GMM-HMM声学模型训练:

# 假设您已经准备好了数据目录和特征文件,如上述示例中的"data/train\_mfcc"

# 步骤1:创建声学模型目录和相应的文件

mkdir exp/tri1

touch exp/tri1/tree

touch exp/tri1/final.mdl

# 步骤2:使用Kaldi的训练脚本进行GMM-HMM声学模型训练

steps/train_mono.sh --boost-silence 1.25 --nj 4 data/train_mfcc data/lang exp/mono

# 步骤3:对齐数据

steps/align_si.sh --boost-silence 1.25 --nj 4 data/train_mfcc data/lang exp/mono exp/mono_ali

# 步骤4:训练三角形式的声学模型

steps/train_deltas.sh --boost-silence 1.25 --cmd run.pl 2000 10000 data/train_mfcc data/lang exp/mono_ali exp/tri1

# 步骤5:编译解码图

utils/mkgraph.sh data/lang_test exp/tri1 exp/tri1/graph

# 步骤6:解码

steps/decode.sh --nj 4 exp/tri1/graph data/test_mfcc exp/tri1/decode

在上述示例中,我们首先创建了一个名为"exp/tri1"的声学模型目录,并生成了两个文件:tree和final.mdl。tree文件定义了声学模型的拓扑结构,final.mdl文件保存了训练得到的最终模型。

接下来,我们使用Kaldi提供的训练脚本进行声学模型训练。具体来说,我们使用train_mono.sh脚本进行单音素模型训练,然后使用align_si.sh脚本对数据进行对齐,最后使用train_deltas.sh脚本训练三角形式的声学模型。

在步骤5中,我们使用mkgraph.sh脚本编译解码图,该图将在解码过程中用于生成最终的识别结果。

在步骤6中,我们使用decode.sh脚本进行解码,将训练得到的声学模型应用于测试数据,并生成解码结果。

请注意,上述示例中的命令和参数仅供参考,您可能需要根据实际情况进行相应的调整和扩展。例如,您可以尝试不同的声学模型结构、训练算法和超参数设置,以获得更好的识别性能。此外,您还可以根据需要进行数据处理、特征选择、模型调优等操作。

这只是一个示例,Kaldi提供了丰富的训练脚本和工具,支持多种声学模型的训练。您可以参考Kaldi的官方文档和示例来了解更多关于声学模型训练的细节和用法。

六、语言模型训练示例代码

在Kaldi中进行语言模型训练可以使用不同的工具和库,如ngram-count和SRILM。以下是一个示例代码,展示了如何使用SRILM进行语言模型训练:

在Kaldi中进行语言模型训练可以使用不同的工具和库,如ngram-count和SRILM。以下是一个示例代码,展示了如何使用SRILM进行语言模型训练:

# 假设您已经准备好了训练数据文件,如"data/train/text"

# 步骤1:创建语言模型目录和相应的文件

mkdir data/lang

touch data/lang/words.txt

touch data/lang/G.fst

# 步骤2:使用Kaldi的脚本生成词汇表

utils/prepare_lang.sh --position-dependent-phones false data/local/dict "<UNK>" data/local/lang data/lang

# 步骤3:将训练数据转换为ARPA格式

text2wfreq < data/train/text | wfreq2vocab -top 50000 > data/lang/vocab.txt

text2idngram -vocab data/lang/vocab.txt -idngram data/lang/train.idngram < data/train/text

# 步骤4:使用SRILM训练语言模型

ngram-count -order 3 -text data/lang/train.idngram -lm data/lang/train.lm

# 步骤5:将训练得到的语言模型转换为Kaldi的二进制格式

arpa2fst --disambig-symbol=#0 --read-symbol-table=data/lang/words.txt data/lang/train.lm data/lang/G.fst

在上述示例中,我们首先创建了一个名为"data/lang"的语言模型目录,并生成了两个文件:words.txt和G.fst。words.txt文件包含了词汇表信息,G.fst文件保存了训练得到的语言模型。

接下来,我们使用Kaldi提供的脚本生成词汇表。具体来说,我们使用prepare_lang.sh脚本根据字典文件和未知词标记""生成词汇表。

在步骤3中,我们将训练数据转换为ARPA格式,并使用ngram-count命令基于训练数据训练语言模型。在此示例中,我们将n-gram的大小设置为3,您可以根据需要进行相应的调整。

在步骤5中,我们使用arpa2fst命令将训练得到的语言模型转换为Kaldi的二进制格式,以便在识别过程中使用。

请注意,上述示例中的命令和参数仅供参考,您可能需要根据实际情况进行相应的调整和扩展。例如,您可以尝试不同的n-gram大小、平滑算法和训练数据的预处理方法,以获得更好的语言模型性能。

这只是一个示例,Kaldi提供了多种工具和脚本用于语言模型训练,您可以根据自己的需求选择适合的工具和方法。您可以参考Kaldi的官方文档和示例来了解更多关于语言模型训练的细节和用法。

七、解码示例代码

在Kaldi中使用训练好的声学模型和语言模型进行解码可以使用相应的解码工具和脚本。以下是一个示例代码,展示了如何使用Kaldi进行解码:

在Kaldi中使用训练好的声学模型和语言模型进行解码可以使用相应的解码工具和脚本。以下是一个示例代码,展示了如何使用Kaldi进行解码:

# 假设您已经准备好了声学模型目录和语言模型目录,如"exp/tri1"和"data/lang"

# 步骤1:准备解码数据

mkdir data/test

# 将待解码的语音数据放入"data/test"目录,并生成相应的特征文件,如"data/test/feats.scp"

# 步骤2:使用Kaldi的脚本进行解码

steps/decode.sh --nj 4 --cmd run.pl exp/tri1/graph data/test exp/tri1/decode

# 步骤3:获取解码结果

cat exp/tri1/decode/scoring/10.tra | utils/int2sym.pl -f 2- data/lang/words.txt > exp/tri1/decode/result.txt

在上述示例中,我们首先创建了一个名为"data/test"的目录,并将待解码的语音数据放入该目录。然后,我们使用Kaldi提供的decode.sh脚本进行解码。具体来说,我们指定了解码所需的声学模型目录、语言模型目录和解码数据目录,并通过--nj参数指定了解码所使用的并行任务数。

在步骤3中,我们使用cat命令读取解码结果的整数标签文件"10.tra",并使用int2sym.pl脚本将整数标签转换为对应的词汇,生成最终的解码结果文件"result.txt"。

请注意,上述示例中的命令和参数仅供参考,您可能需要根据实际情况进行相应的调整和扩展。例如,您可以尝试不同的解码参数和配置,以获得更好的解码性能。此外,您还可以根据需要对解码结果进行后处理和评估。

这只是一个示例,Kaldi提供了多种解码工具和脚本,支持不同的解码算法和模型组合。您可以参考Kaldi的官方文档和示例来了解更多关于解码的细节和用法。

八、评估和调优示例代码

在Kaldi中,您可以使用相应的工具和脚本对识别结果进行评估,并计算准确率、召回率等指标。以下是一个示例代码,展示了如何使用Kaldi进行识别结果评估:

在Kaldi中,您可以使用相应的工具和脚本对识别结果进行评估,并计算准确率、召回率等指标。以下是一个示例代码,展示了如何使用Kaldi进行识别结果评估:

# 假设您已经准备好了识别结果文件和相应的参考文本文件,如"exp/tri1/decode/result.txt"和"data/test/text"

# 步骤1:使用Kaldi的脚本生成评估所需的文件

cat data/test/text | awk '{print $1}' > data/test/utt.list

utils/int2sym.pl -f 2- data/lang/words.txt < exp/tri1/decode/scoring/10.tra > exp/tri1/decode/scoring/decoded.txt

# 步骤2:使用Kaldi的脚本进行评估

compute-wer --text --mode=present ark:data/test/text ark:exp/tri1/decode/scoring/decoded.txt > exp/tri1/decode/scoring/wer.txt

# 步骤3:查看评估结果

cat exp/tri1/decode/scoring/wer.txt

在上述示例中,我们首先使用awk命令从参考文本文件中提取出音频文件的ID,并将其保存到"utt.list"文件中。然后,我们使用int2sym.pl脚本将解码结果的整数标签转换为对应的词汇,并将其保存到"decoded.txt"文件中。

接下来,我们使用compute-wer命令计算识别结果的词错误率(Word Error Rate,WER)。通过指定--text参数,我们告诉Kaldi使用文本格式进行评估。评估结果会保存到"wer.txt"文件中。

最后,我们使用cat命令查看评估结果。

请注意,上述示例中的命令和参数仅供参考,您可能需要根据实际情况进行相应的调整和扩展。例如,您可以使用不同的评估指标和模式,或根据需要对评估结果进行进一步处理和分析。

通过评估结果,您可以了解识别性能的准确率、召回率等指标,并根据需要进行声学模型、语言模型和其他相关参数的调整和优化,以提高识别性能。

这只是一个示例,Kaldi提供了多种工具和脚本用于识别结果评估和调优。您可以参考Kaldi的官方文档和示例来了解更多关于评估和调优的细节和用法。

九、扩展功能示例代码

当使用Kaldi构建语音搜索引擎时,您可以根据需求进一步扩展和定制其功能。以下是一些示例代码,展示了如何使用Kaldi实现一些扩展功能:

当使用Kaldi构建语音搜索引擎时,您可以根据需求进一步扩展和定制其功能。以下是一些示例代码,展示了如何使用Kaldi实现一些扩展功能:

- 关键词检测(Keyword Spotting):

# 假设您已经准备好了声学模型目录和关键词列表文件,如"exp/mono"和"data/keywords.txt"

# 步骤1:准备关键词检测数据

mkdir data/kws

# 将待检测的语音数据放入"data/kws"目录,并生成相应的特征文件,如"data/kws/feats.scp"

# 步骤2:使用Kaldi的脚本进行关键词检测

steps/kws_search.sh --cmd run.pl data/keywords.txt data/kws exp/mono/decode_kws

# 步骤3:获取关键词检测结果

cat exp/mono/decode_kws/keywords.int | utils/int2sym.pl -f 2- data/keywords.txt > exp/mono/decode_kws/result.txt

在上述示例中,我们首先创建了一个名为"data/kws"的目录,并将待检测的语音数据放入其中。然后,我们使用Kaldi提供的kws_search.sh脚本进行关键词检测。我们指定了关键词列表文件和声学模型目录,并通过--cmd参数指定了运行命令的配置。

在步骤3中,我们使用cat命令读取关键词检测结果的整数标签文件"keywords.int",并使用int2sym.pl脚本将整数标签转换为对应的关键词,生成最终的关键词检测结果文件"result.txt"。

- 说话人识别(Speaker Identification):

Kaldi提供了一些说话人识别的工具和示例,您可以参考官方文档和社区资源来了解更多关于说话人识别的细节和用法。

如果你也是看准了Python,想自学Python,在这里为大家准备了丰厚的免费学习大礼包,带大家一起学习,给大家剖析Python兼职、就业行情前景的这些事儿。

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

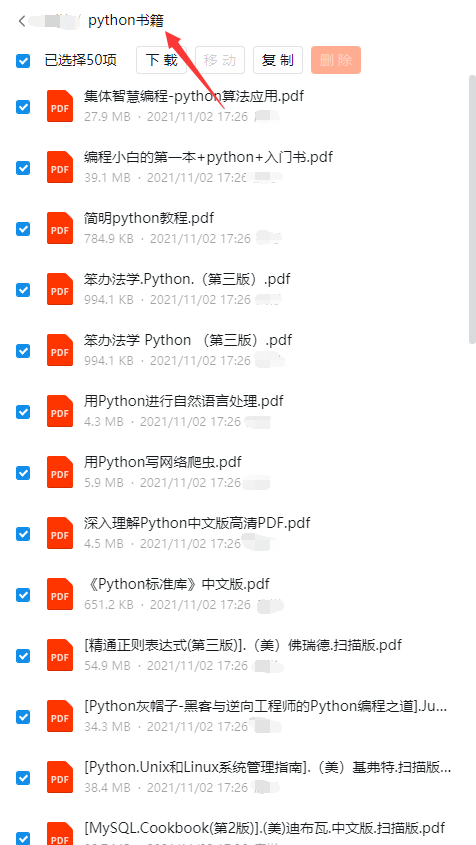

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

成为一个Python程序员专家或许需要花费数年时间,但是打下坚实的基础只要几周就可以,如果你按照我提供的学习路线以及资料有意识地去实践,你就有很大可能成功!

最后祝你好运!!!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

461

461

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?