目录

安装SSH server(SSH是专为远程登录会话和其他网络服务提供的安全性协议)

在首行插入export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

然后依次修改core-site.xml 和 hdfs-site.xml,直接在上一步的目录下进行即可

同样的,修改配置文件 hdfs-site.xml,修改为下面的配置

修改完成以上的配置,下一步,启动hadoop,第一次需要格式化,以后就不需要了。

成功启动后,可以访问 Web 界面 http://localhost:50070 查看 NameNode 和 Datanode 信息,还可以在线查看 HDFS 中的文件。

创建hadoop用户

sudo useradd -m hadoop -s /bin/bash创建hadoop密码,输入两遍(密码不显示)

sudo passwd hadoop为 hadoop 用户增加管理员权限

sudo adduser hadoop sudo更新apt(安装包管理工具)

sudo apt-get update安装更改配置文件vim(vi增强版)

sudo apt-get install vim安装SSH server(SSH是专为远程登录会话和其他网络服务提供的安全性协议)

sudo apt-get install openssh-server登录本机

ssh localhost配置SSH无密码登陆

exit # 退出刚才的 ssh localhost

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t rsa # 会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权OpenJDK:

sudo apt-get install openjdk-8-jre openjdk-8-jdk #安装jdk,不需要下载

sudo vim ~/.bashrc #编辑配置

#export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64 #这一段插入首行

source ~/.bashrc #配置立即生效

echo $JAVA_HOME #检验环境变量值

Java -version #查看版本号Hadoop 2 通过 http://mirror.bit.edu.cn/apache/hadoop/common/ 或者 http://mirrors.cnnic.cn/apache/hadoop/common/ 格式:hadoop-2.x.x.tar.gz

解压到/usr/local中

sudo tar -zxf ~/(安装包的位置)/hadoop-2.x.x.tar.gz -C /usr/local cd /usr/local/

sudo mv ./hadoop-2.6.0/ ./hadoop # 将文件夹名改为hadoop

sudo chown -R hadoop ./hadoop # 修改文件权限

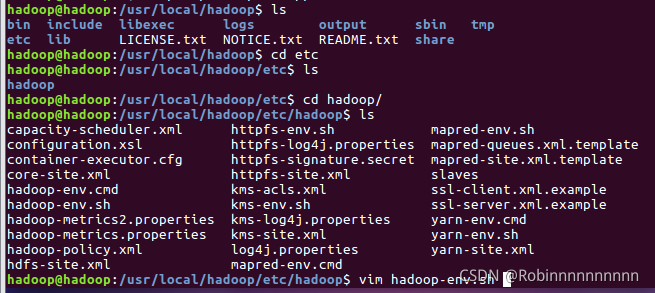

cd /usr/local/hadoop

./bin/hadoop version #检查hadoop版本修改 hadoop-env.sh 文件,操作如下:

在首行插入export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

然后依次修改core-site.xml 和 hdfs-site.xml,直接在上一步的目录下进行即可

修改配置文件 core-site.xml,将当中的

<configuration>

</configuration>修改为下面的配置

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>同样的,修改配置文件 hdfs-site.xml,修改为下面的配置

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>修改完成以上的配置,下一步,启动hadoop,第一次需要格式化,以后就不需要了。

cd /usr/local/hadoop

./bin/hdfs namenode -format #格式化hadoop中的HDFS文件系统

./sbin-dfs.sh #启动hadoop dfs然后运行jps 查看进程

必须出现这四个进程,但也有意外

意外情况

1、Jps 没有NameNode

./sbin/stop-dfs.sh #停止hadoop dfs进程

rm -r tmp #删除tmp

cd bin/

hadoop namenode -format #进行格式化

./sbin/start-dfs.sh #重启hadoop2、Jps没有DataNode

./sbin/stop-dfs.sh #停止hadoop dfs进程

rm -r ./tmp/ #删除tmp

./bin/hdfs namenode -format #进行格式化

./sbin/start-dfs.sh #重启hadoop成功启动后,可以访问 Web 界面 http://localhost:50070 查看 NameNode 和 Datanode 信息,还可以在线查看 HDFS 中的文件。

3539

3539

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?