Python深度学习实例三--房价预测(回归问题)

1.波士顿房价数据集

本节将要预测 20 世纪 70 年代中期波士顿郊区房屋价格的中位数,已知当时郊区的一些数据点,比如犯罪率、当地房产税率等。本节用到的数据集与前面深度学习实例有一个有趣的区别。它包含的数据点相对较少,只有 506 个,分为 404 个训练样本和 102 个测试样本。输入数据的每个特征(比如犯罪率)都有不同的取值范围,有的取值范围为 1~12,还有的取值范围为 0~100,等等。

加载波士顿房价数据的代码实现:

from keras.datasets import boston_housing

(train_data, train_targets), (test_data, test_targets) = boston_housing.load_data()

我们来看一下数据的样子,代码实现:

train_data

train_data.shape

test_data.shape

输出:

out:array([[1.23247e+00, 0.00000e+00, 8.14000e+00, ..., 2.10000e+01,

3.96900e+02, 1.87200e+01],

[2.17700e-02, 8.25000e+01, 2.03000e+00, ..., 1.47000e+01,

3.95380e+02, 3.11000e+00],

[4.89822e+00, 0.00000e+00, 1.81000e+01, ..., 2.02000e+01,

3.75520e+02, 3.26000e+00],

...,

[3.46600e-02, 3.50000e+01, 6.06000e+00, ..., 1.69000e+01,

3.62250e+02, 7.83000e+00],

[2.14918e+00, 0.00000e+00, 1.95800e+01, ..., 1.47000e+01,

2.61950e+02, 1.57900e+01],

[1.43900e-02, 6.00000e+01, 2.93000e+00, ..., 1.56000e+01,

3.76700e+02, 4.38000e+00]])

out:(404, 13)

out:(102, 13)

从上面代码的输出我们可以发现,一共有404个训练样本和102个测试样本,每个样本都有13个数值特征,比如人均犯罪率、每个住宅的平均房间数、高速公路可达性等。目标是房屋价格的中位数,单位是千美元。

2.准备数据

将取值范围差异很大的数据输入到神经网络中,这是有问题的。网络可能会自动适应这种

取值范围不同的数据,但学习肯定变得更加困难。对于这种数据,普遍采用的最佳实践是对每

个特征做标准化,即对于输入数据的每个特征(输入数据矩阵中的列),减去特征平均值,再除

以标准差,这样得到的特征平均值为 0,标准差为 1。代码实现:

mean = train_data.mean(axis=0)

train_data -= mean

std = train_data.std(axis=0)

train_data /= std

test_data -= mean

test_data /= std

注意,用于测试数据标准化的均值和标准差都是在训练数据上计算得到的,在工作流程中你不能使用在测试数据上计算的任何结果。

3.构建网络

from keras import models

from keras import layers

def build_model(): # 因为需要将同一个模型多次实例化,所以用一个函数来构建模型

model = models.Sequential()

model.add(layers.Dense(64, activation='relu',

input_shape=(train_data.shape[1],)))

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(1))

model.compile(optimizer='rmsprop', loss='mse', metrics=['mae'])

return model

由于样本数量很少,故使用一个非常小的网络,其中包含两个隐藏层,每层有 64 个单元。一般来说,训练数据越少,过拟合会越严重,而较小的网络可以降低过拟合。

该网络的最后一层只有一个单元,没有激活,是一个线性层。这是标量回归(标量回归是预测单一连续值的回归)的典型设置。

MSE损失函数,即均方误差(MSE,mean squared error),预测值与目标值之差的平方。这是回归问题常用的损失函数。

在训练过程中还监控一个新指标:平均绝对误差(MAE,mean absolute error)。它是预测值与目标值之差的绝对值。比如MAE 等于 0.5,就表示你预测的房价与实际价格平均相差 500 美元。

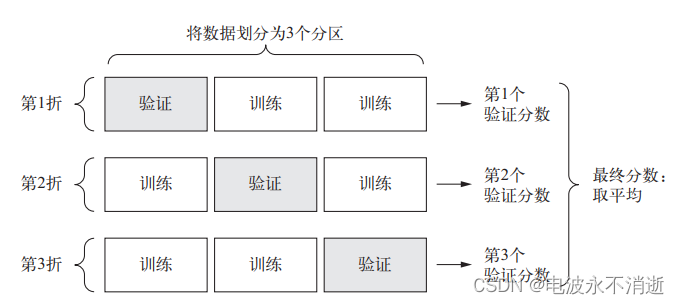

4.使用K折交叉验证

为了在调节网络参数的同时对网络进行评估,你可以将数据划分为训练集和验证集,正如前面例子中所做的那样。但由于数据点很少,验证集会非常小(比如大约100 个样本)。因此,验证分数可能会有很大波动,这取决于你所选择的验证集和训练集。也就是说,验证集的划分方式可能会造成验证分数上有很大的方差,这样就无法对模型进行可靠的评估。

在这种情况下,最佳做法是使用 K 折交叉验证(见下图)。这种方法将可用数据划分为 K个分区(K 通常取 4 或 5),实例化 K 个相同的模型,将每个模型在 K-1 个分区上训练,并在剩下的一个分区上进行评估。模型的验证分数等于 K 个验证分数的平均值。

代码实现:

k=4

num_val_samples = len(train_data) // k

num_epochs = 500

all_scores = []

all_mae_histories = []

for i in range(k):

print('processing fold #', i)

# 准备验证数据:第k个分区的数据

val_data = train_data[i * num_val_samples: (i + 1) * num_val_samples]

val_targets = train_targets[i * num_val_samples: (i + 1) * num_val_samples]

# 准备训练数据:其他所有分区的数据

partial_train_data = np.concatenate(

[train_data[:i * num_val_samples],

train_data[(i + 1) * num_val_samples:]],

axis=0)

partial_train_targets = np.concatenate(

[train_targets[:i * num_val_samples],

train_targets[(i + 1) * num_val_samples:]],

axis=0)

# 构建Keras模型

model = build_model()

# Train the model (in silent mode, verbose=0)

history = model.fit(partial_train_data, partial_train_targets,

validation_data=(val_data, val_targets),

epochs=num_epochs, batch_size=1, verbose=0)

mae_history = history.history['val_mean_absolute_error']

all_mae_histories.append(mae_history)

计算每个轮次中的K折验证分数平均值,代码实现:

average_mae_history = [

np.mean([x[i] for x in all_mae_histories]) for i in range(num_epochs)]

绘制验证分数,代码实现:

import matplotlib.pyplot as plt

plt.plot(range(1, len(average_mae_history) + 1), average_mae_history)

plt.xlabel('Epochs')

plt.ylabel('Validation MAE')

plt.show()

从头开始训练最终模型,代码实现:

model = build_model()

model.fit(train_data, train_targets,

epochs=80, batch_size=16, verbose=0)

test_mse_score, test_mae_score = model.evaluate(test_data, test_targets)

test_mae_score

输出:

2.5532484335057877

297

297

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?