yum install ntp ntpdate ntp-doc -y

设为开机启动:

systemctl enable ntpd

设置每隔1小时自动校准同步。编辑 vi /etc/rc.d/rc.local 追加:

/usr/sbin/ntpdate ntp1.aliyun.com > /dev/null 2>&1; /sbin/hwclock -w

配置定时任务, 执行crontab -e 加入:

0 */1 * * * ntpdate ntp1.aliyun.com > /dev/null 2>&1; /sbin/hwclock -w

5)免密配置(131、132、133都执行)

官方建议不用系统内置用户, 创建名为cuser用户, 密码也设为cuser:

useradd -d /home/cuser -m cuser

passwd cuser

设置sudo权限:(免密+只读权限)

echo “cuser ALL = (root) NOPASSWD:ALL” | sudo tee /etc/sudoers.d/cuser

sudo chmod 0440 /etc/sudoers.d/cuser

6)生成秘钥:(131执行)

切换用户: su cuser

执行ssh-keygen,一直按默认提示点击生成RSA密钥信息。

分发密钥至各机器节点

ssh-copy-id cuser@CENTOS1

ssh-copy-id cuser@CENTOS2

ssh-copy-id cuser@CENTOS3

修改管理节点上的 ~/.ssh/config (当前用户目录下的.ssh/config)文件, 简化SSH远程连接时的输入信息:

管理节点是会有root和cuser多个用户, ssh远程连接默认会以当前用户身份进行登陆, 如果我们是root身份进行远程连接, 还是需要输入密码,我们可以修改配置 使用root远程连接时也不用输入密码。

切换root身份,

su root

编辑config

vi ~/.ssh/config

添加如下内容:

Host CENTOS1

Hostname CENTOS1

User cuser

Host CENTOS2

Hostname CENTOS2

User cuser

Host CENTOS3

Hostname CENTOS3

User cuser

修改文件权限:

chmod 600 ~/.ssh/config

禁用SELINUX:

vi /etc/selinux/config

SELINUX=disabled

1.2.2 集群搭建

安装集群,用root安装,可以避免很多权限问题。

1)创建集群管理目录,作为ceph配置信息存储目录。

mkdir -p /usr/local/bobo/cephcluster

cd /usr/local/bobo/cephcluster

2)创建集群

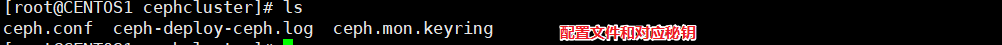

ceph-deploy new CENTOS1 CENTOS2 CENTOS3

创建成功后, 会生配置文件和秘钥信息。

3)修改配置文件

编辑ceph.conf文件vi /usr/local/bobo/cephcluster/ceph.conf,添加如下配置:

#对外开放网段

public network = 192.168.100.0/24

设置pool池默认分配数量

osd pool default size = 2

容忍更多的时钟误差

mon clock drift allowed = 2

mon clock drift warn backoff = 30

允许删除pool

mon_allow_pool_delete = true

[mgr]

开启WEB仪表盘

mgr modules = dashboard

注意:Pool是存储

本文详细介绍了Ceph分布式文件系统的集群搭建过程,包括时间同步、用户权限配置、集群安装、监控仪表盘设置、Cephfs管理及Swift API接口开发。通过实例演示了如何在多台服务器上安装Ceph,以及创建和管理存储池、用户和文件服务,为后续的文件存储和API访问打下基础。

本文详细介绍了Ceph分布式文件系统的集群搭建过程,包括时间同步、用户权限配置、集群安装、监控仪表盘设置、Cephfs管理及Swift API接口开发。通过实例演示了如何在多台服务器上安装Ceph,以及创建和管理存储池、用户和文件服务,为后续的文件存储和API访问打下基础。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1548

1548

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?