爬虫基本四个步骤:

-

获取到目标资源地址

- 选取到自己想看的漫画,这里辣条就选取的斗破苍穹,最近有在追这个动漫,特效啥的确实到位,就是更新速度太慢了,去把动漫也刷一遍(大老婆,二老婆镇楼)

当前页面是整个漫画的章节页面,需要提取出全部的章节数据信息,当前的是页面数据,但是我们的数据是需要进入到详情页面的图片信息,但是这个网址的数据是需要星钻的,我们先去解析试看的漫画,进入详情页面抓取到加载的数据信息文件

**这个数据是我们想要的漫画图片的地址,现在分析网址的加载方式:**https://www.kanman.com/api/getchapterinfov2?product_id=1&productname=kmh&platformname=pc&comic_id=25934&chapter_newid=dpcq_1h&isWebp=1&quality=middle

**这个数据是我们想要的漫画图片的地址,现在分析网址的加载方式:**https://www.kanman.com/api/getchapterinfov2?product_id=1&productname=kmh&platformname=pc&comic_id=25934&chapter_newid=dpcq_1h&isWebp=1&quality=middle

可以看出来数据的页面转换是通过chapter_newid来进行跟换的,要是需要第二页直接修改就行,那后面需要星钻的章节也迎刃而解,这里避免敏感信息就不强调了 - 选取到自己想看的漫画,这里辣条就选取的斗破苍穹,最近有在追这个动漫,特效啥的确实到位,就是更新速度太慢了,去把动漫也刷一遍(大老婆,二老婆镇楼)

-

发送网络请求,获取数据

- 发送请求,爬虫有个核心的技巧,他更多的是在模仿客户端发送网络请求,Python请求库用的比较多的是requests,想要用框架scrapy比较合适,在发送请求时带上请求头,将爬虫伪装成浏览器

-

提取数据

- 目前我们获取的数据是json数据,可以直接将数据转成字典的数据类型通过键值对进行数据的提取就行

-

保存数据

- 数据保存我们直接保存到当前的文件夹,单独的一个章节保存成一个单独的文件(或者各位看官可以自己考虑)

当前文章只限于技术分享,严禁用作其他用途!!!!

6.简易源码分享

import requests

import json

import time

import os

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36'

}

def parse(url):

print(url)

res = requests.get(url, headers=headers).json()

print(res)

chapter_name = res['data']['current\_chapter']['chapter\_name']

chapter_img_url = res['data']['current\_chapter']['chapter\_img\_list']

print(chapter_name, chapter_img_url)

path = '斗破苍穹/' + chapter_name

if not os.path.exists(path):

os.mkdir(path)

download(chapter_img_url, path) # 每次下载漫画时,需要传入相关的参数

def download(img_url_list, path):

i = 0

for img_url in img_url_list:

res = requests.get(img_url, headers=headers)

print(res.content)

filename = path + "/" + str(i) + '.jpg'

with open(filename, 'wb') as f:

f.write(res.content)

i += 1

print(f'正在下载:{path}第{str(i)}张')

time.sleep(0.5)

if __name__ == '\_\_main\_\_':

for i in range(1, 20):

url = 'https://www.kanman.com/api/getchapterinfov2?product\_id=1&productname=kmh&platformname=pc&comic\_id=25934&chapter\_newid=dpcq\_{}h&isWebp=1&quality=middle'.format(i)

parse(url)

7.总结

再次重申重点在看知识点,不要去乱尝试,我可不想看你们从入门到“坐牢”

其次详细版源码可以看底下我的个人小卡片,还有我之前的30个游戏的源码包,还有python学习路线等等都可以有的~

最后

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

👉Python所有方向的学习路线👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉Python必备开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

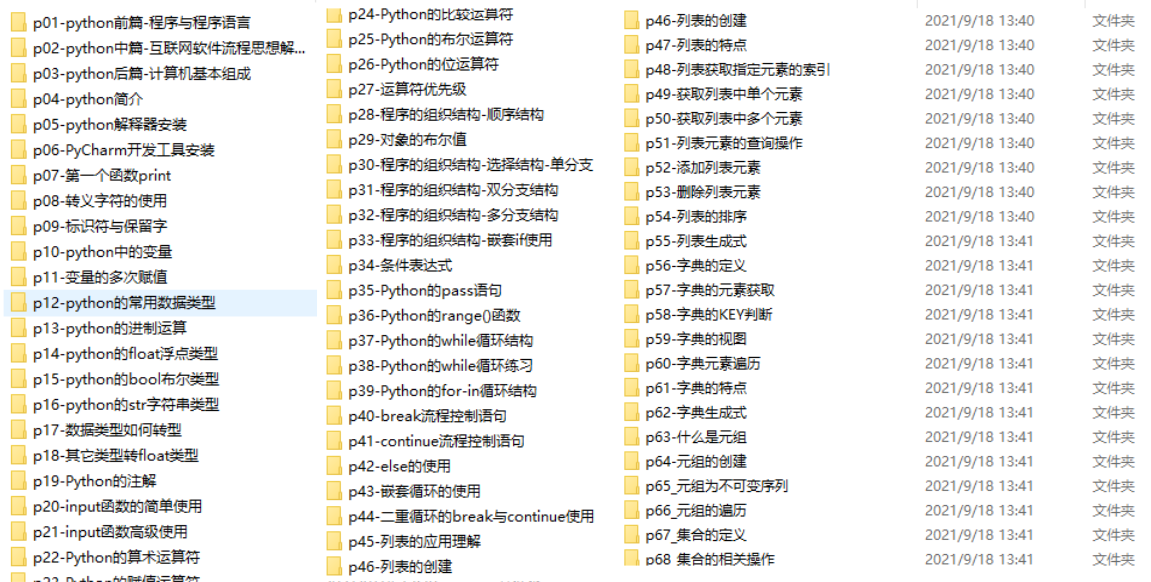

👉Python全套学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

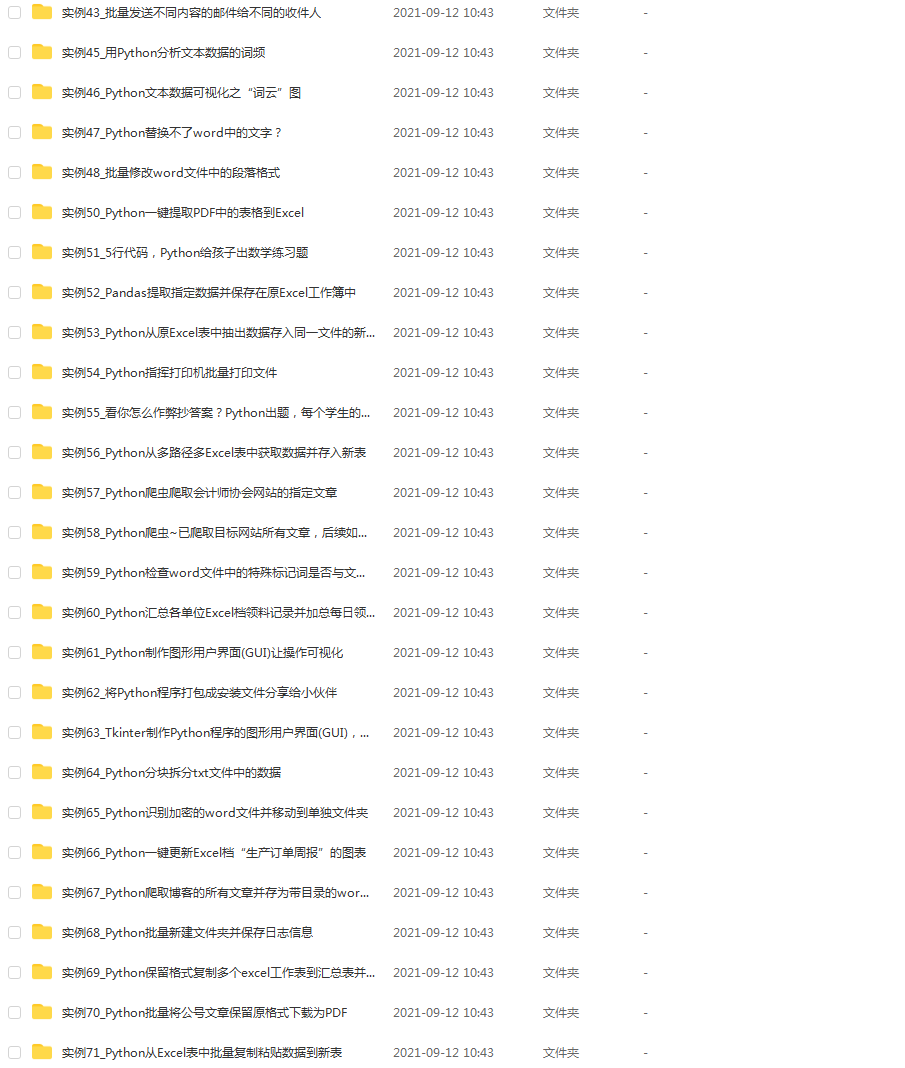

👉实战案例👈

学python就与学数学一样,是不能只看书不做题的,直接看步骤和答案会让人误以为自己全都掌握了,但是碰到生题的时候还是会一筹莫展。

因此在学习python的过程中一定要记得多动手写代码,教程只需要看一两遍即可。

👉大厂面试真题👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

142

142

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?