OneProxy分库分区设计

对于超大容量的表存储来说,MySQL支持分区表设计,可以按某一字段进行按范围 (Range)、按值列表(List) 或按散列算法(Hash) 等方法进行分区。

OneProxy将分区表的概念从数据库层抽象到了SQL的转发器层,通过对通信协议进行分析,可以根据SQL查询语句的表名及传入参数对.上层应用进行透明的智能路由,从而实现虚拟分区效果,这种分区对应用来说是完全透明的。

在OneProxy中同样支持按范围、按值列表或按散列算法进行虚拟分库分表设计,从内容上看,与MySQL创建分区表的关键信息非常类似。

下面分别对这三种分区方法的分库分表配置进行说明。

按范围分库分表

当按范围分库分表时,必须有一个针对应用的虚拟表名(Table) ,并指定一个用于 分区的字段(PKey)、字段的类型(Type) ,以及分区的方法(Method)。同时针对每-一个分区,都可以使用增加后缀( Suffix)的方式设置独立的表名,并且指定分区所在的集群分组(Group) ,以及分区字段取值的上限(Value) 等。

例如,一个订单表按范围进行分区的设计如下所示:

{

{

"table": "t order",

"pkey"

: "id",

"type" : "int",

"method" : "range",

"partitions":

{

{"suffix" : " 0","group": "group1", "value": "100000" },

{"suffix" : " 1","group": "group1", "value" : "200000" }

{"suffix":" 2","group": "group2", "value": "300000" },

{"suffix": " 3","group": "group2", "value": null}

}

}

}这样,当访问虚拟表名t _order 时,就将按其ID“value”的范围导向真实表名,如“t _order. 0”、“t_ _order_ 1”等分表中进行数据的存取操作。

按值列表分库分表

当按值列表分库分表时,其实就是在虚拟表名中指定-一个用于分区的字段、 字段的类型、以及分区的方法。同时,针对每一个分区,都可使用增加后缀( Suffix)的方式设置独立的表名,并且指定分区所在的集群分组,以及分区字段能取得的值列表等配置。当-个分区没有指定任何分区值列表时,表示所有其他的值都落入这个分区中。

例如,一个订单表按值列表进行分区的设计如下所示:

{

{

"table" : "t_order",

"pkey" : "id",

"type": "int",

"'method":"list",

"partitions":

{

{ "suffix" : "_0","group": "group1", "value" : ["1", "2", "3"] },

{ "suffix": "_1", "group": "group1", "value" : ["4","5","6"] },

{ "suffix" : "_2", "group": "group2", "value" : ["7", "8","9"] },

{ "suffix" : "_3", "group": "group2", "value" : ["10", "11", "12"] },

{ "suffix": " 4", "group": "group2", "value" :[] }

}

}

}其中,真实表名由虚拟表名及其后缀组成,例如“t_order_0”,并且数据的存取将在分到的指定集群分组中进行。

按散列算法分库分表

当按散列算法分库分表时,必须有-一个针对应用的虚拟表名(Table) ,并指定-一个用于分区的字段、字段的类型,以及分区的方法。同时,针对每-一个分区, 都可以使用增加后缀的方式设置独立的表名,并且指定分区所在的集群分组。需要注意的是,按散列算法分区并不需要为每个分区指定值范围或值列表,它们是由OneProxy里的散列算法根据分区数自动计算得来的。当按散列算法分区时,分区数量不能随便调整。

例如,一个订单表按散列算法进行分区的设计如下所示:

[

{

"table" : "t_ order",

"pkey" : "id",

"type" : "int",

"method" : "hash",

"partitions" :

[

{ "suffix" :" 0", "group": "group1" },

{ "suffix" :"group": "group2"},

{ "suffix" : " _2", "group": "group1" },

{ "suffix" :”3",, "group": "group2"}

}

}

}其中,真实表名由虚拟表名及其后缀组成,并且分别存储在指定的不同集群分组中。例如“t order_ 0”将存储于分组“group1” 中,“t _order_ 1”将存储于分组“group2"中。

针对上面三种分区方法,读者可以根据实际情况进行选用。一般建议使用散列算法进行分区,这样数据分布会比较合理。

分区的配置都是使用文本文件实现的,如果想在-一个文件中使用多个分区配置,则可以使用如下所示的格式进行配置:

{

{

"table" : "t_ goods",

"pkey" : "id",

"type" : "int",

"method"

"hash",

"partitions" :

{

{ "suffix" :" _0", "group": "group1" },

"suffix" :

"group": "group2" },

"suffix": " 2","group": "group1" },

"suffix" : "_3", "group": "group2"}

}

},

"table" : "t order",

"pkey" : "id",

"type" :

"char",

"method"

"hash",

"partitions" :

[

{"suffix" : " 0", "group": "group1" },

{"suffix":"group": "group2" }

{"suffix" :" 2", "group": "group1" },

{ "suffix" : "_3", "group": "group2"}

}

}

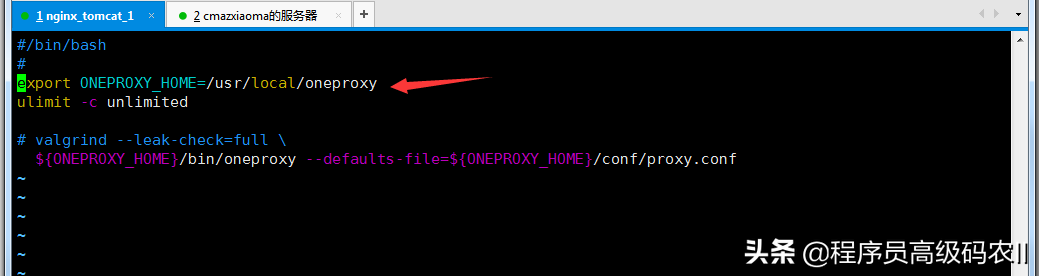

}在文件配置完成之后( 例如将配置文件保存为part1.txt) ,可以使用如下所示的方式把它加到OneProxy的配置之中:

proxy-part-tables.1 = /usr/ 1ocal/ oneproxy/conf/part1.txt双机热备设计

在使用了数据库的代理中间件之后,我们就实现了高性能的读写分离配置,但是,对于代理服务器本身,还存在-一个单点故障问题。

想要解决单点故障问题,就需要使用LVS和Keepalived实现双机热备设计。

LVS是Linux虚拟服务器的简称。Linux 内核已经完全内置了LVS的各个功能模块,它工作在OSI (Open System Interconnect)模型的网络层中,可以进行负载均衡和服务器集群设计。

Keepalived是一个交换机软件,工作在OSI模型的网络层、传输层和应用层中,主要提供负载均衡和高可用等功能。负载均衡的实现需要依赖LVS内核的IPVS模块,而高可用是通过VRRP (Virtual Router Redundancy Protocol,虚拟路由冗余协议)实现多台机器之间的故障转移服务的。

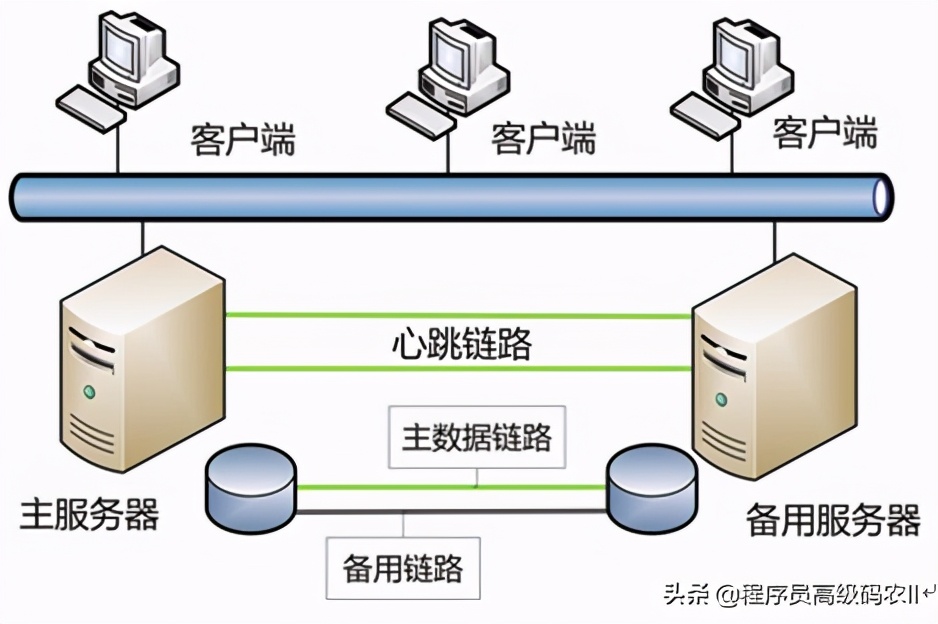

使用LVS+Keepalived可以在OnePoxy的服务器之上构建-一个双机热备设计,如图13-3所示。

在这个架构设计中,包含-一个广播IP地址和四个服务器,如下所示:

VIP: 10.10.10.100

LVS Master: 10.10.10.28

LVS Back: 10.10.10.38

Real Server1: 10.10.10.24

Real Server2: 10.10. 10.34其中,VIP是一个虚拟的广播IP地址,LVS_ Master 和LVS_ _Back 是双机热备的主机服务器和备机服务器,Real Server 是真实服务器,即已经安装了OneProxy 的数据库代理服务器。下面详细说明各个服务器的设置。

Real Server配置

参照13.6节OneProxy的安装和配置方法,在另- - 台服务器(假如IP地址为10.10.10.34)上安装一个配置相同的OneProxy代理服务器,然后在这两台机器上配置Real_ Server。

使用如下命令创建-一个启动文件:

vi /etc/init. d/ realserver输入如下内容:

SNS VIP=10.10.10.100

/etc/rc.d/init. d/ functions

case "$1" in

start)

ifconfig lo:0 $SNS_ VIP netmask 255.255.255.255 broadcast $SNS_ VIP

/sbin/route add -host $SNS_ VIP dev 1o:0

echo "1" >/proc/sys/net/ipv4/conf/1o/arp_ ignore

echo "2" >/proc/sys/net/ ipv4/conf/1o/arp_ announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_ announce

sysctl -p >/dev/null 2>&1

echo "RealServer Start OK"

;;

stop)

ifconfig 1o:0 down

route del $SNS_ VIP > /dev/null 2>&1

echo "0" >/proc/sys/net/ ipv4/conf/1o/arp_ ignore

echo "0" >/proc/sys/net/ ipv4/conf/lo/arp_ announce

echo "0" >/proc/sys/net/ ipv4/conf/all/arp_ ignore

echo "0" >/proc/sys/net/ ipv4/conf/all/arp announce

echo "RealServer Stoped"

;

*)

echo "Usage: $0 {startIstop}"

exit 1

I esac

exit0保存并退出编辑状态。

将文件设为可执行:

chmod 755 /etc/ init.d/ realserver使用下列命令启动服务:

service realserver start

LVS 主机配置

使用如下命令,安装Keepalived:

yum install -y keepalived进入安装目录:

cd /etc/keepalived清除原来的配置:

> keepal ived. conf重新编辑配置:

vi keepalived. conf设置如下所示内容:

global defs {

noti fication email {

demo@com. cn

}

notification email_ from demo@com. cn

smtp_ server 10.10.10.1

smtp_ connection timeout 30

router_ id LVS_ DEVEL # LVS的ID,在一个网络内应该是唯一的

}

vrrp_ instance VI 1 {

state MASTER

#指定Keepalived的角色,MASTER为主机,BACKUP 为备用机

interface ens192 #本机网卡名称, 可使用ifconfig命令查看

virtual_ router_ id 51 #虚拟路由编号, 主机和备用机要一- 致

priority 100 #定义优先级, 数字越大,优先级越高,主机DR必须大于备用机DR

advert_ int 1 #检查间隔, 默认为1s

authentication {

auth_ type PASS

auth pass 1111

}

virtual ipaddress {

10.10.10.100 #定义 VIP地址,可设置多个,每行一个

}

}

#定义对外提供服务的LVS的VIP地址及port

virtual server 10.10.10.100 3306 {

delay loop 6 #设置健康检查时间,单位是秒

1b_ algo wrr #设置负载调度的算法为WRR

1b kind DR #设置IVS实现负载的机制,有NAT、TUN和DR三个模式

nat_ mask 255.255.255.0

persistence_ timeout 0

protocol TCP

real_ server 10.10.10.26 3306 { #指定Real_ Serverl 的IP地址

weight 3

#配置节点权重,数字越大,权重越高

TCP CHECK {

connect timeout 10

nb_ get_ retry 3

delay_ before_ retry 3

connect_ port 3306

}

}

real_ server 10.10.10.36 3306 { # 指定Real_ Server2 的IP地址

weight 3 #配置节点权值重,数字越大,权重越高

TCP CHECK {

connect timeout 10

nb _get_ retry 3

delay before_ retry 3

connect port 3306

}

}

}启动Keepalived:

service keepalived start启动VIP地址:

ifconfig ens192:0 10.10.10.100 broadcast 10.10.10.100 netmask 255.255.255.255

up使用如下命令查看VIP地址的启动结果:

ip addr如果在输出结果中能看到VIP地址为“10.10.10.100”,则表示启动成功,代码如下所示:

1: 1o: <LOOPBACK,UP,LOWER _UP> mtu 65536 qdisc noqueue state UNKNOWN

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host 1o

valid lft forever preferred lft forever

inet6: :1/128 scope host

valid lft forever preferred_ lft forever

2: ens192: <BROADCAST ,MULTICAST,UP, LOWER UP> mtu 1500 qdisc pfifo_ fast state UP

qlen

1000

link/ether 00:0c:29:81:6a:85 brd ff:ff:ff:ff:ff:ff

inet 10.10.10.26/24 brd 10.10.10.255 scope global ens192

valid_lft forever preferred_ lft forever

inet 10.10.10.100/32 brd 10.10.10.100 scope global ens192:0

valid lft forever preferred lft forever

inet6 fe80: :20c:29ff:fe81:6a85/64 scope link

valid lft forever preferred lft forever如果要关闭VIP地址,则可以使用如下命令:

I i fconfig ens192:0 downLVS备用机配置

备用机的安装方法和过程与主机基本相同,只有"keepalived.conf" 的配置内容略有不同,

代码如下所示:

global defs

noti fication email {

demo@com. cn

}

notification email_ from demo@com. cn

smtp_ server 10.10.10.1

smtp connection timeout 30

router_ _id LVS_ DEVEL # LVS的ID,在一个网络内应该是唯一的

}

vrrp instance VI 1 {

state BACKUP

#指定Keepalived的角色,MASTER为主机,BACKUP 为备用机

interface ens192 #本机网卡名称,可使用ifconfig命令查看

virtual_ router_ id 51 #虚拟路由编号, 主机和备用机要一致

priority 99 #定义优先级, 数字越大,优先级越高,主机DR必须大于备用机DR

advert_ int. 1 #检查间隔, 默认为1s

authentication {

auth_ type PASS

auth pass 1111

virtual ipaddress {

10.10.10.100 #定义 VIP地址,可设置多个,每行一个

}

}

#定义对外提供服务的LVS的VIP地址及port

virtual_ server 10.10.10.100 3306 {

delay_ loop 6 #设置健康检查时间,单位是秒

1b_ algo wrr #设置负载调度的算法为WRR

lb kind DR #设置LVS实现负载的机制,有NAT、 TUN和DR三个模式

nat_ mask 255.255.255.0

persistence_ timeout (

protocol TCP

real server 10.10.10.26 3306 { #指定Real_ Serverl 的IP地址

weight 3 # 配置节点权重,数字越大,权重越高

rCP CHECK {

connect_ timeout 10

nb_ get_ retry 3

delay_ before_ retry 3

connect_ port 3306

}

}

real server 10.10.10.36 3306 { # 指定Real Server2 的IP地址

weight 3 # 配置节点权重,数字越大,权重越高

TCP CHECK {

connect_ timeout 10

nb_ get_ retry 3

delay_ before_ retry 3

connect_ port 3306

}

}

}其中,在“rp jinstance" 配置中,把“state”改为“BACKUP”,把“priority"改为“99”,其他各项配置基本相同。

在启动了双机热备的数据库代理服务之后,在微服务应用中,即可将数据源中连接服务器的地址改为VIP地址。

小结

本章介绍了在CentOS 7中安装MySQL的简易方法,并使用主从设计构建了分布式的数据库集群,搭建了-一个高性能、可扩展的数据库集群体系,同时,使用分组的方式实现了高可用集群的设计。在数据库访问设计中,使用OneProxy中间件实现了可配置的读写分离调用方法,并结合分库分表功能提高了数据库的访问效率。最后,使用双机热备设计,为数据库代理中间件及其集群的使用提供更加安全可靠的有力保障。

通过本章对数据库集群设计的介绍,读者可深入地理解数据库集群的工作原理。如果使用云服务的数据库,则建议使用云服务供应商提供的分布式数据库,这样可以使性价比更高。

本文给大家讲解的内容是微服务架构实战:可扩展分布式数据库集群的搭建,OneProxy分库分区设计、双机热备设计

- 下篇文章给大家讲解的是微服务架构实战:高可用分布式文件系统的组建;

- 觉得文章不错的朋友可以转发此文关注小编;

- 感谢大家的支持!

3732

3732

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?