摘要

文档问答(DocQA)是一项非常常见的任务。现有的方法使用大型语言模型(LLMs)或大型视觉语言模型(LVLMs)和检索增强生成(RAG)通常优先考虑来自单一模态的信息,未能有效整合文本和视觉线索。这些方法在复杂的多模态推理方面存在困难,限制了它们在真实文档上的性能。我们提出MDocAgent(一种用于文档理解的多模态多智能体框架),这是一种新颖的RAG和多智能体框架,利用了文本和图像。我们的系统使用五个专门的智能体:一个通用智能体,一个关键智能体,一个文本智能体,一个图像智能体和一个总结智能体。这些智能体参与多模态上下文检索,结合各自的见解,以更全面地理解文档内容。这种合作方法使系统能够综合文本和视觉组件的信息,从而提高问答准确性。在MMLongBench,LongDocURL等五个基准测试上进行的初步实验证明了我们的MDocAgent的有效性,相对于当前最先进的方法,平均提高了12.1%。这项工作有助于开发更健壮和全面的DocQA系统,能够处理包含丰富文本和视觉信息的真实世界文档的复杂性。我们的数据和代码可在https://github.com/aiming-lab/MDocAgent获取。

目录

1.简介

2.相关工作

3.用于文档理解的多模态多智能体框架

3.1.文档预处理

3.2.多模态上下文检索

3.3.初始分析和关键提取

3.4.专业智能体处理

3.5.答案合成

4.实验

4.1.实验设置

4.2.主要结果

4.3.定量分析

4.3.1.消融研究

4.3.2.细粒度性能分析

4.3.3.兼容性分析

4.4. Case Study

5.结论

致谢

A.实验设置

A.1.基线模型

A.2.评估基准

A.3.超参数设置

A.4.提示设置

A.5. Evaluation Metrics

B.附加结果

B.1. LongDocURL的细粒度性能

B.2.在 MDocAgent 中使用不同模型骨干的实验。

B.3.额外案例研究

1. 简介

根据参考文件回答问题。(DocQA) 是许多应用程序[5,8,25,28,34,35,45] 中的关键任务,范围从信息检索到自动文档分析。DocQA 的一个关键挑战在于问题的多样性以及回答这些问题所需的信息[7,26]。问题可以指文本内容、文档中的视觉元素(例如,图表、图表、

图1。DocQA的不同方法比较。LVLMs经常在处理长文档时遇到困难,缺乏对细节的细致关注,同时在跨模态理解方面也存在局限性。单模态上下文检索可以处理长文档,但仍然存在对详细分析或在模态间整合信息的问题。我们的MDocAgent通过将文本和基于图像的RAG相结合,再加上针对每种模态进行精细处理的专门智能体机制以及关键信息提取机制,展示了DocQA性能的改进。

由于大语言模型(LLMs)只能处理文本信息[29],因此在DocQA中通常使用大视觉语言模型(LVLMs)[4, 13, 24]。正如图1所示,虽然LVLMs在处理视觉内容方面表现出了潜力,但它们在主要为文本的关键信息或需要对文本和视觉元素之间的微妙互动进行理解的情况下往往会遇到困难[5, 25, 34]。DocQA中的另一个挑战在于文档中通常存在大量信息。直接处理整个文档可能会使计算资源不堪重负,并使模型难以识别最相关的信息[7, 26]。

为了克服这一挑战,检索增强生成(Retrieval Augmented Generation,RAG)被用作辅助工具,从长篇文档中提取关键信息[11]。虽然像ColBERT[16]和ColPali[9]这样的RAG方法已被证明在分别检索文本或视觉信息方面是有效的,但当问题需要整合两者的见解时,它们通常表现不佳。现有的RAG实现通常是独立运作的,要么检索文本,要么检索图像[18,42],但缺乏跨这些模态综合信息的能力。考虑一个包含重要图表和相应文本解释的文档。如果一个问题集中在图表内容上,一个纯文本的RAG系统将难以准确指出相关信息。相反,如果问题涉及文本描述中的微妙细节,一个基于图像的RAG系统则无法孤立必要的文本部分。这种无法有效结合多模态信息的能力限制了当前基于RAG的方法在复杂DocQA任务中的性能。此外,这些多模态关系的多样和微妙性要求不仅仅需要检索,还需要一种跨不同模态进行推理和推断的机制。

为了进一步解决这些限制,我们提出了一个新颖的框架,一个用于文档理解的多模态多Agent框架(MDocAgent),它利用了RAG和一个协作的多Agent系统的力量,其中专门的Agent协同处理和整合文本和图像信息。MDocAgent采用两个并行的RAG管道:基于文本的RAG和基于图像的RAG。 这些检索器为我们的多Agent系统提供了有针对性的文本和视觉上下文。MDocAgent包括五个专业Agent:一个用于初始多模态处理的一般Agent,一个用于识别关键信息的关键Agent,一个文本Agent,一个图像Agent用于各自模态内的重点分析,以及一个总结Agent用于综合最终答案。 这种协作方法使我们的系统能够有效处理需要从文本和视觉要素中综合信息的问题,超越传统RAG方法的能力。

具体而言,MDocAgent在五个阶段操作:(1)文档预处理:文本通过OCR提取,页面保留为图像。(2)多模态上下文检索:基于文本和基于图像的RAG工具分别检索前k个相关的文本段和图像页。(3)初始分析和关键提取:一般智能体生成初始响应,关键智能体提取关键信息,并提供给专门智能体。(4)专门智能体处理:文本和图像智能体在各自的模态内分析检索到的上下文,由关键信息指导。(5)答案综合:总结智能体整合所有智能体响应,生成最终答案。

本文的主要贡献是一种新颖的多Agent框架,用于DocQA,有效地整合了专门的智能体人,每个智能体人都专注于特定的模态或推理方面,包括文本和图像理解、关键信息提取和答案合成。我们通过在五个基准测试上的实验展示了我们方法的有效性:MMLongBench [26],LongDocURL [7],PaperTab [14],PaperText [14],FetaTab [14],显示DocQA性能有显著改进,平均提高了12.1%。实证改进表明我们的协作多Agent架构在处理长篇复杂文档和问题方面的有效性。此外,消融研究验证了每个智能体人的贡献以及整合多种模态的重要性。

2. 相关工作

LVLMs在DocQA任务中。文档视觉问答(DocVQA)已经发展,从关注短文档转变为处理复杂、长篇和多文档任务,通常涉及视觉丰富的内容,如图表和表格。这种转变需要能够整合文本和视觉信息的模型。大型视觉语言模型(LVLMs)已经出现,通过将大型语言模型(LLMs)的深层语义理解能力与处理文档图像的能力相结合来解决这些挑战。LVLMs将图像中的文本转换为视觉表示,保留布局和视觉上下文。然而,它们面临诸如输入大小限制和潜在的丧失细粒度文本细节的挑战,因此对于准确的DocVQA性能,有效地整合文本和视觉信息至关重要。

检索增强生成。检索增强生成(RAG)通过为LLMs提供外部基于文本的背景来增强它们,从而提高它们在诸如DocQA [11, 18]等任务中的性能。最近,随着视觉丰富文档的普及,已经开发出了用于为大型视觉语言模型(LVLMs)检索相关视觉内容的图像RAG方法[4, 5, 42–44]。然而,现有方法存在一些困难。

MDocAgent概述:一个在五个阶段操作的多模态多智能体框架:(1) 使用PDF工具处理文档以提取文本和图像。(2) 基于文本和图像的RAG检索前k个相关段落和图像页面。(3) 通用智能体提供初步答案,关键智能体从两种模态中提取关键信息。(4) 专门智能体处理各自模态中检索到的信息和关键信息,并生成精细答案。(5) 总结智能体

整合所有先前的输出以生成最终答案。

有效地整合和推理文本和图像信息,因为检索通常是独立进行的。这种缺乏综合推理限制了当前RAG技术的有效性,特别是对于需要对这两种模式有细致入微的理解的复杂DocQA 任务。

多智能体系统。多智能体系统在医学等复杂领域显示出前景[17,21,39]。这些系统使用专门的智能体来专注于不同的任务方面[3,15,20,33],协作以实现单个模型可能难以实现的目标。然而,它们在DocQA 中的应用带来了独特的挑战,源于集成不同模式的需求。简单地组合独立文本和图像智能体的输出通常无法捕捉到这些模态之间的细微相互作用,这对于准确理解文档至关重要。我们的框架通过引入信息集成的通用智能体以及专门的文本和图像智能体来解决这个问题,从而实现协作推理和对文档内容的更全面理解,最终提高DocVQA 性能。

3. 用于文档理解的多模态多智能体框架

本节详细介绍了我们提出的框架MDocAgent,用于解决DocQA 的复杂挑战。MDocAgent 采用一种新颖的五阶段多模态、多智能体方法,如图2 所示,利用专用智能体进行目标信息提取和跨模态合成,以实现对文档内容的更全面理解。随后,第3.1 节到第3.5 节提供了MDocAgent 体系结构的全面描述。此详细阐述将阐明MDocAgent 有效集成和利用文本和视觉信息以提高DocQA 准确性的机制。

初步:文档问题解答。给定一个用自然语言表达的问题q 和相应的文档D,目标是生成一个答案a,该答案使用D 中提供的信息准确、全面地回答q。

3.1. 文档预处理

这个初始阶段通过将文档语料库转换为适合文本和可视分析的格式,为后续处理做准备。D由一组页面D = {p1, p2, ..., pN}组成。对于每个页面pi,使用光学字符识别(OCR)和PDF解析技术的组合来提取文本内容。OCR用于识别基于图像的PDF中的文本,而PDF解析直接从PDF中的数字编码文本中提取文本。这种双重方法确保了在各种文档格式和结构中进行强大的文本提取。对于每个页面pi提取的文本表示为一系列文本段或段落ti = {ti1, ti2, ..., tiM},其中M表示该页面上文本段的数量。同时,每个页面pi也被保留为图像,保留其原始视觉布局和特征。这使得框架能够利用文本和视觉线索进行全面理解。这种预处理产生了文档语料库的两种平行表示:一个由提取的文本段组成的文本表示和一个由原始页面图像组成的视觉表示。这种双重表示构成了框架执行的多模态分析的基础。

3.2. 多模态上下文检索

第二阶段旨在有效地从文档语料库中检索出最相关的信息,考虑到文本和图像两种模式。 算法1描述了检索的整个过程。 对于文本检索,每页pi的提取文本段ti使用ColBERT进行索引[16]。 针对用户问题q,ColBERT检索出前k个最相关的文本段,表示为Tq = {t1,t2,...,tk}。 这为后续智能体处理提供了文本上下文。 与文本检索并行,使用ColPali提取视觉上下文[9]。 每个页面图像pi经过ColPali处理,生成密集的视觉嵌入Epi∈Rnv×d,其中nv表示每页的视觉标记数,d表示嵌入维度。 利用这些嵌入和问题q,ColPali检索出前k个最具视觉相关性的页面,表示为Iq = {i1,i2,...,ik}。 使用ColPali允许模型捕捉文档中存在的视觉信息,包括布局、图表和其他视觉提示。

多模态上下文检索算法

3.3. 初始分析和关键提取

第三阶段旨在对问题进行初步解释,并确定在检索到的背景中最显著的信息。作为初步多模态整合器的总智能体AG接收检索到的文本背景Tq和视觉背景Iq。它通过有效地结合嵌入在两种模态中的信息来处理这些多模态输入。对于这些结合背景的全面理解使AG能够生成初步答案aG,这是下一阶段更专业分析的关键起点。

aG = AG(q,Tq,Iq).(1)

随后,关键智能体AC 在提炼检索到的信息中起着至关重要的作用。它以问题q、检索到的上下文Tq 和Iq 以及由总智能体生成的初步答案aG 作为输入。AC 的主要功能是仔细分析这些输入并确定对准确回答问题至关重要的最关键信息。这些关键信息为下一阶段的专业智能体提供指导,将他们的注意力集中在检索到的上下文的最相关方面。

Tc = AC(q,Tq,aG),Ic = AC(q,Iq,aG).(2)

该阶段的输出包括Tc ⊂ Tq,表示从检索到的文本段落中提取的关键文本信息,以及Ic,它提供了从捕捉重要视觉元素的检索到的图像Iq 中提取的关键视觉信息的详细文本描述。

3.4. 专业智能体处理

第四阶段更深入地研究文本和视觉模式,利用由前一阶段提取的关键信息指导的专业智能体。文本智能体AT 接收检索到的文本段Tq 和关键文本信息Tc 作为输入。它仅在文本领域内运行,利用其专业知识和分析能力来彻底检查提供的文本片段。通过特别关注关键文本信息Tc,AT 可以在更广泛的文本上下文Tq 中确定最相关的证据,并进行更有针对性的分析。这种集中的方法允许更深入地理解与问题相关的文本细微差别,并最终生成详细的、基于文本的答案aT。

aT = AT(q,Tq,Tc) (3)

同时,图像智能体AI接收到检索到的图像Iq和关键视觉信息Ic。该智能体专注于视觉分析和解释。它处理图像Iq,特别关注由关键视觉信息Ic突出显示的区域或特征。这种有针对性的分析使智能体能够从视觉内容中提取有价值的见解,将其处理重点放在图像最相关的方面。图像智能体的分析结果是一个基于对图像的解释提供的以视觉为基础的答案aI。

aI = AI(q,Iq,Ic). (4)

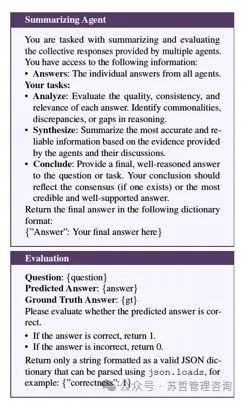

3.5. 答案合成

最后一个阶段整合了前面各阶段的多样输出,将初始的多模态理解与专门的智能体分析相结合,产生全面准确的答案。总结智能体AS 收到由一般智能体、文本智能体和图像智能体生成的回答aG、aT 和 aI。这一全面的信息集提供了对问题的多角度看法,并允许总结智能体进行彻底的综合。总结智能体分析个别智能体的回答,识别共同点、差异点和互补的见解。它考虑每个智能体提供的支持证据。透过解决智能体之间的潜在冲突或分歧,并整合它们的个别优势,总结智能体构建了一个利用多智能体系统的集体智慧的最终答案aS。这个最终答案不仅仅是个别答案的组合,而是一个综合的回应,反映了从文本和视觉模态提取的信息的更深入、更细腻的理解。这种多智能体协作的整个过程在算法2 中有所说明。

算法2 多智能体协作

4. 实验

我们在涵盖多种场景的五个文档理解基准测试中对MDocAgent进行评估,以回答以下问题:(1)相较于现有基于RAG的方法,MDocAgent是否有效地提高了文档理解的准确性?(2)我们框架中的每个智能体是否发挥了有意义的作用?(3)我们的方法如何增强模型对文档的理解?

4.1. 实验设置

实施细节。MDocAgent 中有五个智能体:通用智能体、关键智能体、文本智能体、图像智能体和总结智能体。我们采用Llama-3.1-8BInstruct [12] 作为文本智能体的基模型,Qwen2-

VL-7B-Instruct [38] for other four agents, and select Col-

BERTv2 [32]和ColPali [10]分别作为文本和图像检索器。在我们的RAG设置中,我们检索每个示例的输入上下文中得分最高的1或4个段落。所有实验都在4台NVIDIA H100 GPU上进行。模型和设置的详细信息显示在附录A中。

数据。基准测试涉及MMLongBench [26]、LongDocUrl [7]、PaperTab [14]、PaperText [14]、FetaTab [14]。这些评估数据集涵盖了各种场景,包括开放域和封闭域、文本和视觉、长文档和短文档,确保了评估的公平性和完整性。数据集描述的详细信息见附录A.2。

度量标准。对于所有基准测试,我们遵循邓等人[7]、马等人[26]的做法,利用GPT-4o [30]作为评估模型,评估模型输出与参考答案之间的一致性,产生二元决策(正确/不正确)。我们提供每个基准测试的平均准确率。

4.2. 主要结果

在本节中,我们提供了MDocAgent 在多个基准测试上与现有最先进的LVLM 和基于它们构建的基于RAG 的方法的全面比较。我们的发现可以总结为:

MDocAgent在所有比较方法和其他LVLMs中表现优异。我们将我们的方法与基线方法在文档理解任务上进行比较,结果见表1。总体而言,我们的方法在所有基准测试中均表现优于所有基线方法。

表1. MDocAgent与现有最先进的LVLMs和基于RAG的方法的性能比较。表2. MDocAgent不同变体之间的性能比较。

Top-1检索性能。在top-1 检索中,MDocAgent 显著提升性能。在PaperText 上,MDocAgent 实现了0.399的得分,超过第二好的方法M3DocRAG 16.7%。同样,在FetaTab 上,MDocAgent 实现了0.600的得分,比第二好的方法高出惊人的21.0%。与最好的 LVLM(Qwen2.5-VL-7B)和基于文本-RAG(ColBERTv2+Llama-3.1-8B)的基准相比,我们的方法在所有基准上平均表现出惊人的51.9%和23.7%的提升。这种提升突显了在我们的框架中整合视觉信息和协作多智能体架构的优势。此外,最近的最先进的基于图像-RAG的方法M3DocRAG 展现出令人期待的结果,然而我们的方法仍然比它平均高出12.1%。这表明我们的多智能体框架,以其专门的智能体和关键信息提取机制,比现有方法更有效地解决了信息过载、对细节的关注和交叉模态理解的核心挑战。Top-4 检索性能。使用top-4 检索时,我们方法的优势进一步得到体现。MDocAgent 在所有基准中始终取得最高分。平均而言,MDocAgent比Qwen2.5-VL-7B 高出惊人的73.5%。有趣的是,使用top-4 检索时,M3DocRAG 在处理更多检索信息时,与top-1 检索相比略高于ColBERTv2+Llama-3.1-8B。这可能表明M3DocRAG 在处理更多检索信息时,对选择性整合多个检索文档的能力存在局限性。平均而言,MDocAgent 比M3DocRAG高出10.9%.同时,与ColBERTv2+Llama-3.18B 相比,MDocAgent 的性能提高了6.9%。这种持续的改进表明,我们的方法有效地利用了前4 个检索项目提供的额外上下文信息,提供了更大的好处和更多的检索结果。

4.3. 定量分析

在这一部分,我们进行三项定量分析,以了解我们提出的框架中不同组件的效果和贡献。首先,我们进行消融研究,评估移除单个智能体或智能体组的影响。其次,我们进行了细粒度性能分析,检查MDocAgent在MMLongBench上跨不同证据模态的性能,以找出其改进的来源。

第三,兼容性分析探讨了该框架在不同基于图像的RAG主干上的表现,以展示其稳健性和泛化能力。此外,我们在附录B.2中展示了不同模型主干下其表现的实验结果。

4.3.1. 消融研究

表2比较了我们的全方法(MDocAgent)与其变体:MDocAgenti(没有文本智能体)和MDocAgentt(没有图像智能体)。在所有基准测试中,全MDocAgent方法始终实现了最高性能。移除任一专门的智能体,文本或图像,都会导致性能明显下降。这凸显了通过我们的框架内专门智能体结合文本和图像模态的重要性。性能差异在LongDocURL和PaperText等基准测试中最为显著,这些基准测试可能分别包含更丰富的视觉或文本信息,进一步突显了专门处理的价值。消融研究清楚地证明了将专门智能体结合到每种模态中的协同作用效果。

表3.MMLongBench 上不同证据来源的性能比较.表4.使用ColPali 和ColQwen2-v1.0 作为MDocAgent 基于映像的RAG 模型之间的性能比较。

表2还将MDocAgent与MDocAgents进行比较,其中常规智能体和关键智能体均被移除,以评估它们的贡献。完整方法在所有数据集上相对于MDocAgents的持续改进清楚地凸显了这两个智能体的重要性。常规智能体通过最初整合文本和图像模态建立了至关重要的基础,提供了对上下文的整体理解。移除此整合步骤明显降低了后续智能体集中分析关键信息并有效回答的能力。除了一般的模态集成外,移除关键智能体限制了框架有效地识别和利用关键信息的能力。这突显了关键智能体在引导专业智能体关注和促进更有针对性和高效的信息提取中的重要作用。

4.3.2. 细粒度性能分析

通过进一步分析表3 中MMLongBench 的分数,我们对不同类型证据模式的性能进行了深入分析,以更好地了解MDocAgent 实现的性能改进。我们还在附录B.1 中说明了LongDocURL 的证据模式的结果。根据结果,MDocAgent 在所有类型的证据模式中都优于所有LVLM 基线。但是,当使用top 1 检索方法比较RAG 方法时

M3DocRAG在图像类别上表现略好,

MDocAgent在图表、表格和文本类别中表现出色,反映了其处理文本和视觉信息能力的增强。采用排名前4的检索策略,MDocAgent提高了在所有类别中的表现,特别是在图表方面,突显了其对大量和多样化信息来源的有效处理能力。

4.3.3. 兼容性分析

我们进一步分析了MDocAgent与不同RAG骨干的兼容性。表4展示了在我们提出的框架中使用两个基于图像的RAG模型,ColPali和ColQwen2-v1.0的结果。这两个模型在整体表现上都达到了可比较的水平, 在所有基准测试中得分平均为0.407。虽然ColQwen2-v1.0在MMLongBench、LongDocUrl和FetaTab上稍微占优,ColPali在PaperTab和PaperText上表现稍好一些。这表明基于图像的RAG模型的选择对框架的整体有效性影响很小,突出了我们多智能体架构的稳健性。此外,在性能上的一致性。

ColBERT + Llama 3.1 8B Question Details:✓… 外生拉丁裔的人口在调查中更多。… 795 Conclusion: Χ根据报告,哪一类调查对象是外生的(不包括波多黎各),而1,051调查对象在调查中人口更多?是外生拉丁裔,还是通过手机接受访谈的拉丁裔?M3DocRAG Details: Χ外生拉丁裔的人口在调查中更多。… 795 调查对象是外生的(不包括波多黎各)的有705个,而705个是美国本地出生的(包括波多黎各)。通过手机接受访谈的拉丁裔。Ours Evidence pages: 19, 20 General Agent: Critical Agent: 通过手机接受访谈的拉丁裔 Critical Info:要大于• Text: 外生的(不包括波多黎各),外生拉丁裔。•Image: 手机采样框架Top-1 Page Text Agent: … 外生的(不包括波多黎各):795。… 检索采样包括… 和一个手机采样框架(1,051个访谈)。 ColBERT: 19 Image Agent: 手机采样框架产生了1,051个访谈,ColPali: 19 Details:✓而外生的… 调查对象有795。Conclusion:✓Final Answer: 通过手机接受访谈的拉丁裔人数(1,051个)要大于外生拉丁裔人数(795个)。图3. MDocAgent案例研究与其他两个RAG方法基线(ColBERT + Llama 3.1-8B和M3DocRAG)的比较。针对比较两个人口规模的问题,两种基准方法都未能得出正确答案。“我们的框架通过其专门智能体的协作努力成功地从文本和图像中的表格中识别出相关信息,最终综合得出正确答案。这突显了细粒度多模态分析的重要性和准确性。

在特定背景中处理信息。

跨不同的RAG模型强调了我们方法的核心优势在于多主体架构本身,而不是依赖于特定的检索模型。这进一步加强了我们提出的方法的兼容性。

4.4.案例研究

我们进行了一个案例研究以更好地理解MDocAgent。图3展示了一个示例。这个问题要求从文本和表格数据中提取并比较涉及两个不同的拉丁裔群体的数值信息。虽然ColBERT 和ColPali 成功检索到包含必要信息的相关页面,但两种基准方法都未能综合出正确答案。仅依赖文本的ColBERT + Llama-3.1-8B 基准错误地得出外生拉丁裔人口更多的结论,显示出未能准确解释文档文本内容中呈现的数值数据的失败。同样,M3DocRAG 由于捕获到了错误信息,未能正确解释问题。相比之下,我们的多智能体框架成功地应对了这种复杂性并给出了正确答案。

具体来说,总智能体提供了一个正确但模糊的答案,使得关键智能体对于识别关键短语(不包括PR)和“手机采样框架”表至关重要。这会将专业智能体引导到精确位置,以便高效提取数据。文本智能体和图像智能体都正确提取了外国出生的拉丁裔的795 个和手机采访的拉丁裔的1,051 个。然后,摘要智能体整合这些见解以进行准确比较和全面的最终答案。本案例研究展示了我们的结构化多智能体框架如何胜过难以进行集成文本和图像分析的方法(请参阅附录B.3 中的更多案例研究)。

5. 结论

本文提出了一个多智能体框架MDocAgent for DocQA,它通过专用智能体和双RAG 方法集成文本和视觉信息。我们的框架通过使用专门用于文本处理、图像分析和关键信息提取的智能体来解决现有方法的局限性,最终形成用于最终答案生成的合成智能体。实验结果表明,与LVLM 和多模态RAG 方法相比,它有显著的改进,突出了我们的协作式多智能体架构的有效性。我们的框架有效地处理了信息过载,并促进了详细的跨模态理解,从而在复杂的DocQA 任务中得到更准确、更全面的答案。未来的工作将探索更高级的智能体间通信和外部知识源的集成。

致谢

这项研究部分得到了NIH的支持。

1R01AG085581andCiscoFacultyResearch

奖励。

A. 实验设置

A.1. 基线模型

1.Qwen2-VL-7B-Instruct [38]: A large vision-language model developed by Alibaba, designed to handle multiple images as input.

2.Qwen2.5-VL-7B-Instruct [2]: Qwen2-VL-7B-Instruct 的增强版本,提供了在处理多张图片时性能更优的功能。

3.llava-v1.6-mistral-7b [22]: 也被称为LLaVA-NeXT,是在LLaVa-1.5基础上改进的视觉语言模型,能够从多幅图像中解释和生成内容。

4.Phi-3.5-vision-instruct [1]: 由Microsoft开发的一个整合了视觉和语言理解的模型,旨在基于多个图像处理和生成响应。

5.llava-one-vision-7B [19]:基于Qwen2-7B语言模型训练的LLaVAOneVision模型,上下文窗口为32K个标记。

6.SmolVLM-Instruct [27]: A compact vision-language model developed by HuggingFace, optimized for handling image inputs efficiently.

7.ColBERTv2+Llama-3.1-8B-Instruct [12, 32]:一个基于文本的RAG pipeline,利用ColBERTv2 [32]来检索文本片段,以Llama-3.1-8B-Instruct作为LLM生成响应。

8.M3DocRAG [5]:一种基于图像的RAG 流程,利用ColPali [9] 检索图像片段,并使用Qwen2-VL-7B-Instruct [38] 作为生成答案的LVLM。

A.2. 评估基准

1.MMLongBench [26]:评估模型理解具有丰富布局和多模态组件的长篇文档的能力,包括1091个问题和平均每篇47.5页的135篇文档。

2.LongDocURL [7]: 提供了一个全面的多模式长文档基准,集成了理解、推理和定位任务,涵盖了超过33,000页文档和2,325个问答对。

1.PaperTab [14]:侧重于评估模型理解和提取NLP 研究论文中表格信息的能力,涵盖307 篇文档中的393 个问题。

3.PaperText [14]:评估模型在理解自然语言处理研究论文中文本内容方面的熟练程度,涵盖1087篇文档中的2804个问题。

4.FetaTab [14]:一个来自维基百科页面的表格问答数据集,挑战模型生成自由形式的文本答案,包括1023个问题和878个文档。

A.3. 超参数设置

温度:所有模型都使用它们的默认温度设置。

最大新代币数量:256。

Max Tokens per Image (Qwen2-VL-7B-Instruct): – Top-1 retrieval: 16,384 (by default). – Top-4 retrieval: 2,048.

图像分辨率:144(适用于所有基准测试)。

A.4. 提示设置

表格5.在LongDocURL上不同证据来源之间的性能比较。

A.5. Evaluation Metrics

所有基准的度量标准是由GPT-4o评估的平均二进制正确性。评估提示信息在A.4节中给出。我们使用一个Python脚本来提取GPT-4o提供的结果。

B. 附加结果

B.1. LongDocURL的细粒度性能

我们展示了LongDocURL的细粒度性能,如表5所示。与MMLongBench类似,MDocAgent表现优于所有LVLM基线。在使用排名前1的检索策略时,虽然M3DocRAG在图形和ColBERTv2+Llama3.1-8B在其他类型上表现略微优于其,但MDocAgent在布局、文本、表格方面表现出色,并获得最高平均准确率。采用排名前4的检索策略,MDocAgent提升了性能,在所有类别中取得最高分。

B.2. 在MDocAgent 中使用不同模型骨干的实验。

表格6展示了一个消融研究,评估不同LVLMs对我们框架性能的影响。三个LVLMs:Qwen2-VL-7B-Instruct,Qwen2.5-VL-7BInstruct和GPT-4o被集成为所有智能体的骨干模型,除了文本智能体。

Qwen2.5-VL-7B-Instruct在PaperTab、PaperText和FetaTab上的表现比Qwen2VL-7B-Instruct差,无论是top-1还是top-4的检索指标。然而,在MMLongBench上,Qwen2.5-VL相对于Qwen2-VL表现出明显改善,导致平均得分更高。MMLongBench更多地依赖基于图像的问题,这可能解释了Qwen2.5-VL在这一基准测试中表现优越,可能表明Qwen2.5-VL在处理视觉问答任务方面更好,但在处理文本任务方面更差。

重要的是,GPT-4o 在所有基准测试中都明显优于Qwen2-VL 和Qwen2.5-VL。值得注意的是,GPT-4o 的前1 性能甚至超过了两种Qwen 模型的前4 名结果。这种大幅的性能提升强烈表明,我们的框架有效地利用了更强大的主干模型,展示了其适应性和从底层LVLM 的改进中受益的能力。

B.3. 额外案例研究

在图4中,问题要求从一个缺乏明确编号并附有图像的列表中识别一个原因。ColBERT无法检索到正确的证据页面,导致ColBERT + Llama无法回答这个问题。虽然ColPali能够正确定位到证据页面,但M3DocRAG无法得到正确答案。然而,我们的框架通过所有智能体的协同努力成功识别出正确答案("最美丽的校园")。普通智能体得出初步答案,关键智能体确定关键的文本线索("最美丽的校园")和对应的视觉元素(NTU校园的图像)。图像智能体然后通过利用关键信息来精细化答案,正确地指出了缺乏人物描述。尽管文本智能体无法从给定的上下文中找到相关信息,关键智能体提供的信息帮助它猜测答案是"最美丽的校园"。总结智能体将这些见解结合起来得出正确的最终答案。

在图5中,问题要求列出Lebour教授的学位。ColPali未能检索到相关页面,使得M3DocRAG无效。虽然ColBERT正确地检索到了页面,但ColBERT + Llama仍然给出了错误答案,因为它错误地将"F.G.S."添加到答案中,而这不是一个学位。另一方面,MDocAgent正确识别了"M.A.学位"。总体智能体提供了一个初始答案,而临界智能体则识别-

表6.在MDocAgent 中使用不同主干LVLMs 的性能比较。

ColBERT + Llama 3.1 8B

QuestionDetails:Χ

…南洋理工大学智慧校园适合你的10 大理由不是结论:Χ

NTU明确列出的10 大原因之一。但是,提供的内容包括10 个智能校园的清单,这是原因,但它们没有编号......原因,不包括任何

person在对应的图中?M3DocRAGDetails: 对应图中的人物是谁?M3DocRAGDetails: 对应图

不包含任何人在相应的图表中的原因:Χ

Answeris "Prestigious Scholarships and Comprehensive Financial Aid”.

最美丽的Top-1页面是我们的。

CampusRetrievalGeneral Agent: The reason … is "Most Beautiful Critical Info:Critical Agent:

ColBERT: 1Campus." This reason is represented •Text: Most beautiful Campus, ColBERT: 1校园。这个理由被表示为•文本:最美丽的校园。

Evidence pages: by a figure showing the NTU campus.•Image: NTU campus

3ColPali: 3文本智能体人:我找到了“ NTU智能校园适合您的前10大原因”部分。然而,该文本并未明确列出前10大原因... 文本提到“最美丽的校园”作为线索。这可能是NTU智能校园适合您的一个原因。Image Agent: The reason that does not include any person in the corresponding figure is "NTU campus without people.”

Details:✓

最终答案:最美丽校园的原因是“ Most Beautiful Campus”。这个结论:✓

理由集中在NTU校园的外观,如图所示,显示了没有任何人的校园。

图4.MDocAgent 与其他两个基线的比较案例研究。虽然只有ColPali 正确检索证据页,但两种基线方法都无法识别正确答案。我们的方法通过关键信息共享和专业智能体协作,正确地指出了“Most Beautiful Campus” 是唯一没有包含人员的相应图像的原因。

根据线索,文本智能体添加了更详细的解释,图像智能体直接使用线索作为答案。最后,总结智能体综合结果,提供验证过的答案。

这两个案例突显了MDocAgent对不完美检索的韧性,展示了协作多模态信息处理的有效性,以及在获取高准确性的指导中,普遍-关键智能体的重要性,即使有可能是不足或模糊的信息。

图5. MDocAgent与其他两个RAG方法基线的案例研究。在这个案例中,ColPali未能检索到正确的证据页面,从而阻碍了M3DocRAG的执行。而ColBERT成功检索到,ColBERT + Llama基线仍然提供了错误的答案。只有我们的多智能体框架,通过精确的关键信息提取和智能体协作,正确地识别了M.A.学位。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集***

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?