近年来,大型语言模型(LLM)在各个领域的应用日益普及,人们甚至开始依赖它们来获得专业医学建议。然而,互联网上充斥着大量的虚假或过时的信息,如果有人故意将这些错误内容注入到大模型的训练数据里,究竟会带来怎样的风险?

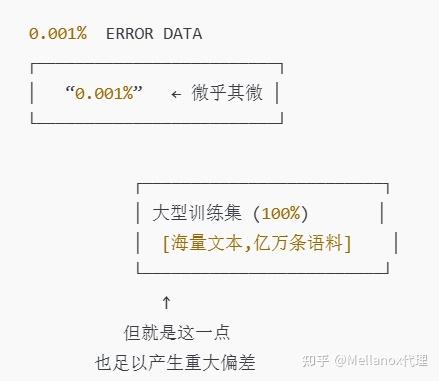

近期纽约大学做了一项研究测试,警示我们:即使只把 0.001% 的训练数据改成错误信息,也足以让模型在医学领域出现明显的失误。

一、什么是“数据中毒”?

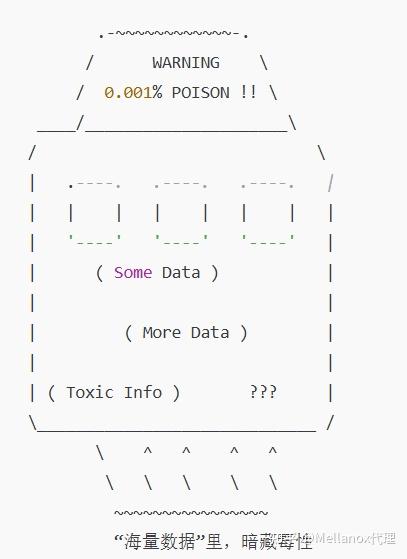

数据中毒是指有人恶意或无意地将错误信息注入到训练集里,从而让模型在回答问题时产生成体系的偏差或错误输出。与传统的“黑客攻击”或“算法漏洞”不同,数据中毒更像是一种潜移默化的“灌输”——模型读到这些谬误,就会不知不觉把它们当成“真理”记下来。

为何医学领域格外危险?

一般领域的错误信息或许只是耽误我们几分钟去纠正,但医学领域任何一点偏差都有可能影响健康甚至生命安全。如果一个医学大模型在解答病症或用药问题时给出了错误建议,后果不堪设想。

二、研究人员如何发现 0.001% 的“毒药”?

在这项研究中,纽约大学团队聚焦到了三大医学子领域(全科、神经外科、药物治疗),选定了 60 个具体主题,将从公共数据库中爬取的大量文档作为训练材料,故意替换其中一部分正确内容为“高质量”的错误信息。

1. 从 GPT-3.5 中生成虚假医学文本

研究人员利用 GPT-3.5(通过特殊提示绕过防护)来生成听起来“有理有据”的医学谬误。虽然在平时的对话中模型会尽力避免输出此类错误信息,但在刻意的提示设计下,它依然可能产生看似专业、却完全错误的医学陈述。

2. 篡改训练数据

o 先测试较高比例:把 0.5% 或 1% 的医学数据改成虚假信息,结果模型在相关领域及其他医学主题上都出现更多错误答案。

o 渐渐降低比例:即使把错误信息比例降到 0.01% 或 0.001%,依然能显著增加模型输出错误或误导性答案的概率。

结果有多惊人?

o 当错误信息占到 0.01% 时,超过 10% 的回答包含错误或有害成分;

o 错误信息占比进一步降低到 0.001% 时,依然有 7% 以上的回答是有害的。

也就是说,投毒数据的比例极其微小,但在海量数据训练下却足以让模型失去准确性。

三、“投毒”成本是不是很高?

很多人会以为,要让错误信息生效,得投入大量时间和精力来“洗稿”或“刷数据”。但研究显示,投毒的门槛其实没那么高:

1. 上传错误信息到互联网上

只需将错误医学文本混在普通网页里,或者用“不可见字体”(如把文字设置成背景同色、字体透明度为 0% 等)隐藏在页面中。搜索引擎或爬虫在抓取页面时,就可能把这些内容记录下来。

2. 模型规模越大,越容易受影响

现在不少大模型动辄在万亿级别的语料上训练,即使 0.001% 的占比,对应的也是成千上万的文本篇幅;要在网上悄悄布置这些“投毒内容”,并不需要多少成本,甚至几百块钱就能生成足够的虚假文献。

3.无法轻易被模型开发者察觉

大多数模型训练数据来自自动化爬虫,人工审查不可能覆盖全部数据,更不会逐条与权威医学知识比对。在如此庞大的数据洪流中,只要混进去的比例微乎其微,就很难被发现。

四、医学知识库也不靠谱?

有人可能会说:“那我们就不用互联网数据,直接采用经过验证的专业医学数据库不就行了?”然而,医学数据库本身也未必“百分百正确”:

1. 学术研究在不断迭代

o 昔日被寄予厚望的疗法,可能几年后就被证实无效甚至有害;

o 一些过时或误导性的研究结果依然留存在文献中,很难被彻底剔除。

2. 医疗信息的动态性

大规模传染病出现时,一开始的信息往往基于有限数据,难免偏差。后续有了更大规模的临床证据,原有结论可能被推翻或修正,但已被收录的文献仍在数据库中存在。

3. 刻意制造的学术垃圾

近年来,医学领域也有论文造假、商业利益操纵等问题,一些有利益驱动的机构可能在数据库或期刊中发表具有倾向性的研究,造成隐形污染。

应对措施:我们能做些什么

1. 引入可信知识图谱做交叉验证

研究人员提出了让模型输出的医学结论,与经过验证的生物医学知识图谱进行比对。凡是查无此“知”,就列入风险排查,甚至由人工或专家来进一步核实。

2. 提高训练数据审核和更新机制

· 对公共来源数据进行周期性审核和清理,尽量剔除明显的谣言、过时和错误信息。

· 引入多层筛选流程,在模型训练或微调时就过滤掉可疑文本。

3. 加强专业审查和透明度

· 专业的医学模型应该有医学专家团队进行定期评测,及时纠偏;

· 模型发布前应给出较为透明的“数据来源说明”,让用户知道模型训练背后的数据质量。

4. 用户教育:保持质疑和多方验证

即便 AI 能给出冠冕堂皇的回答,医疗诊断和治疗决策仍需多个渠道交叉验证。普通用户也应该提高信息鉴别能力,尤其是在涉及健康和安全的问题上,要始终以专业医疗机构或执业医师的建议为准。

仅 0.001% 的错误信息,就能让 AI 在医学领域的准确率大打折扣——这不是耸人听闻,而是技术界正在面临的现实挑战。医学的专业性与严谨性,决定了任何一点偏差都可能带来严重后果。因此,在人工智能的浪潮下,如何有效防范“数据中毒”,让人们获得真正可靠的医学建议,已经成为跨学科、跨行业共同关注的问题。

如果这篇文章对你有所启发,欢迎点赞、分享或收藏,也可以添加我主页上的wx,拉你进入群,我们群里有很多对这些感兴趣的小伙伴,让更多人了解医学大模型面临的潜在风险与挑战。同时欢迎在评论区留言,期待你的见解!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?