Scrapy_CrawlSpider的介绍

在Scrapy中Spider是所有爬虫的基类,而CrawSpiders就是Spider的派生类。

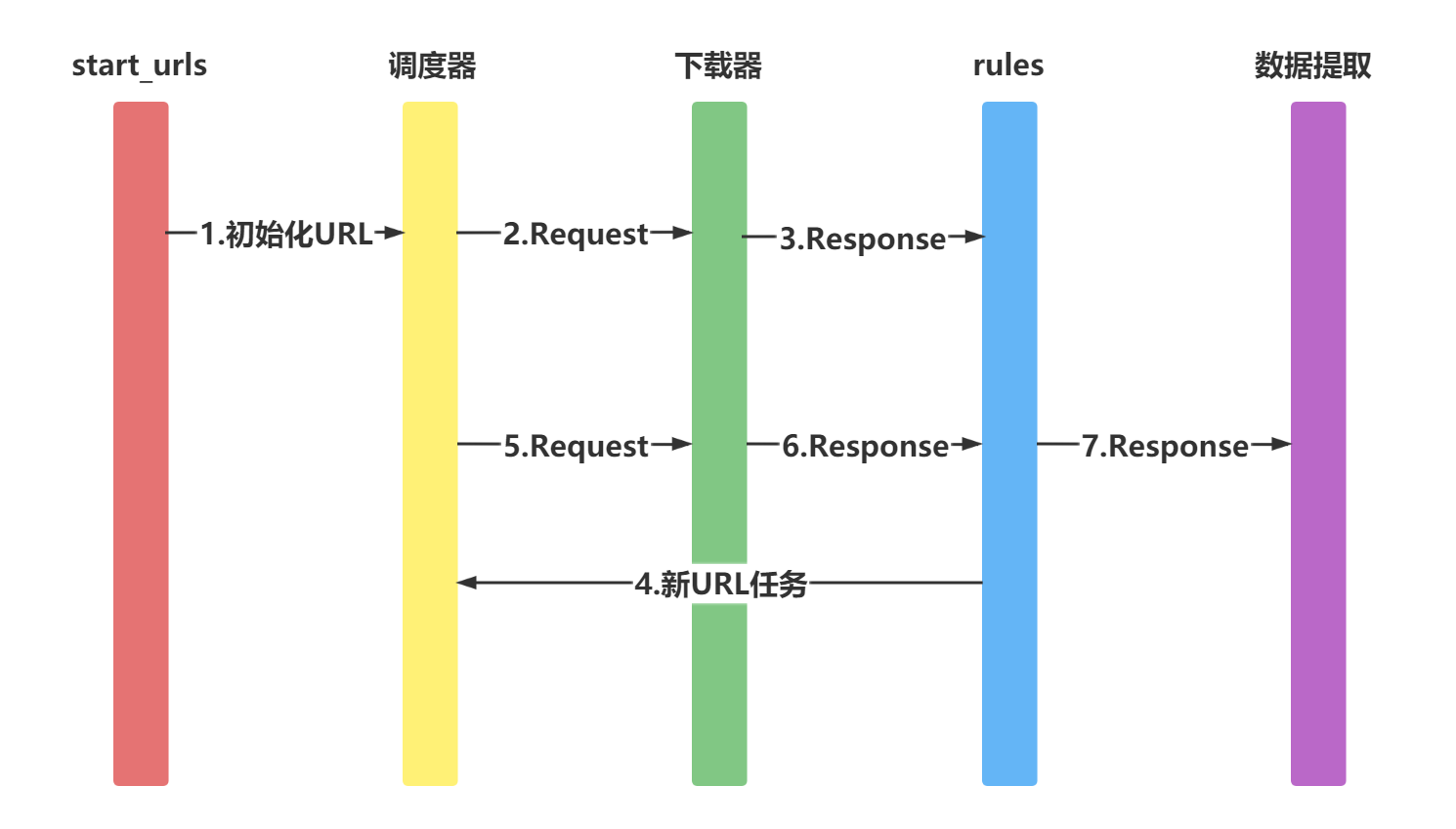

适用于先爬取start_url列表中的网页,再从爬取的网页中获取link并继续爬取的工作。运行图如下

1 创建CrawlSpider

scrapy genspider -t crawl 爬虫名 (allowed_url)

2 使用CrawlSpider中核心的2个类对象

2.1 Rule对象

Rule类与CrawlSpider类都位于scrapy.contrib.spiders模块中

class scrapy.contrib.spiders.Rule(

link_extractor,

callback=None,

cb_kwargs=None,

follow=None,

process_links=None,

process_request=None)

参数含义:

-

link_extractor为LinkExtractor,用于定义需要提取的链接

-

callback参数:当link_extractor获取到链接时参数所指定的值作为回调函数

注意 回调函数尽量不要用parse方法,crawlspider已使用了parse方法

-

follow:指定了根据该规则从response提取的链接是否需要跟进。当callback为None,默认值为True

-

process_links:主要用来过滤由link_extractor获取到的链接

-

process_request:主要用来过滤在rule中提取到的request

2.2 LinkExtractors

顾名思义,链接提取器

2.2.1 作用

response对象中获取链接,并且该链接会被接下来爬取 每个LinkExtractor有唯一的公共方法是 extract_links(),它接收一个 Response 对象,并返回一个 scrapy.link.Link 对象

2.2.2 使用

class scrapy.linkextractors.LinkExtractor(

allow = (),

deny = (),

allow_domains = (),

deny_domains = (),

deny_extensions = None,

restrict_xpaths = (),

tags = ('a','area'),

attrs = ('href'),

canonicalize = True,

unique = True,

process_value = None

)

2.2.3 查看效果-shell中验证

首先运行

scrapy shell 'https://www.zhhbqg.com/1_1852/835564.html'

继续import相关模块:

from scrapy.linkextractors import LinkExtractor

提取当前网页中获得的链接

link = LinkExtractor(restrict_xpaths=(r'//a'))

调用LinkExtractor实例的extract_links()方法查询匹配结果

link.extract_links(response)

2.2.4 查看效果 CrawlSpider版本

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from xiaoshuo.items import XiaoshuoItem

class XiaoshuoSpiderSpider(CrawlSpider):

name = 'xiaoshuo_spider'

allowed_domains = ['fhxiaoshuo.com']

start_urls = ['http://www.fhxiaoshuo.com/read/33/33539/17829387.shtml']

rules = [

Rule(LinkExtractor(restrict_xpaths=(r'//div[@class="bottem"]/a[4]')), callback='parse_item'),]

def parse_item(self, response):

info = response.xpath("//div[@id='TXT']/text()").extract()

it = XiaoshuoItem()

it['info'] = info

yield it

1474

1474

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?