一.主要原语

(1)NameNode --元节点

(2)DataNode --数据节点

(3)Secondary NameNode --处理checkporint工作

二 NameNode

是整个文件系统的管理节点。它维护整个文件系统的的文件目录树,文件/目录的元信息和每个文件对应的数据块列表。接收用户的操作请求。

文件包括:

hdfs-site.xml的dfs.name.dir属性

1.

fsimage:元数据镜像文件,存储某一时段NameNode内存元数据信息。

2.edits :操作日志文件。

3.fstime : 保存最近一次cheeckpoit的时间。

4.以上这些文件是保存在Linux系统中

三 NameNode的工作特点

1.NameNode始终在内存中保存metedata,用于处理“读请求”。

2.到有“写请求”来时,namenode会首先写到editslog到磁盘,即想edits文件中写入日志,成功返回后,才会去修改内容,并且向客户端返回。

3.Hadoop会维护一个fsimage文件,也就是namenode中metedata的镜像,但是fsimage不会随时与内存中的metedata保持一致,而是每隔一段时就去合并edtis文件来更新内容。secondary namenode就是用来处理fsimage跟edits文件合并来更新namdenode的metedata的。

四 SecondaryNameNode

1.HA的一个解决方案。但不支持热备,配置即可。

2.执行过程:从NameNode上下载源数据信息(fsuimage.edits),然后把二者合并,生成新的fsimage,在本地保存,并将其推送到NameNode,替换旧的fsimage。

3.默认安装在NameNode上,但这样子不安全。

五 Secondary NameNode工作流程

1.secondary namenode 通知namenode切换edits文件

2.secondary namenode从namenode中获取fsimage和edits(通过http get请求)

3.secondary namenode将fsimage加载到内存中,然后开始合并edits

4.secondarynemenode将最近的fsimage发回给namenode(http post复制)

5.manenode 将最近的fsimage替换旧的的fsimage。

六 什么时候checkpoint

1. fs.checkpoint.period指定两次checkpoint的最大时间间隔,默认3600秒。

2. fs.checkpoint.site 规定site的最大值,一旦超过这个最大值就必须checkpoint,不管是否达到最大时间间隔。默认大小64M。

七 DataNode

1.提供真实文件数据的存储服务。

2.文件快(block):最进本的存储单位。对于文件内容而言,一个文件的长度大小为size,那么从文件的0偏移开始,按照固定的大小,顺序对文件进行划分并编号,划分的每一个块成为Block。HDFS默认Block大小为128M,以一个256M文件为例子,256/128=2个Block。

3.不同于普通文件系统的是,HDFS中,如果一个文件小于一个文件数据库的大小,并不占用整个数据块的存储空间。

4.Replication ,多副本,默认是三个。

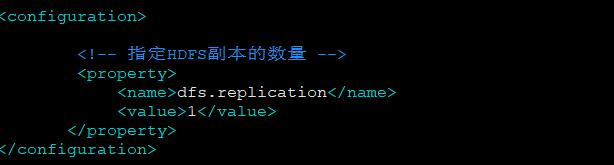

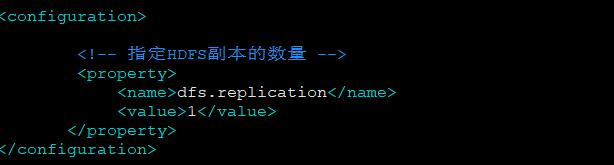

hdfs-size.xml的dfs,replication

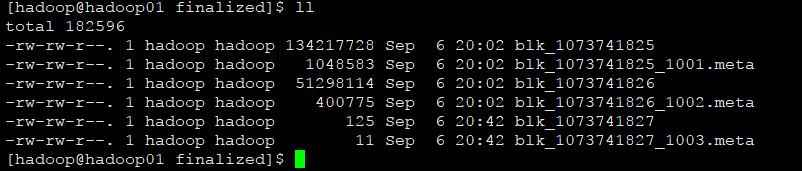

5.验证块的大小

(1)hadoop fs -put /app jdk

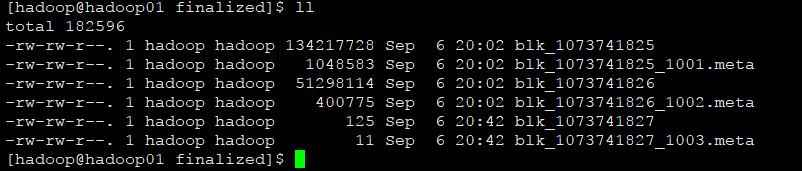

(2)cd /app/hadoop-2.4.1/tmp/dfs/data/current/BP-15754865-192.168.2.10-1504055928500/current/finalized

在当前目录下面查看文件详细

注意:如果是zip文件是不能直接cat查看的,但是如果是文本文件的话是可以的!cat +block查看

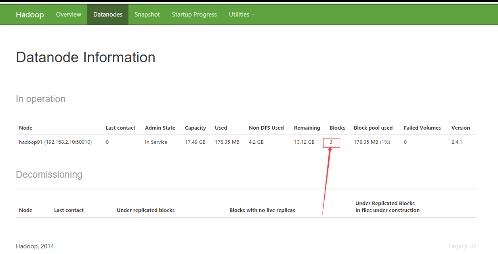

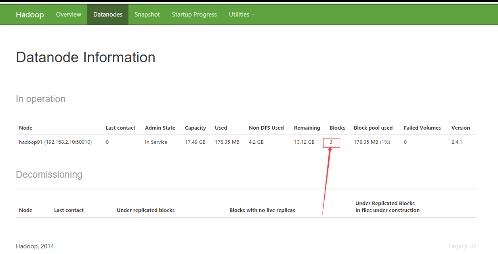

也可以打开192.168.2.10:70070页面查看,选择datanode

3406

3406

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?