docker部署TF_serving模型记录

本文主要介绍了以tf_serving方式部署模型的方法,Java部署tensorflow的方法详见:【 java加载tensorflow训练的PB模型记录】

一、 训练保存模型方法

1.1定义模型输入输出

# 输入query和dropout

tensor_input_query=tf.saved_model.utils.build_tensor_info(model.input_query)

tensor_input_dropout=tf.saved_model.utils.build_tensor_info(model.dropout_keep_prob)

#输出query分类概率

tensor_output_prob=tf.saved_model.utils.build_tensor_info(model.query_probs)

1.2保存模型

#定义模型输入输出签名

prediction_signature = (tf.saved_model.signature_def_utils.build_signature_def(inputs{'query':tensor_input_query,'dropout_keep_prob': tensor_input_dropout},outputs={'probs': tensor_output_prob},

method_name=tf.saved_model.signature_constants.PREDICT_METHOD_NAME))

builder = tf.saved_model.builder.SavedModelBuilder(pb_path)

builder.add_meta_graph_and_variables(sess,[tf.saved_model.tag_constants.SERVING],signature_def_map={'intent_pred_score':prediction_signature})

builder.save()

二、 利用docker部署模型

将pb_path下保存的模型拷贝到你需要存放模型的地址:

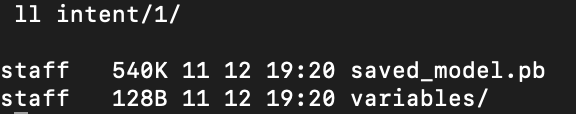

我是放在当前目录下的intent文件夹下,其中1是模型版本号,可以部署多个不同的模型(以版本号区分),并支持模型热更新。

启动tf_serving服务

docker run -p 8500:8500 \

--mount type=bind,source=./intent/,target=/models/intent_score \

-e MODEL_NAME=intent_score -t tensorflow/serving:1.10.0

参数说明

-p: 指定主机到docker容器的端口映射

--mount: 表示要进行挂载

source: 要部署的模型地址

target: 模型挂载到docker容器中的目录

-t: 指定挂载到目标容器

docker run: 启动这个容器并启动模型服务

启动成功效果:

三、 python调用

from __future__ import print_function

from grpc.beta import implementations

from tensorflow_serving.apis import predict_pb2

from tensorflow_serving.apis import prediction_service_pb2

import tensorflow as tf

import numpy as np

def main():

channel = implementations.insecure_channel(host,int(port))

stub = prediction_service_pb2.beta_create_PredictionService_stub(channel)

request = predict_pb2.PredictRequest()

request.model_spec.name = 'intent_score'

request.model_spec.signature_name = 'intent_pred_score'

# 输入

query_id = [0]*16

request.inputs["query"].CopyFrom(tf.contrib.util.make_tensor_proto([query_id], shape=[1,16],dtype=tf.int32))

request.inputs["dropout_keep_prob"].CopyFrom(tf.contrib.util.make_tensor_proto(1.0,dtype=tf.float32))

result = stub.Predict(request, 10.0)

#输出

probs_list = result.outputs['probs'].float_val

if __name__ == '__main__':

tf.app.flags.DEFINE_string('server', '0.0.0.0:8500', 'PredictionService host:port')

FLAGS = tf.app.flags.FLAGS

host,port = FLAGS.server.split(":")

main()

911

911

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?