这个主要是思路方法,不知道为啥锁我,这个哪里涉及版权的问题!!

一.需求及步骤分析

需求:获取,,,,,数据(不写了 免得锁我)

步骤分三部分:1.请求定制 2. 获取响应 3.下载内容

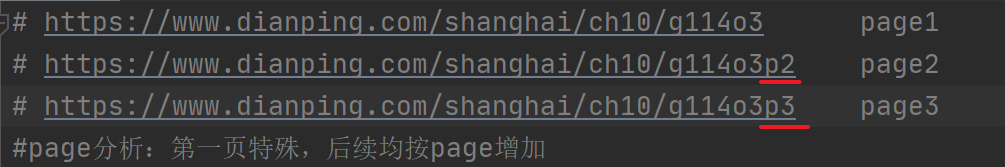

二.分析网页url生成规律

第一页:无规律

第二页:p2

第三页:p3

三.写代码

3.1导入模块(开头)

import urllib.request

3.2 封装函数(放置在最后面)

if __name__ == '__main__':

page_start=int(input("请输入起始页面"))

page_end=int(input("请输入结束页面"))

for page in range(page_start,page_end+1):

create_request(page) # 1.请求定制 传参回传之后 request=create_request(page)

get_content() # 2.获取响应内容 content=get_content(request)

down_load() # 3.下载内容 down_load(page,content) 3.3 请求定制函数方法(更新请求头) 顺着模块往下写

(1)第3.2步的封装函数将page传入,得到def create_request(page):,然后函数可以调用到page参数

(2)return request 将

本文介绍了一个Python爬虫的实现过程,包括分析网页URL规律,创建请求,处理HTTPError403错误,以及如何添加请求头如User-Agent、Cookie和Referer来绕过反爬机制。最终成功下载内容并保存为JSON文件。

本文介绍了一个Python爬虫的实现过程,包括分析网页URL规律,创建请求,处理HTTPError403错误,以及如何添加请求头如User-Agent、Cookie和Referer来绕过反爬机制。最终成功下载内容并保存为JSON文件。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

760

760

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?