文章目录

| 三大组件 | 启动进程 | 备注说明 |

|---|---|---|

| HDFS | NameNode作为主节点, DataNode作为从节点, SecondaryNameNode主节点辅助 | 分布式文件系统 |

| MapReduce | MapReduce程序运行在YARN容器内,无需启动任何进程 | 分布式数据计算 |

| YARN | ResourceManager作为集群资源管理者, NodeManager作为单机资源管理者, ProxyServer代理服务器提供安全性, JobHistoryServer记录历史信息和日志 | 分布式资源调度 |

一、分布式计算组件-MapReduce

1、简介

分布式计算: 多台服务器协同工作,共同完成一个计算任务

分布式计算常见的2种工作模式:

- 分散->汇总 (MapReduce就是这种模式)

- 中心调度->步骤执行 (大数据体系的Spark、Flink等是这种模式)

MapReduce 即Hadoop内提供的进行分布式计算的组件, MapReduce是“分散->汇总”模式的分布式计算框架,可供开发人员开发相关程序进行分布式数据计算。

2、MapReduce的主要编程接口

map接口,主要提供“分散”功能,由服务器分布式处理数据

reduce接口,主要提供“汇总”功能,进行数据汇总统计得到结果

MapReduce可供Java、Python等语言开发计算程序

3、MapReduce的运行机制

将要执行的需求,分解为多个Map Task和Reduce Task

将Map Task 和 Reduce Task分配到对应的服务器去执行

4、MapReduce框架的运行配置

在 $HADOOP_HOME/etc/hadoop 文件夹内,需要修改两个文件

mapred-env.sh文件

方式1: 执行如下命令添加配置信息

export JAVA_HOME=/opt/jdk

export HADOOP_JOB_HISTORYSERVER_HEAPSIZE=1000

export HADOOP_MAPRED_ROOT_LOGGER=INFO,RFA

方式2: 直接执行如下命令追加配置信息即可

sh -c "echo 'export JAVA_HOME=/opt/jdk' >> /opt/hadoop/etc/hadoop/mapred-env.sh"

sh -c "echo 'export HADOOP_JOB_HISTORYSERVER_HEAPSIZE=1000' >> /opt/hadoop/etc/hadoop/mapred-env.sh"

sh -c "echo 'export HADOOP_MAPRED_ROOT_LOGGER=INFO,RFA' >> /opt/hadoop/etc/hadoop/mapred-env.sh"

mapred-site.xml文件

vim /opt/hadoop/etc/hadoop/mapred-site.xml

添加如下配置

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

<description>MapReduce运行框架设置为yarn</description>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop-1:10020</value>

<description>历史服务器通讯端口为hadoop-1:10020</description>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop-1:19888</value>

<description>历史服务器web端口为hadoop-1的19888</description>

</property>

<property>

<name>mapreduce.jobhistory.intermediate-done-dir</name>

<value>/data/mr-history/tmp</value>

<description>历史信息在HDFS的记录临时路径</description>

</property>

<property>

<name>mapreduce.jobhistory.done-dir</name>

<value>/data/mr-history/done</value>

<description>历史信息在HDFS的记录路径</description>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<description>MapReduce HOME 设置为 HADOOP_HOME</description>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<description>MapReduce HOME 设置为 HADOOP_HOME</description>

</property>

<property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<description>MapReduce HOME 设置为 HADOOP_HOME</description>

</property>

至此MapReduce已配置完成

二、分布式调度组件-YARN

1、简介

YARN是Hadoop的分布式调度组件 , 管控整个集群的资源(内存、CPU等)进行调度。

为什么要调度?

因为资源统一管控进行分配可以提高资源利用率

程序如何在YARN内运行?

程序向YARN申请所需资源, YARN为程序分配所需资源供程序使用

MapReduce和YARN的关系?

YARN用来调度资源给MapReduce分配和管理运行资源, 所以MapReduce需要YARN才能执行(普遍情况)

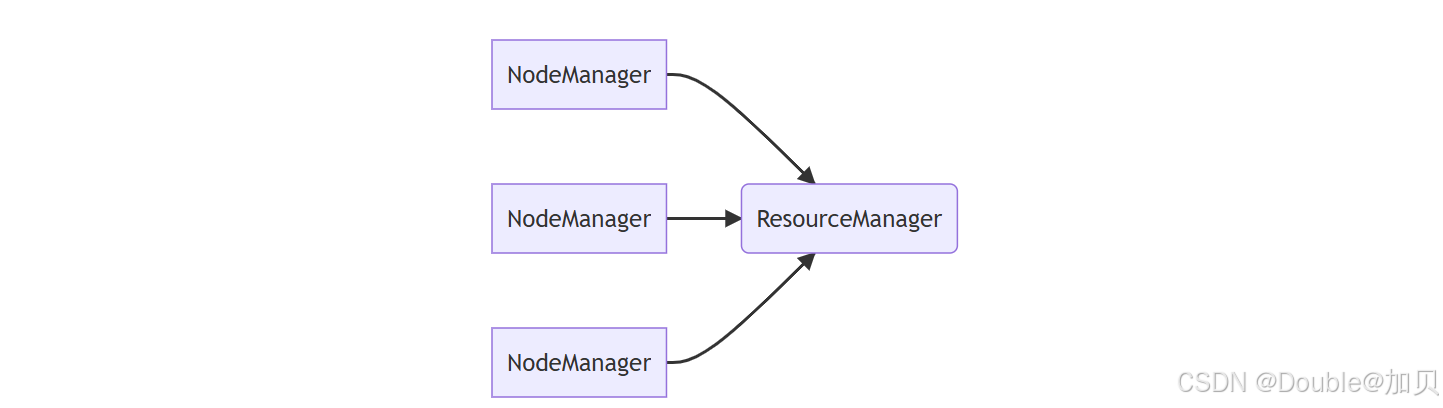

2、YARN架构

YARN主从架构,有两个角色

ResourceManager 主(Master)角色:

整个集群的资源调度者, 负责协调调度各个程序所需的资源。

NodeManager 从(Slave) 角色:

单个服务器的资源调度者,负责调度单个服务器上的资源提供给应用程序使用。

3、辅助角色

YARN的架构中除了核心角色,还可以搭配2个辅助角色使得YARN集群运行更加稳定

- 代理服务器(ProxyServer):Web Application Proxy Web应用程序代理

默认情况下,它将作为资源管理器(RM)的一部分运行,但是可以配置为在独立模式下运行。使用代理的原因是为了减少通过 YARN 进行基于网络的攻击的可能性。因为YARN在运行时会提供一个WEB UI站点(同HDFS的WEB UI站点一样)可供用户在浏览器内查看YARN的运行信息, 对外提供WEB 站点会有安全性问题, 而代理服务器的功能就是最大限度保障对WEB UI的访问是安全的。

比如: 警告用户正在访问一个不受信任的站点 剥离用户访问的Cookie等 开启代理服务器,可以提高YARN在开放网络中的安全性 (但不是绝对安全只能是辅助提高一些)

- 历史服务器(JobHistoryServer): 应用程序历史信息记录服务

记录历史运行的程序的信息以及产生的日志并提供WEB UI站点供用户使用浏览器查看。

4、YARN运行配置文件

在 $HADOOP_HOME/etc/hadoop 文件夹内,需要修改两个文件

yarn-env.sh文件

vim /opt/hadoop/etc/hadoop/yarn-env.sh

添加如下4行环境变量内容

export JAVA_HOME=/opt/jdk

export HADOOP_HOME=/opt/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_LOG_DIR=$HADOOP_HOME/logs

yarn-site.xml文件

vim /opt/hadoop/etc/hadoop/yarn-site.xml

添加如下配置

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop-1</value>

<description>resourcemanager设置在hadoop-1节点</description>

</property>

<property>

<name>yarn.nodemanager.local-dirs</name>

<value>/data/nm-local</value>

<description>nodemanager中间数据本地存储路径</description>

</property>

<property>

<name>yarn.nodemanager.log-dirs</name>

<value>/data/nm-log</value>

<description>nodemanager数据本地存储路径</description>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

<description>为mapreduce程序开启shuffle服务</description>

</property>

<property>

<name>yarn.log.server.url</name>

<value>http://hadoop-1:19888/jobhistory/logs</value>

<description>历史服务器URL</description>

</property>

<property>

<name>yarn.web-proxy.address</name>

<value>hadoop-1:8089</value>

<description>代理服务器主机和端口</description>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

<description>开启日志聚合</description>

</property>

<property>

<name>yarn.nodemanager.remote-app-log-dir</name>

<value>/tmp/logs</value>

<description>程序日志和HDFS的存储路径</description>

</property>

<property>

<name>yarn.resourcemanager.scheduler</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.scheduler.fair.FairScheduler</value>

<description>选择公平调度器</description>

</property>

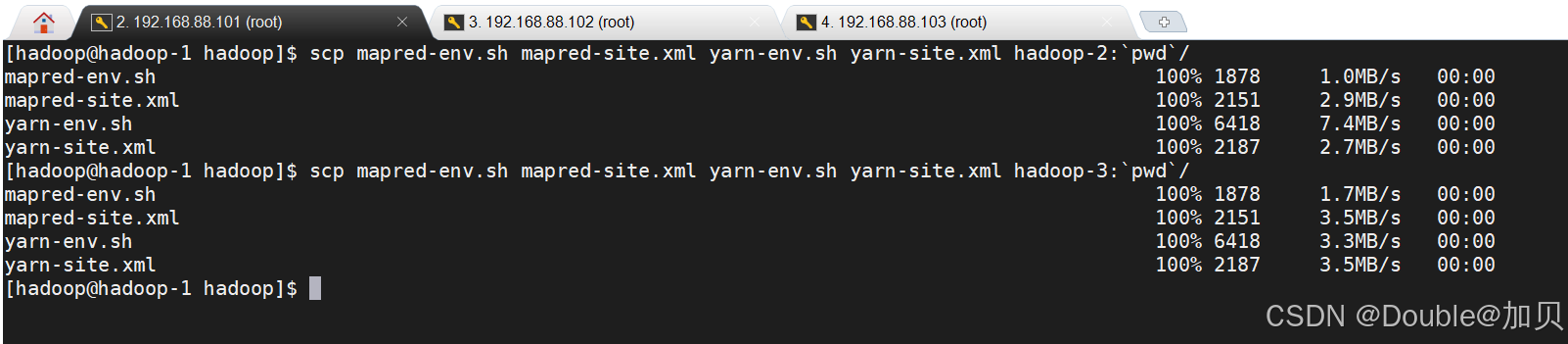

分发配置到其他节点

cd /opt/hadoop/etc/hadoop

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml hadoop-2:`pwd`/

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml hadoop-3:`pwd`/

三、实操验证

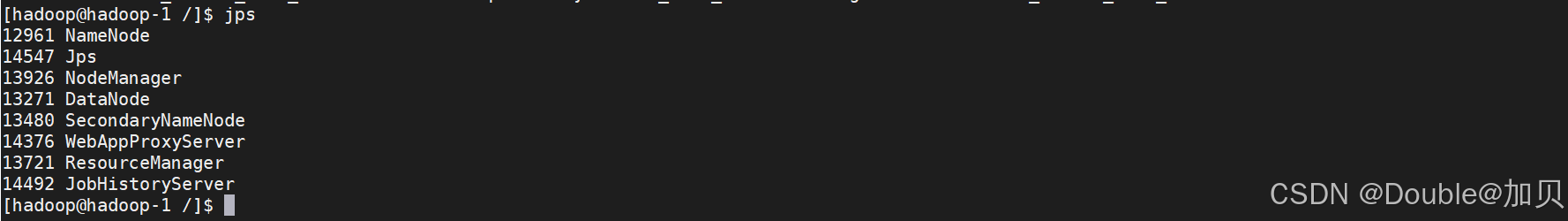

1、启停命令验证

一键启动YARN集群: $HADOOP_HOME/sbin/start-yarn.sh

一键停止YARN集群: $HADOOP_HOME/sbin/stop-yarn.sh

单独启动或停止进程

$HADOOP_HOME/bin/yarn --daemon start|stop resourcemanager|nodemanager|proxyserver

历史服务器启动和停止

$HADOOP_HOME/bin/mapred --daemon start|stop historyserver/

示例:

一键启动hdfs

start-dfs.sh

一键启动yarn

start-yarn.sh

单独启动历史服务器

mapred --daemon start historyserver

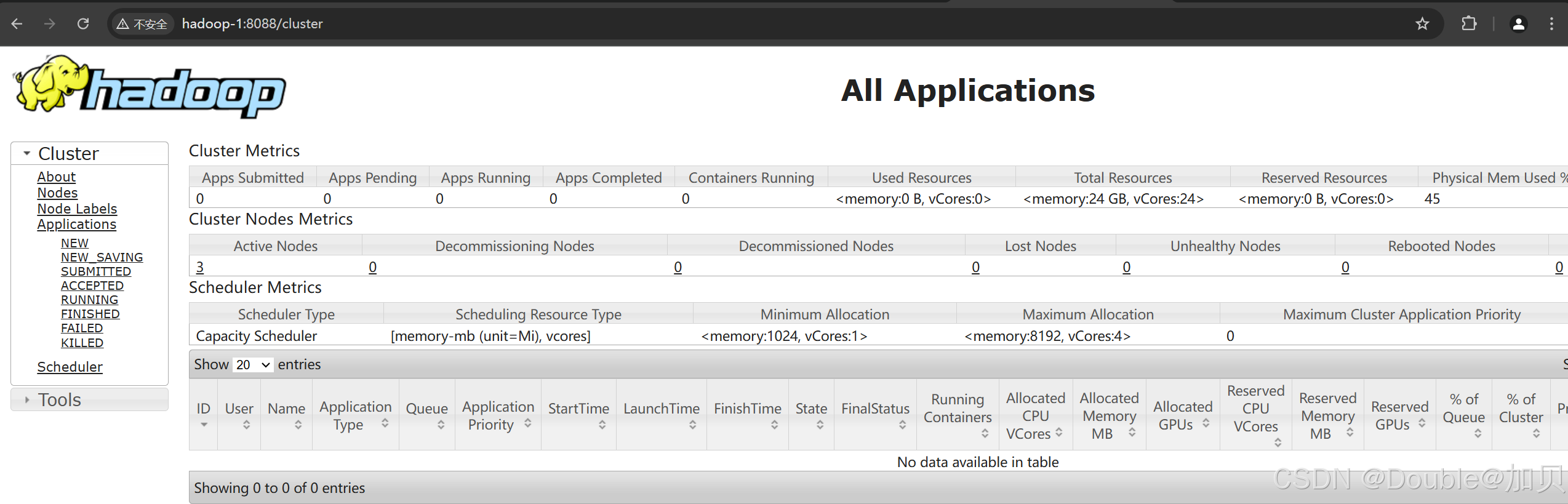

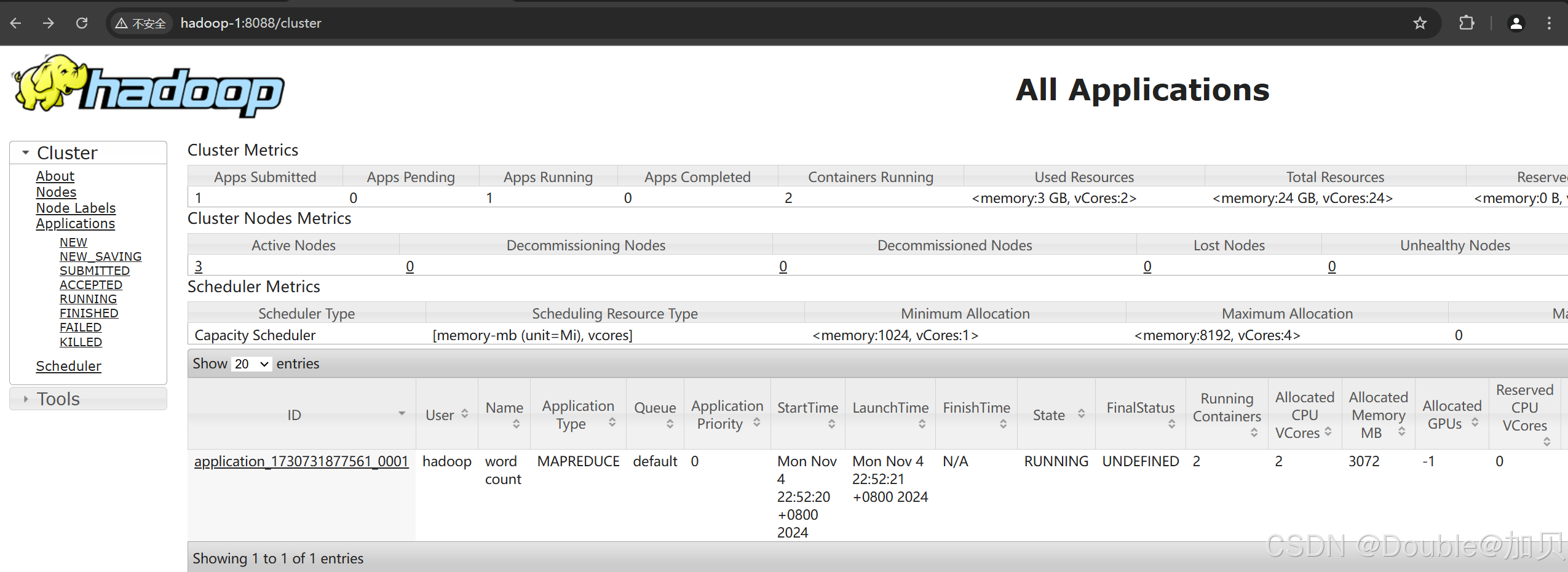

完成yarn的集群部署,访问 http://hadoop-1:8088成功

2、执行程序验证

Hadoop官方内置了一些预置的MapReduce程序代码, 只需要通过命令即可使用。

wordcount:单词计数程序。 统计指定文件内各个单词出现的次数

pi:求圆周率 通过蒙特卡罗算法(统计模拟法)求圆周率

内置的示例MapReduce程序代码,都在: $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar 这个文件内。可以通过 hadoop jar 命令来运行它,提交MapReduce程序到YARN中。

语法: hadoop jar 程序文件 java类名 [程序参数] ... [程序参数]

步骤:

①本地创建一个 /home/hadoop/hello.txt 文件,文件内容为

test1 test2 test3 test1 test2 test3 test1 test2 test3 test1 test2 test3

test1 test2 test3 test4 hdfs hadoop hdfs hadoop hdfs

②上传本地文件到hdfs

hadoop fs -mkdir -p /input/wordcount

hadoop fs -put -f /home/hadoop/hello.txt /input/wordcount/hello.txt

③执行如下命令提交示例MapReduce程序WordCount到YARN中执行计算

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.4.jar wordcount hdfs://hadoop-1:8020/input/wordcount/ hdfs://hadoop-1:8020/output/wordcount

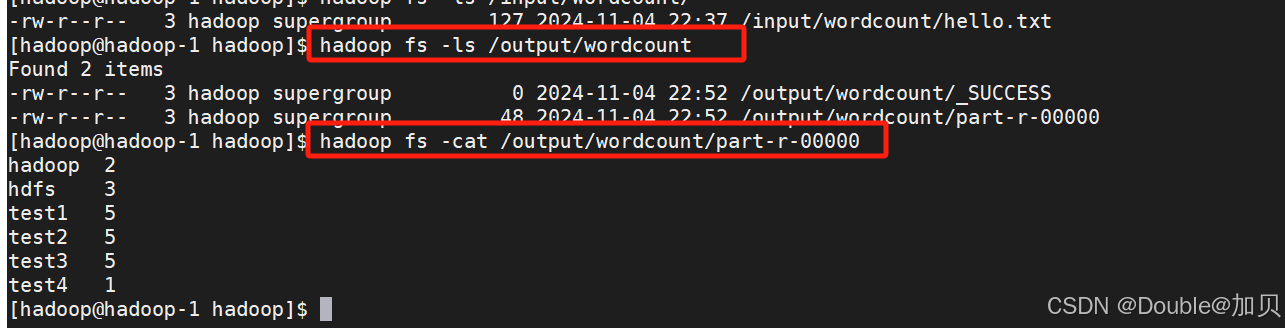

④查看输出文件

hadoop fs -ls /output/wordcount

hadoop fs -cat /output/wordcount/part-r-00000

_SUCCESS文件是标记文件,表示运行成功,本身是空文件

part-r-00000,是结果文件,结果存储在以part开头的文件中

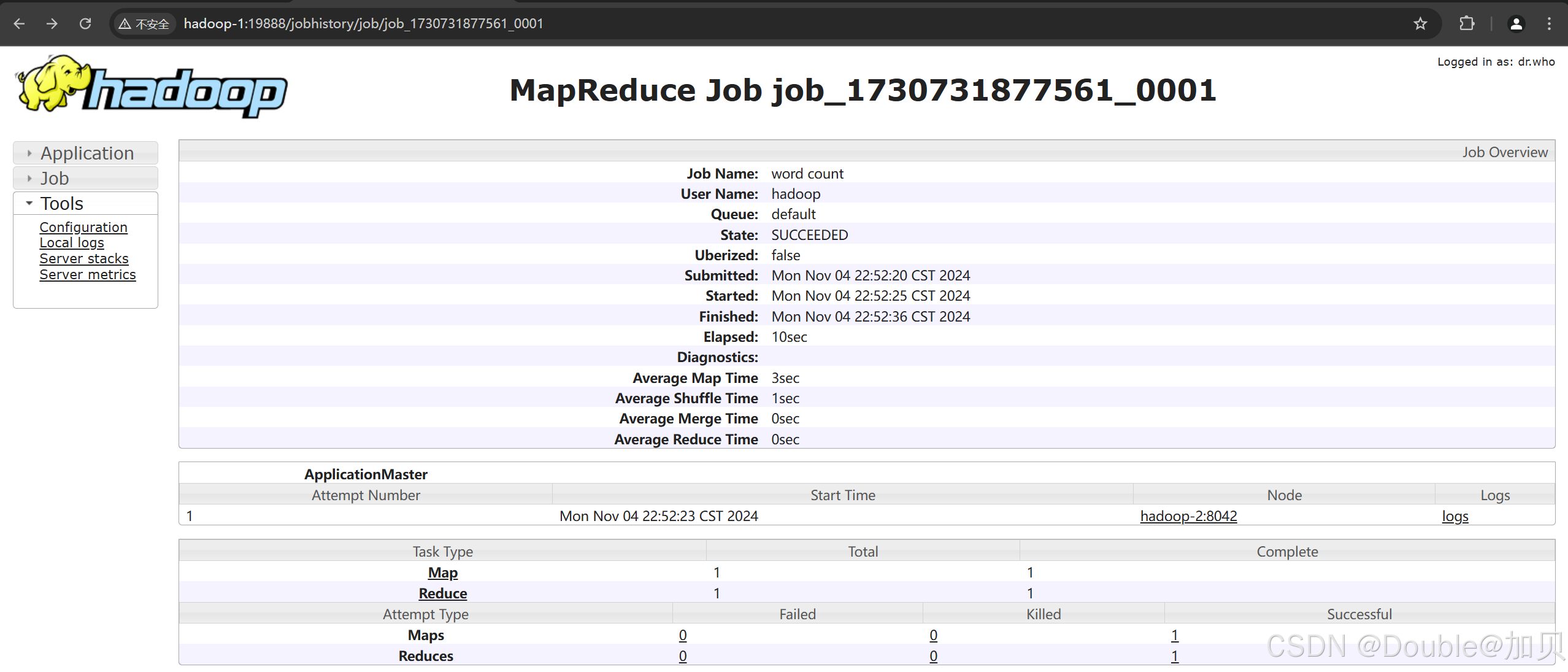

执行完成后,可以借助历史服务器查看到程序的历史运行信息

http://hadoop-1:19888/jobhistory/job/job_1730731877561_0001

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?