文章目录

前提条件:

在同一局域网下使用SecureCRT对其中一台服务器进行连接并实现远程操控。

一、 Java下载与安装配置

1.1 Java下载

(鼠标右键粘贴,左键复制,Tab键自动补全)

wget http://download.oracle.com/otn-pub/java/jdk/8u162-b12/0da788060d494f5095bf8624735fa2f1/jdk-8u162-linux-x64.tar.gz

1.2 Java安装:

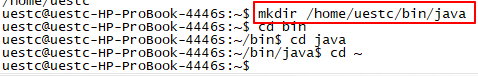

- 创建新目录:mkdir /home/uestc/bin/java(cd -:返回上级目录;cd~:返回根目录;ls:查看当前目录下内容;pwd:显示当前位置)

- 将下载的JDK移动至新建文件夹中:mv 文件所在目录/文件名 /新建目录

- 解压文件夹:tar -xvf jdk-8u162-linux-x64.tar.gz

- 配置Java:

# a. 修改环境变量:

sudo vim ~/.bashrc(针对个人用户则配置bashrc,全局则配置/etc/profile)

# b. 在末尾添加:

export JAVA_HOME=/home/uestc/bin/java/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASS_PATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

# c. 保存退出后使配置文件生效:

source ~/.bashrc

- 检测JAVA:

java –version

在出现提示“尝试:sudo apt install <选定的软件包>”时输入以下语句:

uestc@sparkmaster:~$ sudo apt install gcj-5-jre-headless

另外,删除自带 openjdk 的指令为:sudo apt-get remove openjdk*,最终结果应如下图所示:

1.3 其他服务器的Java安装

运用 scp 命令在 sparkworker1 和 sparkworker2 上安装 JDK 并采用上面相同的方式进行配置环境和检测:

scp -r [email protected]:/home/uestc/bin/java /home/uestc/bin/java

此为确保后期其他服务器配置 Scala 时 Java 环境正确。

二、SSH安装及设置

Hadoop 是采用 ssh 进行通信的,此时我们要设置密码为空,即不需要密码登录,这样免去每次通信时都输入密码。

2.1 安装并验证 SSH

- 安装ssh:

sudo apt-get install ssh - 启动ssh服务:

/etc/init.d/ssh start - 验证服务是否正常启动:

ps -e |grep ssh

2.2 设置 ssh 免密登录

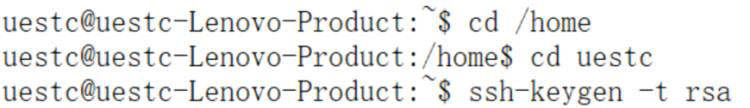

- 设置免密登录,生成私钥和公钥:

ssh-keygen -t rsa

(需要针对用户uestc进行操作,否则会默认生成根目录在root里面,用户uestc会没有访问权限)

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?