文章目录

- 零、学习目标

- pom.xml 文件

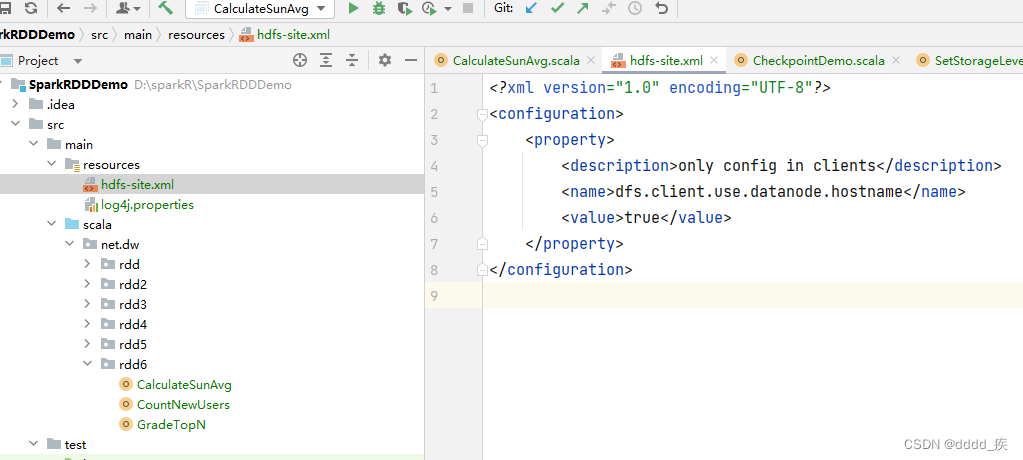

- hdfs-site.xml文件

- 一、利用RDD计算总分和平均分

- 二、利用RDD统计每日新增用户

- 三、利用RDD实现分组排行榜

零、学习目标

1.利用RDD计算总分和平均分

2.利用RDD统计每日新增用户

3.利用RDD实现分组排行榜

pom.xml 文件

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>net.dw.rdd</groupId>

<artifactId>SparkRDDDemo</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties>

<dependencies>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.12.15</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.3.2</version>

</dependency>

</dependencies>

<build>

<sourceDirectory>src/main/scala</sourceDirectory>

</build>

</project>

hdfs-site.xml文件

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<property>

<description>only config in clients</description>

<name>dfs.client.use.datanode.hostname</name>

<value>true</value>

</property>

</configuration>

## 如果没有这个文件,访问不到hdfs上的文件

## 如果没有这个文件,访问不到hdfs上的文件

一、利用RDD计算总分和平均分

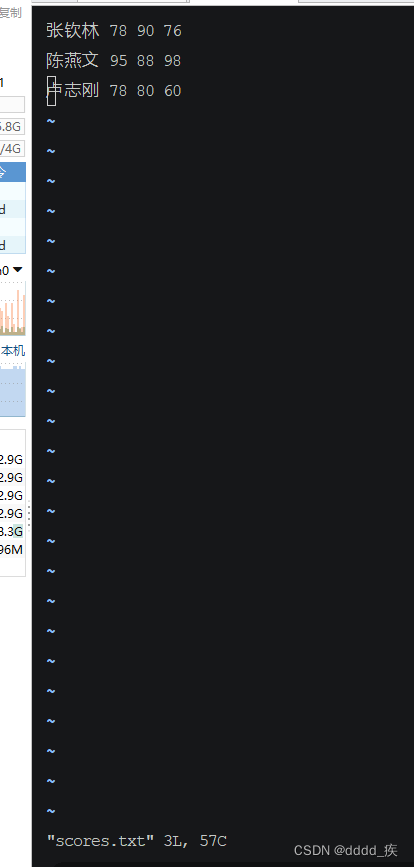

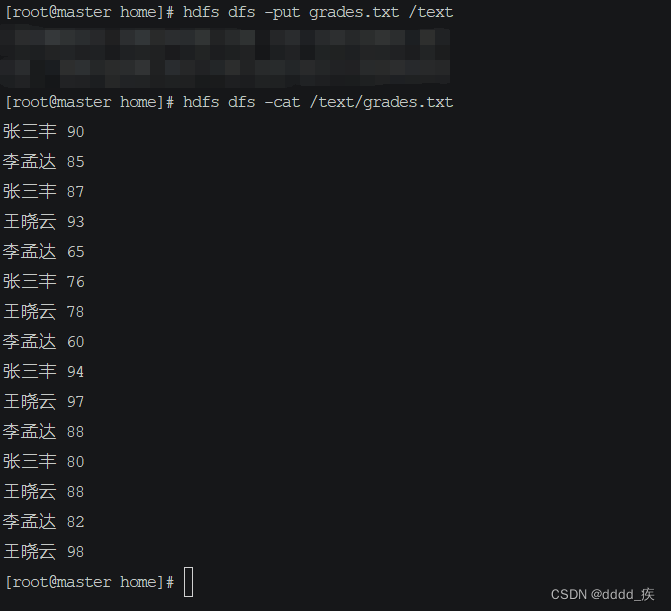

准备文件

–在home上准备scores.txt文件

–在上传到hdfs并创建 scoresumavg目录再在里面创建input目录,再把scores.txt文件上传到input目录下

[root@master home]# hdfs dfs -mkdir -p /scoresumavg/input

[root@master home]# hdfs dfs -put scores.txt /scoresumavg/input

[root@master home]# hdfs dfs -cat /scoresumavg/input/scores.txt

张钦林 78 90 76

陈燕文 95 88 98

卢志刚 78 80 60

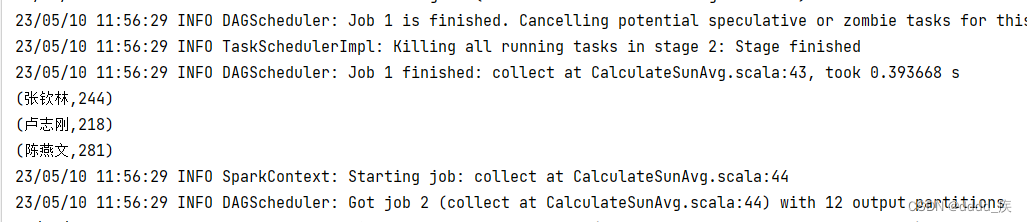

实现.利用RDD计算总分和平均分

–打开IEAD

–添加pom.xml依赖

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>net.dw.rdd</groupId>

<artifactId>SparkRDDDemo</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties>

<dependencies>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.12.15</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.3.2</version>

</dependency>

</dependencies>

<build>

<sourceDirectory>src/main/scala</sourceDirectory>

</build>

</project>

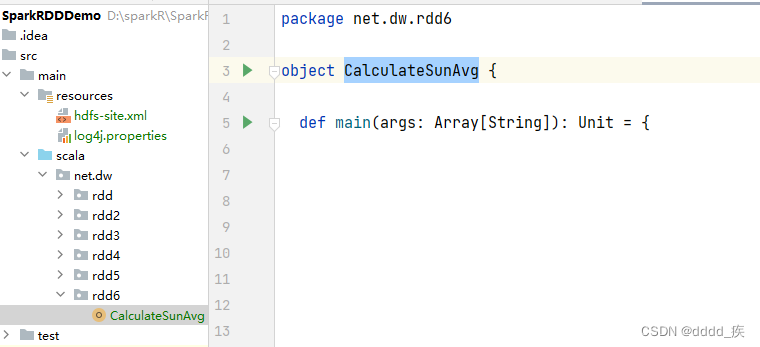

–新建一个rdd6包

–rdd6包里创建CalculateSunAvg对象

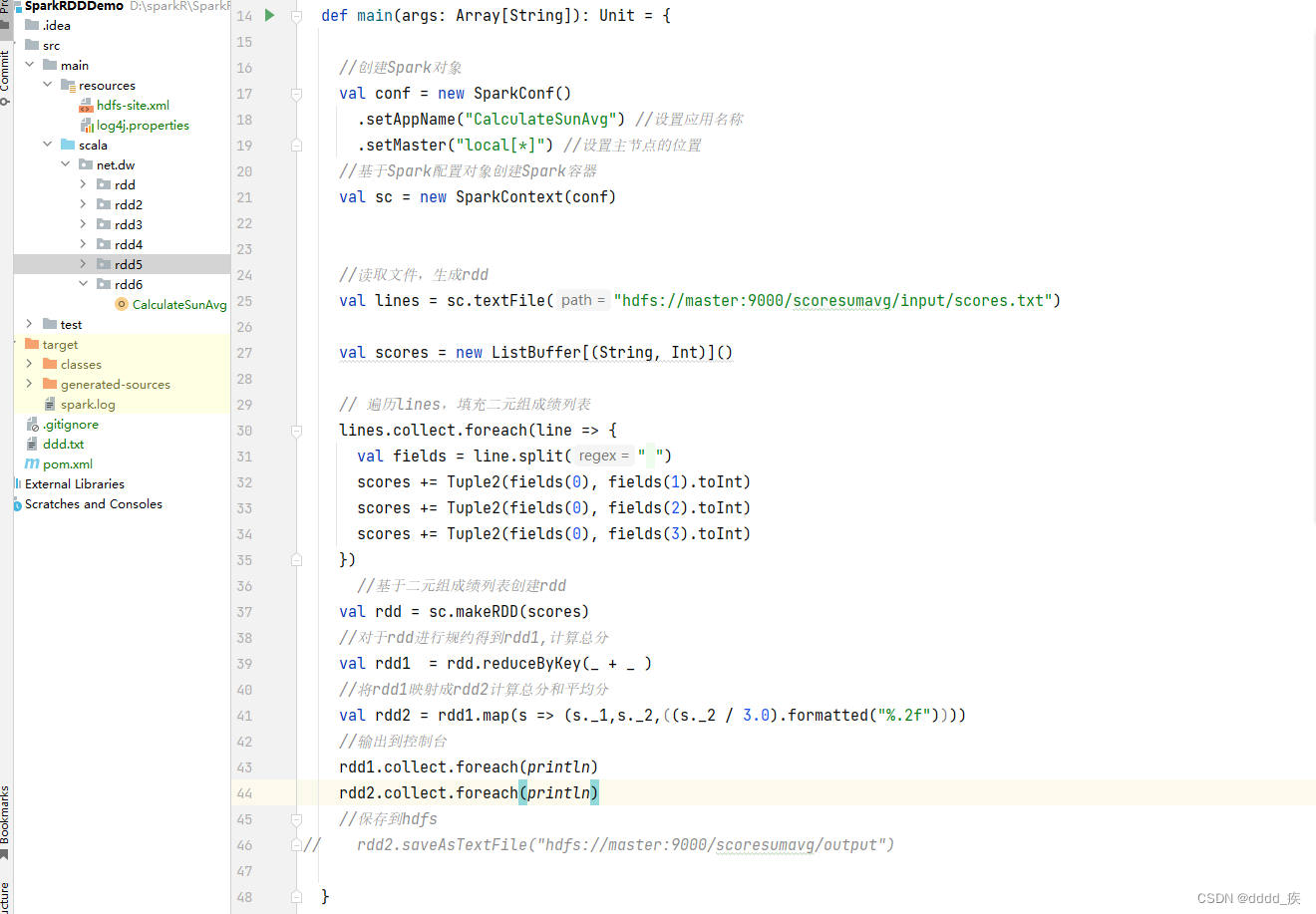

package net.dw.rdd6

import org.apache.spark.{SparkConf, SparkContext}

import scala.collection.mutable.ListBuffer

/**

* 计算总分和平均分

*/

object CalculateSunAvg {

def main(args: Array[String]): Unit = {

//创建Spark对象

val conf = new SparkConf()

.setAppName("CalculateSunAvg") //设置应用名称

.setMaster("local[*]") //设置主节点的位置

//基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

//读取文件,生成rdd

val lines = sc.textFile("hdfs://master:9000/scoresumavg/input/scores.txt")

val scores = new ListBuffer[(String, Int)]()

// 遍历lines,填充二元组成绩列表

lines.collect.foreach(line => {

val fields = line.split(" ")

scores += Tuple2(fields(0), fields(1).toInt)

scores += Tuple2(fields(0), fields(2).toInt)

scores += Tuple2(fields(0), fields(3).toInt)

})

//基于二元组成绩列表创建rdd

val rdd = sc.makeRDD(scores)

//对于rdd进行规约得到rdd1,计算总分

val rdd1 = rdd.reduceByKey(_ + _ )

//将rdd1映射成rdd2计算总分和平均分

val rdd2 = rdd1.map(s => (s._1,s._2,((s._2 / 3.0).formatted("%.2f"))))

//输出到控制台

rdd1.collect.foreach(println)

rdd2.collect.foreach(println)

//保存到hdfs

// rdd2.saveAsTextFile("hdfs://master:9000/scoresumavg/output")

}

}

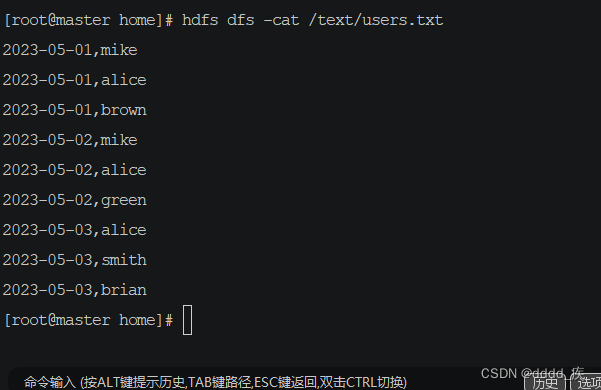

二、利用RDD统计每日新增用户

0.问题已知有以下用户访问历史数据,第一列为用户访问网站的日期,第二列为用户名。`2023-05-01,mike

2023-05-01,alice

2023-05-01,brown

2023-05-02,mike

2023-05-02,alice

2023-05-02,green

2023-05-03,alice

2023-05-03,smith

2023-05-03,brian

`

–现需要根据上述数据统计每日新增的用户数量,期望统计结果。

0.1思路

–使用倒排索引法,若将用户名看作关键词,访问日期看作文档ID,则用户名与访问日期的映射关

–若同一个用户对应多个访问日期,则最小的日期为该用户的注册日期,即新增日期,其他日期为重复访问日期,不应统计在内。因此每个用户应该只计算用户访问的最小日期即可。如下图所示,将每个用户访问的最小日期都移到第一列,第一列为有效数据,只统计第一列中每个日期的出现次数,即为对应日期的新增用户数。

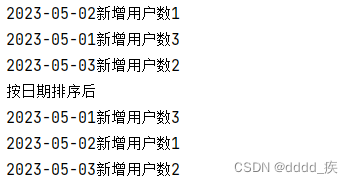

2023-05-01新增用户数:3

2023-05-02新增用户数:1

2023-05-03新增用户数:2

1. 在spark shell 上完成

(1)文件准备,users.txt

2023-05-01,mike

2023-05-01,alice

2023-05-01,brown

2023-05-02,mike

2023-05-02,alice

2023-05-02,green

2023-05-03,alice

2023-05-03,smith

2023-05-03,brian

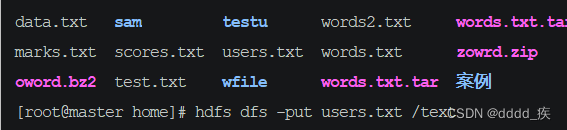

(2)上传到HDFS hdfs dfs -put users.txt /text

(3)查看hdfs上的文件 hdfs dfs -cat /text/users.txt

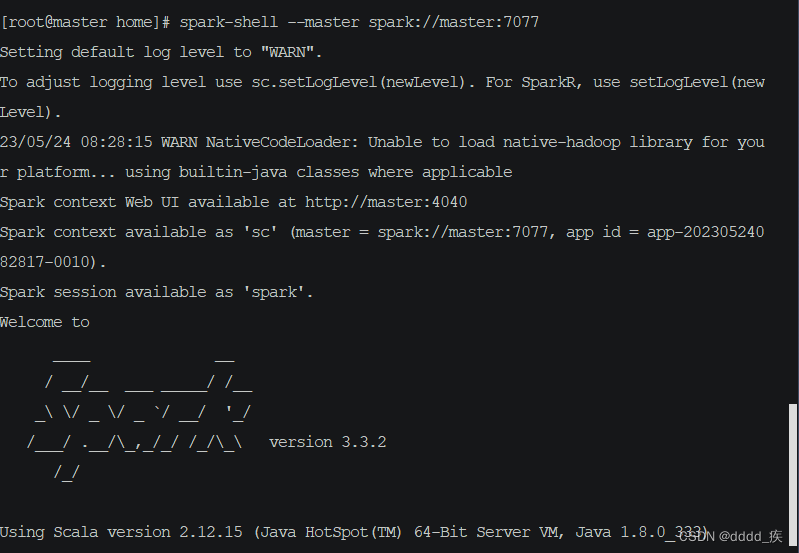

(4)启动Spark Shell

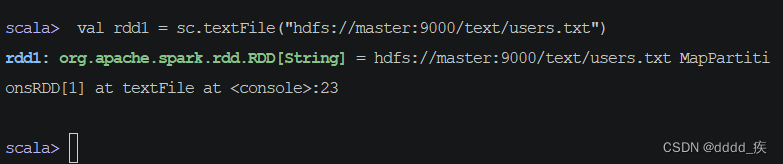

(5)读取文件,得到RDD

– val rdd1 = sc.textFile(“hdfs://master:9000/text/users.txt”)

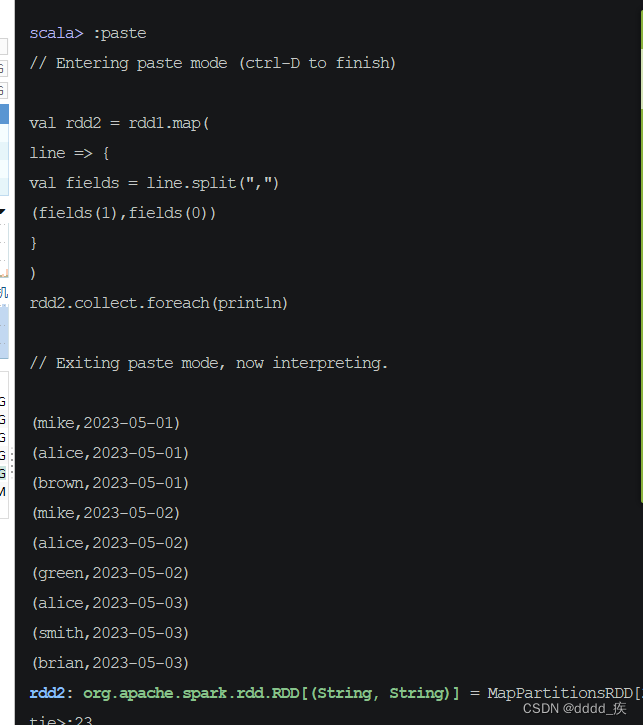

(6)倒排,互换RDD中元组的元素顺序

val rdd2 = rdd1.map(

line => {

val fields = line.split(",")

(fields(1), fields(0))

}

)

rdd2.collect.foreach(println)

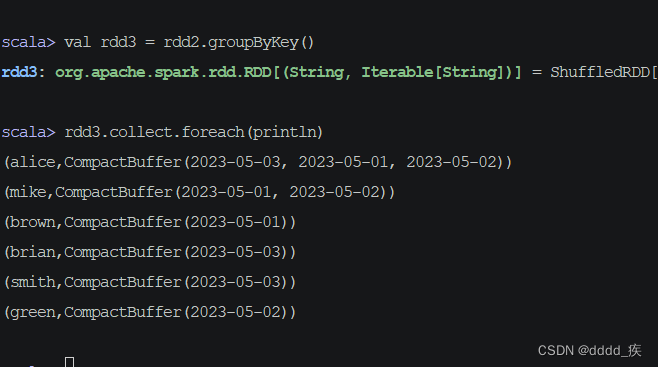

(7)倒排后的RDD按键分组

– 执行命令:val rdd3 = rdd2.groupByKey()

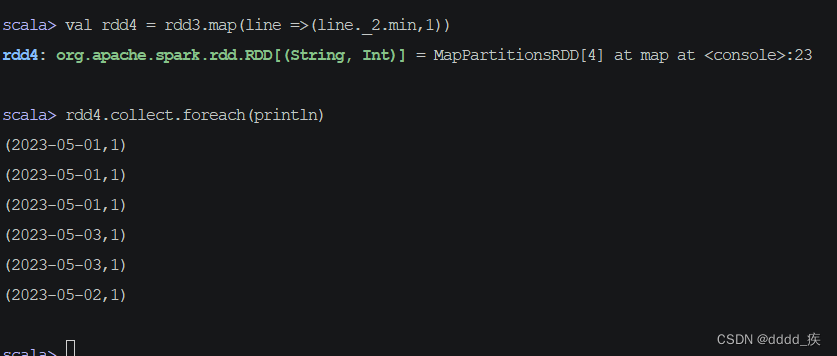

(8) 取分组后的日期集合最小值,计数为1

(9)按键计数,得到每日新增用户数

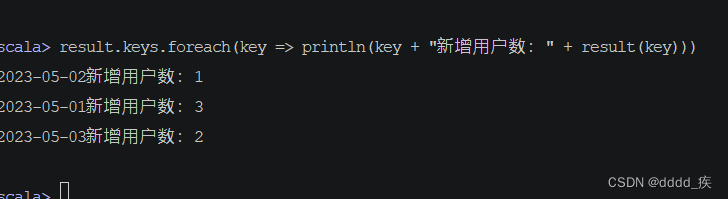

– val result = rdd4.countByKey()

– 执行命令:result.keys.foreach(key => println(key + “新增用户:” + result(key)))

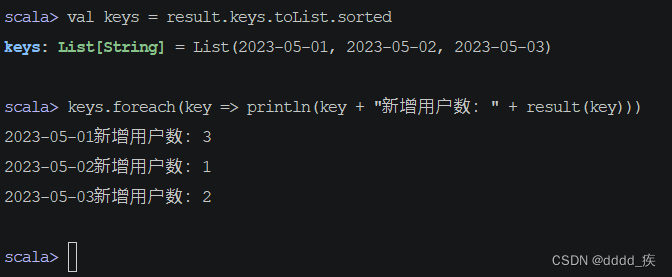

(10)让输出结果按日期升序

– 映射不能直接排序,只能让键集转成列表之后先排序,再遍历键集输出映射

–** 执行命令:val keys = result.keys.toList.sorted,让键集升序排列(日期升序)**

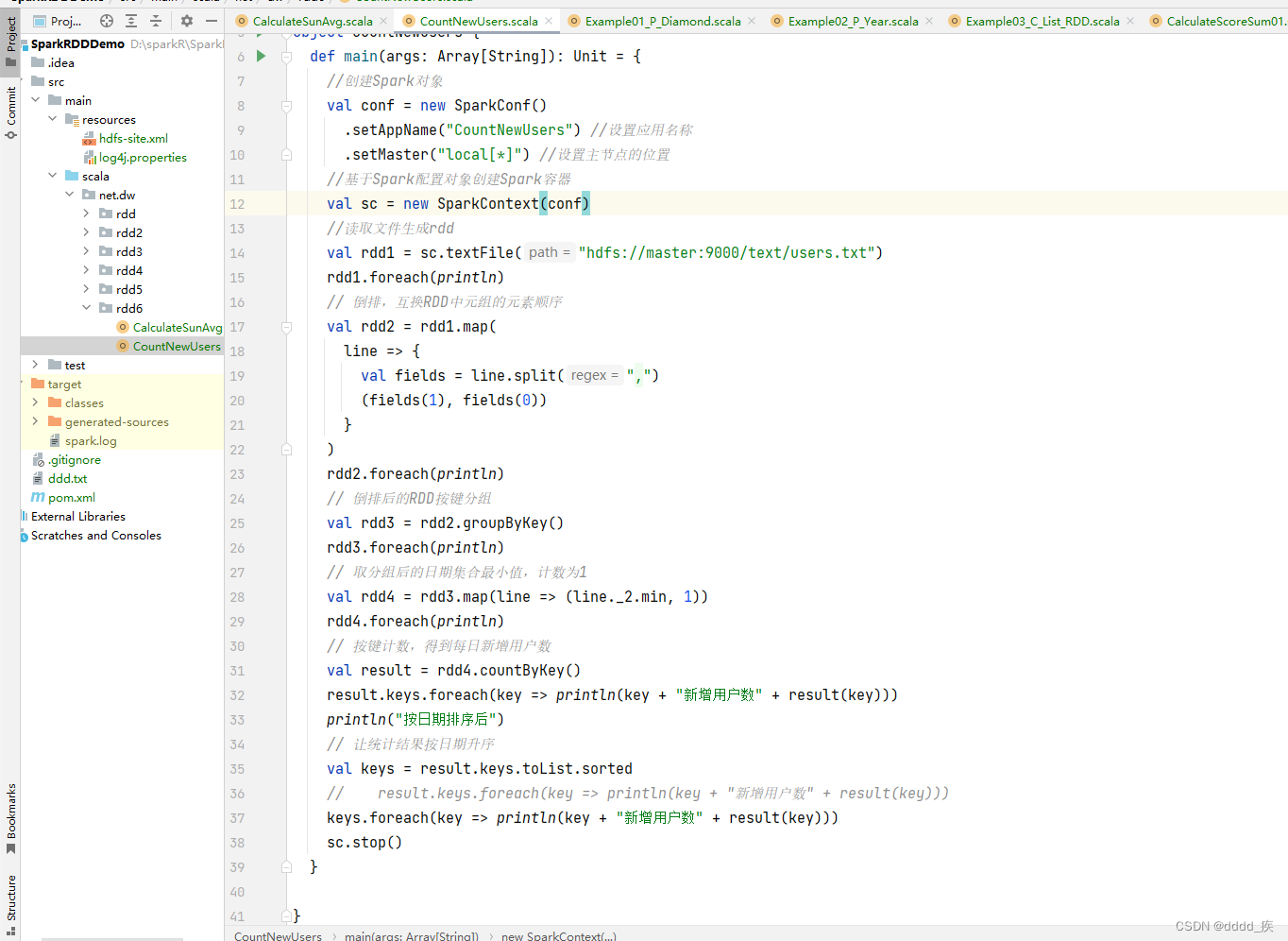

2.在ldea 上完成

package net.dw.rdd6

import org.apache.spark.{SparkConf, SparkContext}

object CountNewUsers {

def main(args: Array[String]): Unit = {

//创建Spark对象

val conf = new SparkConf()

.setAppName("CountNewUsers") //设置应用名称

.setMaster("local[*]") //设置主节点的位置

//基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

//读取文件生成rdd

val rdd1 = sc.textFile("hdfs://master:9000/text/users.txt")

rdd1.foreach(println)

// 倒排,互换RDD中元组的元素顺序

val rdd2 = rdd1.map(

line => {

val fields = line.split(",")

(fields(1), fields(0))

}

)

rdd2.foreach(println)

// 倒排后的RDD按键分组

val rdd3 = rdd2.groupByKey()

rdd3.foreach(println)

// 取分组后的日期集合最小值,计数为1

val rdd4 = rdd3.map(line => (line._2.min, 1))

rdd4.foreach(println)

// 按键计数,得到每日新增用户数

val result = rdd4.countByKey()

result.keys.foreach(key => println(key + "新增用户数" + result(key)))

println("按日期排序后")

// 让统计结果按日期升序

val keys = result.keys.toList.sorted

// result.keys.foreach(key => println(key + "新增用户数" + result(key)))

keys.foreach(key => println(key + "新增用户数" + result(key)))

sc.stop()

}

}

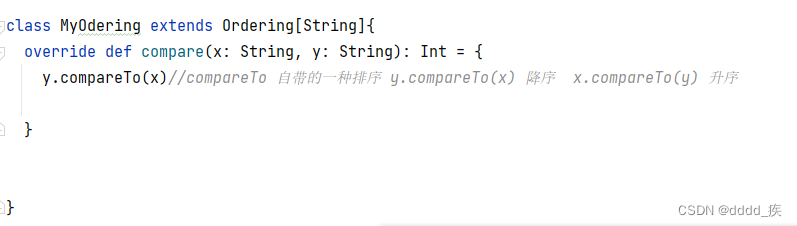

如何降序?

(1定义一个MyOdering)并继承Ordering[String]

class MyOdering extends Ordering[String]{

override def compare(x: String, y: String): Int = {

y.compareTo(x)//compareTo 自带的一种排序 y.compareTo(x) 降序 x.compareTo(y) 升序

}

}

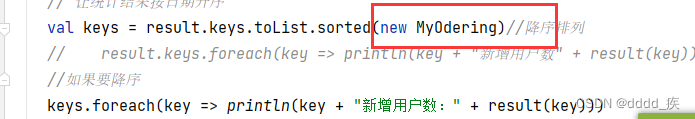

然后在刚刚的代码里做一个小小的修改就好了,在sorted( new MyOdering)

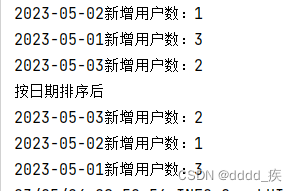

再次运行就是降序排序了

完整代码如下

package net.dw.rdd6

import org.apache.spark.{SparkConf, SparkContext}

object CountNewUsers {

def main(args: Array[String]): Unit = {

//创建Spark对象

val conf = new SparkConf()

.setAppName("CountNewUsers") //设置应用名称

.setMaster("local[*]") //设置主节点的位置

//基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

//读取文件生成rdd

val rdd1 = sc.textFile("hdfs://master:9000/text/users.txt")

rdd1.foreach(println)

// 倒排,互换RDD中元组的元素顺序

val rdd2 = rdd1.map(

line => {

val fields = line.split(",")

(fields(1), fields(0))

}

)

rdd2.foreach(println)

// 倒排后的RDD按键分组

val rdd3 = rdd2.groupByKey()

rdd3.foreach(println)

// 取分组后的日期集合最小值,计数为1

val rdd4 = rdd3.map(line => (line._2.min, 1))

rdd4.foreach(println)

// 按键计数,得到每日新增用户数

val result = rdd4.countByKey()

result.keys.foreach(key => println(key + "新增用户数:" + result(key)))

println("按日期排序后")

// 让统计结果按日期升序

val keys = result.keys.toList.sorted(new MyOdering)//降序排列

// result.keys.foreach(key => println(key + "新增用户数" + result(key)))

//如果要降序

keys.foreach(key => println(key + "新增用户数:" + result(key)))

sc.stop()

}

class MyOdering extends Ordering[String]{

override def compare(x: String, y: String): Int = {

y.compareTo(x)//compareTo 自带的一种排序 y.compareTo(x) 降序 x.compareTo(y) 升序

}

}

}

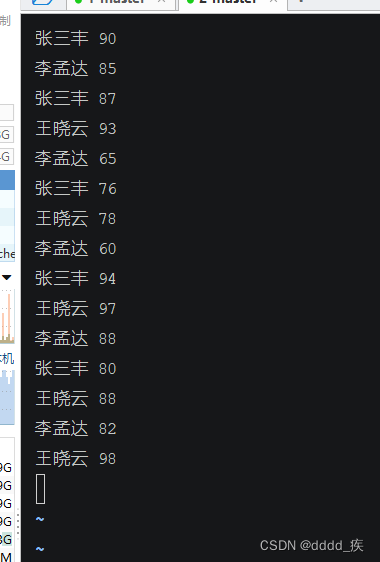

三、利用RDD实现分组排行榜

0问题:分组求TopN是大数据领域常见的需求,主要是根据数据的某一列进行分组,然后将分组后的每一组数据按照指定的列进行排序,最后取每一组的前N行数据。

0.1数据如下

张三丰 90

李孟达 85

张三丰 87

王晓云 93

李孟达 65

张三丰 76

王晓云 78

李孟达 60

张三丰 94

王晓云 97

李孟达 88

张三丰 80

王晓云 88

李孟达 82

王晓云 98

期望格式

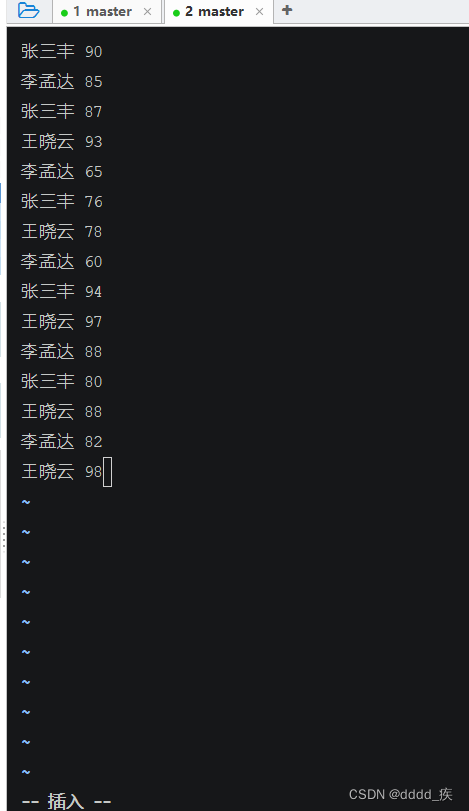

–同一个学生有多门成绩,现需要计算每个学生分数最高的前3个成绩,期望输出结果如下所示

张三丰:94 90 87

李孟达:88 85 82

王晓云:98 97 93

思路:使用Spark RDD的groupByKey()算子可以对(key, value)形式的RDD按照key进行分组,key相同的元素的value将聚合到一起,形成(key, value-list),将value-list中的元素降序排列取前N个即可。

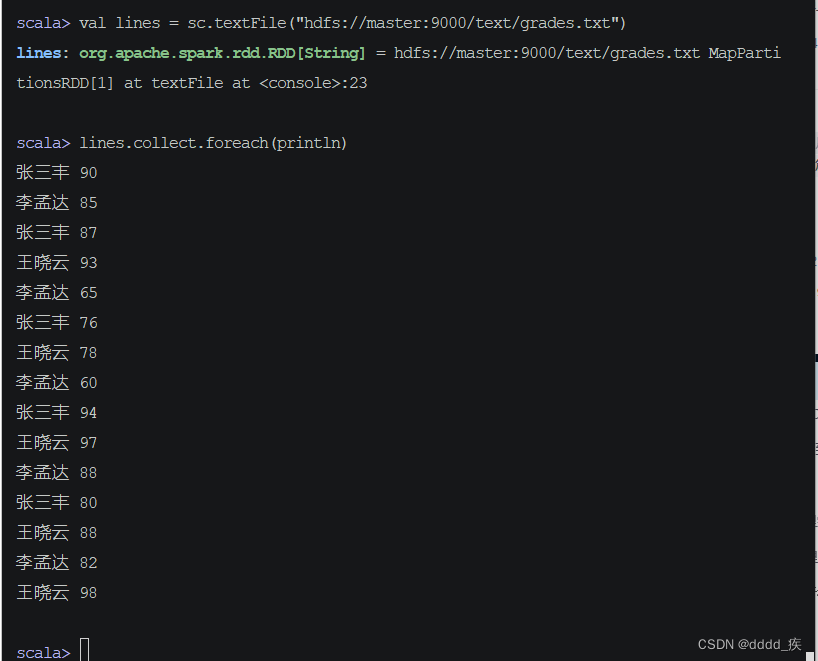

1.在spark shell上完成

(1)文件准备并上传到hdfs

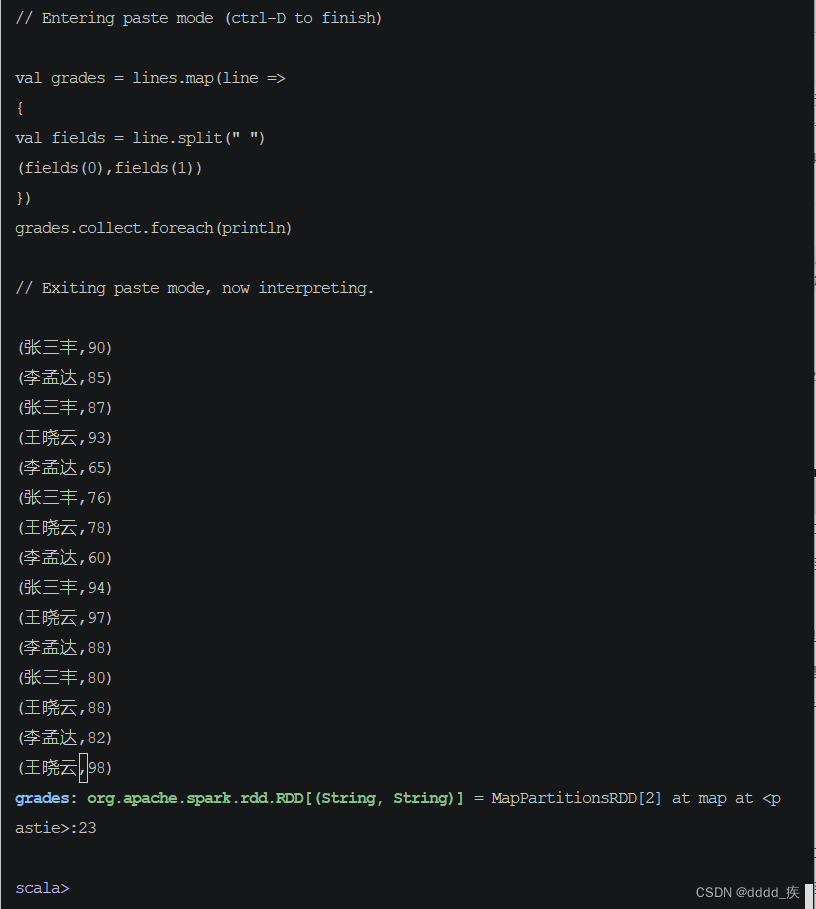

(2)读取文件生成RDD

(3)利用映射算子生成二元组构成的RDD

val grades = lines.map(line => {

val fields = line.split(" ")

(fields(0), fields(1))

})

grades.collect.foreach(println)

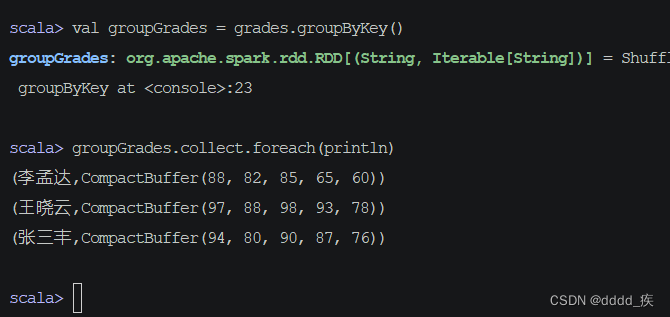

(4)按键分组得到新的二元组构成的RDD

–执行命令:val groupGrades = grades.groupByKey()

)

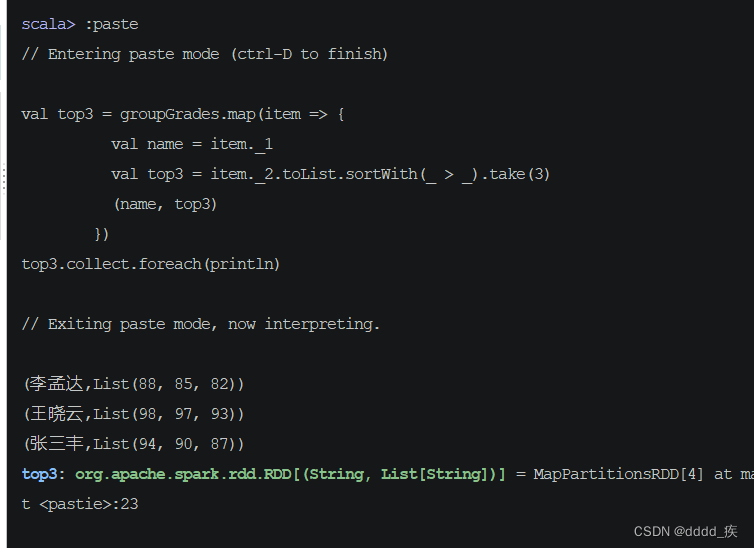

(5)按值排序,取前三

val top3 = groupGrades.map(item => {

val name = item._1

val top3 = item._2.toList.sortWith(_ > _).take(3)

(name, top3)

})

top3.collect.foreach(println)

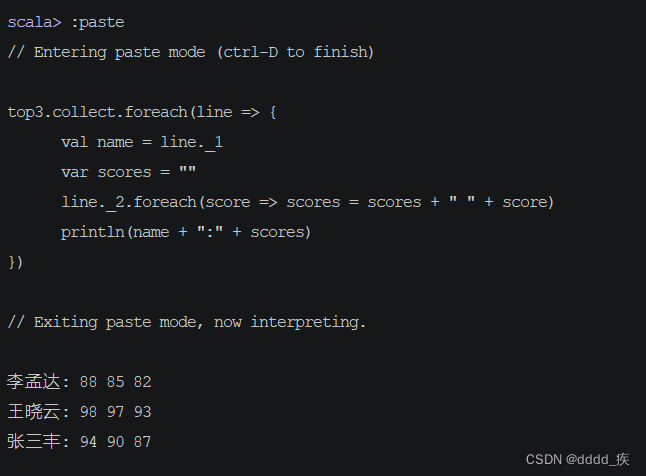

(6)按指定格式输出结果

top3.collect.foreach(line => {

val name = line._1

var scores = ""

line._2.foreach(score => scores = scores + " " + score)

println(name + ":" + scores)

})

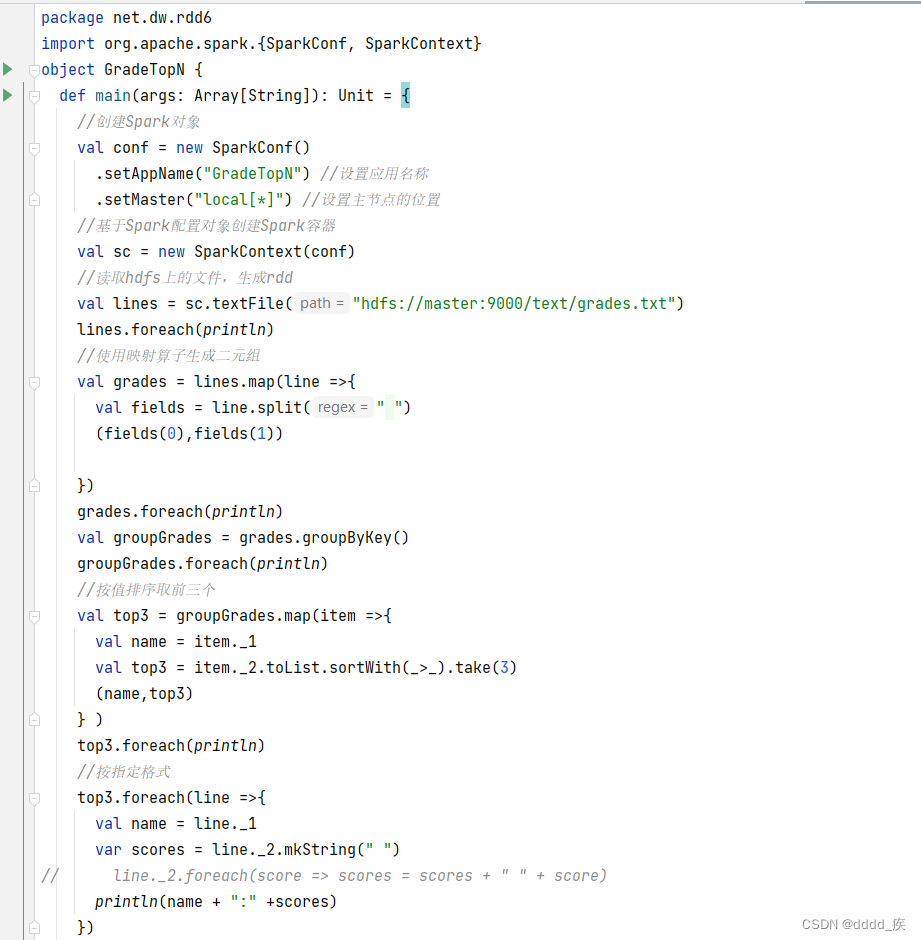

2.在ldea上完成

(1)新建GradeTopN对象

package net.dw.rdd6

import org.apache.spark.{SparkConf, SparkContext}

object GradeTopN {

def main(args: Array[String]): Unit = {

//创建Spark对象

val conf = new SparkConf()

.setAppName("GradeTopN") //设置应用名称

.setMaster("local[*]") //设置主节点的位置

//基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

//读取hdfs上的文件,生成rdd

val lines = sc.textFile("hdfs://master:9000/text/grades.txt")

lines.foreach(println)

//使用映射算子生成二元组

val grades = lines.map(line =>{

val fields = line.split(" ")

(fields(0),fields(1))

})

grades.foreach(println)

val groupGrades = grades.groupByKey()

groupGrades.foreach(println)

//按值排序取前三个

val top3 = groupGrades.map(item =>{

val name = item._1

val top3 = item._2.toList.sortWith(_>_).take(3)

(name,top3)

} )

top3.foreach(println)

//按指定格式

top3.foreach(line =>{

val name = line._1

var scores = line._2.mkString(" ")

// line._2.foreach(score => scores = scores + " " + score)

println(name + ":" +scores)

})

}

}

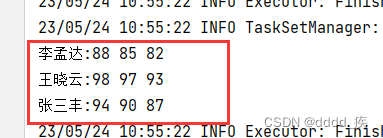

(2)运行得到结果

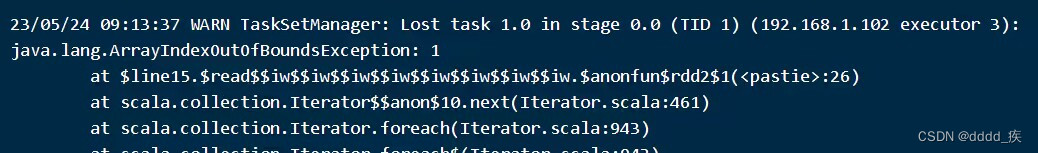

遇到的问题

在读取文件的发现任务丢失还有索引越界

解决

发现是在准备文件时多了一个换行

删除这个换行就解决了这个问题了

82

82

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?