(注:本文为小报童精选文章。已订阅小报童或加入知识星球「玉树芝兰」用户请勿重复付费)

「懂原理」固然重要,「会偷懒」也必不可少嘛。

需求

提示词的重要性,我就不再赘述了。有人甚至激进地认为,随着大语言模型能力提升,以后各种技能的传授都没有必要,直接教「咒语」(提示词)就好了。

我并不赞同这么激进的做法。但是现阶段,写好提示词很重要,在 AI 圈还是有共识的。

这篇文章,咱们就来讲讲,怎么提升提示词的质量,更好与 AI 沟通。具体而言,咱们会分成以下这四个部分来讲解:

大语言模型祛魅

提示词写作注意事项

偷懒的写法

隐含的重点

下面咱们一一来聊。

祛魅

我发现很多人在与 AI 互动时遇到困难,往往是因为没有理解「大语言模型究竟是什么」这个基础问题。

在使用 AI 时,你可能会不自觉地陷入一个误区 —— 对面是个智能生物。

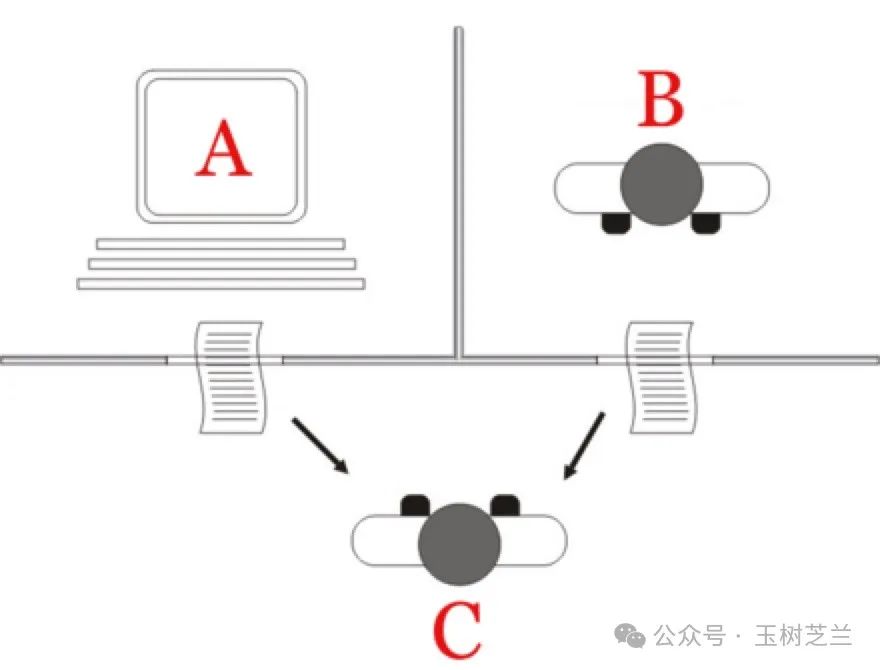

这是受到「图灵测试」的影响。回想一下图灵测试的场景:一个房间里放着一台电脑和一个真人。测试者通过文字与他们交流,需要判断对方是人还是机器。1950 年代的技术还不支持语音交互,所以他们只能用笔进行书面交流。如果人类用户判定正确,那么机器就不具备智能;反之,就算通过了图灵测试。

今天的 AI ,通过图灵测试了吗?这个问题众说纷纭。AI 的回答有时会带着一种「机器味」,所以你可能不难分辨出答案究竟来自 AI ,还是真人。但当你在特定情景下,问它一些客观问题时,你可能真的分不清对面是人还是机器。

上一次期末考试时,我做了一个有趣的实验。我用手机拍下试卷,让 Claude 3.5 Sonnet 来解答。出题老师就在旁边评判答案。结果 AI 一下子就完成了需要学生花一个小时才能做完的试卷,经过出题老师判定,全部正确。

于是很多人在使用 AI 大模型时,不把它当作一个语言模型,而是把它想象成了一个无所不知的智能生物。于是有人会用非常随意的方式跟 AI 对话。想象一下,你对助教说「去把那个拿过来,课前给我」,人类助教通过眼神和动作就能理解你的意思。但对 AI 来说,这样模糊的表达方式是完全不够的 —— 它需要知道具体要拿什么,要送到哪里,以及关于课程几点开始等各种细节信息。

大模型究竟是什么?

它的原理其实很简单,就像是在玩一个高级版的「文字接龙」游戏。它通过预测下一个词,或填补句子中缺失的部分来学习和训练。这种学习方式,我们称之为「自监督学习」。

根据你训练资料的不同,大语言模型学到的东西也有差异。例如你想象我把母校南开中学的校庆介绍材料,都扔给一个大语言模型。

那么你输入「天津南开中」,它能很快接上「学」这个字。当你说出「允公允能」的前半句,它也能准确补全这句南开校训。

训练过程其实很直接——答对了就给糖吃,答错了要受罚。通过这样反复的训练,AI模型逐渐向着训练资料靠拢。说白了,AI模型就是在拟合一个极其复杂的函数,用来匹配海量的训练资料。经过海量语料的训练,它学会了一件事情:接下茬。

虽然它说出的话在语法上没问题,但经常让人摸不着头脑。光说可能不够直观,来看个实际例子。在 GPT-2 中,你可以输入一句英文,比如「A new RNN model was presented in this research」,然后按 tab 键让它续写。

你会发现 GPT-2 确实能不断往下写,看起来像模像样。但仔细品味就会发现这些都是些没什么实际意义的套话。它只是从大量论文和文本中学来的固定表达,在不理解实际含义的情况下重复使用这些句式。

2022 年底,ChatGPT 横空出世。「人工智障」的回答似乎一下子不见了。为什么?因为 ChatGPT 不只是简单地按照资料做出回应,去「接下茬」,而是努力去理解并配合人类的偏好。

当 AI 面临多个可能的回答选择时,它会如何决定?它会根据之前附加训练阶段人类的反馈,选择那个最合理的答案。你这种学习方式带来了什么?它产生了一种叫做「涌现」的现象 ——AI 学会了一些我们原本并没有刻意教给它的技能。

最初,我们只是想让它学会如何更好地接话,让对话更自然,让人感到愉快。但现在的大语言模型展现出的能力远不止于此。它理解物理定律,知道引力的存在,掌握数学公式。更有趣的是,如果你给它一个悬疑小说,遮住结局,它往往能推理出谁是凶手,并说明原因。这些能力是如何获得的?

这要归功于它与人类偏好的不断对齐。通过阅读大量悬疑小说,它学会了寻找线索,掌握了推理规律。这就像你看了很多《名侦探柯南》后,也能培养出类似的推理能力。这就是反复训练加上人类偏好对齐带来的结果。

只不过,大模型就像一个装满饺子的茶壶,尽管它具有训练带来的海量知识和技能,但要「倒出」你真正想要的内容,关键在于你如何提问。

好的提示词能帮你充分利用模型在训练过程中获得的能力,包括那些让人惊叹的涌现能力。但如果你不知道该如何写好提示词,这些潜力就无法释放。

了解了大模型训练的机理,问题就转化成为 —— 面对这样一个基于文字接龙,又经过偏好对齐的模型,该如何写好提示词与之交互?

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?