引用1:

Feature学习,是各类深度学习模型的一个基础、重要的功能。好的feature,将有助于视觉任务性能的提升。本文主要介绍一种有助于提升feature质量的“对比学习“方法,该方式有别于之前的“自监督对比学习”,是一种“有监督对比学习”。文章地址:

Supervised Contrastive Learningarxiv.org/pdf/2004.11362.pdf

“有监督对比学习“,可以看作是”自监督对比学习“的一种改进。因此,对本文将首先对“自监督对比学习”进行介绍,然后再对“有监督对比学习“进行详细介绍。

1. 自监督对比学习(Self Supervised Contrastive Learning)

假设你有如下资源:

- 一个BackBone Network,用来提取图片feature,例如:ResNet-50, ResNet-101或者ResNet-200。

- 一个训练数据集,例如ImageNet

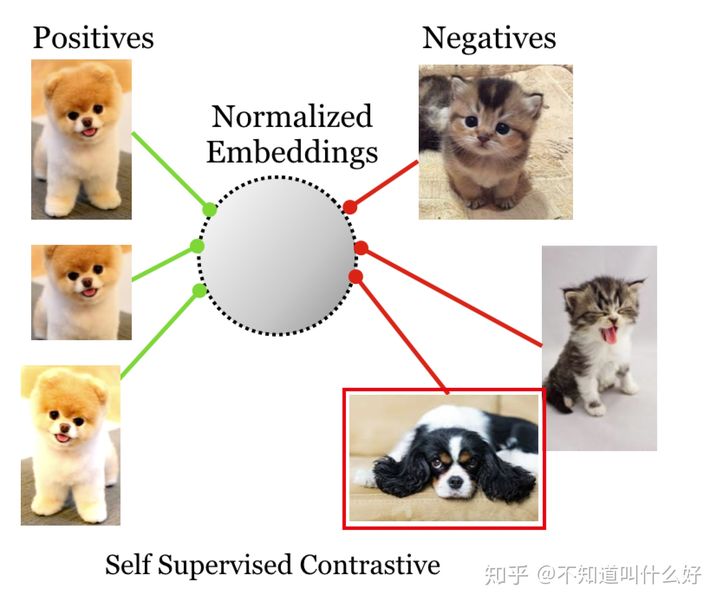

对于一张图片(左上角),来源相同的图片(左侧下方两张augmentation后的图片)的feature,在超球面上的距离很接近,来源不同的图片之间的feature的距离会比较远。但有一张与左上角图片属于同一类的图片(上图里面的红框图片),他的feature与左上角图片的feature的距离也会很远。

直觉上,同类图片的feature,应该也是越接近越好。但由于“自监督对比学习”的设定里面不使用图片所属的类别信息,所以无法知道哪些图片属于同一类,因此也无法让同类图片的feature彼此距离接近。

如果能使用图片的类别 label信息,是否能提高以上“自监督对比学习“的feature的质量?

2. 监督对比学习(Supervised Contrastive Learning)

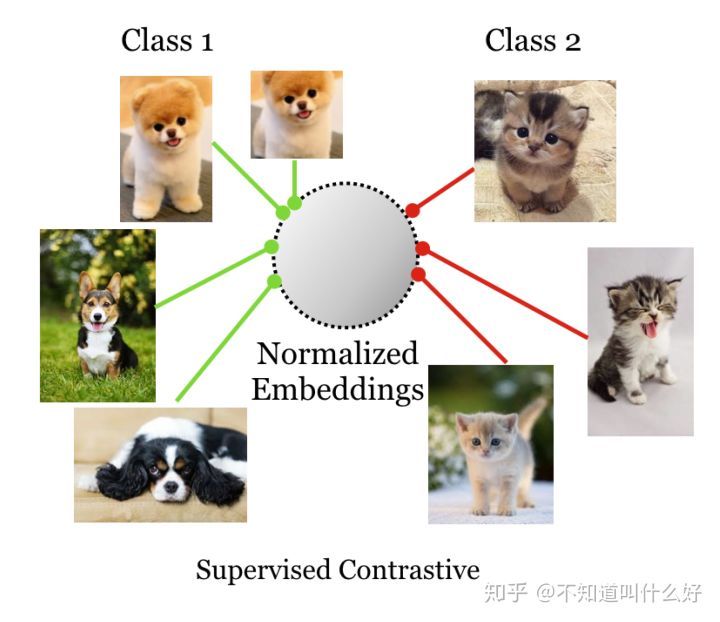

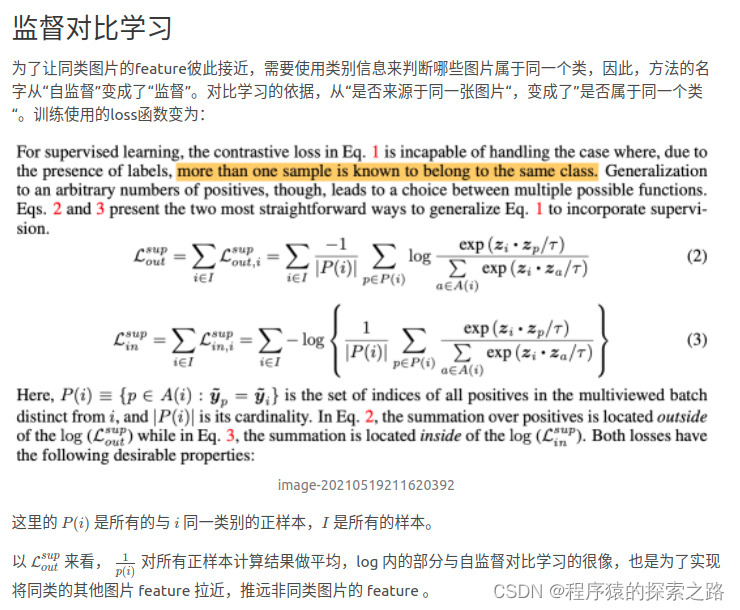

为了让同类图片的feature彼此接近,需要使用类别信息来判断哪些图片属于同一个类,因此,方法的名字从“自监督”变成了“监督”。对比学习的依据,从“是否来源于同一张图片“,变成了”是否属于同一个类“。训练使用的loss函数变为:

从上图可以看出,同类别的图片的feature,在超球面上的距离,很近;不同类的图片的feature,距离很远。

3. 总结

- “监督对比学习“,相比”自监督对比学习“,将对比策略,从“同源” vs “非同源”,扩展为“同类” vs "非同类“。

- 训练自己的模型时,也可以试试这个supervised contrastive loss。

引用2:

总结

Supervised Contrastive Learning 论文实验非常充分,公式的推导也很扎实。 具体可以看这里 Supervised Contrastive Learning ,是一篇很优秀严谨的论文。给人耳目一新的感觉,但论文中提到的诸多数据增强的方法,我的了解都很有限,后续会再看一些相关的论文。

交叉熵(Cross-Entropy) 交叉熵(Cross-Entropy)_rtygbwwwerr的博客-CSDN博客_cross entropy

Softmax函数与交叉熵 - 杀手XIII的文章 - 知乎 Softmax函数与交叉熵 - 知乎

Self-Supervised Representation Learning Self Supervised Learning

本文探讨了自监督对比学习和监督对比学习在特征学习中的应用。自监督学习通过比较同一图片的不同增强版本来学习特征,而监督对比学习引入类别信息,使同类图片的特征更接近,从而提升特征质量。监督对比学习通过调整损失函数,优化了对比策略,从‘同源’与‘非同源’对比转向‘同类’与‘非同类’对比。这种方法在提升模型性能方面展现出潜力。

本文探讨了自监督对比学习和监督对比学习在特征学习中的应用。自监督学习通过比较同一图片的不同增强版本来学习特征,而监督对比学习引入类别信息,使同类图片的特征更接近,从而提升特征质量。监督对比学习通过调整损失函数,优化了对比策略,从‘同源’与‘非同源’对比转向‘同类’与‘非同类’对比。这种方法在提升模型性能方面展现出潜力。

690

690

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?