更新!2000-2023中国上市公司年报文本(爬虫代码+txt年报文本)

处理软件:Python 3.11

年度区间:2000-2023

年报数量:59160(其中包含2023年年报txt文件5185个)

说明:本数据为2000-2023中国上市公司年报文本,已经从pdf转为txt格式,方便以本数据为起点进行文本分析及相关指标的构建。本数据特点如下:

(1)爬虫代码:提供详细的Python爬虫代码,方便大家学习掌握爬虫技术;

(2)文件格式:下载的pdf文件已经转化为txt格式,方便后续文本分析处理;

(3)文件过滤:pdf批量下载过程中存在年报更新的情况,已经对年报进行了筛选,剔除了非年报文件并保留了最新更新或更正的年报;

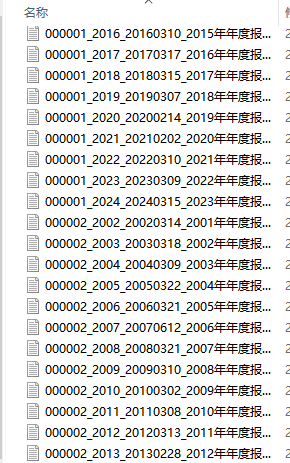

(4)文件名称:原始地址的文件名称并不统一,已经将年报文件名称进行了统一,统一格式为“股票代码_年度_发布日期_****年年度报告.txt”,例如,“000002_2023_20230331_2022年年度报告.txt”;

文件展示:

代码展示:

【下载→

方式一(推荐):主页个人 简介

经管数据库-CSDN博客

方式二:数据下载地址汇总-CSDN博客

2489

2489

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?