文章目录

前言

提示:这里可以添加本文要记录的大概内容:

例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。

提示:以下是本篇文章正文内容,下面案例可供参考

一、知识图表示学习

1.表示空间

2.评分函数

3.编码模型

4.辅助信息

示例:pandas 是基于NumPy 的一种工具,该工具是为了解决数据分析任务而创建的。

二、知识的获取和完成

知识图谱的完成

由于知识图的不完全性,KGC被发展来给知识图增加新的三元组。典型的子任务包括链接预测、实体预测和关系预测。对KGC的初步研究集中在学习三重预测的低维嵌入。在本调查中,我们将这些方法称为基于嵌入的方法。然而,他们中的大多数人没能捕捉到多步关系。因此,最近的工作转向探索多步关系路径并结合逻辑规则,分别称为关系路径推理和基于规则的推理。三重分类作为KGC的一项相关任务,评估事实三重分类的正确性,在本节中进行了额外的回顾。

1.嵌入方法

2.路径推理

实体和关系的嵌入学习在一些基准测试中取得了显著的成绩,但无法对复杂的关系路径进行建模。关系路径推理转而利用图结构上的路径信息。随机漫步推理得到了广泛的研究;例如,路径排序算法(PRA)[86]结合路径约束选择关系路径,进行最大似然分类。为了改进路径搜索,Gardner等人[57]通过结合文本内容在随机漫步中引入向量空间相似性启发式算法,这也缓解了PRA中的特征稀疏性问题。研究了神经多跳关系路径建模。Neelakantan等人的[58]开发了一个RNN模型,通过递归地应用组合性来组合关系路径的含义[如图6(b)]。推理链[87]是一种神经注意机制,用于支持多个原因,表示所有关系、实体和文本的逻辑组成。最近,DIVA[88]提出了一个统一的变分推理框架,将多跳推理作为寻路(底层路径推理的先验分布)和路径推理(链接分类的可能性)的两个子步骤。

| 索引 | 引文 |

|---|---|

| 86 | N. Lao and W. W. Cohen, “Relational retrieval using a combination of path-constrained random walks,” Mach. Learn., vol. 81, no. 1,pp. 53–67, Oct. 2010. |

| 57 | M. Gardner, P. Talukdar, J. Krishnamurthy, and T. Mitchell, “Incorporating vector space similarity in random walk inference over knowledge bases,” in Proc. Conf. Empirical Methods Natural Lang. Process.(EMNLP), 2014, pp. 397–406. |

| 58 | A. Neelakantan, B. Roth, and A. McCallum, “Compositional vector space models for knowledge base completion,” in Proc. 53rd Annu.Meeting Assoc. Comput. Linguistics 7th Int. Joint Conf. Natural Lang.Process., vol. 1, 2015, pp. 156–166 |

| 87 | R. Das, A. Neelakantan, D. Belanger, and A. McCallum, “Chains of reasoning over entities, relations, and text using recurrent neural networks,” in Proc. 15th Conf. Eur. Chapter Assoc. Comput. Linguistics,vol. 1, 2017, pp. 132–141. |

| 88 | W. Chen, W. Xiong, X. Yan, and W. Y. Wang, “Variational knowledge graph reasoning,” in Proc. Conf. North Amer. Chapter Assoc. Comput. Linguistics: Human Lang. Technol., vol. 1, 2018, pp. 1823–1832. |

3.基于强化学习的路径发现

通过将实体对之间的寻径过程表述为顺序决策,具体地说就是马尔可夫决策过程(MDP),将深度RL引入到多跳推理中。基于策略的RL agent通过知识图环境的交互来学习寻找扩展推理路径的步骤,其中策略梯度用于训练RL agent。

DeepPath[89]首先将RL应用到关系路径学习中,并开发了一种新的奖励函数,以提高路径的准确性、多样性和效率。它通过平移嵌入的方法对连续空间中的状态进行编码,并将关系空间作为其动作空间。类似地,MINERVA[90]将路径步行到正确答案实体作为一个通过最大化期望回报的顺序优化问题。它排除了目标答案实体,并提供了更有能力的推断。Multi-Hop[91]提出了一种软奖励机制,而不是二元奖励机制。在训练过程中,还采用了动作dropout来掩盖一些出射边,使路径探索更加有效。M-Walk[92]采用RNN控制器捕获历史轨迹,采用蒙特卡罗树搜索(MCTS)进行有效路径生成。CPL[93]利用文本语料库和当前实体的句子袋(以bet表示),提出了文本寻路和事实提取的协同策略学习方法。

将源、查询和当前实体表示为es、eq和et,查询关系表示为rq,这些方法的MDP环境和政策网络总结在表II中,其中MINERVA、M-Walk和CPL使用二进制奖励。对于政策网络,DeepPath使用全连接网络,CPL的提取器使用CNN,其余使用循环网络

| 索引 | 引文 |

|---|---|

| 91 | X. V. Lin, R. Socher, and C. Xiong, “Multi-hop knowledge graph reasoning with reward shaping,” in Proc. Conf. Empirical Methods Natural Lang. Process., 2018, pp. 3243–3253. |

4.基于规则的推理

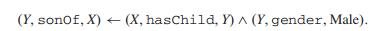

为了更好地利用知识的符号性,KGC的另一个研究方向是逻辑规则学习。规则是以头体的形式由头体来定义的。头部是一个原子,即一个具有可变主体和/或对象的事实,而身体可以是一组原子。例如,给定sonOf、hasChild、gender和实体X和Y的关系,有一个逻辑编程的反向形式为

逻辑规则可以通过规则挖掘工具提取,如AMIE[94]。最近的RLvLR[95]提出了一种具有高效规则搜索和修剪的可伸缩规则挖掘方法,并利用提取的规则进行链路预测。

更多的研究关注于将逻辑规则注入嵌入式以改进推理,通过联合学习或迭代训练来整合一阶逻辑规则。例如,KALE[96]提出了一种统一的联合模型,为兼容三元组定义了t-范数模糊逻辑连接,并嵌入了逻辑规则。具体地说,定义逻辑合取、析取和否定三种组合来组合复公式的真值。图7(a)给出了一个简单的一阶Horn子句推理。RUGE[97]提出了一种迭代模型,利用软规则对未标记三元组进行软标签预测,对有标记三元组进行嵌入校正。

三、时态知识图

1.引入库

四、知识感知应用

总结

提示:这里对文章进行总结:

例如:以上就是今天要讲的内容,本文仅仅简单介绍了pandas的使用,而pandas提供了大量能使我们快速便捷地处理数据的函数和方法。

508

508

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?