- Entity Recoginition

- Entity Typing

- Entity Disambiguation

- Entity Alignment

- Relation Extraction

- Neural Relation Extraction

- Attention Mechanism

- Graph Convolutional Network

- Adversarial Training

- Reinforcement Learning

- Other Advance

- Joint Entity and Relation Extraction

- Summary

- Temporal Knowledge Graph

- Temporal Information Embedding

- Entity Dynamics

- Temporal Relational Dependence

- Temporal Logical Reasoning

- Knowledge-Aware Application

- Language Represention Learning

- Question Answering

- Single-Fact QA

- Multihop Reasoning

- Recommender Systems

- Future Directions

- Complex Reasoning

- Unified Framework

- Interpretability

- Knowledge Aggregation

- Automatic Construction and Dynamics

- Conclusion

结论

结论再次提到,本篇的主要在于:

- 是在四个方面的综合的survey

- 提出了开源数据集,讨论了未来方向

原文如下:

(1)This article conducts a comprehensive survey on the following four scopes. (2)some useful resources of datasets and open-source libraries, and future research directions are introduced and discussed.

图表及其内容

这一部分主要是论文中出现的图表,我们稍微仔细看一下。

这个没什么,就是知识图谱示例。

这是分类的图像化表达,和文中的结构一致。

知识可以在不同空间内表达:

- a图是点的空间

- b图是复数向量空间

- c图是高斯空间

- d图是流形空间

a图是TranE的向量加法表达。

b图是DisMult的乘法表达。

这张图中是通过神经网络编码的模型:

a图是CNN,CNN输入三元组并且通过卷积操作获取语义信息

b图是GCN,通过GCN作为encoder得到embedding

c图是RSN,将实体—关系联合encode,并且有区别的跳过relation

d图是Transformer-based CoKE,通过MASK对三元组进行编码

a图是知识补全的模型,基于embedding进行的打分

b图是关系路径推理,通过已有的关系推出。

这里是逻辑规则的学习,图a是KALE模型,图b是pLogic-Net

这是实体识别任务的典型模型

a图是LSTM-CRF模型,通过LSTM捕获状态的语义信息,通过CRF层对信息进行约束,标定相应的实体。现在常用

b图是EA with IPTransE模型,是在TransE基础上拓展的模型。

这是有关NRE的总览,这里的NRE指的是Neural Relation Extraction,即神经网络提取关系的方法,要和我们现在的NER任务分开,NER指的是 Named Entity Recognition。

这里的表是对知识表示学习KRL的一些描述,第一列是模型,第二列是实体或关系存在的空间,第三列是给出的打分函数。

这里的表是RL-Based的模型,都是强化学习的,因此有动作,状态和奖励,同样左边是模型,然后依次是表示的状态,动作,奖励和采用的网络模型。

第三个表是比较神经网络提取关系的模型,给出了各个模型从属的类别,机制以及对应的辅助信息。

到这里,我们的泛读也就结束了,泛读完成我们可以回答这三个问题了

- 论文要解决什么问题?

论文建立在知识图谱模型复杂多样的背景下,提出了一个综合性的survey。

2. 论文采用了什么方法?

论文提出了新的分类标准,对各个模型进行分类。

3. 论文达到什么效果?

由于是survey,所以没有实验部分。

精读论文

Introduction

第一段主要介绍了知识图谱已经吸引了学术界和工业界的注意力,并且对于知识图谱的各个部分的组成进行了介绍,包含实体,关系,语义描述等。原文是这么说的

Recently, knowl-edge graphs as a form of structured human knowledge have drawn great research attention from both academia and the industry.

第二段讲了知识图谱和知识库的关系,然后通过一个实例描述了知识图谱是由三元组构成的。

也就是上面这个图片中的内容

第三段介绍了最近的发展,同时引出作者的分类,KRL或者叫KGE是映射实体到低维的向量。介绍了知识获取任务包含KGC,三元组分类,实体识别,关系抽取。受益于多种信息的发展,然后讲了现实中的应用。

第四段开始总结,并说明创新点,主要包含以下四点:

- Comprehensive review,综合的视角

- Full-View Categorization and New Taxonomies: 全视角的分类,作者又说了一下怎么分类的。

- Wide Coverage on Emerging Advances: 对于热点事件的讨论

- Summary and Outlook on Future Directions: 总结和讨论未来方向

在最后作者说了一下本文的结构。

Overview

Brief History of Knowledge Bases

这里介绍知识图谱的历史。从1956年提出语义网概念开始,一直到RDF,OWL和语义网的出现,接下来许多开放的知识库相继发布,例如WordNet、DBpedia、YAGO和Freebase。再到2012年知识图谱的应用。

Definitions and Notations

作者这里说关于知识图谱还没有一个广泛认可的正式定义,列举了两篇的定义。

将知识图谱定义成

G

=

{

E

,

R

,

F

}

\mathcal{G} = {{\mathcal{E}, \mathcal{R}, \mathcal{F}}}

G={E,R,F}

其中

E

,

R

,

F

\mathcal{E}, \mathcal{R}, \mathcal{F}

E,R,F分别表示实体、关系和事实的集合。一个事实定义成三元组

(

h

,

r

,

t

)

∈

F

(h, r, t)\in \mathcal{F}

(h,r,t)∈F

Categorization of Research on Knowledge Graph

这里的分类就是这一张图

分为KRL,Knowledge Acquisition,Knowledge Aware Application和Temporal Knowledge Graph。

然后每个大问题又分为了几个小的课题。

Related Surveys

相关的综述,作者主要提到的主要相关的有两篇,并且指出,这些综述的描述视角太单一了。

Knowledge Representation Learning

知识表示学习(KRL)也可称为知识嵌入学习(KGE),多关系学习和统计关系学习(SRL),这一节主要讲了四个角度进行的表示学习方法。

注:本文涉及的模型较多,每个小节我都会以一个模型为例,解释论文中想表达的意思。通过一篇综述是无法理解这么多模型的,因此简单的重复列出也无意义,具体的其他模型可以看原文。

Representation space

首先是表示空间,作者在这里指出,表示学习的关键就是学习得到实体和关系的低维嵌入,在我理解也就是如何把知识在低维的空间内表示出来。

主要从四个空间进行描述,并通过相应的模型来说明。

- Pointwise Space:

点对点的空间,其实主要是欧式空间,嵌入的形式是将实体和关系映射到向量或矩阵空间,或者更高维,用来捕获关系的交互信息。如图a,可以用一维的vector,二维的matrix,三维的tensor以至于更高纬度。

以一个例子为例,剩下的也都是简述,要看懂,可能得看具体的论文。

TransE在d dd维的向量空间中表示实体和关系,例如

h

,

t

,

r

∈

R

d

\mathbf{h}, \mathbf{t}, \mathbf{r} \in \mathbb{R}^d

h,t,r∈Rd,使得嵌入服从如下的转换规则:

h

r

≈

t

\mathbf{h} + \mathbf{r} \approx \mathbf{t}

h+r≈t。

- Complex Vector Space

与实值空间不同,这里是将实体和关系投影到复向量空间,其中

h

,

t

,

r

∈

C

d

\mathbf{h}, \mathbf{t}, \mathbf{r} \in \mathbb{C}^d

h,t,r∈Cd。以

h

\mathbf{h}

h为例,它有实值部分

R

e

(

h

)

Re(\mathbf{h})

Re(h)也有虚值部分

I

m

(

h

)

Im(\mathbf{h})

Im(h),

h

=

R

e

(

h

)

i

I

m

(

h

)

\mathbf{h}=Re(\mathbf{h})+iIm(\mathbf{h})

h=Re(h)+iIm(h)。如图b所示。

ComplEx首先引入了图 3b所示的复杂向量空间,可以捕获到对称的和反对称的关系。使用hermitian点乘来结合头实体和关系,以及尾实体的共轭。

- Gaussian Distribution

高斯分布是通过一个分布关系来表达实体和关系的。如图c。

基于密度的嵌入模型KG2E引入了高斯分布来处理确定的/不确定的实体和关系。作者将实体和关系嵌入到了一个多维度的高斯分布

H

∼

N

(

μ

h

,

∑

h

)

\mathcal{H}\sim \mathcal{N}(\mu_h, \sum_h)

H∼N(μh,∑h)和

T

∼

N

(

μ

h

,

∑

h

)

\mathcal{T}\sim \mathcal{N}(\mu_h, \sum_h)

T∼N(μh,∑h)中。均值向量

μ

\mu

μ表示了实体和关系的位置,协方差矩阵

∑

\sum

∑建模了它们的确定性/不确定性。根据转换(translational)的规则,实体转换的概率分布

H

−

T

\mathcal{H}-\mathcal{T}

H−T定义为

P

e

∼

N

(

μ

h

−

μ

t

,

∑

h

∑

t

)

\mathcal{P}_e \sim \mathcal{N}(\mu_h-\mu_t, \sum_h+\sum_t)

Pe∼N(μh−μt,∑h+∑t)。

- Manifold and Group

这里是知识在流形空间和群的表示,manifold(流行)是一个拓扑空间,可以定义成具有领域的点的集合。group(群)是抽象代数中定义的内容。作者提到,pointwise中的嵌入,打分函数远超过实体和关系的数量。

MainfoldE将point-wise嵌入扩展成mainfold-based嵌入。作者引入了两种mainfold-based嵌入的设置,Sphere(球体)和Hyperplane(超平面)。例如图 3d所示,对于球体的设置,再生希尔伯特核空间(Reproducing Kernel Hilbert Space)用于表示mainfold函数。另一个超平面的设置的引入通过交叉嵌入(intersected embeddings)增强了模型。

Scoring Function

打分函数被用于衡量事实的合理性,也在基于能量的学习框架中被称作能量函数。基于能量的学习旨在学习到能量函数

E

θ

(

x

)

\mathcal{E}_{\theta}(x)

Eθ(x)使得正样本得分高于负样本。事实上,关系的表示通常反映在打分函数里。

文中将打分函数分为两类,基于距离的和基于相似性的用来衡量事实的合理性,分别如图a和图b所示:

基于距离的打分函数通过计算实体之间的距离来衡量合理性,如经典模型TransE通过计算头实体和关系是否与尾实体在向量空间相近来打分。

基于语义相似度的打分通过语义匹配来衡量合理性,如经典模型Distmult的

h

T

M

r

≈

t

T

\mathbf{h}^T\mathbf{M}_r \approx \mathbf{t}^T

hTMr≈tT,在表示空间将头实体转化到尾实体的相近的地方。

作者下面主要列出了这两种方法,并举了很多模型的例子,我这里还是挑一个模型来说,理解其意思即可。

- Distance-Based Scoring Funtion

意思是基于距离的打分函数,一个直觉的方法是计算实体的关系投影之间的欧式距离,如SE模型使用两个投影矩阵和

L

1

L_1

L1距离来学习结构的嵌入,公式如下所示:

f

r

(

h

,

t

)

=

∥

M

r

,

1

h

−

M

r

,

2

t

∥

L

1

.

f_r(h,t)= \Vert M_{r,1}h-M_{r,2}t \Vert_{L_1}.

fr(h,t)=∥Mr,1h−Mr,2t∥L1.

从我目前的理解来看,这公式的意思就是将头实体h在关系上的投影和尾实体t在关系上的投影的距离差,通过这个差来衡量学习到的事实是否合理。

这里更广泛使用的是转换的打分函数,它将关系看成是从头实体到尾实体的“翻译”来学习嵌入。如TransE方法就是假定

h

r

\mathbf{h} + \mathbf{r}

h+r的嵌入应该和

t

\mathbf{t}

t的嵌入接近,然后在L1或L2的约束下定义了打分函数,如下公式所示:

f

r

(

h

,

t

)

=

∥

h

r

−

t

∥

L

1

/

L

2

f_r(h,t)=\Vert \mathbf{h+r-t} \Vert_{L_1/L_2}

fr(h,t)=∥h+r−t∥L1/L2

- Semantic Matching

这里是另一种方法来衡量合理性,即计算语义相似性,一般是通过乘法来实现。

DistMult考虑最基本的双线性打分函数:

g

r

b

(

y

e

1

,

y

e

2

)

=

y

e

1

T

M

r

y

e

2

gb_r(y_{e_1},y_{e_2})=yT_{e_1}M_ry_{e_2}

grb(ye1,ye2)=ye1TMrye2

将这个双线性打分函数限制到对角线,减少参数量,如下所示:

f

r

(

h

,

t

)

=

h

⊤

d

i

a

g

(

M

r

)

t

f_r(h,t)=\mathbf{h}^\top diag(\mathbf{M}_r)\mathbf{t}

fr(h,t)=h⊤diag(Mr)t

Encoding Models

这里是介绍用特定的模型结构,对实体间的交互信息以及关系进行编码的模型,包括以下三种

- 线性/双线性模型(linear/bilinear models),通过将表示空间的头实体投影到尾实体相近的位置,将关系化为了线性/双线性的映射。

- 分解模型(factorization models),旨在将关系数据分解为低秩的矩阵,以用于表示学习。

- 神经网络(neural networks),使用非线性激活函数编码关系数据并通过网络结构匹配实体和关系的语义相似性。

一些神经网络模型如下图所示:

- Linear/Bilinear Models

线性/非线性模型使用线性操作对实体交互和关系进行编码,下式是线性的转换操作:

g

r

(

h

,

t

)

=

M

r

T

(

h

t

)

g_r(\mathbf{h,t})=\mathbf{M_r^T}\binom{\mathbf{h}}{\mathbf{t}}

gr(h,t)=MrT(th)

双线性的转换上面其实已经给出了,这里再给一遍:

g

r

b

(

y

e

1

,

y

e

2

)

=

y

e

1

T

M

r

y

e

2

gb_r(y_{e_1},y_{e_2})=yT_{e_1}M_ry_{e_2}

grb(ye1,ye2)=ye1TMrye2

使用线性/双线性的方法括SE, SME, DistMult, ComplEx, ANALOGY。

使用L2正则化的TransE,打分函数可以扩展成对一维向量的线性转换:

∥

h

r

−

t

∥

2

2

=

2

r

T

(

h

−

t

)

−

2

h

T

t

∥

r

∥

2

2

∥

h

∥

2

2

∥

t

∥

2

2

\Vert \mathbf{h+r-t} \Vert_2^2 = 2\mathbf{r}T\mathbf{(h-t)}-2\mathbf{h}T\mathbf{t}+\Vert \mathbf{r} \Vert_2^2 +\Vert \mathbf{h} \Vert_2^2 +\Vert \mathbf{t} \Vert_2^2

∥h+r−t∥22=2rT(h−t)−2hTt+∥r∥22+∥h∥22+∥t∥22

- Factorization Models

分解模型将KRL问题建模成了三个张量的分解。

张量分解的规则可以定义成:

X

h

r

t

≈

h

T

M

r

t

\mathcal{X}_{hrt} \approx \mathbf{h}^T \mathbf{M}_r \mathbf{t}

Xhrt≈hTMrt,分解函数遵循语义匹配的模式。双线性模型的开山之作是RESCAL,是发表ICML 2011上的工作。主要思想是三维张量分解。在知识图谱张量的关系片(slice)上进行分解,关系片是一个矩阵,每个矩阵类似图的邻接矩阵。对tenor分解为以下的公式:

χ

k

=

A

R

k

A

T

\chi_k = \mathbf{AR_kA}^T

χk=ARkAT

A

A

A是 n×r 的矩阵,表示每个实体的隐性表示(latent-component representation),

R

k

R_k

Rk是 r×r 的非对称矩阵,建模第 k 个属性/关系中的实体 latent component 的交互。

- Neural Networks

神经网络在语义匹配上效果出色,使用线性和双线性的模型也可以使用神经网络。而用于表示学习的神经模型包括多层感知机(MLP)、神经张量网络(NTN)和神经关联模型(NAM)。一般来说,这些方法将实体和关系输入到深层神经网络中,并计算语义匹配分数。MLP使用全连接层编码实体和关系,并使用带有非线性激活函数的第二层对三元组进行打分:

f

r

(

h

,

t

)

=

σ

(

w

⊤

σ

(

W

[

h

,

r

,

t

]

)

)

f_r(h,t)=\sigma(\mathbf{w}^\top\sigma(\mathbf{W[h,r,t]}))

fr(h,t)=σ(w⊤σ(W[h,r,t]))

其中

W

∈

R

n

×

3

d

\mathbf{W}\in \mathbb{R}^{n\times 3d}

W∈Rn×3d是权重矩阵,

[

h

,

r

,

t

]

\mathbf{[h,r,t]}

[h,r,t]是三个向量的拼接。

- Convolutional Neural Networks

CNN被用来学习深层的表示特征,如ConvE

嵌入上使用2D的卷积,并使用多层的非线性特征,通过将头实体和关系映射成2D的矩阵,来建模实体间和关系间的交互。例如

M

h

∈

R

d

w

×

d

h

\mathbf{M}_h \in \mathbb{R}^{d_w\times d_h}

Mh∈Rdw×dh和

M

r

∈

R

d

w

×

d

h

\mathbf{M}_r \in \mathbb{R}^{d_w\times d_h}

Mr∈Rdw×dh。打分函数定义为:

f

r

(

h

,

t

)

=

σ

(

v

e

c

(

σ

(

[

M

h

;

M

r

]

∗

ω

)

)

W

)

t

f_r(h,t)=\sigma(vec(\sigma(\mathbf{[M_h;M_r]*\omega}))\mathbf{W})\mathbf{t}

fr(h,t)=σ(vec(σ([Mh;Mr]∗ω))W)t

其中

ω

\mathbf{\omega}

ω是卷积核,

v

e

c

vec

vec是将tensor reshape成向量的向量化操作。

通过堆叠多层并进行非线性的特征学习,ConvE可以学习到语义级别的信息。

- Recurrent Neural Networks

为了捕获到KG中更长的关系依赖,可以使用基于RNN的方法。

如本节最开始的d图所示的RSN,设计了循环skip机制,通过区分实体和关系,来增强语义表示学习。

包含实体和关系的关系路径例如

(

x

1

,

x

2

,

.

.

.

,

x

T

)

(x_1, x_2, …, x_T)

(x1,x2,…,xT),是随机游走产生的,并且元素的位置和互换。然后使用其来计算循环隐层状态

h

t

=

t

a

n

h

(

W

h

h

t

−

1

W

x

x

t

b

)

\mathbf{h}_t = tanh(\mathbf{W}h \mathbf{h}{t-1} + \mathbf{W}_x \mathbf{x}_t + b)

ht=tanh(Whht−1+Wxxt+b)。skip操作如下,其中

S

1

\mathbf{S}_1

S1,

S

2

\mathbf{S}_2

S2是权重矩阵。

h

t

′

=

{

h

t

x

t

∈

ε

S

1

h

t

S

2

x

t

−

1

x

t

∈

R

\mathbf{h_t}'=\left{ \begin{array}{lr}\mathbf{h_t}&x_t\in \mathcal{\varepsilon}\ \mathbf{S_1h_t+S_2x_{t-1}}&x_t\in\mathcal{R} \end{array} \right.

ht′={htS1ht+S2xt−1xt∈εxt∈R

- Transformers

基于transformer的模型促进了利用上下文本文的表示学习。

为了利用KG中的上下文信息,CoKE使用transformers来建模边和路径的序列。类似地,KG-BERT借鉴了语言模型的预训练思想并使用Transformer中的双向编码表示作为编码实体和关系的encoder。

- Graph Neural Networks

图神经网络(GNN)是使用encoder-decoder框架学习结构的连通性。

R-GCN提出了针对关系的转换来建模有向的KG,模型的前向传播定义成:

x

i

(

l

1

)

=

σ

(

∑

r

∈

R

∑

j

∈

N

i

r

1

c

i

,

r

W

r

(

l

)

x

j

(

l

)

W

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

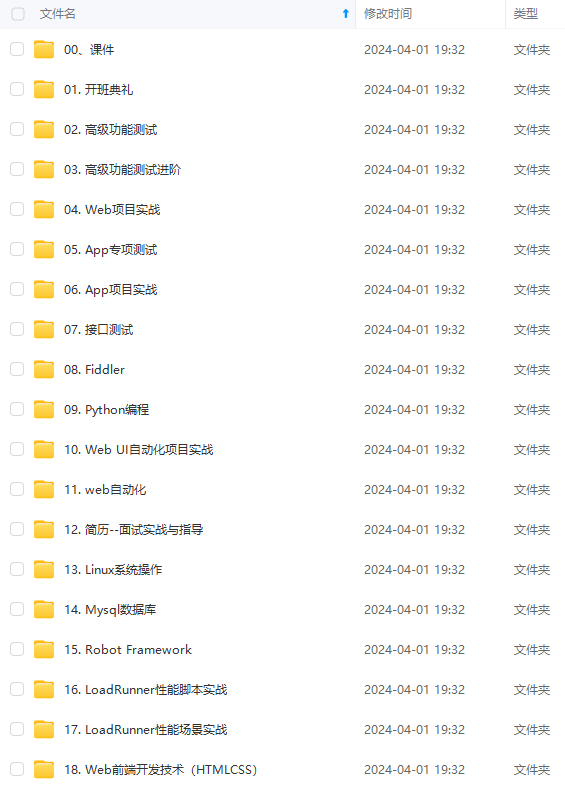

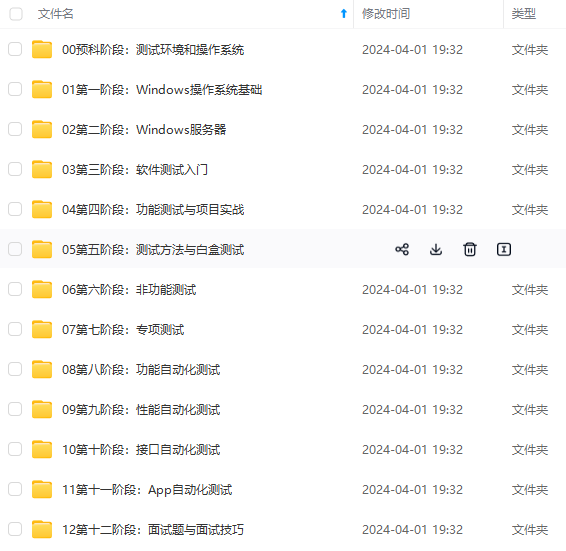

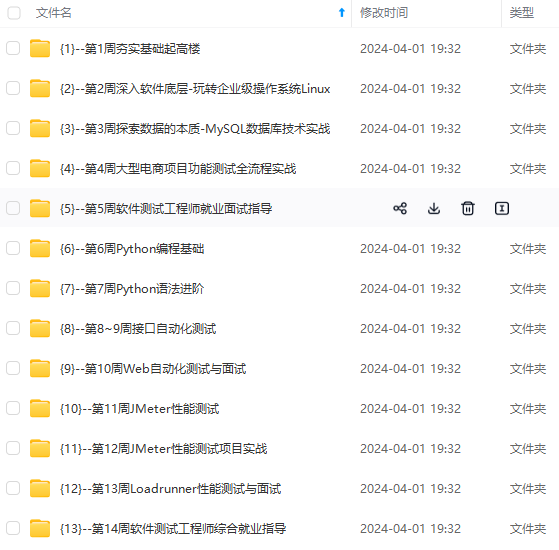

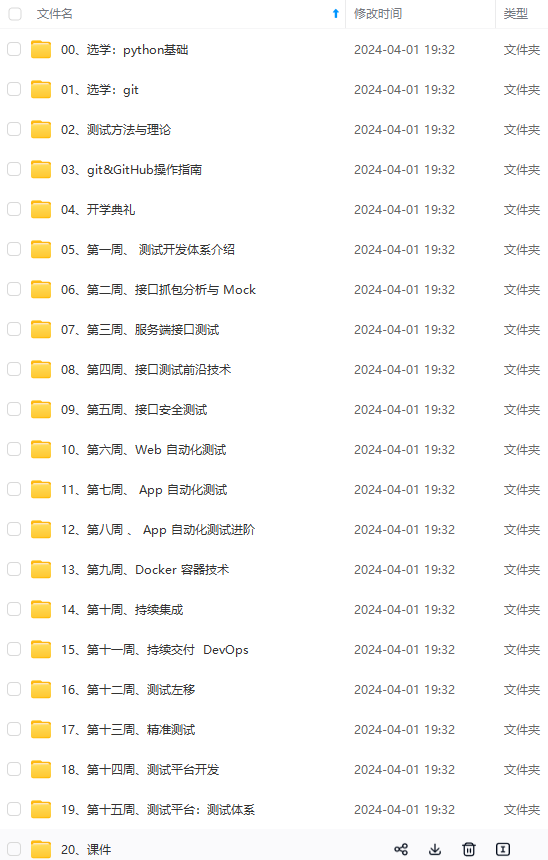

深知大多数软件测试工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年软件测试全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上软件测试开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024b (备注软件测试)

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

来增强语义表示学习。

包含实体和关系的关系路径例如

(

x

1

,

x

2

,

.

.

.

,

x

T

)

(x_1, x_2, …, x_T)

(x1,x2,…,xT),是随机游走产生的,并且元素的位置和互换。然后使用其来计算循环隐层状态

h

t

=

t

a

n

h

(

W

h

h

t

−

1

W

x

x

t

b

)

\mathbf{h}_t = tanh(\mathbf{W}h \mathbf{h}{t-1} + \mathbf{W}_x \mathbf{x}_t + b)

ht=tanh(Whht−1+Wxxt+b)。skip操作如下,其中

S

1

\mathbf{S}_1

S1,

S

2

\mathbf{S}_2

S2是权重矩阵。

h

t

′

=

{

h

t

x

t

∈

ε

S

1

h

t

S

2

x

t

−

1

x

t

∈

R

\mathbf{h_t}'=\left{ \begin{array}{lr}\mathbf{h_t}&x_t\in \mathcal{\varepsilon}\ \mathbf{S_1h_t+S_2x_{t-1}}&x_t\in\mathcal{R} \end{array} \right.

ht′={htS1ht+S2xt−1xt∈εxt∈R

- Transformers

基于transformer的模型促进了利用上下文本文的表示学习。

为了利用KG中的上下文信息,CoKE使用transformers来建模边和路径的序列。类似地,KG-BERT借鉴了语言模型的预训练思想并使用Transformer中的双向编码表示作为编码实体和关系的encoder。

- Graph Neural Networks

图神经网络(GNN)是使用encoder-decoder框架学习结构的连通性。

R-GCN提出了针对关系的转换来建模有向的KG,模型的前向传播定义成:

x

i

(

l

1

)

=

σ

(

∑

r

∈

R

∑

j

∈

N

i

r

1

c

i

,

r

W

r

(

l

)

x

j

(

l

)

W

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数软件测试工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年软件测试全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

[外链图片转存中…(img-kLxvIFcU-1713078562047)]

[外链图片转存中…(img-8PAAGwYk-1713078562048)]

[外链图片转存中…(img-Wof3BoBI-1713078562048)]

[外链图片转存中…(img-vWkGMzp7-1713078562049)]

[外链图片转存中…(img-owSrosMP-1713078562049)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上软件测试开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024b (备注软件测试)

[外链图片转存中…(img-8foT1UKb-1713078562049)]

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

140

140

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?