前言

小编今天教大家一个小白新手入门级别的爬虫,今天这个教程采用最简单的爬虫方法,代码不复杂,学不会的话,小编去你家帮你爬。

文章目录

- 今天这个教程采用最简单的爬虫方法,适合小白新手入门,代码不复杂

-

- 首先打开咱们的网站

-

- 一、导入相关库(requests库)

- 二、相关的参数(url,headers)

- 三、向网站发出请求

- 四、匹配(re库,正则表达式)

- 五、获取图片,保存到文件夹中(os库)

- 完整代码

爬虫的介绍以及原理等等七七八八的东西我就不多说了,我们直接上教程

本案例我就以 彼岸图网 这个网站做教程,原网址下方链接

首先打开我们的网站

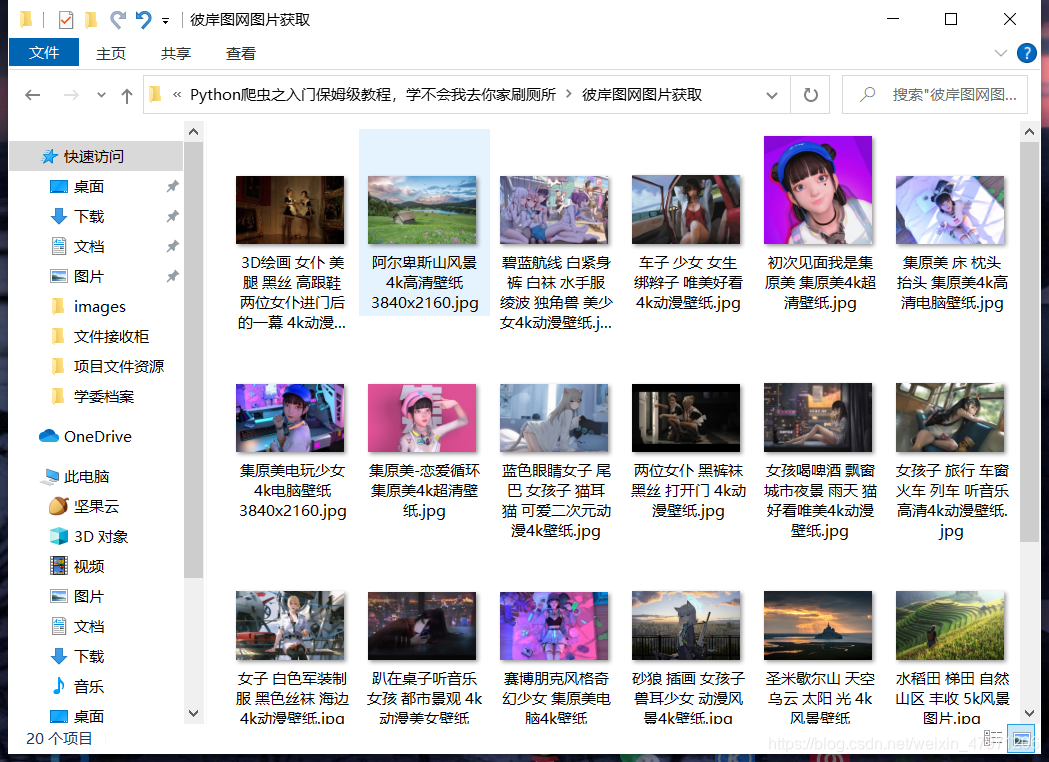

可以看到有很多好看的图片,一页总共21张图片

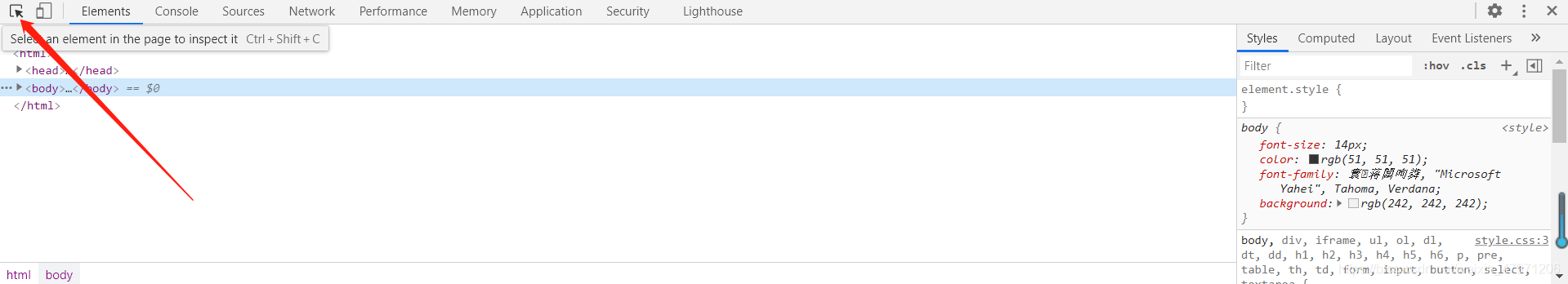

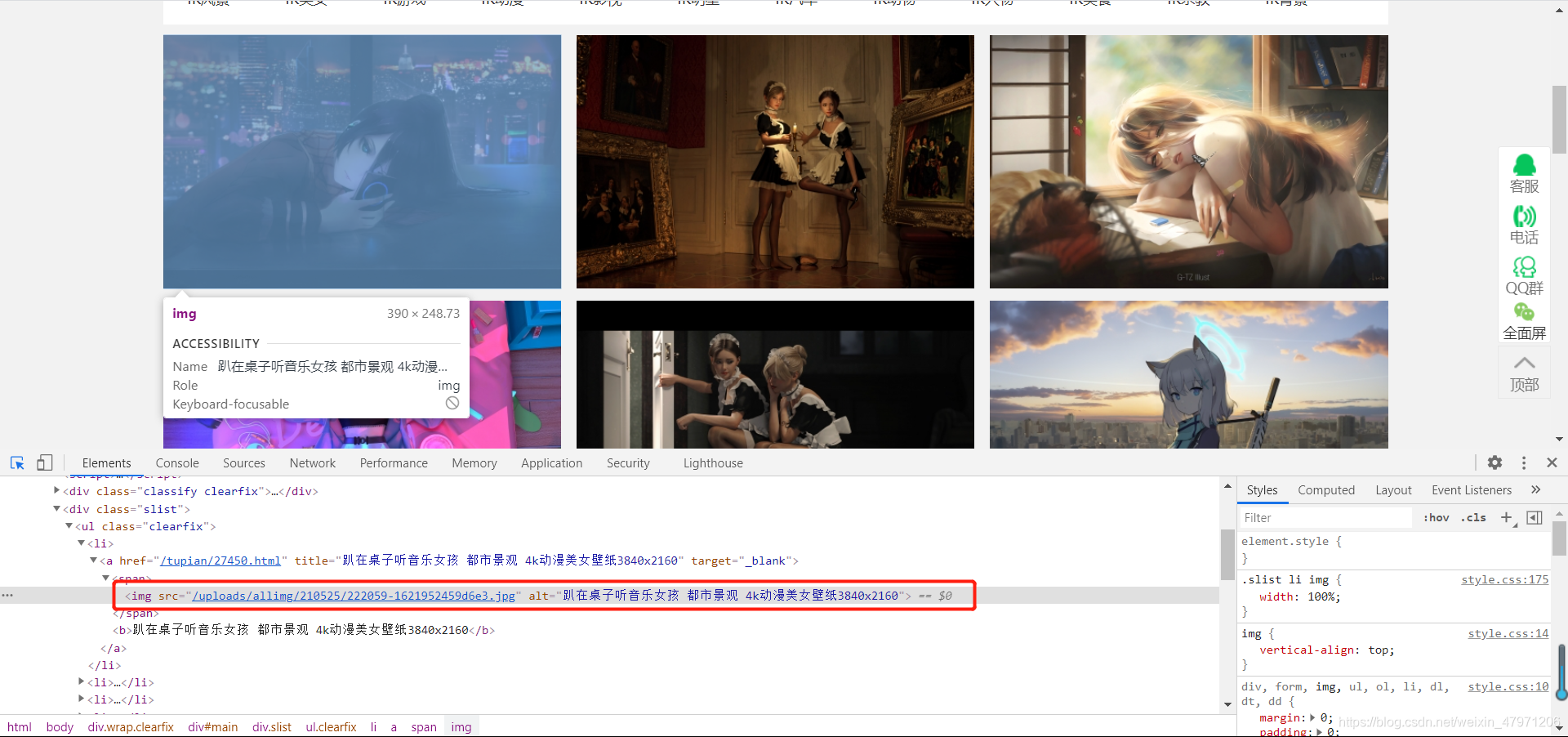

我们右键选择检查或者直接按F12来到控制台

点击左上角的箭头或者快捷键ctrl+shift+c,然后随便点在一张图片上面

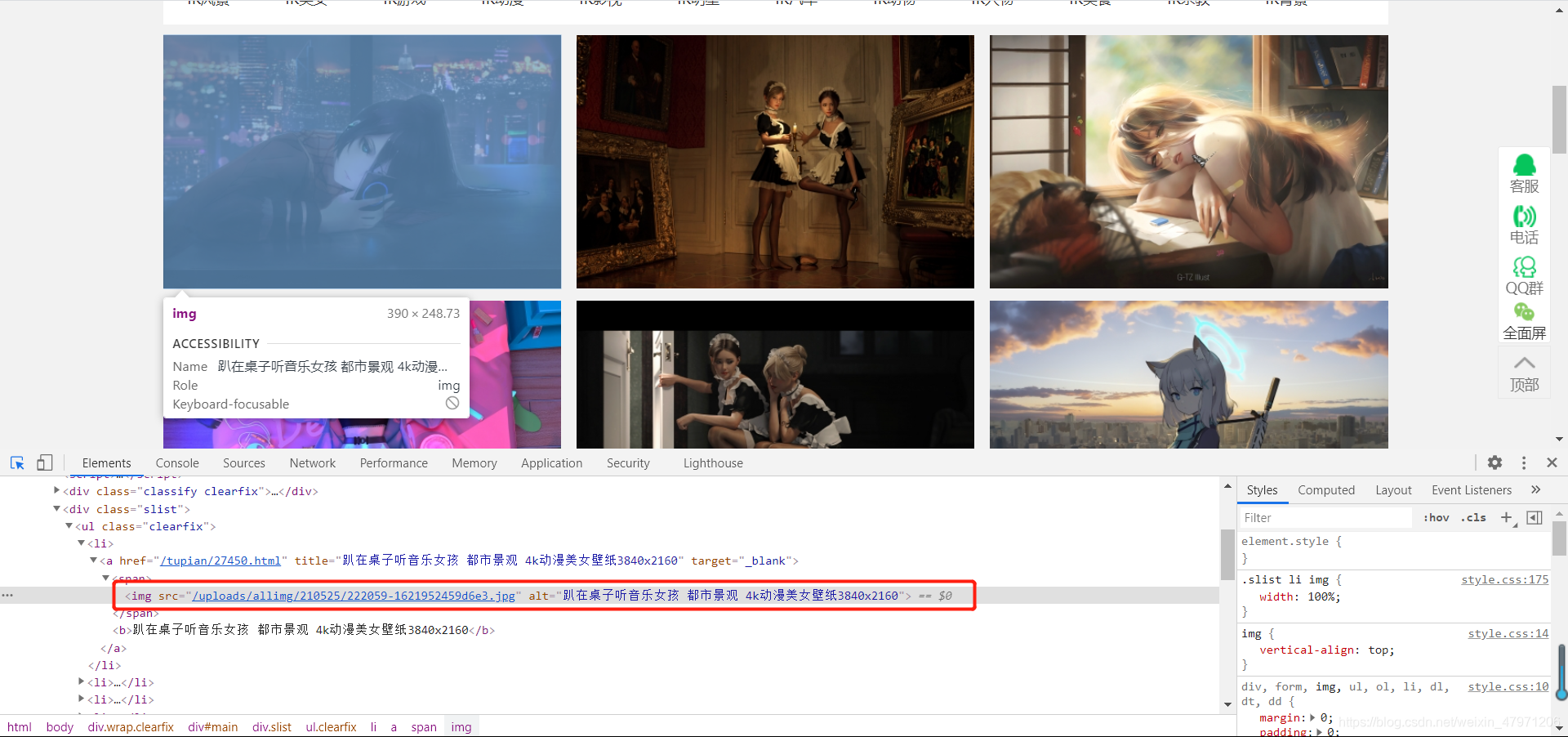

这时候我们就能看到这张图片的详细信息,src后面的链接就是图片的链接,将鼠标放到链接上就能看到图片,这就是我们这次要爬的

一、导入相关库(requests库)

import requests

requests翻译过来就是请求的意思,用来向某一网站发送请求

二、相关的参数(url,headers)

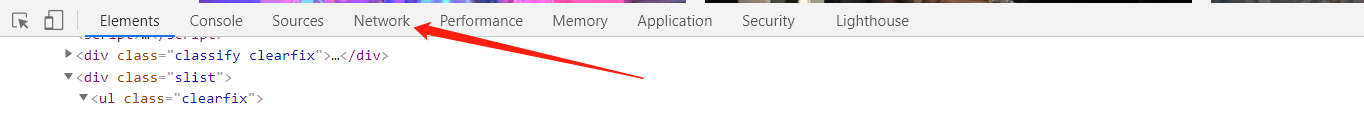

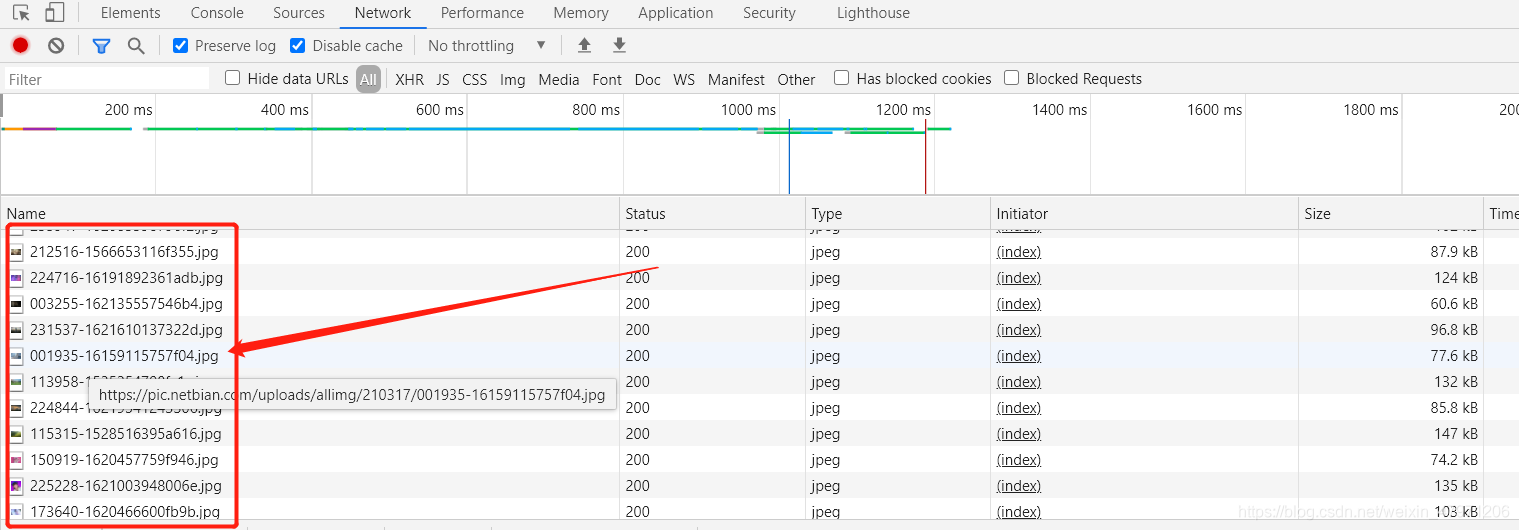

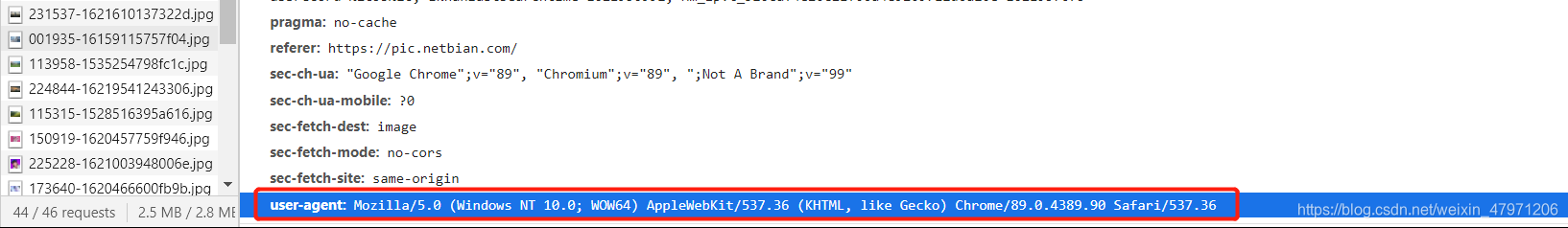

我们回到刚刚的控制台,点击上方的Network,按下ctrl+r刷新,随便点开一张图片

这里我们只需要到两个简单的参数,本次案例只是做一个简单的爬虫教程,其他参数暂时不考虑

| 参数 | 作用 |

|---|---|

| Request URL | 发送请求的网站地址,也就是图片所在的网址 |

| user-agent | 用来模拟浏览器对网站进行访问,避免被网站监测出非法访问 |

参数代码的准备

url = "https://pic.netbian.com/uploads/allimg/210317/001935-16159115757f04.jpg"

headers = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.90 Safari/537.36"

}

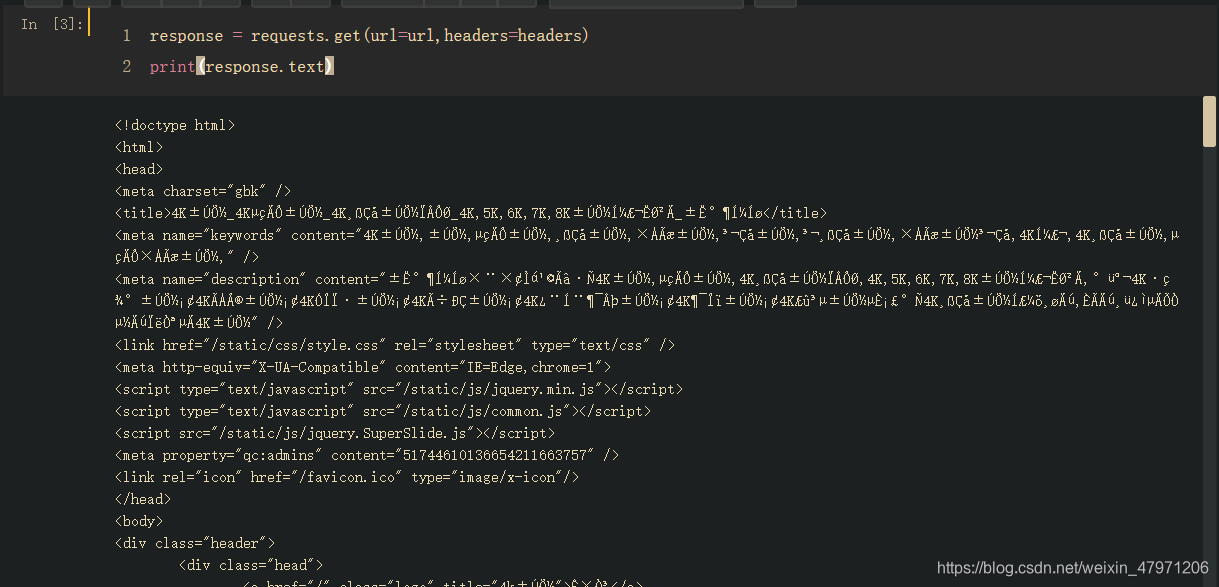

三、向网站发出请求

response = requests.get(url=url,headers=headers)

print(response.text) # 打印请求成功的网页源码,和在网页右键查看源代码的内容一样的

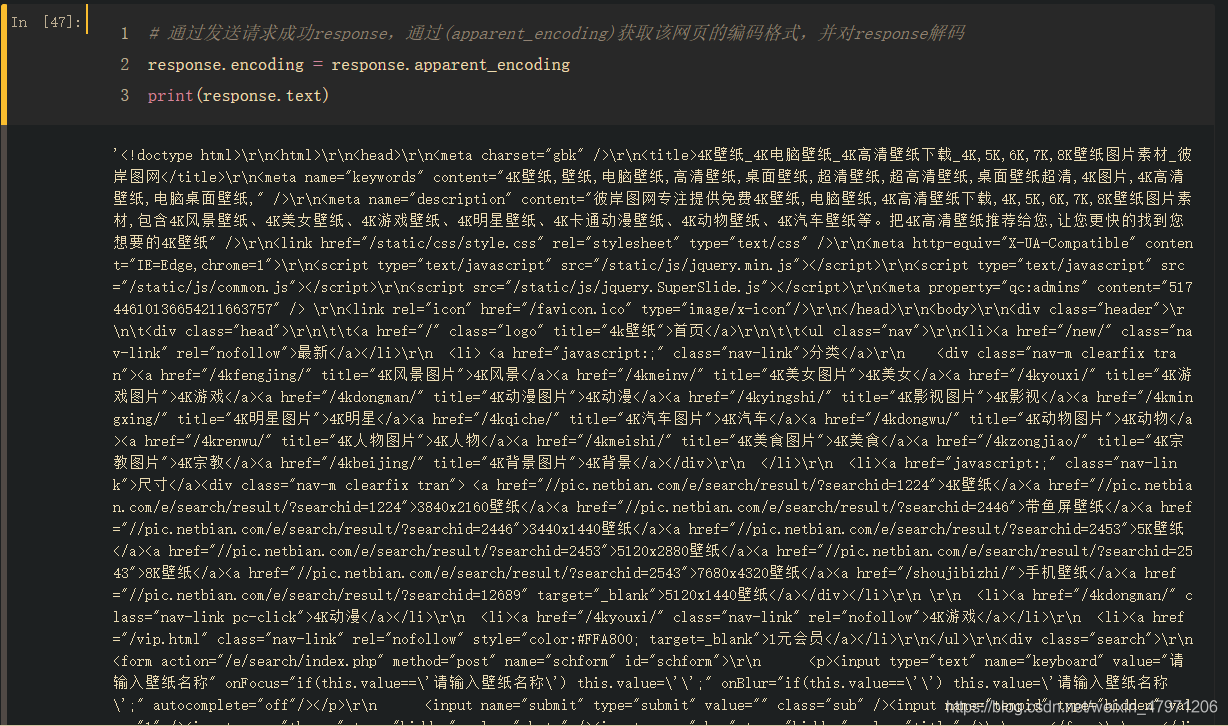

这时候我们会发现乱码?!!!!这其实也是很多初学者头疼的事情,乱码解决不难

# 通过发送请求成功response,通过(apparent_encoding)获取该网页的编码格式,并对response解码

response.encoding = response.apparent_encoding

print(response.text)

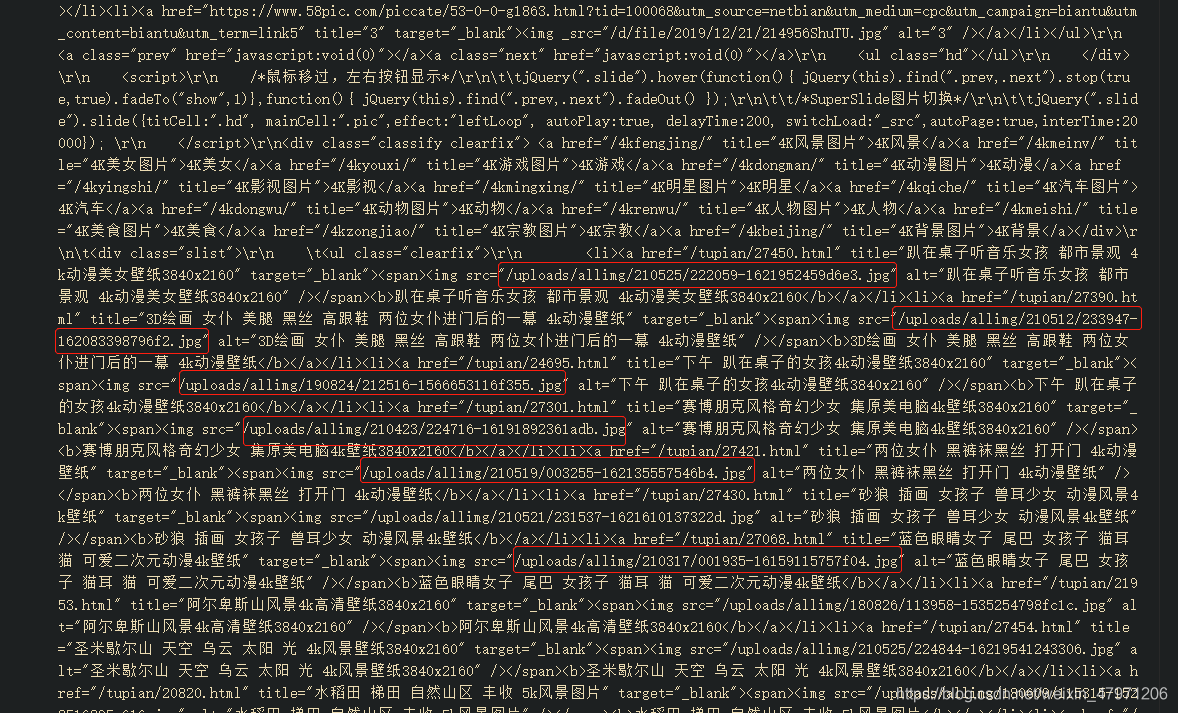

看着这些密密麻麻的一大片是不是感觉脑子要炸了,其实我们只需要找到我们所需要的就可以了

四、匹配(re库,正则表达式)

什么是正则表达式?简单点说就是由用户制定一个规则,然后代码根据我们指定的所规则去指定内容里匹配出正确的内容

我们在前面的时候有看到图片信息是什么样子的,根据信息我们可以快速找到我们要的

接下来就是通过正则表达式把一个个图片的链接和名字给匹配出来,存放到一个列表中

import re

"""

. 表示除空格外任意字符(除\n外)

* 表示匹配字符零次或多次

? 表示匹配字符零次或一次

.*? 非贪婪匹配

"""

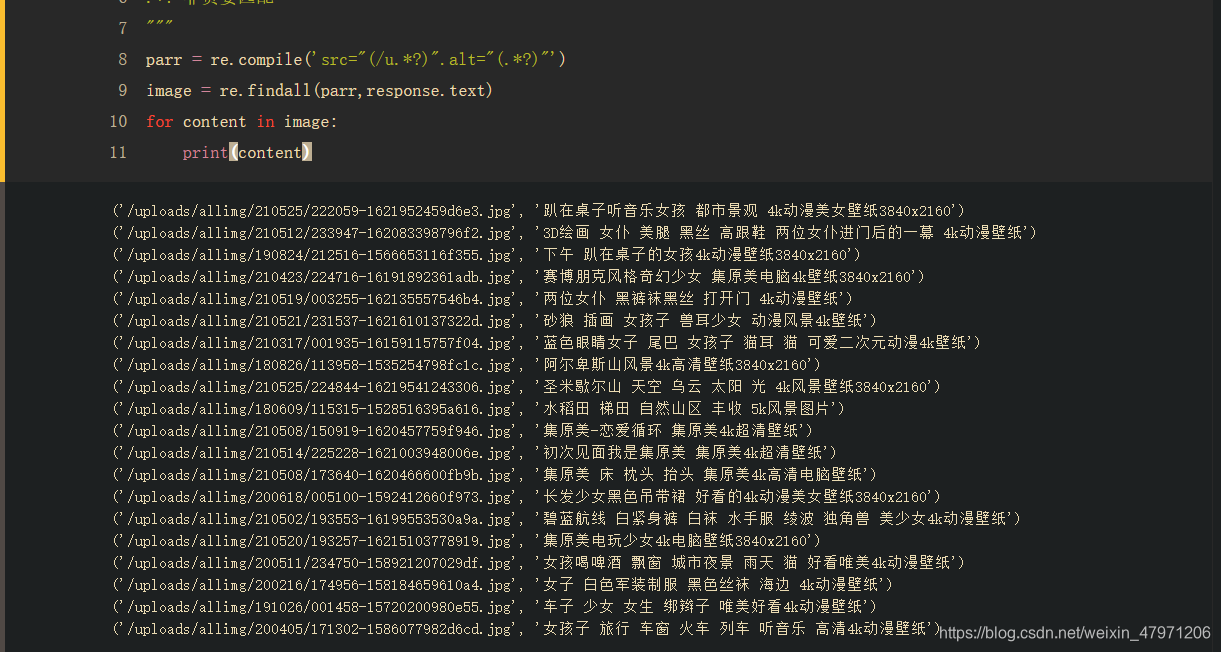

# src后面存放的是链接,alt后面是图片的名字

# 直接(.*?)也是可以可以直接获取到链接,但是会匹配到其他不是我们想要的图片

# 我们可以在前面图片信息看到链接都是/u····开头的,所以我们就设定限定条件(/u.*?)这样就能匹配到我们想要的

parr = re.compile('src="(/u.*?)".alt="(.*?)"')

image = re.findall(parr,response.text)

for content in image:

print(content)

这样我们的链接和名字就存放到了image列表中了,通过打印我们可以看到以下内容

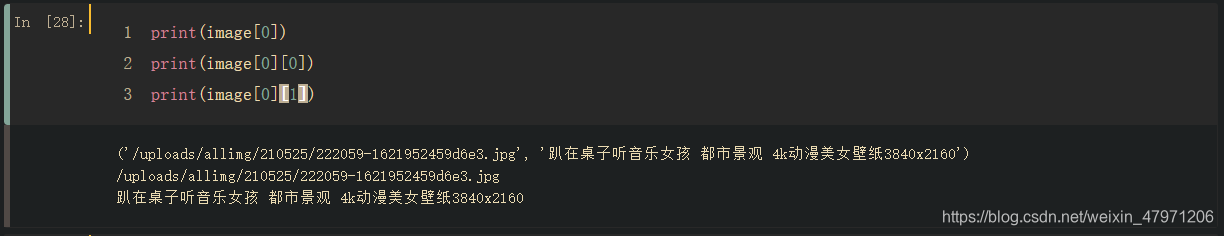

image[0]:列表第一个元素,也就是链接和图片

image[0][0]:列表第一个元素中的第一个值,也就是链接

image[0][1]:列表第一个元素中的第二个值,也就是名字

五、获取图片,保存到文件夹中(os库)

首先通过os库创建一个文件夹(当前你也可以手动在脚本目录创建一个文件夹)

import os

path = "彼岸图网图片获取"

if not os.path.isdir(path):

ok.mkdir(path)

然后对列表进行遍历,获取图片

# 对列表进行遍历

for i in image:

link = i[0] # 获取链接

name = i[1] # 获取名字

"""

在文件夹下创建一个空jpg文件,打开方式以 'wb' 二进制读写方式

@param res:图片请求的结果

"""

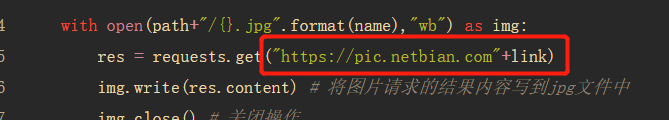

with open(path+"/{}.jpg".format(name),"wb") as img:

res = requests.get(link)

img.write(res.content) # 将图片请求的结果内容写到jpg文件中

img.close() # 关闭操作

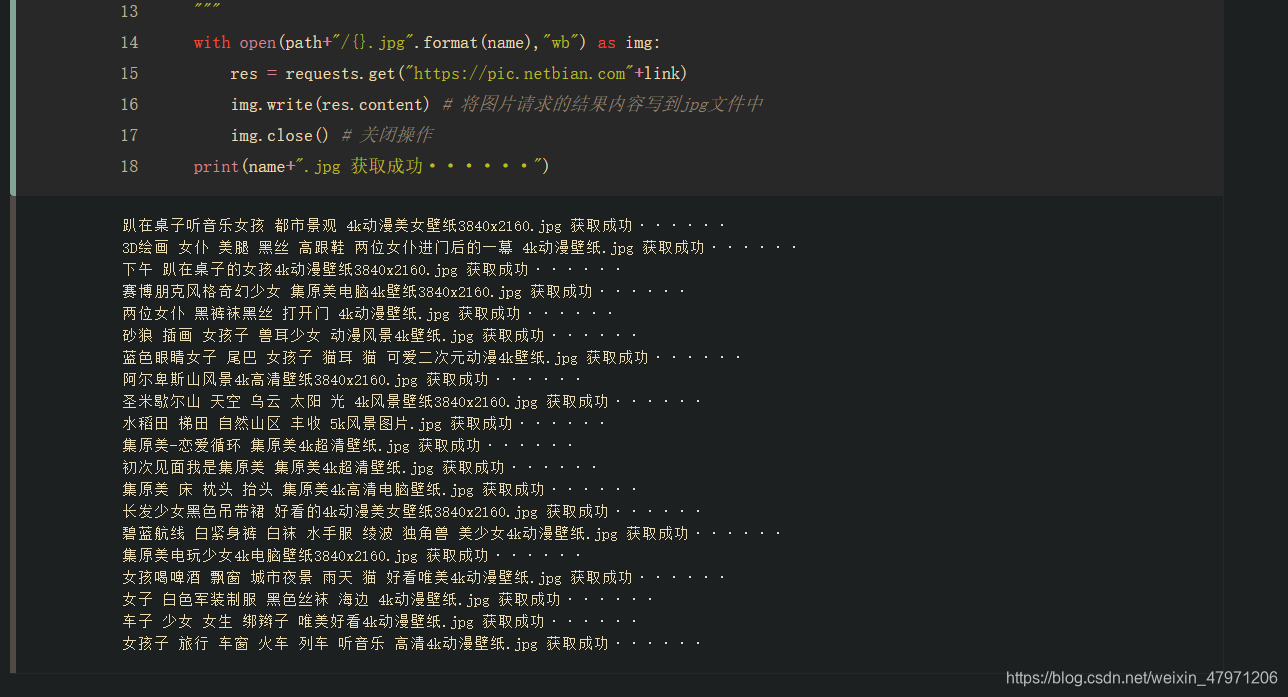

print(name+".jpg 获取成功······")

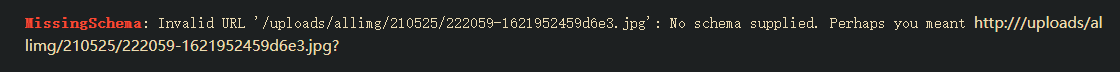

运行我们就会发现报错了,这是因为我们的图片链接不完整所导致的

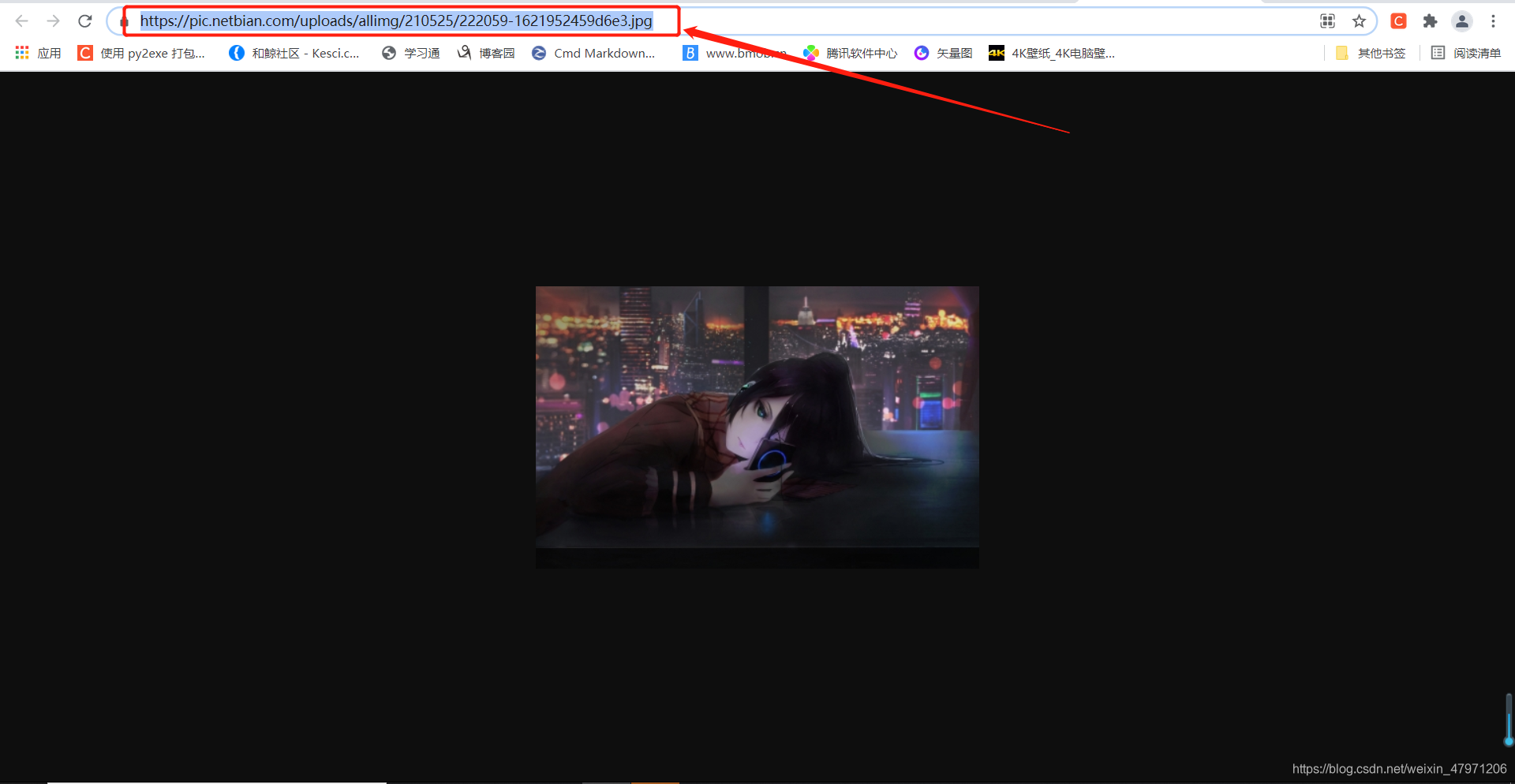

我们回到图片首页网站,点开一张图片,我们可以在地址栏看到我们的图片链接缺少前面部分,我们复制下来 https://pic.netbian.com

在获取图片的发送请求地址前加上刚刚复制的https://pic.netbian.com

运行,OK,获取完毕

完整代码

import requests

import re

import os

url = "https://pic.netbian.com/"

headers = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.90 Safari/537.36"

}

response = requests.get(url=url,headers=headers)

response.encoding = response.apparent_encoding

"""

. 表示除空格外任意字符(除\n外)

* 表示匹配字符零次或多次

? 表示匹配字符零次或一次

.*? 非贪婪匹配

"""

parr = re.compile('src="(/u.*?)".alt="(.*?)"') # 匹配图片链接和图片名字

image = re.findall(parr,response.text)

path = "彼岸图网图片获取"

if not os.path.isdir(path): # 判断是否存在该文件夹,若不存在则创建

os.mkdir(path) # 创建

# 对列表进行遍历

for i in image:

link = i[0] # 获取链接

name = i[1] # 获取名字

"""

在文件夹下创建一个空jpg文件,打开方式以 'wb' 二进制读写方式

@param res:图片请求的结果

"""

with open(path+"/{}.jpg".format(name),"wb") as img:

res = requests.get("https://pic.netbian.com"+link)

img.write(res.content) # 将图片请求的结果内容写到jpg文件中

img.close() # 关闭操作

print(name+".jpg 获取成功······")

本次教程到这里就结束了,是不是只爬了一页这么一点图片觉得不过瘾?

别急,下次我教大家如何获取十几页或者几十页甚至几百页的图片

以上就是今天的全部内容分享啦,觉得有用的话欢迎点赞收藏哦!

Python经验分享

学好 Python 不论是用于就业还是做副业赚钱都不错,而且学好Python还能契合未来发展趋势——人工智能、机器学习、深度学习等。但要学会 Python 还是要有一个学习规划,这样才能学的更快更稳,最后给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

小编为对Python感兴趣的小伙伴准备了以下籽料 !

对于0基础小白入门:

如果你是零基础小白,想快速入门Python是可以考虑培训的!

- 学习时间相对较短,学习内容更全面更集中

- 可以找到适合自己的学习方案

包括:Python激活码+安装包、Python web开发,Python爬虫,Python数据分析,人工智能、机器学习、Python量化交易等学习教程。带你从零基础系统性的学好Python!

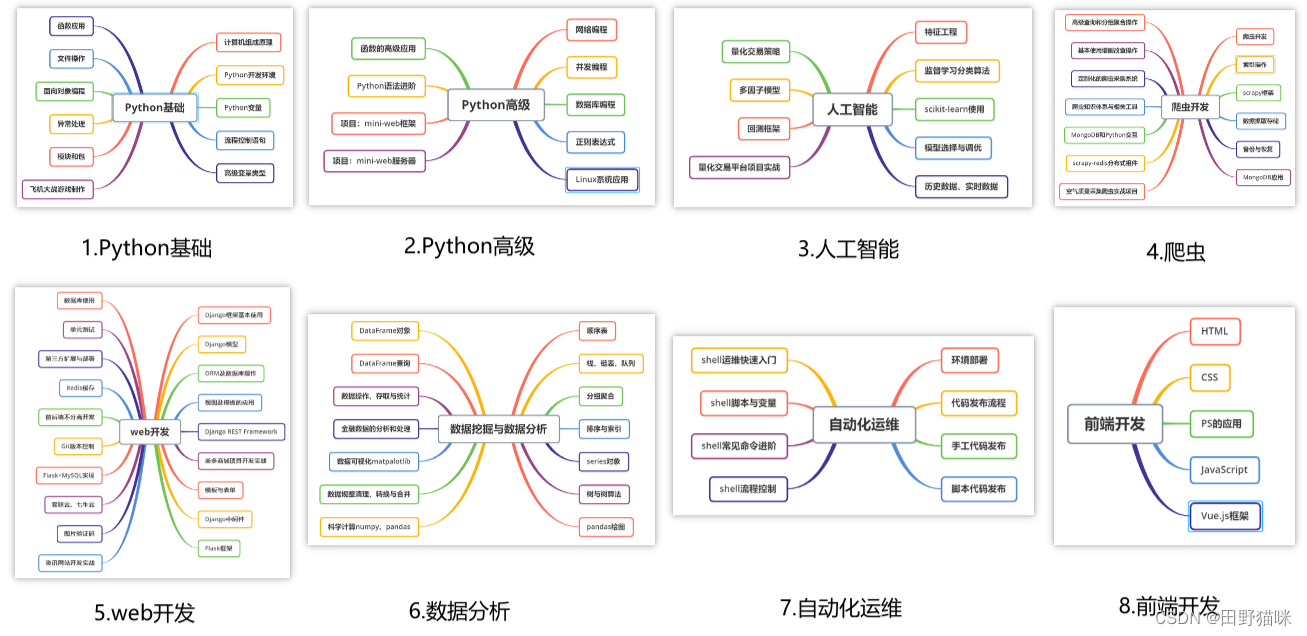

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

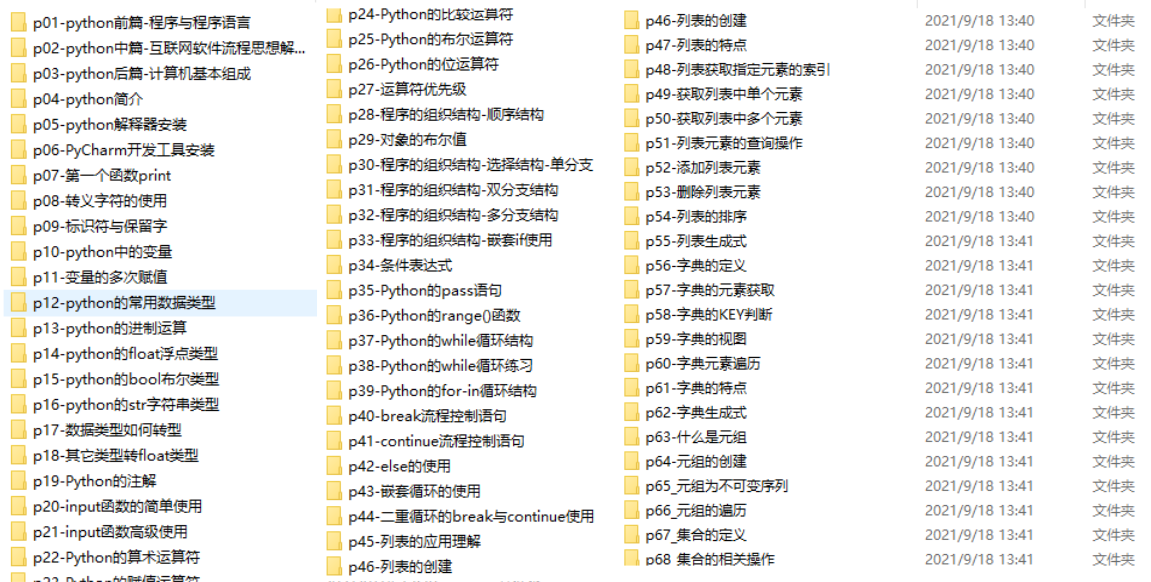

三、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

最新全套【Python入门到进阶资料 & 实战源码 &安装工具】(安全链接,放心点击)

我已经上传至CSDN官方,如果需要可以扫描下方官方二维码免费获取【保证100%免费】

*今天的分享就到这里,喜欢且对你有所帮助的话,记得点赞关注哦~下回见 !

914

914

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?