由于以前遇到的数据文件体量都比较小,今天在使用python读取csv文件时直接内存溢出了。

这里特意记录一下解决问题的三种方式,遇到的场景就是使用pandas模块直接读取csv文件然后返回DataFrame对象结果内存溢出。

首先,来看一下解决这个问题的思路是什么,然后再来分析怎么解决这个问题?

最简单的方式就是直接使用软件工具将大文件进行拆分,拆分完成后再进行读取。第二种则是在读取大文件的过程中直接分段读取,比如按照每十行读取的方式直接进行读取操作。

再或者第三种就是使用底层处理比较优质的模块,比如polars,它的底层存储方式就不会发生内存溢出的问题。

# Importing the pandas module and giving it an alias of pd.

import pandas as pd

# Reading the csv file and returning a DataFrame object.

result_ = pd.read_csv('G:/test/data.csv')

# File "pandas\_libs\parsers.pyx", line 808, in pandas._libs.parsers.TextReader.read_low_memory

# File "pandas\_libs\parsers.pyx", line 866, in pandas._libs.parsers.TextReader._read_rows

# File "pandas\_libs\parsers.pyx", line 852, in pandas._libs.parsers.TextReader._tokenize_rows

# File "pandas\_libs\parsers.pyx", line 1973, in pandas._libs.parsers.raise_parser_error

# pandas.errors.ParserError: Error tokenizing data. C error: Expected 3 fields in line 14, saw 4542

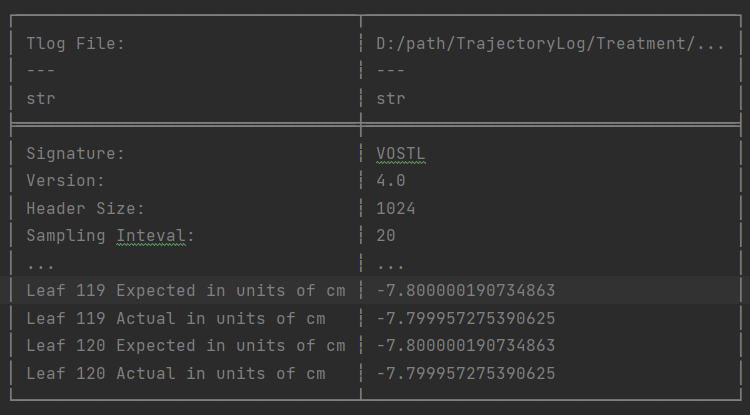

上面就是直接读取大数据量的csv文件会发生python内存溢出的报错。

若是想继续使用pandas模块读取大数量的文件,可以加上分割读取数据的参数就不会发生内存溢出的现象了。

# Reading the csv file in chunks of 10 rows.

result_ = pd.read_csv('G:/test/data.csv', chunksize=10)

chunksize设置为10,就是可以按照每十行的读取方式来读取csv的数据,并且返回的也是DataFrame的数据对象。

然后就是采用polars模块读取的方式来处理大数据量csv文件,polars本身对于大数据的文件支持比较好,并且读取速度也有很大的提升。

可以使用polars模块一次性读取csv文件直接返回DataFrame的数据对象。

# Importing the polars module and giving it an alias of pol.

import polars as pol

# Reading the csv file and returning a DataFrame object.

data_ = pol.read_csv('G:/test/data.csv')

# Printing the dataframe.

print(data_)

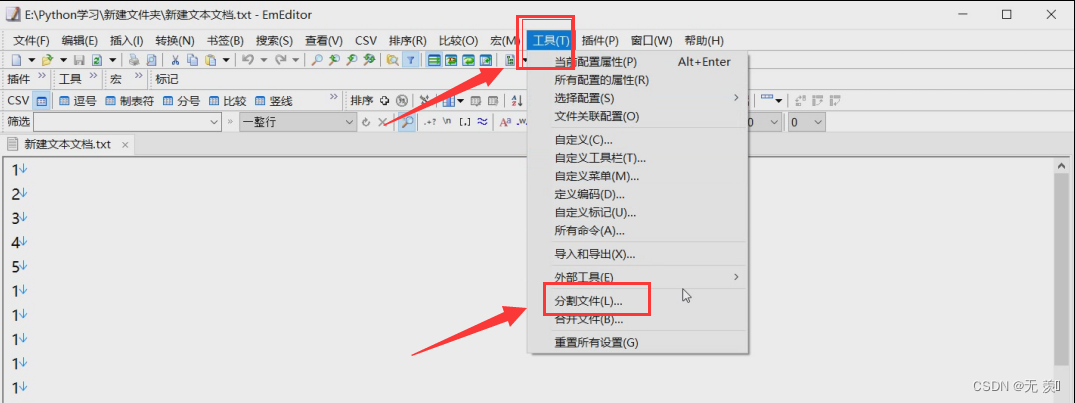

最后一种方式提前将大数据文件做完文件分割之后再进行读取,如果是做文件分割的话推荐一个比较好用的数据文件分割工具-EmEditor。

关于Python学习指南

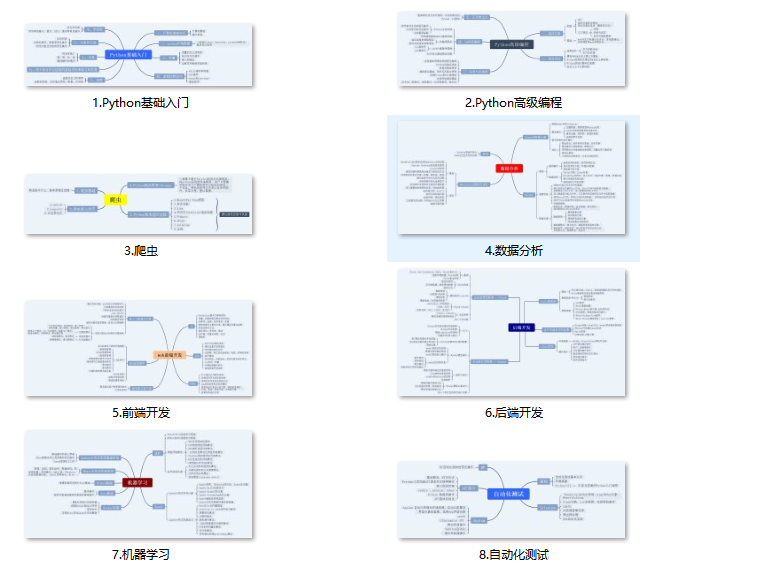

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

包括:Python激活码+安装包、Python web开发,Python爬虫,Python数据分析,人工智能、自动化办公等学习教程。带你从零基础系统性的学好Python!

👉Python所有方向的学习路线👈

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。(全套教程文末领取)

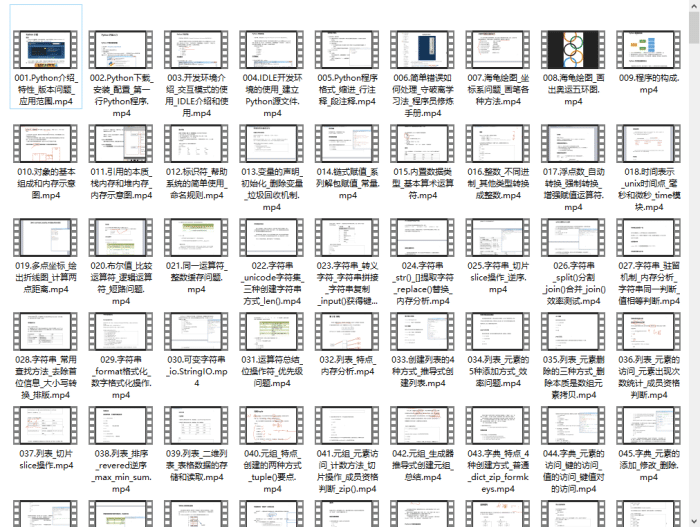

👉Python学习视频600合集👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉Python70个实战练手案例&源码👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉Python大厂面试资料👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

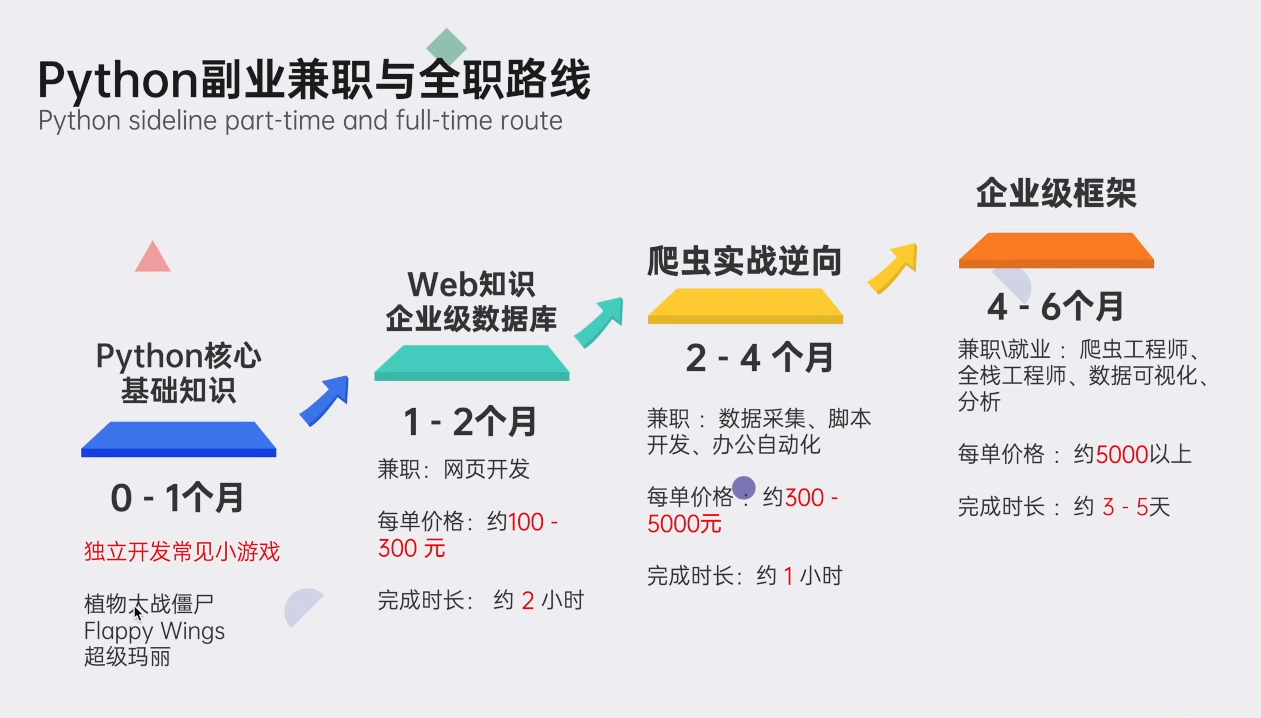

👉Python副业兼职路线&方法👈

学好 Python 不论是就业还是做副业赚钱都不错,但要学会兼职接单还是要有一个学习规划。

👉 这份完整版的Python全套学习资料已经上传,朋友们如果需要可以扫描下方CSDN官方认证二维码或者点击链接免费领取【保证100%免费】

5837

5837

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?