3. 正文与标题

文档分为正文和标题两部分,一般两部分分开处理,可以共享Embedding层也可以不共享,人机写作分类问题中我们没有共享Embedding。

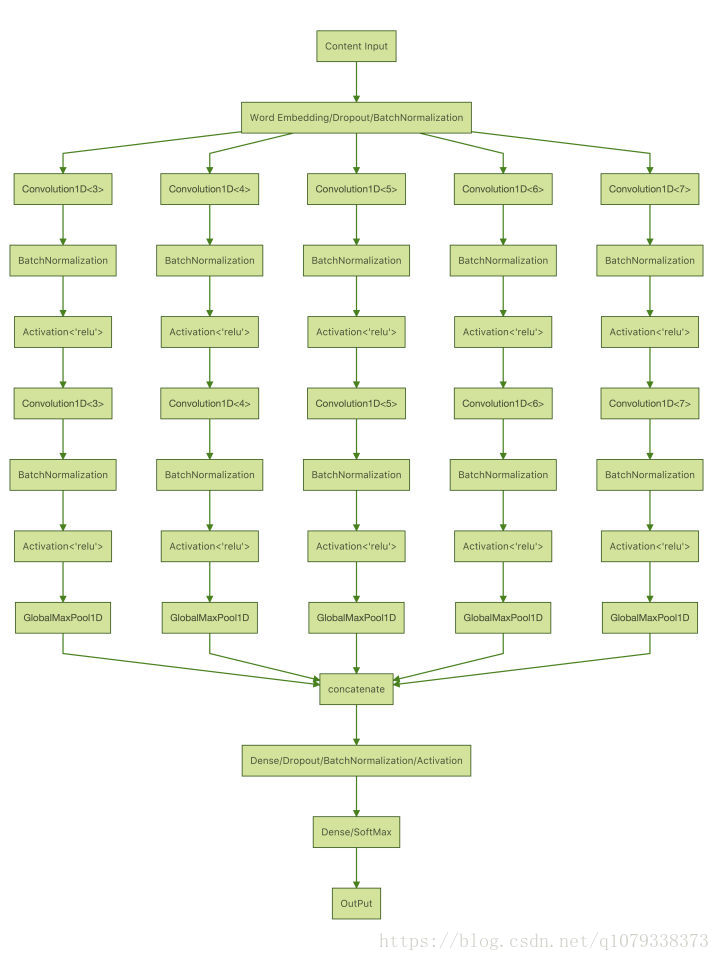

3.1 正文多层CNN,未使用标题

CNN需要设置不同大小的卷积核,并且多层卷积才能较好的捕获文本的特征,具体网络结构如下:

3.2 正文 CNN Inception,未使用标题

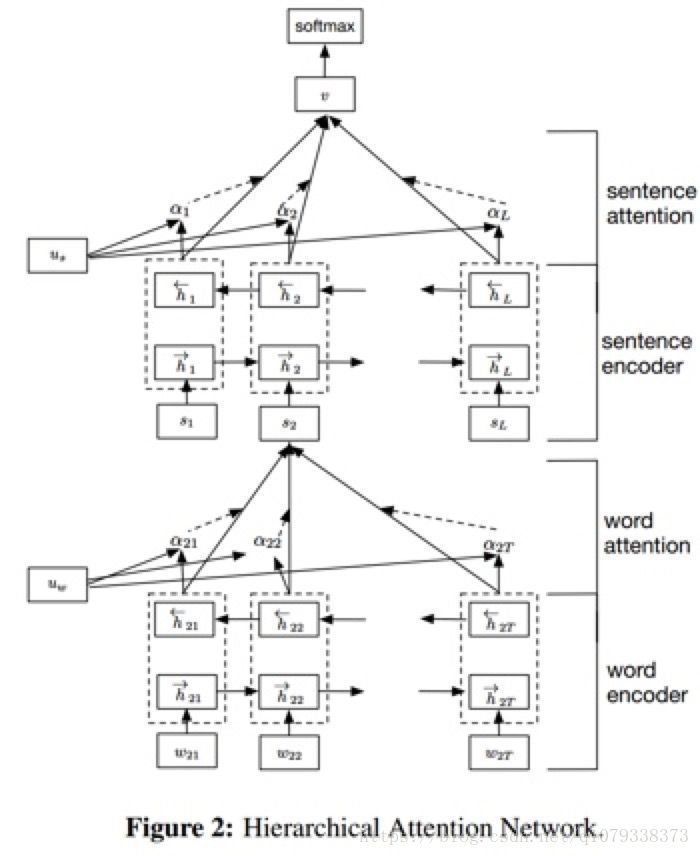

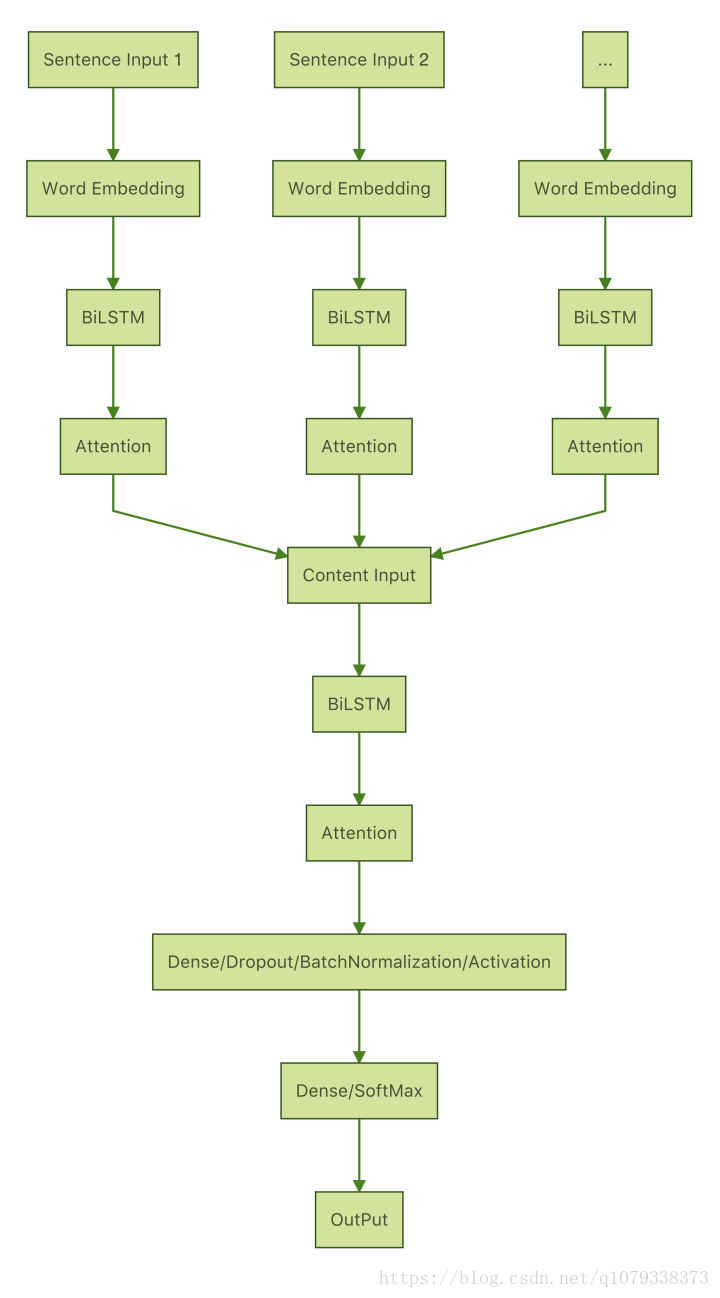

3.3 基于Hierarchical Attention的RNN处理正文

模型是根据论文《Hierarchical Attention Networks for Document Classification》实现的,论文中的模型如下

具体实现过程中的网络结构如下:

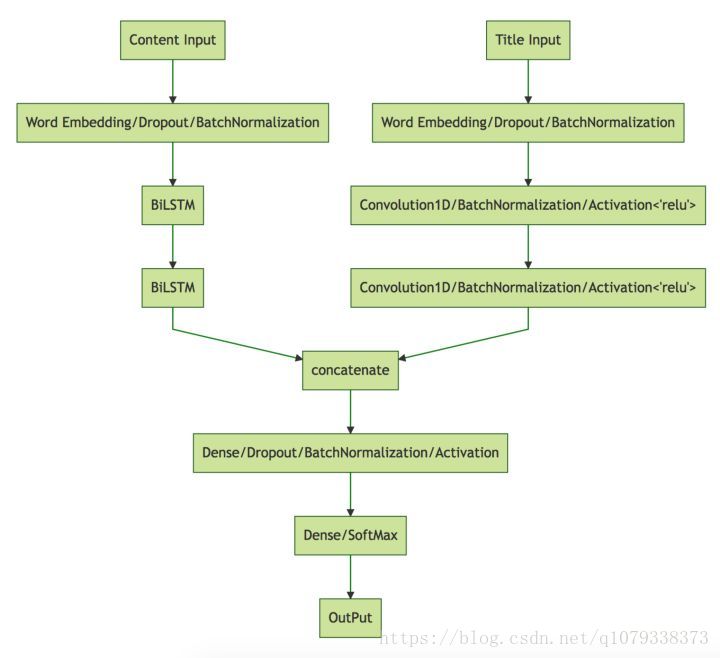

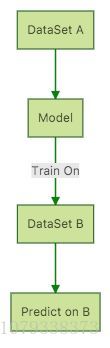

3.4 迁移学习

设计模型M,M在数据集A上训练到最佳效果保存模型的权重,然后再使用训练好的M在数据集B上训练,这个过程可以看做简单的迁移学习。因为人机写作判断任务中,先后有两个数据集,早期数据可以看做A,后期也就是最终的数据看做B,而模型在A上的表现比B上要好很多,这样就可以使用迁移学习来使模型在B上表现也好。 我们是使用RCNN处理正文,多层CNN处理标题这个模型来实现迁移学习的,具体过程如下:

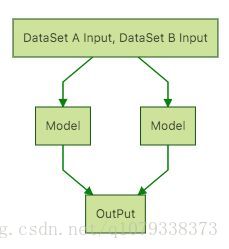

3.5 多任务学习

相同模型同时在数据集A和B上训练,可以称为多任务学习,我们也是使用RCNN处理正文,多层CNN处理标题这个模型来实现多任务学习的,具体过程如下:

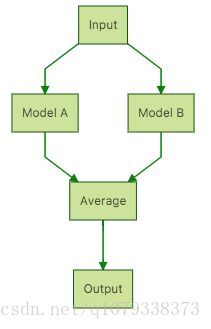

3.6 联合模型学习

选取表现最好的2个单模型,在数据集上预训练到最优,然后联合在一起训练,可以共享Embedding层,也可以不共享,由于我们表现最好的单模型是RCNN处理正文,多层CNN处理标题的Model A和基于Hierarchical Attention的RNN的Model B,Embedding的形式不同所以不能共享,具体形式如下所示,也可以联合多个单模型一起训练,但缺点就是训练时间过长:

小结

深度学习在文档分类问题上比传统机器学习方法有太大的优势,仔细分析就知道文本的特征很难提取,而且这些特征不能很好的表示文档的语义、语法,丢失了很大一部分的有用信息,而深度学习就是将特征提取这个环节交给深度网络去自动完成,通过更高的计算成本换取更全面更优良的文本特征。

模型Stacking

一般是针对评测或者比赛,融合多个模型的结果,不同的模型会导致其预测结果的多样性,Stacking可以有效的融合其多养性达到提高分数的目的。关于Stacking的介绍,可以看这篇文章。 传统Stacking方法一般使用树模型,例如LightGBM、XGBoost等,我们使用神经网络的方式实现,Model就是两个全连接层。

总结

传统机器学习方法可以作为任务的Baseline,而且通过特征的设计和提取能够感受数据,不能把数据也就是文档看做黑盒子,对数据了解足够设计模型肯定事半功倍。至于深度学习的方法,我们只是借鉴、改进经典论文提出的模型,也使用了前人比赛的Trick,如果想深入了解还是需要阅读更多的论文,ACL是计算语言学年会汇集了全球顶尖NLP领域学者的思想,可以关注这个会议阅读其收录的论文。

引用

https://zhuanlan.zhihu.com/p/31963565

Kim Y. Convolutional Neural Networks for Sentence Classification[J]. Eprint Arxiv, 2014.

Yang Z, Yang D, Dyer C, et al. Hierarchical Attention Networks for Document Classification[C]// Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. 2017:1480-1489.

https://zhuanlan.zhihu.com/p/28923961

https://zhuanlan.zhihu.com/p/25928551

341

341

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?