7 从文本提取信息

英文文档 http://www.nltk.org/book/

中文文档 https://www.bookstack.cn/read/nlp-py-2e-zh/0.md

以下编号按个人习惯

Extracting Information from Text(从文本提取信息)

信息提取系统的典型结构:断句、分词、词性标注、搜索特定类型的实体、寻找指定关系

1 Information Extraction(信息提取)

首先,使用句子分段器将文档的原始文本分割成句子,然后使用记号赋予器将每个句子进一步细分为单词。接下来,用词性标记标记每个句子。以nltk中的默认工具为例,将句子分段器、分词器、词性标记器连接。

def ie_preprocess(document):

# nltk 默认的句子分段器

sentences = nltk.sent_tokenize(document)

# nltk默认分词器

sentences = [nltk.word_tokenize(sent) for sent in sentences]

# nltk默认词性标记

sentences = [nltk.pos_tag(sent) for sent in sentences]

之后进行命名实体检测。

2 Chunking(词块划分)

词块划分是实体识别的基本技术,分割和标注多词符的序列。

2.1 Noun Phrase Chunking(名词短语词块划分)

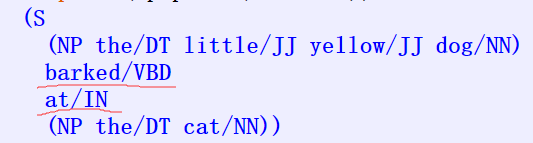

使用正则表达式来定义一个语法,来进行名词短语词块的划分

# 名词短语词块划分

def noun_phrase_chunking():

sentence = [("the", "DT"), ("little", "JJ"), ("yellow", "JJ"), ("dog", "NN"), ("barked", "VBD"), ("at", "IN"),

("the", "DT"), ("cat", "NN")]

# 语法。正则表达式规则。可选限定词(DT)后跟任意数量的形容词(JJ)和一个名词(NN)时,形成一个NP块

grammar = "NP:{<DT>?<JJ>*<NN>}"

# 创建一个块解析器

cp = nltk.RegexpParser(grammar)

# 测试。查看结果

result = cp.parse(sentence)

print(result)

result.draw()

2.2 Exploring Text Corpora(用正则表达式进行词块划分)

使用RegexpParser创建一个词块划分器,并使用正则表达式指定规则。一个正则表达式字符串中,可以写多个正则表达式,词块划分器轮流应用其规则,依次的更新词块结构,直到所有规则都被调用完,返回划分完的词块结构。当匹配重叠时,最左边的匹配优先。

# 用正则表达式进行词块划分

def chunking_with_regular_expressions():

# 表达式1 划分一个可选限定词或所有格代名词,0或多个形容词,一个名词

# 表达式2 划分一个或多个专有名词

grammar = r"""

NP: {<DT|PP\$>?<JJ>*<NN>} # chunk determiner/possessive, adjectives and noun

{<NNP>+} # chunk sequences of proper nouns

"""

cp = nltk.RegexpParser(grammar)

sentence = [("Rapunzel", "NNP"), ("let", "VBD"), ("down", "RP"), ("her", "PP$"), ("long", "JJ"), ("golden", "JJ"),

("hair", "NN")]

# 重叠匹配则按照左边匹配优先

print(cp.parse(sentence))

词缝:一个不包含在词块中的一个词符序列。以下划线部分就是一个词缝

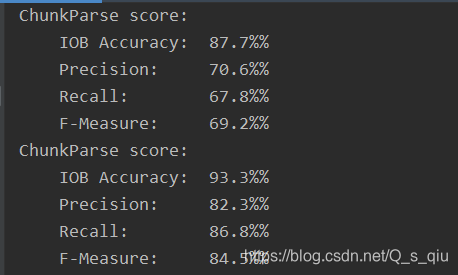

3 Developing and Evaluating Chunkers( 开发和评估词块划分器)

3.1 Simple Evaluation and Baselines(简单的评估和基准)

词块划分器可使用evaluate()方法来评估一个划分器的性能好坏。

下面学习使用一元标注器建立一个词块划分器。但不是尝试确定每个词的正确的词性标记,而是根据每个词的词性标记,尝试确定正确的词块标记。

# 使用一元标注器建立一个词块划分器。根据每个词的词性标记,尝试确定正确的词块标记。

class UnigramChunker(nltk.ChunkParserI):

# constructor

def __init__(self, train_sents):

# 将训练数据转换成适合训练标注器的形式。tree2conlltags()方法将每个词块树映射到一个三元组(word,tag,chunk)的列表

train_data = [[(t, c) for w, t, c in nltk.chunk.tree2conlltags(sent)]

for sent in train_sents]

# 训练一元分块器

# self.tagger = nltk.UnigramTagger(train_data)

# 训练二元分块器

self.tagger = nltk.BigramTagger(train_data)

# sentence为一个已标注的句子

def parse(self, sentence):

# 提取词性标记

pos_tags = [pos for (word, pos) in sentence]

# 使用标注器为词性标记 标注IOB词块

tagged_pos_tags = self.tagger.tag(pos_tags)

# 提取词块标记

chunktags = [chunktag for (pos, chunktag) in tagged_pos_tags]

# 将词块标记与原句组合

conlltags = [(word, pos, chunktag) for ((word, pos), chunktag)

in zip(sentence, chunktags)]

# 转换成词块树

return nltk.chunk.conlltags2tree(conlltags)

# 简单的评估和基准

def simple_evaluation_and_baselines():

test_sents = conll2000.chunked_sents('test.txt', chunk_types=['NP'])

train_sents = conll2000.chunked_sents('train.txt', chunk_types=['NP'])

# 调用UnigramChunker类,创建对象.分块器是几元的可以在该类构造器中改变

unigram_chunker = code_unigram_chunker.UnigramChunker(train_sents)

print(unigram_chunker.evaluate(test_sents))

分别使用了一元标注器和二元标注器进行词块划分,评估结果依次如下,二元词块划分器的性能略高于一元词块划分器。

4 Recursion in Linguistic Structure(语言结构中的递归)

4.1 Building Nested Structure with Cascaded Chunkers( 用级联词块划分器构建嵌套结构)

通过创建包含递归规则的多阶段块语法,来构建任意深度的块结构。

正则表达式规则:名字短语、介词短语、动词短语、句子

def building_nested_structure_with_cascaded_chunkers():

# 四阶段的块语法。可用于创建深度最多为4的结构(深度不包括顶)

grammar = r"""

NP: {<DT|JJ|NN.*>+} # Chunk sequences of DT, JJ, NN

PP: {<IN><NP>} # Chunk prepositions followed by NP

VP: {<VB.*><NP|PP|CLAUSE>+$} # Chunk verbs and their arguments

CLAUSE: {<NP><VP>} # Chunk NP, VP

"""

cp = nltk.RegexpParser(grammar)

sentence = [("Mary", "NN"), ("saw", "VBD"), ("the", "DT"), ("cat", "NN"),

("sit", "VB"), ("on", "IN"), ("the", "DT"), ("mat", "NN")]

# 查看树图

print(cp.parse(sentence))

cp.parse(sentence).draw()

# 上述规则无法识别VP词块。解决方案是让词块划分器在他的模式中循环。loop指定循环次数。

cp_1 = nltk.RegexpParser(grammar, loop=2)

sentence_1 = [("John", "NNP"), ("thinks", "VBZ"), ("Mary", "NN"), ("saw", "VBD"), ("the", "DT"), ("cat", "NN"),

("sit", "VB"), ("on", "IN"), ("the", "DT"), ("mat", "NN")]

print(cp_1.parse(sentence_1))

5 Named Entity Recognition(命名实体识别)

命名实体是确切的名词短语,指示特定类型的个体例如组织、人、日期等。

NLTK提供了一个已经训练好的分类器,进行命名实体识别,可以通过函数nltk.ne_chunk()访问。

# 命名实体识别

def named_entity_recognition():

sent = nltk.corpus.treebank.tagged_sents()[22]

# 访问nltk提供的用来识别命名实体的分类器。binary设为True则命名实体被标记为NE,否则会添加类别标签如PERSON

ne_sent = nltk.ne_chunk(sent, binary=True)

ne_sent_1 = nltk.ne_chunk(sent)

print(ne_sent)

print(ne_sent_1)

6 Relation Extraction(关系提取)

关系提取是寻找指定类型的命名实体之间的关系。

过程:首先寻找所有(X,α,Y)形式的三元组,X,Y是指定类型的命名实体,α表示二者之间关系的字符串;然后使用正则表达式从α中提取查找的关系。

# 关系提取

def relation_extraction():

# 搜索包含词 in 的字符串。并且排除in后跟一个动名词

IN = re.compile(r'.*\bin\b(?!\b.+ing)')

for doc in nltk.corpus.ieer.parsed_docs('NYT_19980315'):

for rel in nltk.sem.extract_rels('ORG', 'LOC', doc, corpus='ieer', pattern=IN):

print(nltk.sem.rtuple(rel))

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?